2022大厂八股文

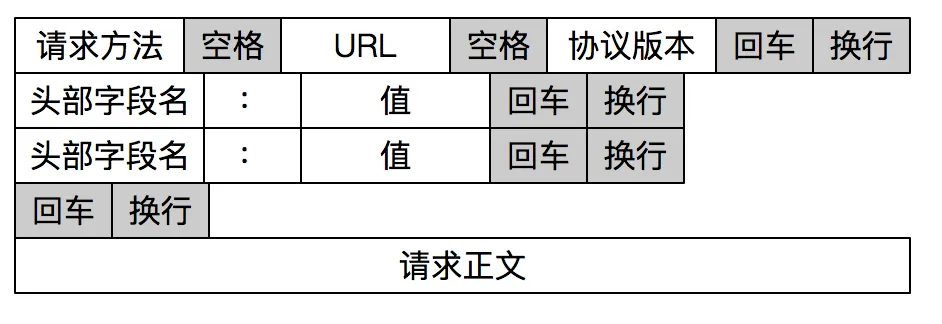

🍤八股文经验&面经精选

🐦Java 基础

LinkedList和ArrayList的区别 (2022飞书)

- 是否保证线程安全:

ArrayList和LinkedList都是不同步的,也就是不保证线程安全; - 底层数据结构:

Arraylist底层使用的是Object数组;LinkedList底层使用的是 双向链表 数据结构(JDK1.6 之前为循环链表,JDK1.7 取消了循环。注意双向链表和双向循环链表的区别,下面有介绍到!) - 插入和删除是否受元素位置的影响: ①

ArrayList采用数组存储,所以插入和删除元素的时间复杂度受元素位置的影响。 比如:执行add(E e)方法的时候,ArrayList会默认在将指定的元素追加到此列表的末尾,这种情况时间复杂度就是 O(1)。但是如果要在指定位置 i 插入和删除元素的话(add(int index, E element))时间复杂度就为 O(n-i)。因为在进行上述操作的时候集合中第 i 和第 i 个元素之后的(n-i)个元素都要执行向后位/向前移一位的操作。 ②LinkedList采用链表存储,所以对于add(E e)方法的插入,删除元素时间复杂度不受元素位置的影响,近似 O(1),如果是要在指定位置i插入和删除元素的话((add(int index, E element)) 时间复杂度近似为o(n))因为需要先移动到指定位置再插入。 - 是否支持快速随机访问:

LinkedList不支持高效的随机元素访问,而ArrayList支持。快速随机访问就是通过元素的序号快速获取元素对象(对应于get(int index)方法)。 - 内存空间占用:

ArrayList的空 间浪费主要体现在在 list 列表的结尾会预留一定的容量空间,而LinkedList的空间花费则体现在它的每一个元素都需要消耗比ArrayList更多的空间(因为要存放直接后继和直接前驱以及数据)。

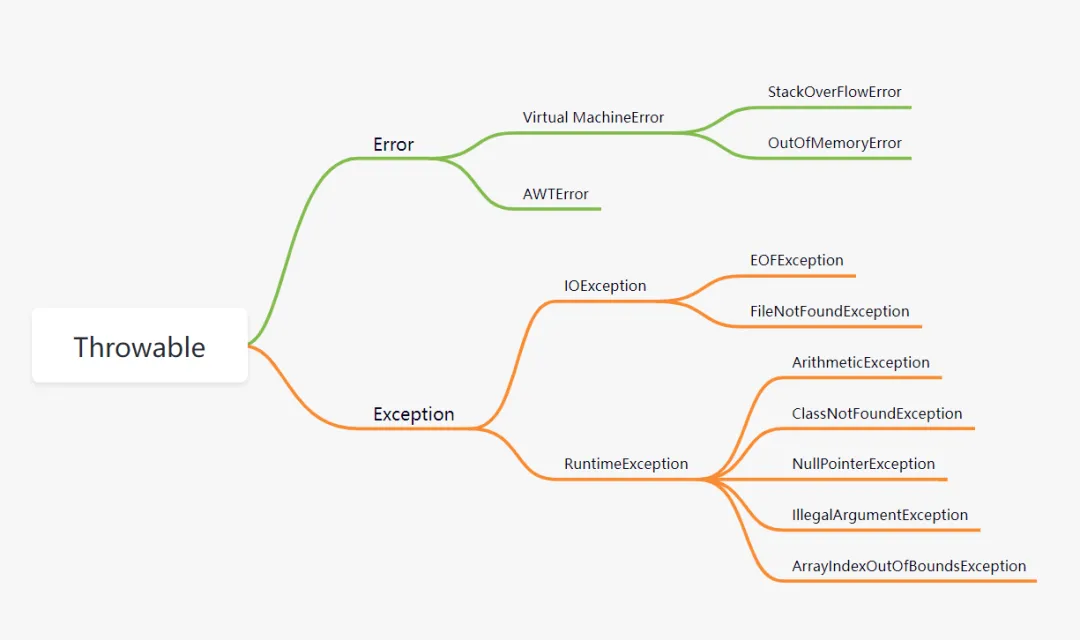

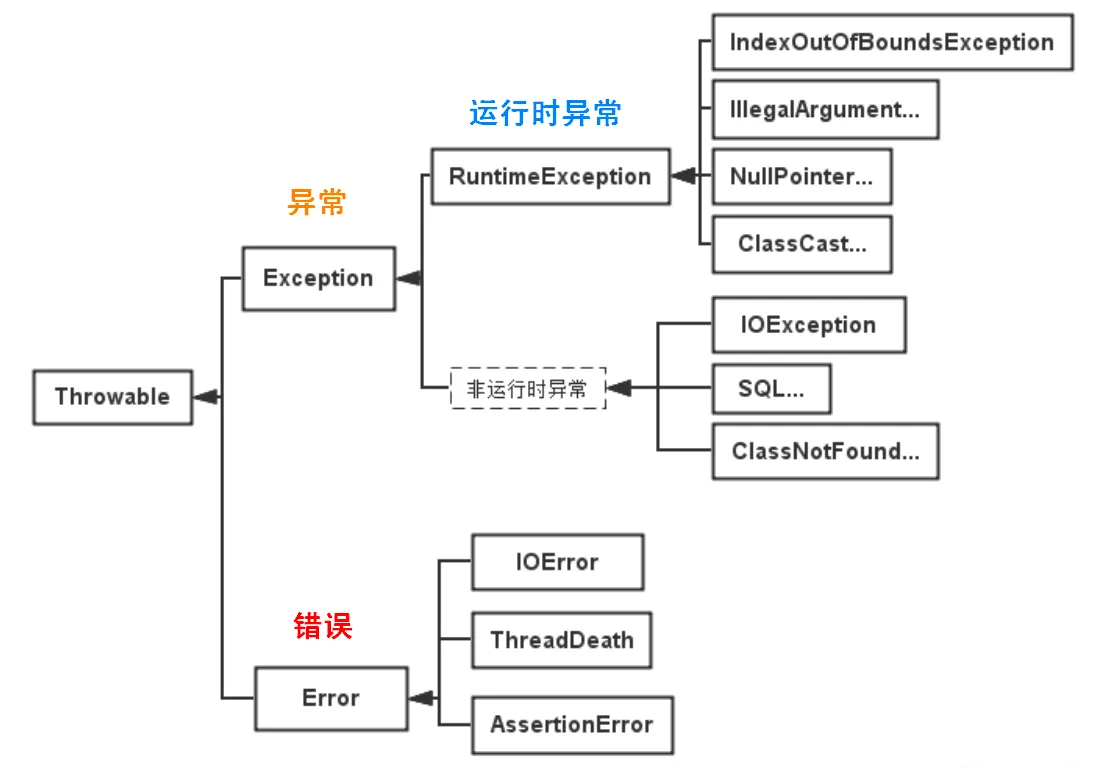

所有异常的共同的祖先是?运行时异常有哪几个?

Java 异常的顶层父类是 Throwable,它生了两个儿子,大儿子叫 Error,二儿子叫 Exception。

- Error:是程序⽆法处理的错误,一般表示系统错误,例如虚拟机相关的错误

OutOfMemoryError - Exception:程序本身可以处理的异常。它可以分为RuntimeException(运行时异常)和CheckedException(可检查的异常)。

什么是RuntimeException(运行时异常)?

运行时异常是不检查异常,程序中可以选择捕获处理,也可以不处理。这些异常一般是由程序逻辑错误引起的,程序应该从逻辑角度尽可能避免这类异常的发生。

常见的RuntimeException异常:

- NullPointerException:空指针异常

- ArithmeticException:出现异常的运算条件时,抛出此异常

- IndexOutOfBoundsException:数组索引越界异常

- ClassNotFoundException:找不到类异常

- IllegalArgumentException(非法参数异常)

什么是CheckedException(可检查的异常)?

从程序语法角度讲是必须进行处理的异常,如果不处理,程序就不能编译通过。如IOException、SQLException等。

常见的 Checked Exception 异常:

- IOException:(操作输入流和输出流时可能出现的异常)

- SQLException

动态代理了解吗?说一下原理?

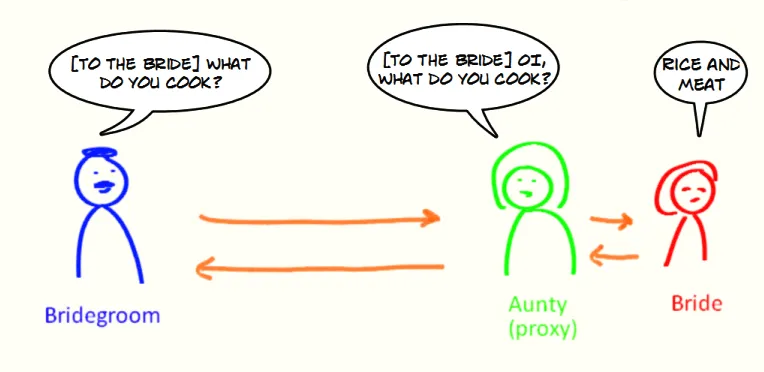

- 什么是代理?

代理模式是一种比较好理解的设计模式。简单来说就是 我们使用代理对象来代替对真实对象(real object)的访问,这样就可以在不修改原目标对象的前提下,提供额外的功能操作,扩展目标对象的功能。

代理模式的主要作用是扩展目标对象的功能,比如说在目标对象的某个方法执行前后你可以增加一些自定义的操作。

举个例子:你找了小红来帮你问话,小红就可以看作是代理你的代理对象,代理的行为(方法)是问话。

- 静态代理

静态代理中,我们对目标对象的每个方法的增强都是手动完成的,非常不灵活(*比如接口一旦新增加方法,目标对象和代理对象都要进行修改*)且麻烦(*需要对每个目标类都单独写一个代理类*)。 实际应用场景非常非常少,日常开发几乎看不到使用静态代理的场景。

上面我们是从实现和应用角度来说的静态代理,从 JVM 层面来说, 静态代理在编译时就将接口、实现类、代理类这些都变成了一个个实际的 class 文件。

静态代理实现步骤:

- 定义一个接口及其实现类;

- 创建一个代理类同样实现这个接口

- 将目标对象注入进代理类,然后在代理类的对应方法调用目标类中的对应方法。这样的话,我们就可以通过代理类屏蔽对目标对象的访问,并且可以在目标方法执行前后做一些自己想做的事情。

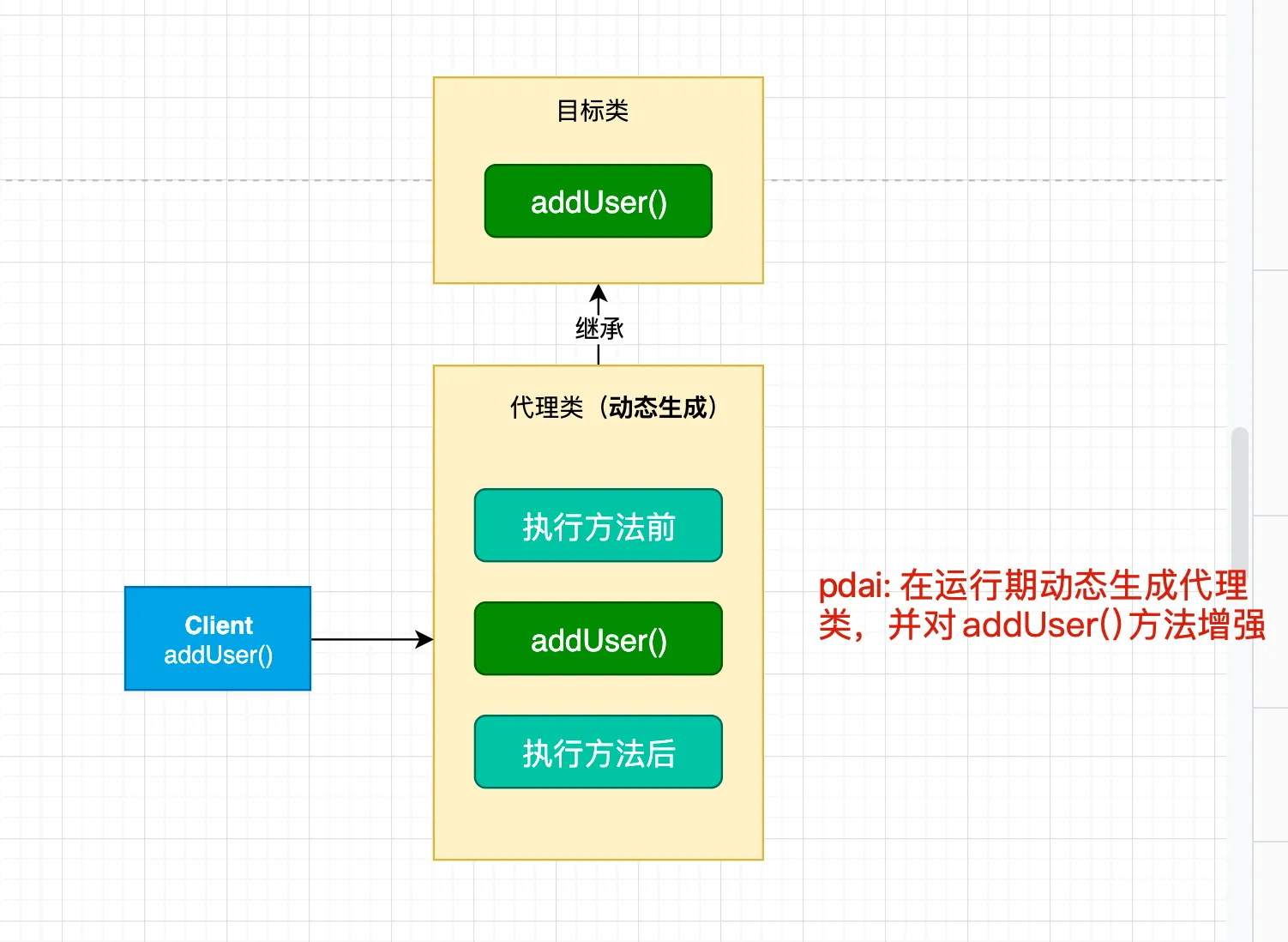

- 动态代理

相比于静态代理来说,动态代理更加灵活。我们不需要针对每个目标类都单独创建一个代理类,并且也不需要我们必须实现接口,我们可以直接代理实现类( CGLIB 动态代理机制)。

从 JVM 角度来说,动态代理是在运行时动态生成类字节码,并加载到 JVM 中的。

说到动态代理,Spring AOP、RPC 框架应该是两个不得不提的,它们的实现都依赖了动态代理。

动态代理在我们日常开发中使用的相对较少,但是在框架中的几乎是必用的一门技术。学会了动态代理之后,对于我们理解和学习各种框架的原理也非常有帮助。

就 Java 来说,动态代理的实现方式有很多种,比如 JDK 动态代理、CGLIB 动态代理等等。

3.1 机制介绍

在 Java 动态代理机制中 InvocationHandler 接口和 Proxy 类是核心。

当需要创建一个代理对象时,程序通过Proxy类的静态方法newProxyInstance()来创建一个代理对象,该方法需要传入一个类加载器、一组接口以及一个InvocationHandler对象。

public static Object newProxyInstance(ClassLoader loader,

Class<?>[] interfaces,

InvocationHandler h)

throws IllegalArgumentException

{

......

}

这个方法一共有 3 个参数:

- loader :类加载器,用于加载代理对象。

- interfaces : 被代理类实现的一些接口;

- h : 实现了

InvocationHandler接口的对象;

代理对象实现了这些接口,并将所有方法的调用委托给InvocationHandler对象进行处理。

要实现动态代理的话,还必须需要实现 InvocationHandler 来自定义处理逻辑。 当我们的动态代理对象调用一个方法时,这个方法的调用就会被转发到实现 InvocationHandler 接口类的 invoke 方法来调用。 在该方法中,可以执行一些额外的操作,例如记录日志、检查权限、修改参数等,然后将结果返回给代理对象。

public interface InvocationHandler {

/**

* 当你使用代理对象调用方法的时候实际会调用到这个方法

*/

public Object invoke(Object proxy, Method method, Object[] args)

throws Throwable;

}

invoke() 方法有下面三个参数:

- proxy :动态生成的代理类

- method : 与代理类对象调用的方法相对应

- args : 当前 method 方法的参数

也就是说:你通过 Proxy 类的 newProxyInstance() 创建的代理对象在调用方法的时候,实际会调用到实现 InvocationHandler 接口的类的 invoke()方法。 你可以在 invoke() 方法中自定义处理逻辑,比如在方法执行前后做什么事情

3.2 动态代理使用步骤

- 定义一个接口及其实现类;

- 自定义

InvocationHandler并重写invoke方法,在invoke方法中我们会调用原生方法(被代理类的方法)并自定义一些处理逻辑; - 通过

Proxy.newProxyInstance(ClassLoader loader,Class<?>[] interfaces,InvocationHandler h)方法创建代理对象

1.定义发送短信的接口

public interface SmsService {

String send(String message);

}

2.实现发送短信的接口

public class SmsServiceImpl implements SmsService {

public String send(String message) {

System.out.println("send message:" + message);

return message;

}

}

3.定义一个 JDK 动态代理类

import java.lang.reflect.InvocationHandler;

import java.lang.reflect.InvocationTargetException;

import java.lang.reflect.Method;

/**

* @author shuang.kou

* @createTime 2020年05月11日 11:23:00

*/

public class DebugInvocationHandler implements InvocationHandler {

/**

* 代理类中的真实对象

*/

private final Object target;

public DebugInvocationHandler(Object target) {

this.target = target;

}

public Object invoke(Object proxy, Method method, Object[] args) throws InvocationTargetException, IllegalAccessException {

//调用方法之前,我们可以添加自己的操作

System.out.println("before method " + method.getName());

Object result = method.invoke(target, args);

//调用方法之后,我们同样可以添加自己的操作

System.out.println("after method " + method.getName());

return result;

}

}

invoke() 方法: 当我们的动态代理对象调用原生方法的时候,最终实际上调用到的是 invoke() 方法,然后 invoke() 方法代替我们去调用了被代理对象的原生方法。

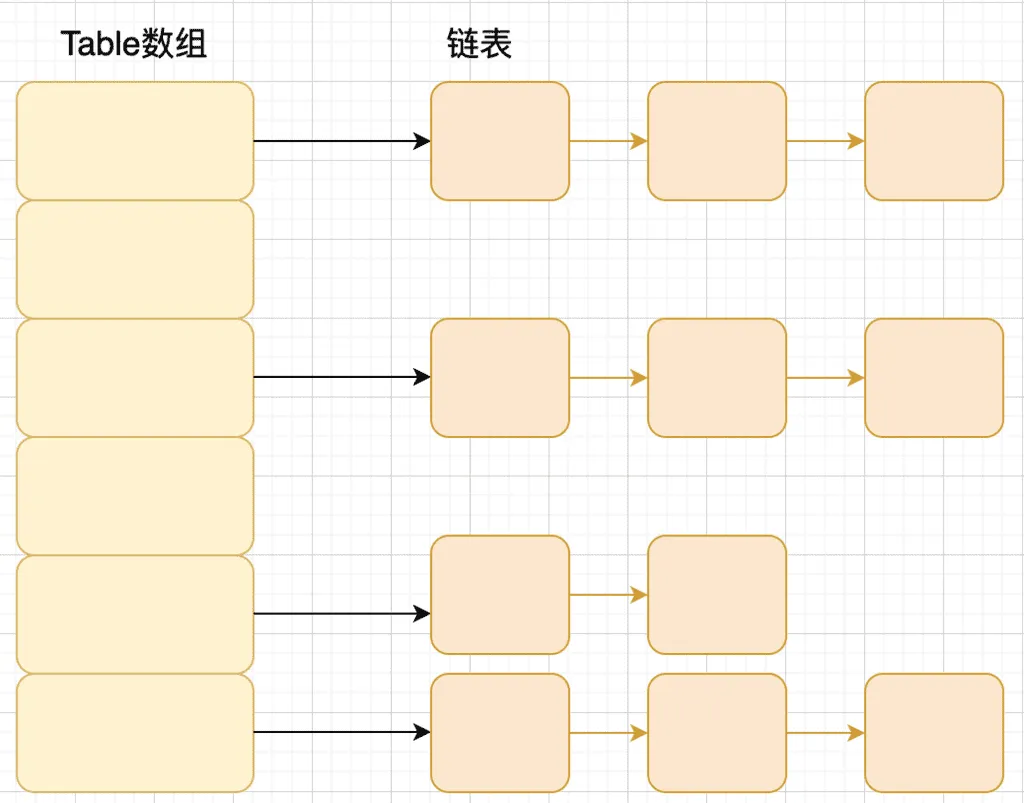

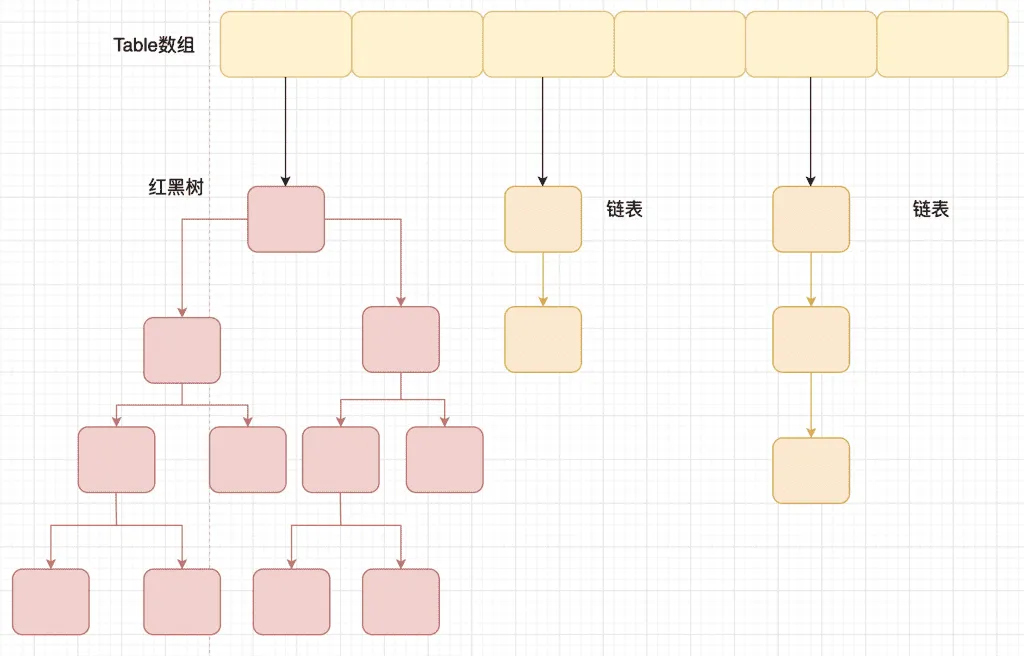

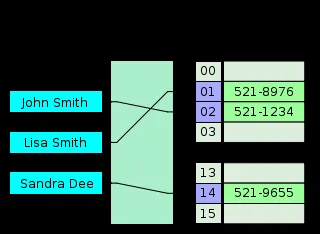

讲讲 hashmap,底层原理是什么?

JDK1.8 之前

JDK1.8 之前 HashMap 底层是 数组和链表 结合在一起使用也就是 链表散列。HashMap 通过 key 的 hashCode 经过扰动函数处理过后得到 hash 值,然后通过 (n - 1) & hash 判断当前元素存放的位置(这里的 n 指的是数组的长度),如果当前位置存在元素的话,就判断该元素与要存入的元素的 hash 值以及 key 是否相同,如果相同的话,直接覆盖,不相同就通过拉链法解决冲突。

所谓扰动函数指的就是 HashMap 的 hash 方法。使用 hash 方法也就是扰动函数是为了防止一些实现比较差的 hashCode() 方法 换句话说使用扰动函数之后可以减少碰撞。

JDK 1.8 HashMap 的 hash 方法源码:

JDK 1.8 的 hash 方法 相比于 JDK 1.7 hash 方法更加简化,但是原理不变。

static final int hash(Object key) {

int h;

// key.hashCode():返回散列值也就是hashcode

// ^ :按位异或

// >>>:无符号右移,忽略符号位,空位都以0补齐

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}

对比一下 JDK1.7 的 HashMap 的 hash 方法源码.

static int hash(int h) {

// This function ensures that hashCodes that differ only by

// constant multiples at each bit position have a bounded

// number of collisions (approximately 8 at default load factor).

h ^= (h >>> 20) ^ (h >>> 12);

return h ^ (h >>> 7) ^ (h >>> 4);

}

相比于 JDK1.8 的 hash 方法 ,JDK 1.7 的 hash 方法的性能会稍差一点点,因为毕竟扰动了 4 次。

所谓 “拉链法” 就是:将链表和数组相结合。也就是说创建一个链表数组,数组中每一格就是一个链表。若遇到哈希冲突,则将冲突的值加到链表中即可。

JDK1.8 之后

相比于之前的版本, JDK1.8 之后在解决哈希冲突时有了较大的变化,当链表长度大于阈值(默认为 8)(将链表转换成红黑树前会判断,如果当前数组的长度小于 64,那么会选择先进行数组扩容,而不是转换为红黑树)时,将链表转化为红黑树,以减少搜索时间。

TreeMap、TreeSet 以及 JDK1.8 之后的 HashMap 底层都用到了红黑树。红黑树就是为了解决二叉查找树的缺陷,因为二叉查找树在某些情况下会退化成一个线性结构。

stringbuilder 有用过吗?stringbuilder 和 stringbuffer 什么区别?

可变性

String 是不可变的(后面会详细分析原因)。

StringBuilder 与 StringBuffer 都继承自 AbstractStringBuilder 类,在 AbstractStringBuilder 中也是使用字符数组保存字符串,不过没有使用 final 和 private 关键字修饰,最关键的是这个 AbstractStringBuilder 类还提供了很多修改字符串的方法比如 append 方法。

abstract class AbstractStringBuilder implements Appendable, CharSequence {

char[] value;

public AbstractStringBuilder append(String str) {

if (str == null)

return appendNull();

int len = str.length();

ensureCapacityInternal(count + len);

str.getChars(0, len, value, count);

count += len;

return this;

}

//...

}

【重要】线程安全性

String 中的对象是不可变的,也就可以理解为常量,线程安全。AbstractStringBuilder 是 StringBuilder 与 StringBuffer 的公共父类,定义了一些字符串的基本操作,如 expandCapacity、append、insert、indexOf 等公共方法。StringBuffer 对方法加了同步锁或者对调用的方法加了同步锁,所以是线程安全的。StringBuilder 并没有对方法进行加同步锁,所以是非线程安全的。

小结:

- String 不可变,因此是线程安全的

- StringBuilder 不是线程安全的

- StringBuffer 是线程安全的,内部使用 synchronized 进行同步

性能

每次对 String 类型进行改变的时候,都会生成一个新的 String 对象,然后将指针指向新的 String 对象。StringBuffer 每次都会对 StringBuffer 对象本身进行操作,而不是生成新的对象并改变对象引用。相同情况下使用 StringBuilder 相比使用 StringBuffer 仅能获得 10%~15% 左右的性能提升,但却要冒多线程不安全的风险。

对于三者使用的总结:

- 操作少量的数据: 适用

String - 单线程操作字符串缓冲区下操作大量数据: 适用

StringBuilder - 多线程操作字符串缓冲区下操作大量数据: 适用

StringBuffer

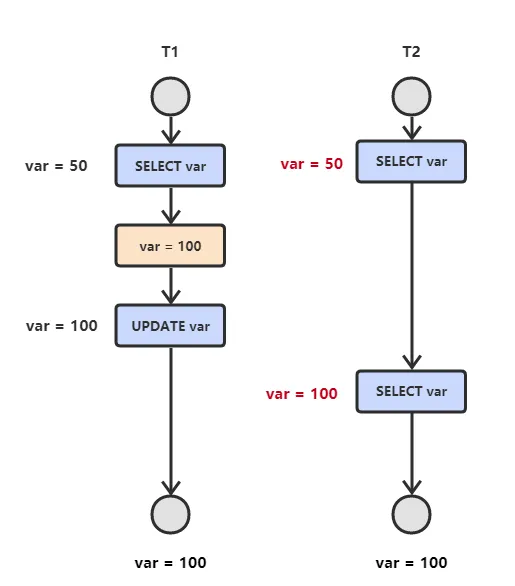

stringbuilder 为什么线程不安全?底层原理是什么?

StringBuilder 并没有对方法进行加同步锁

以StringBuffer为例,可以看到底层加入了同步锁

@Override

public synchronized int length() {

return count;

}

@Override

public synchronized int capacity() {

return value.length;

}

而StringBuilder则没有:

/**

* Returns the length (character count).

*

* @return the length of the sequence of characters currently

* represented by this object

*/

@Override

public int length() {

return count;

}

/**

* Returns the current capacity. The capacity is the amount of storage

* available for newly inserted characters, beyond which an allocation

* will occur.

*

* @return the current capacity

*/

public int capacity() {

return value.length;

}

底层原理:

StringBuilder无参构造方法默认在堆中创建16个长度的char[ ]数组,调用的是父类AbstractStringBuilder的构造方法,StringBuilder的有参构造方法在堆中创建参数的长度+16的char[ ]数组,添加的字符串依次从char[]数组前面为空的位置存入。当再次添加的字符串长度超过创建的char[ ]数组长度,就会进行扩容

/**

* Constructs a string builder with no characters in it and an

* initial capacity of 16 characters.

*/

public StringBuilder() {

super(16);

}

/**

* Constructs a string builder with no characters in it and an

* initial capacity specified by the {@code capacity} argument.

*

* @param capacity the initial capacity.

* @throws NegativeArraySizeException if the {@code capacity}

* argument is less than {@code 0}.

*/

public StringBuilder(int capacity) {

super(capacity);

}

/**

* Constructs a string builder initialized to the contents of the

* specified string. The initial capacity of the string builder is

* {@code 16} plus the length of the string argument.

*

* @param str the initial contents of the buffer.

*/

public StringBuilder(String str) {

super(str.length() + 16);

append(str);

}

扩容机制:

当要添加的字符串大于 > 当前字符数组的长度的时候扩容,扩容是: 原来长度*2+2 的方式扩容

/**

* Returns a capacity at least as large as the given minimum capacity.

* Returns the current capacity increased by the same amount + 2 if

* that suffices.

* Will not return a capacity greater than {@code MAX_ARRAY_SIZE}

* unless the given minimum capacity is greater than that.

*

* @param minCapacity the desired minimum capacity

* @throws OutOfMemoryError if minCapacity is less than zero or

* greater than Integer.MAX_VALUE

*/

private int newCapacity(int minCapacity) {

// overflow-conscious code

int newCapacity = (value.length << 1) + 2;

if (newCapacity - minCapacity < 0) {

newCapacity = minCapacity;

}

return (newCapacity <= 0 || MAX_ARRAY_SIZE - newCapacity < 0)

? hugeCapacity(minCapacity)

: newCapacity;

}

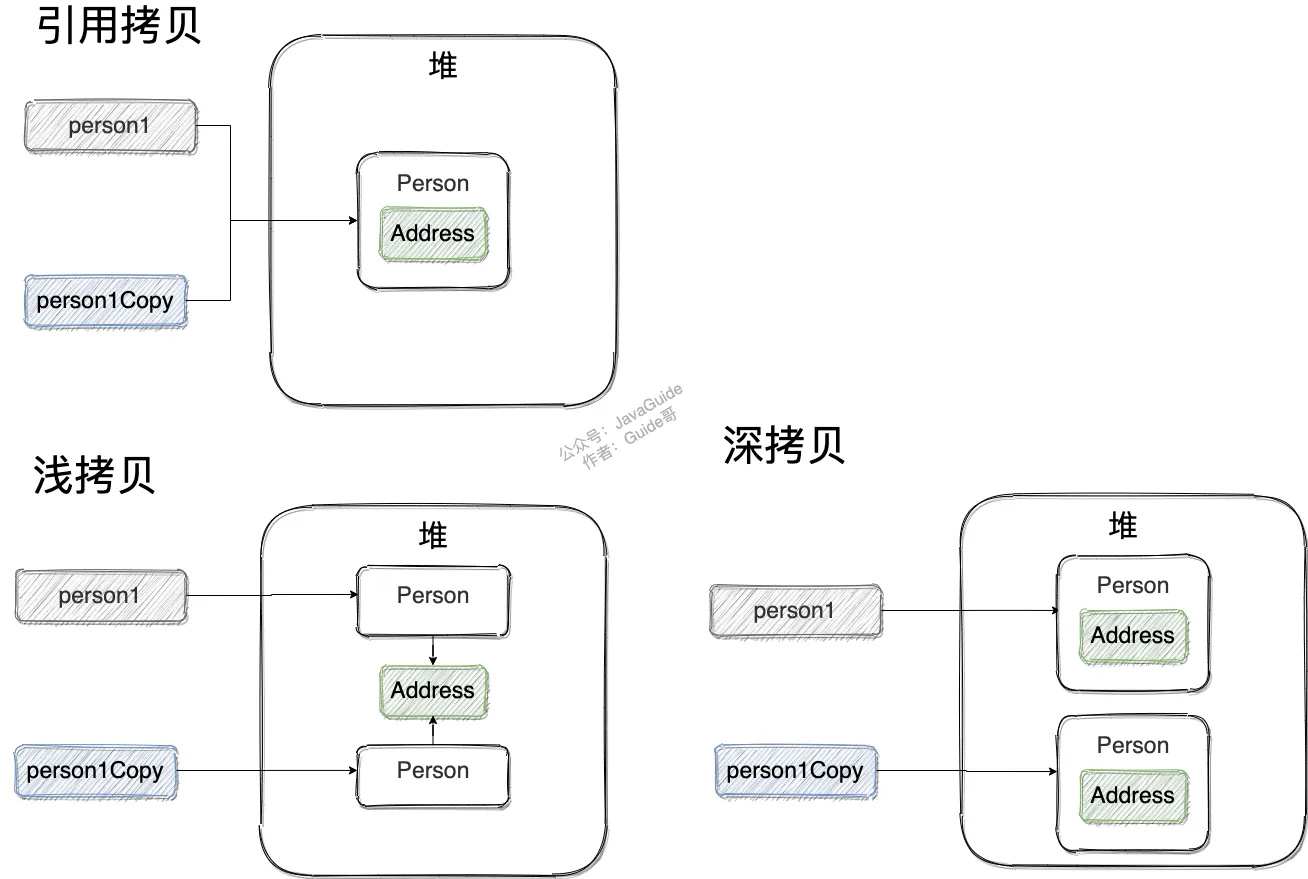

深拷贝和浅拷贝区别,工作原理

- 浅拷贝:对引用数据类型进行引用传递般的拷贝,此为浅拷贝。

- 深拷贝:对基本数据类型进行值传递,对引用数据类型,创建一个新的对象,并复制其内容,此为深拷贝。

深拷贝的另一种方式,使用序列化和反序列化,获取一个新对象。

浅拷贝的示例代码如下,我们这里实现了 Cloneable 接口,并重写了 clone() 方法。

clone() 方法的实现很简单,直接调用的是父类 Object 的 clone() 方法。

public class Address implements Cloneable{

private String name;

// 省略构造函数、Getter&Setter方法

@Override

public Address clone() {

try {

return (Address) super.clone();

} catch (CloneNotSupportedException e) {

throw new AssertionError();

}

}

}

public class Person implements Cloneable {

private Address address;

// 省略构造函数、Getter&Setter方法

@Override

public Person clone() {

try {

Person person = (Person) super.clone();

return person;

} catch (CloneNotSupportedException e) {

throw new AssertionError();

}

}

}

深拷贝

这里我们简单对 Person 类的 clone() 方法进行修改,连带着要把 Person 对象内部的 Address 对象一起复制。

@Override

public Person clone() {

try {

Person person = (Person) super.clone();

person.setAddress(person.getAddress().clone());

return person;

} catch (CloneNotSupportedException e) {

throw new AssertionError();

}

}

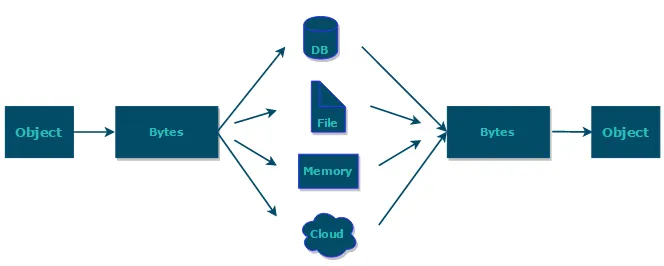

序列化和反序列化的概念,方式,例子(2022美团)

如果我们需要持久化 Java 对象比如将 Java 对象保存在文件中,或者在网络传输 Java 对象,这些场景都需要用到序列化。

简单来说:

- 序列化: 将数据结构或对象转换成二进制字节流的过程

- 反序列化:将在序列化过程中所生成的二进制字节流转换成数据结构或者对象的过程

对于 Java 这种面向对象编程语言来说,我们序列化的都是对象(Object)也就是实例化后的类(Class),但是在 C++这种半面向对象的语言中,struct(结构体)定义的是数据结构类型,而 class 对应的是对象类型。

维基百科是如是介绍序列化的:

序列化(serialization)在计算机科学的数据处理中,是指将数据结构或对象状态转换成可取用格式(例如存成文件,存于缓冲,或经由网络中发送),以留待后续在相同或另一台计算机环境中,能恢复原先状态的过程。依照序列化格式重新获取字节的结果时,可以利用它来产生与原始对象相同语义的副本。对于许多对象,像是使用大量引用的复杂对象,这种序列化重建的过程并不容易。面向对象中的对象序列化,并不概括之前原始对象所关系的函数。这种过程也称为对象编组(marshalling)。从一系列字节提取数据结构的反向操作,是反序列化(也称为解编组、deserialization、unmarshalling)。

综上:序列化的主要目的是通过网络传输对象或者说是将对象存储到文件系统、数据库、内存中。

例子:

/*

* 使用序列化和反序列化创建对象,这种方式其实是根据既有的对象进行复制,这个需要事先将可序列化的对象线存到文件里

*/

@SuppressWarnings("resource")

public static Worker createWorker4(String objectPath) {

ObjectInput input = null;

Worker worker = null;

try {

input = new ObjectInputStream(new FileInputStream(objectPath));

worker = (Worker) input.readObject();

} catch (FileNotFoundException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

return worker;

}

/*

* 将创建的对象存入到文件内

*/

public static void storeObject2File(String objectPath) {

Worker worker = new Worker();

ObjectOutputStream objectOutputStream;

try {

objectOutputStream = new ObjectOutputStream(new FileOutputStream(

objectPath));

objectOutputStream.writeObject(worker);

} catch (FileNotFoundException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

异常分类,受检异常和非受检异常区别,自定义异常优点

Java 异常类层次结构图:

程序本身可以捕获并且可以处理的异常。Exception 这种异常又分为两类:运行时异常和编译时异常。

- 运行时异常

都是 RuntimeException 类及其子类异常,如 NullPointerException(空指针异常)、IndexOutOfBoundsException(下标越界异常)等,这些异常是不检查异常,程序中可以选择捕获处理,也可以不处理。这些异常一般是由程序逻辑错误引起的,程序应该从逻辑角度尽可能避免这类异常的发生。

运行时异常的特点是 Java 编译器不会检查它,也就是说,当程序中可能出现这类异常,即使没有用 try-catch 语句捕获它,也没有用 throws 子句声明抛出它,也会编译通过。

- 非运行时异常 (编译异常)

是 RuntimeException 以外的异常,类型上都属于 Exception 类及其子类。从程序语法角度讲是必须进行处理的异常,如果不处理,程序就不能编译通过。如 IOException、SQLException 等以及用户自定义的 Exception 异常,一般情况下不自定义检查异常。

受检异常 :需要用 try...catch... 语句捕获并进行处理,并且可以从异常中恢复;

非受检异常 :是程序运行时错误,例如除 0 会引发 Arithmetic Exception,此时程序崩溃并且无法恢复

有没有用过自定义异常,声明式异常工作流程,和 return 区别,项目中自定义异常工作流程

用过

项目中自定义异常工作流程:

- 新建异常类,可以继承Exception类,或者继承RuntimeException

- 定义code和message参数,以便调用时传入对应状态码和错误信息

- 使用自定义异常

throw指抛出异常,并且该方法以及调用该方法的一切方法将不会向下执行。

return的作用很简单,意思是方法直接返回了,该方法不在向下执行。但是调用该方法的方法继续执行。

Java 中的异常处理除了包括捕获异常和处理异常之外,还包括声明异常和拋出异常,可以通过 throws 关键字在方法上声明该方法要拋出的异常,然后在方法内部通过 throw 拋出异常对象

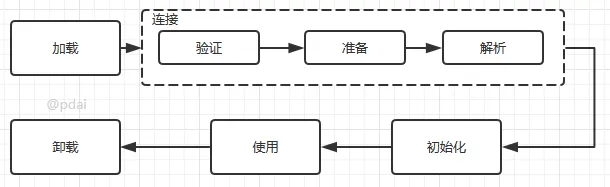

类的生命周期,什么时候回收

其中类加载的过程包括了 加载、验证、准备、解析、初始化五个阶段。在这五个阶段中,加载、验证、准备和 初始化这四个阶段发生的顺序是确定的,而 解析阶段则不一定,它在某些情况下可以在初始化阶段之后开始,这是为了支持 Java 语言的运行时绑定(也称为动态绑定或晚期绑定)。另外注意这里的几个阶段是按顺序开始,而不是按顺序进行或完成,因为这些阶段通常都是互相交叉地混合进行的,通常在一个阶段执行的过程中调用或激活另一个阶段。

Java 虚拟机将结束生命周期的几种情况

- 执行了 System.exit()方法

- 程序正常执行结束

- 程序在执行过程中遇到了异常或错误而异常终止

- 由于操作系统出现错误而导致 Java 虚拟机进程终止

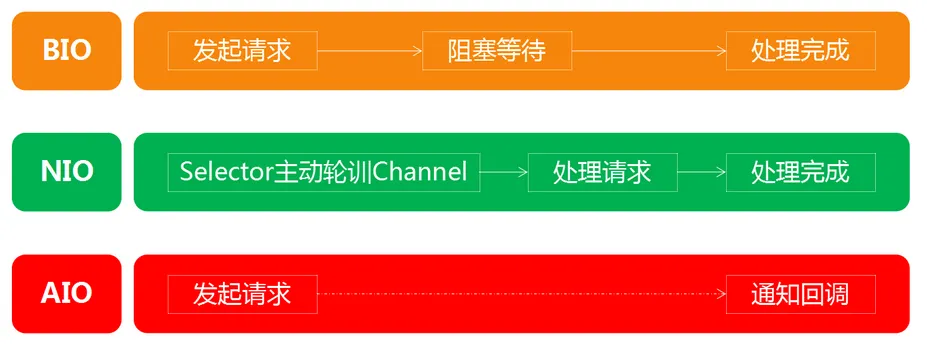

NIO 和 AIO

NIO (Non-blocking/New I/O)

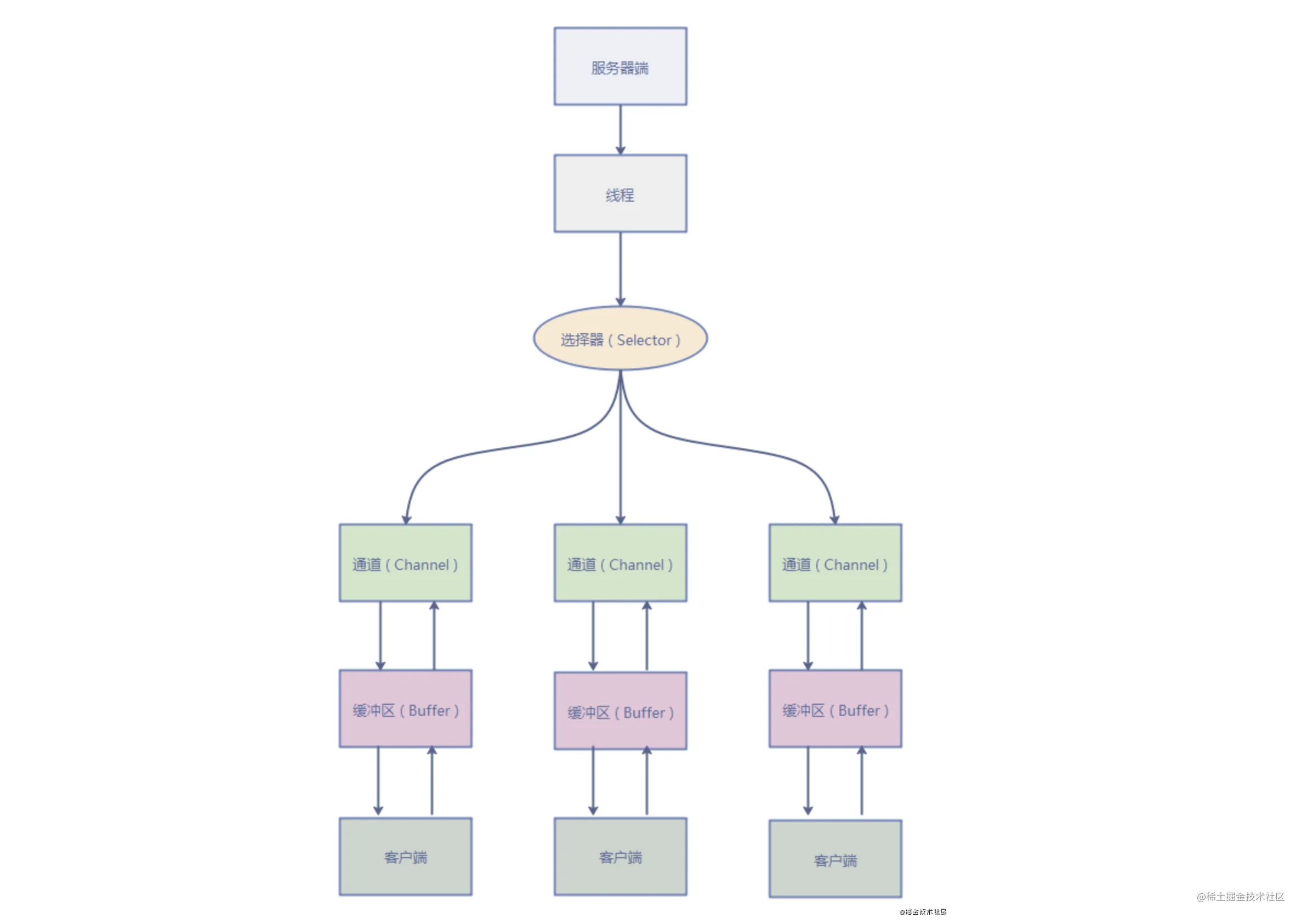

Java 中的 NIO 于 Java 1.4 中引入,对应 java.nio 包,提供了 Channel , Selector,Buffer 等抽象。NIO 中的 N 可以理解为 Non-blocking,不单纯是 New。它是支持面向缓冲的,基于通道的 I/O 操作方法。 对于高负载、高并发的(网络)应用,应使用 NIO 。

Java 中的 NIO 可以看作是 I/O 多路复用模型。也有很多人认为,Java 中的 NIO 属于同步非阻塞 IO 模型。

跟着我的思路往下看看,相信你会得到答案!

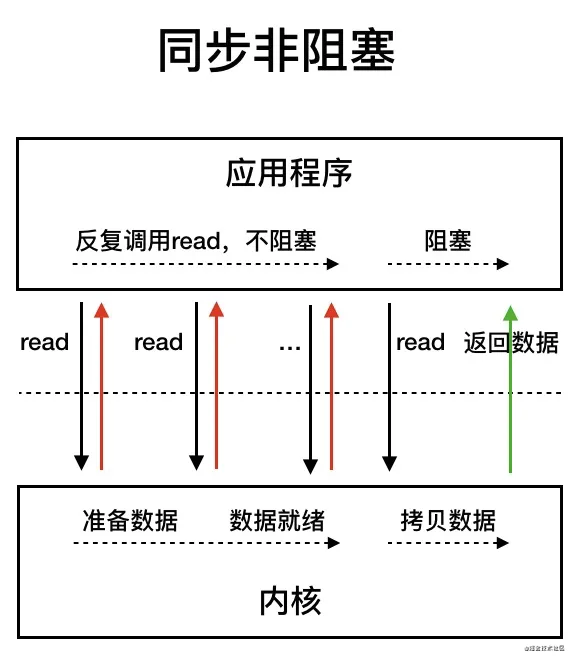

我们先来看看 同步非阻塞 IO 模型。

同步非阻塞 IO 模型中,应用程序会一直发起 read 调用,等待数据从内核空间拷贝到用户空间的这段时间里,线程依然是阻塞的,直到在内核把数据拷贝到用户空间。

相比于同步阻塞 IO 模型,同步非阻塞 IO 模型确实有了很大改进。通过轮询操作,避免了一直阻塞。

但是,这种 IO 模型同样存在问题:应用程序不断进行 I/O 系统调用轮询数据是否已经准备好的过程是十分消耗 CPU 资源的。

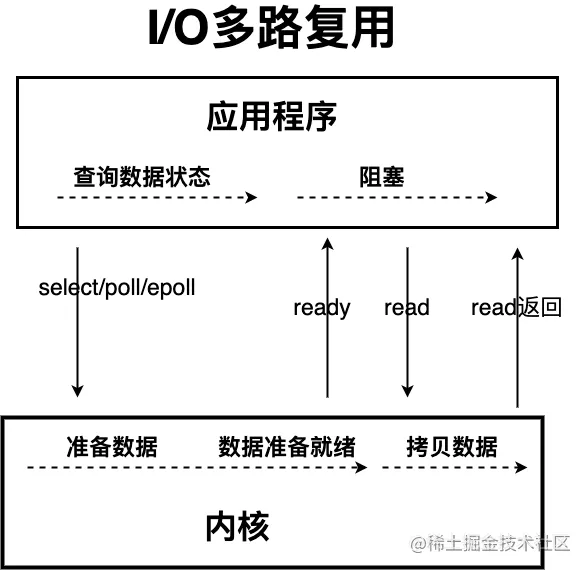

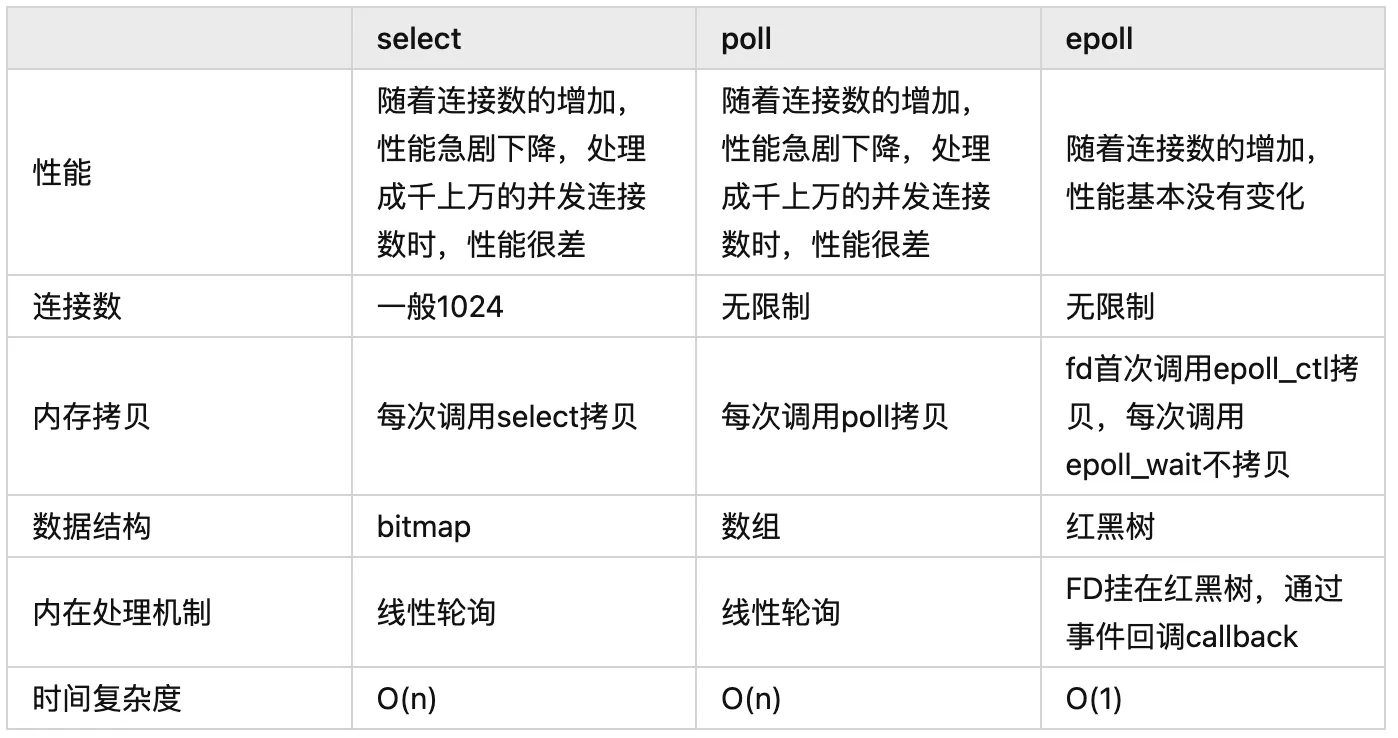

这个时候,I/O 多路复用模型 就上场了。

IO 多路复用模型中,线程首先发起 select 调用,询问内核数据是否准备就绪,等内核把数据准备好了,用户线程再发起 read 调用。read 调用的过程(数据从内核空间 -> 用户空间)还是阻塞的。

目前支持 IO 多路复用的系统调用,有 select,epoll 等等。select 系统调用,目前几乎在所有的操作系统上都有支持。

- select 调用 :内核提供的系统调用,它支持一次查询多个系统调用的可用状态。几乎所有的操作系统都支持。

- epoll 调用 :linux 2.6 内核,属于 select 调用的增强版本,优化了 IO 的执行效率。

IO 多路复用模型,通过减少无效的系统调用,减少了对 CPU 资源的消耗。

Java 中的 NIO ,有一个非常重要的选择器 ( Selector ) 的概念,也可以被称为 多路复用器。通过它,只需要一个线程便可以管理多个客户端连接。当客户端数据到了之后,才会为其服务。

AIO

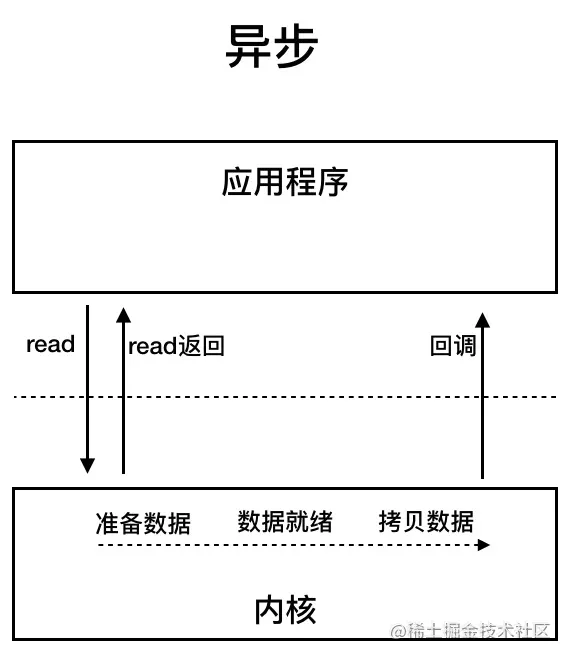

AIO 也就是 NIO 2。Java 7 中引入了 NIO 的改进版 NIO 2,它是异步 IO 模型。

异步 IO 是基于事件和回调机制实现的,也就是应用操作之后会直接返回,不会堵塞在那里,当后台处理完成,操作系统会通知相应的线程进行后续的操作。

目前来说 AIO 的应用还不是很广泛。Netty 之前也尝试使用过 AIO,不过又放弃了。这是因为,Netty 使用了 AIO 之后,在 Linux 系统上的性能并没有多少提升。

最后,来一张图,简单总结一下 Java 中的 BIO、NIO、AIO。

Java 多态概念,实现原理

多态分为编译时多态和运行时多态:

- 编译时多态主要指方法的重载

- 运行时多态指程序中定义的对象引用所指向的具体类型在运行期间才确定

运行时多态有三个条件:

- 继承

- 覆盖(重写)

- 向上转型

Java中的多态(Polymorphism)是指同一个方法在不同情况下的多种实现方式,也就是同一个方法可以根据不同的参数类型、个数或者对象类型而有不同的表现形式。Java中实现多态的方式有两种:方法重载(Overloading)和方法重写(Overriding)。

- 方法重载 方法重载是指在同一个类中定义多个方法名相同但是参数类型、个数或者顺序不同的方法。Java编译器根据方法的参数类型、个数或者顺序来确定调用哪个方法,从而实现多态。

- 方法重写 方法重写是指子类重写了父类中的同名同参数的方法,从而实现多态。在方法重写时,子类必须保证重写方法的返回值类型、方法名和参数类型与父类中的方法相同或者是其子类。

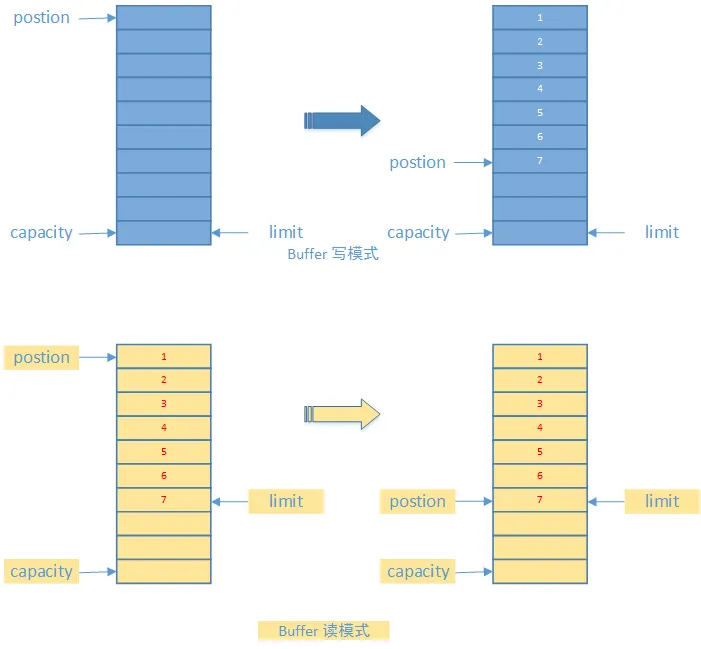

NIO 的 buffer 区是双向的吗?

是双向的

数据缓存区: 在 JAVA NIO 框架中,为了保证每个通道的数据读写速度 JAVA NIO 框架为每一种需要支持数据读写的通道集成了 Buffer 的支持。

这句话怎么理解呢? 例如 ServerSocketChannel 通道它只支持对 OP_ACCEPT 事件的监听,所以它是不能直接进行网络数据内容的读写的。所以 ServerSocketChannel 是没有集成 Buffer 的。

Buffer 有两种工作模式: 写模式和读模式。在读模式下,应用程序只能从 Buffer 中读取数据,不能进行写操作。但是在写模式下,应用程序是可以进行读操作的,这就表示可能会出现脏读的情况。所以一旦您决定要从 Buffer 中读取数据,一定要将 Buffer 的状态改为读模式。

如下图:

- position: 缓存区目前正在操作的数据块位置

- limit: 缓存区最大可以进行操作的位置。缓存区的读写状态正是由这个属性控制的。

- capacity: 缓存区的最大容量。这个容量是在缓存区创建时进行指定的。由于高并发时通道数量往往会很庞大,所以每一个缓存区的容量最好不要过大。

在下文 JAVA NIO 框架的代码实例中,我们将进行 Buffer 缓存区操作的演示

泛型有啥用?泛型擦除是啥?

泛型的本质是为了参数化类型(在不创建新的类型的情况下,通过泛型指定的不同类型来控制形参具体限制的类型)。也就是说在泛型使用过程中,操作的数据类型被指定为一个参数,这种参数类型可以用在类、接口和方法中,分别被称为泛型类、泛型接口、泛型方法。

引入泛型的意义在于:

- 适用于多种数据类型执行相同的代码(代码复用)

- 泛型中的类型在使用时指定,不需要强制类型转换(类型安全,编译器会检查类型)

泛型擦除:

Java语言中的泛型被称为伪泛型,因为这种泛型它只在编写的源码中存在,在经过编译器编译后的字节码文件中不会包含泛型中的类型信息了,泛型信息在编译的时候被擦除了,并且会在相应的地方插入强制类型转换的代码,这个过程就是泛型擦除。例如new ArrayList<String>(),泛型擦除后就是new ArrayList(),对其元素的操作也会加上(String)强制类型转换。

常见的索引结构有?哈希表结构属于哪种场景?(2022OPPO)

哈希表、有序数组和搜索树。

- 哈希表这种结构适用于只有等值查询的场景

- 有序数组适合范围查询,用二分法快速得到,时间复杂度为 O(log(N))。查询还好,如果是插入,就得挪动后面所有的记录,成本太高。因此它一般只适用静态存储引擎,比如保存2018年某个城市的所有人口信息。

- B+树适合范围查询,我们一般建的索引结构都是B+树。

拓展:给你ab,ac,abc字段,你是如何加索引的?

这主要考察联合索引的最左前缀原则知识点。

- 这个最左前缀可以是联合索引的最左

N个字段。比如组合索引(a,b,c)可以相当于建了(a),(a,b),(a,b,c)三个索引,大大提高了索引复用能力。 - 最左前缀也可以是字符串索引的最左

M个字符。

因此给你 ab,ac,abc字段,你可以直接加 abc联合索引和 ac联合索引即可。

联合索引是什么

基于多个字段创建的索引我们称为联合索引,比如我们创建索引create index idx on table(A,B,C) 我们称在字段A,B,C上创建了一个联合索引

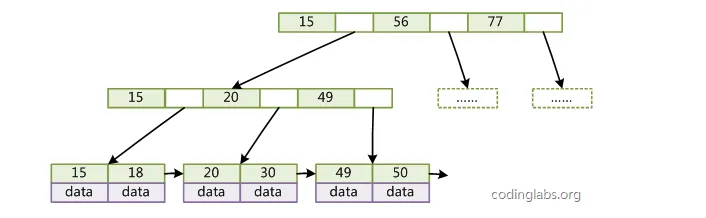

我们知道,索引存储底层是B+树,在InnoDB存储引擎下,主键索引叶子节点存储的是数据,非主键索引上存储的是主键id,在联合索引下,这个B+树是如何组织的呢,我们通过一个具体的例子来看一下,首先我们先建立一个表,向表里添加一些数据。

CREATE TABLE `user` (

`id` int(11) NOT NULL AUTO_INCREMENT COMMENT '主键id自增',

`age` int(11) NULL DEFAULT NULL COMMENT '年龄',

`money` int(11) NULL DEFAULT NULL COMMENT '账户余额 ,真正开发时候,余额不能用整数哈',

`ismale` int(11) NULL DEFAULT NULL comment '性别 0男1女',

`name` varchar(20) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL comment '名称',

PRIMARY KEY (`id`) USING BTREE,

INDEX `index_bcd`(`age`, `money`) USING BTREE

) ENGINE = InnoDB AUTO_INCREMENT = 1 CHARACTER SET = utf8 COLLATE = utf8_general_ci ROW_FORMAT = Dynamic;

联合索引和单个索引对比来讲,联合索引的所有索引项都会出现在索引上,存储引擎会先根据第一个索引项排序,如果第一个索引项相同的话才会去看第二个,所有我们在查询的时候,如果头索引不带的话,联合索引就会失效,因为在根节点他就不知道怎么往下走。比如我们现在select * from USER us where us.age=20 and us.money=30这个sql去查的,首先在根节点上age>1并且<60,那么读下一个节点,依次类推读到叶子节点上取出主键id回表查询所有的字段值。

Mysql系列-联合索引 - 个人文章 - SegmentFault 思否

Java BIO NIO AIO 三者的区别?

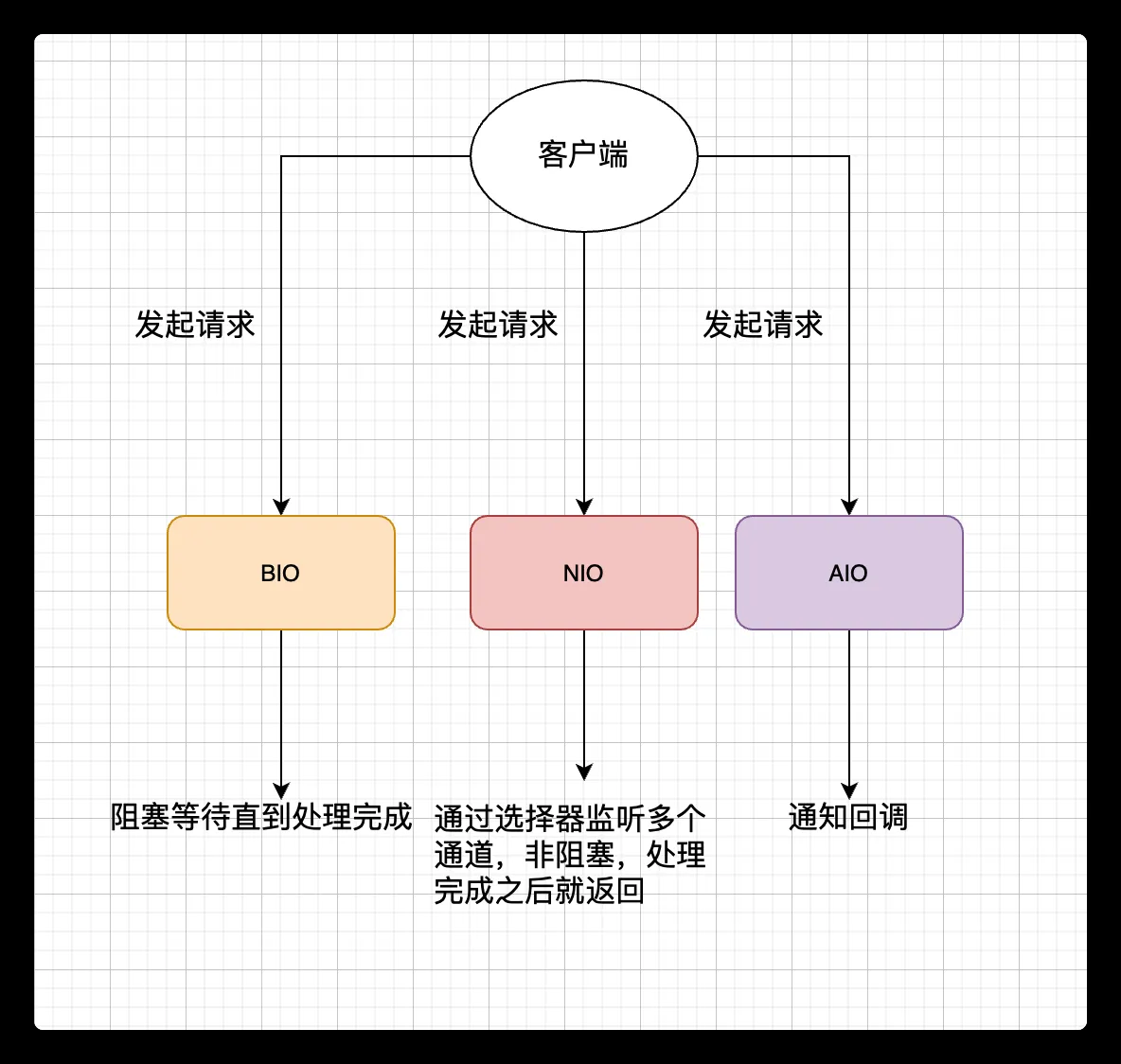

Java BIO[Blocking I/O] | 同步阻塞I/O模式

- BIO 全称Block-IO 是一种同步且阻塞的通信模式。是一个比较传统的通信方式,模式简单,使用方便。但并发处理能力低,通信耗时,依赖网速。

Java NIO[New I/O] | 同步非阻塞模式(也可以称为IO多路复用模型)

- Java NIO,全程 Non-Block IO ,是Java SE 1.4版以后,针对网络传输效能优化的新功能。是一种非阻塞同步的通信模式。

- NIO 与原来的 I/O 有同样的作用和目的, 他们之间最重要的区别是数据打包和传输的方式。原来的 I/O 以流的方式处理数据,而 NIO 以块的方式处理数据。

- 面向流的 I/O 系统一次一个字节地处理数据。一个输入流产生一个字节的数据,一个输出流消费一个字节的数据。

- 面向块的 I/O 系统以块的形式处理数据。每一个操作都在一步中产生或者消费一个数据块。按块处理数据比按(流式的)字节处理数据要快得多。但是面向块的 I/O - 缺少一些面向流的 I/O 所具有的优雅性和简单性。

Java AIO[Asynchronous I/O] | 异步非阻塞I/O模型

- Java AIO,全程 Asynchronous IO,是异步非阻塞的IO。是一种非阻塞异步的通信模式。在NIO的基础上引入了新的异步通道的概念,并提供了异步文件通道和异步套接字通道的实现。

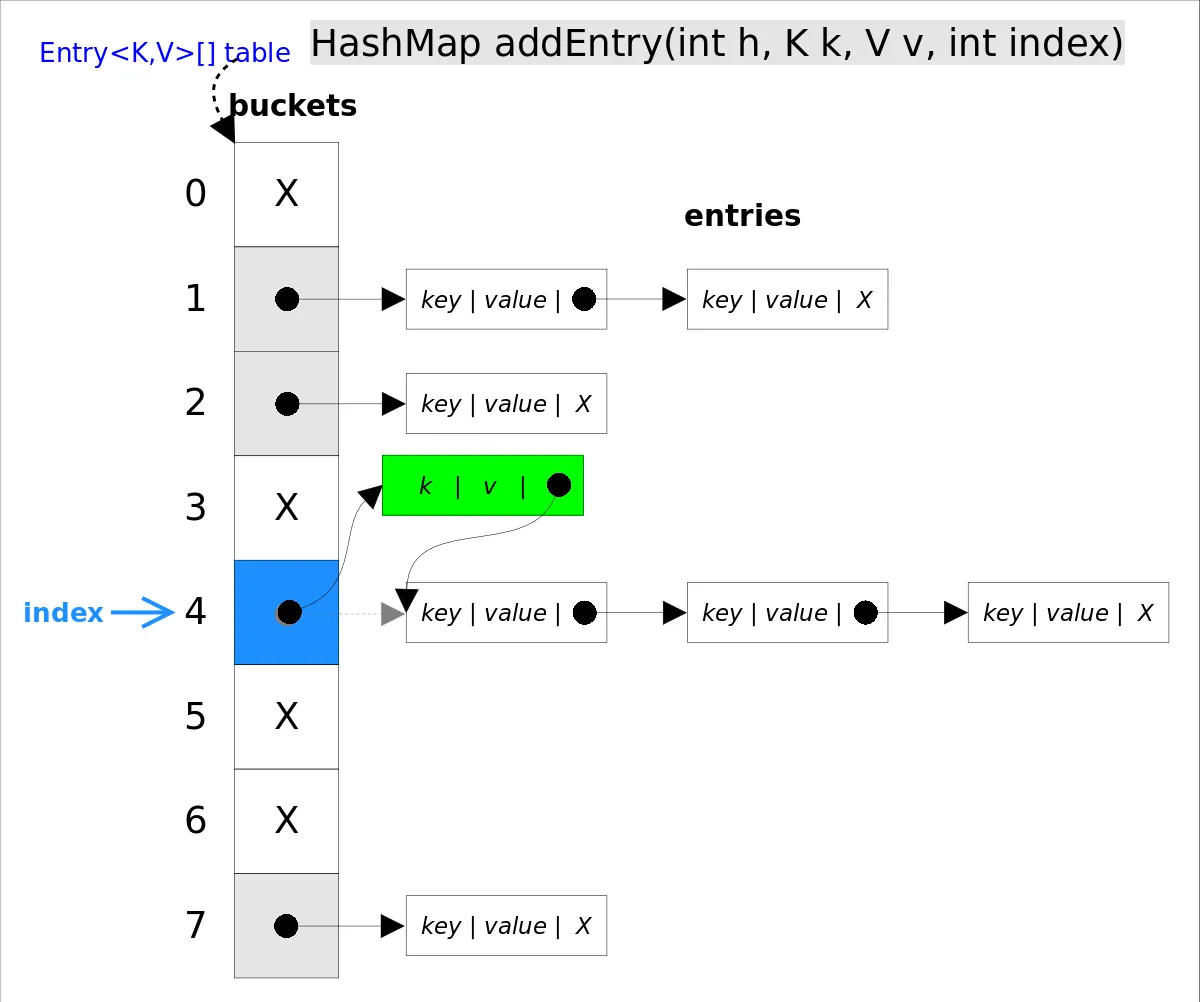

hashmap put() 工作流程(2022飞书)

put(K key, V value)方法是将指定的 key, value对添加到 map里。该方法首先会对 map做一次查找,看是否包含该元组,如果已经包含则直接返回,查找过程类似于 getEntry()方法;如果没有找到,则会通过 addEntry(int hash, K key, V value, int bucketIndex)方法插入新的 entry,插入方式为头插法。

//addEntry()

void addEntry(int hash, K key, V value, int bucketIndex) {

if ((size >= threshold) && (null != table[bucketIndex])) {

resize(2 * table.length);//自动扩容,并重新哈希

hash = (null != key) ? hash(key) : 0;

bucketIndex = hash & (table.length-1);//hash%table.length

}

//在冲突链表头部插入新的entry

Entry<K,V> e = table[bucketIndex];

table[bucketIndex] = new Entry<>(hash, key, value, e);

size++;

}

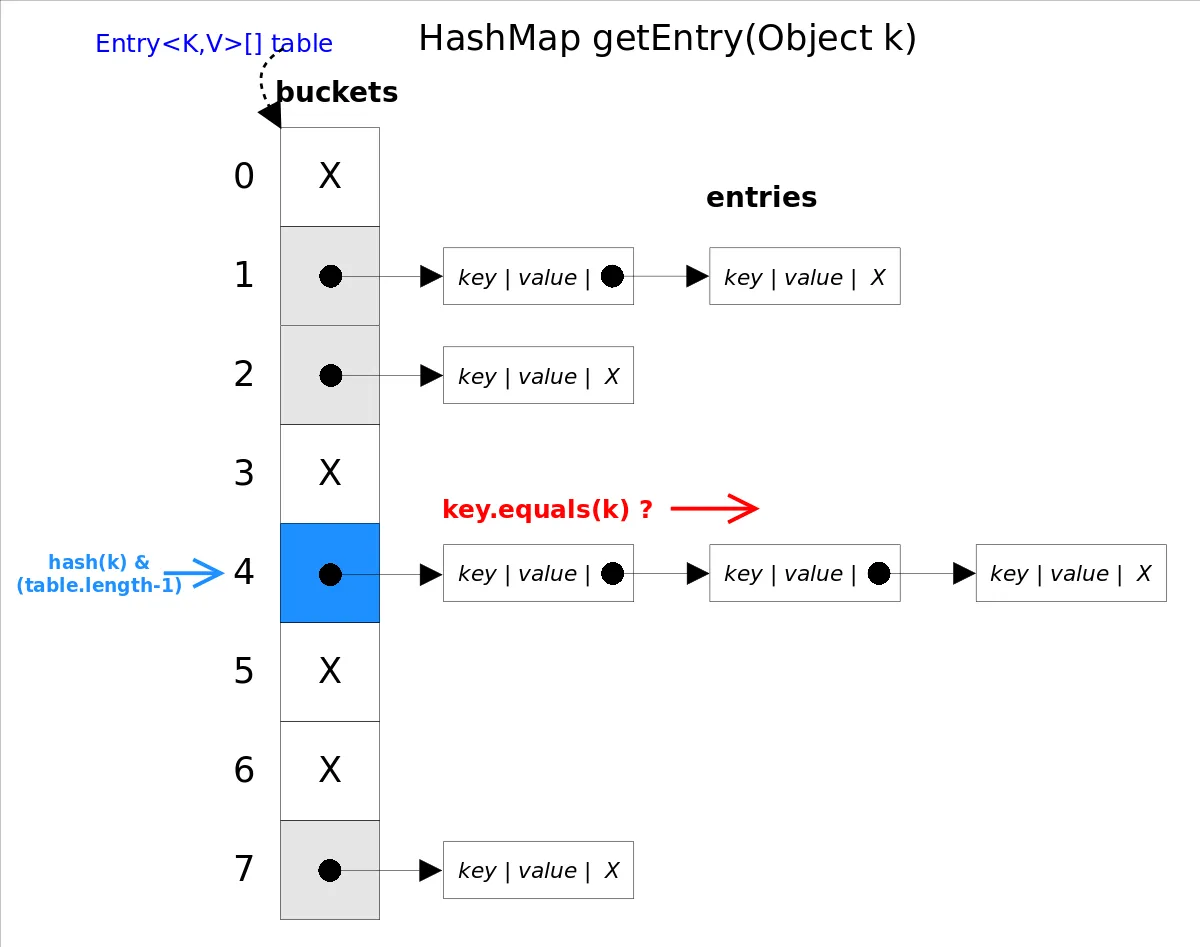

拓展:get() remove()

get(Object key)方法根据指定的 key值返回对应的 value,该方法调用了 getEntry(Object key)得到相应的 entry,然后返回 entry.getValue()。因此 getEntry()是算法的核心。 算法思想是首先通过 hash()函数得到对应 bucket的下标,然后依次遍历冲突链表,通过 key.equals(k)方法来判断是否是要找的那个 entry。

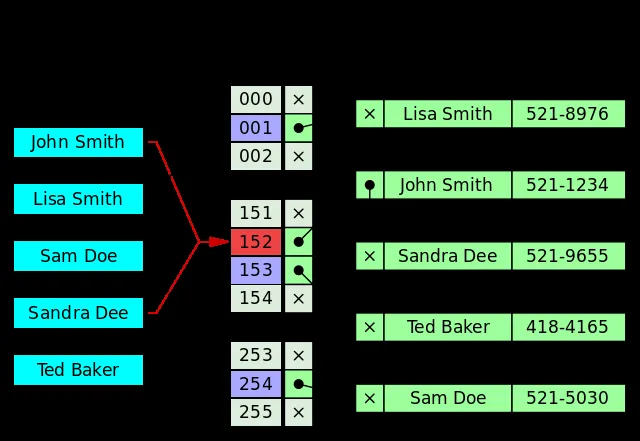

上图中 hash(k)&(table.length-1)等价于 hash(k)%table.length,原因是HashMap要求 table.length必须是2的指数,因此 table.length-1就是二进制低位全是1,跟 hash(k)相与会将哈希值的高位全抹掉,剩下的就是余数了。

//getEntry()方法

final Entry<K,V> getEntry(Object key) {

......

int hash = (key == null) ? 0 : hash(key);

for (Entry<K,V> e = table[hash&(table.length-1)];//得到冲突链表

e != null; e = e.next) {//依次遍历冲突链表中的每个entry

Object k;

//依据equals()方法判断是否相等

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

}

return null;

}

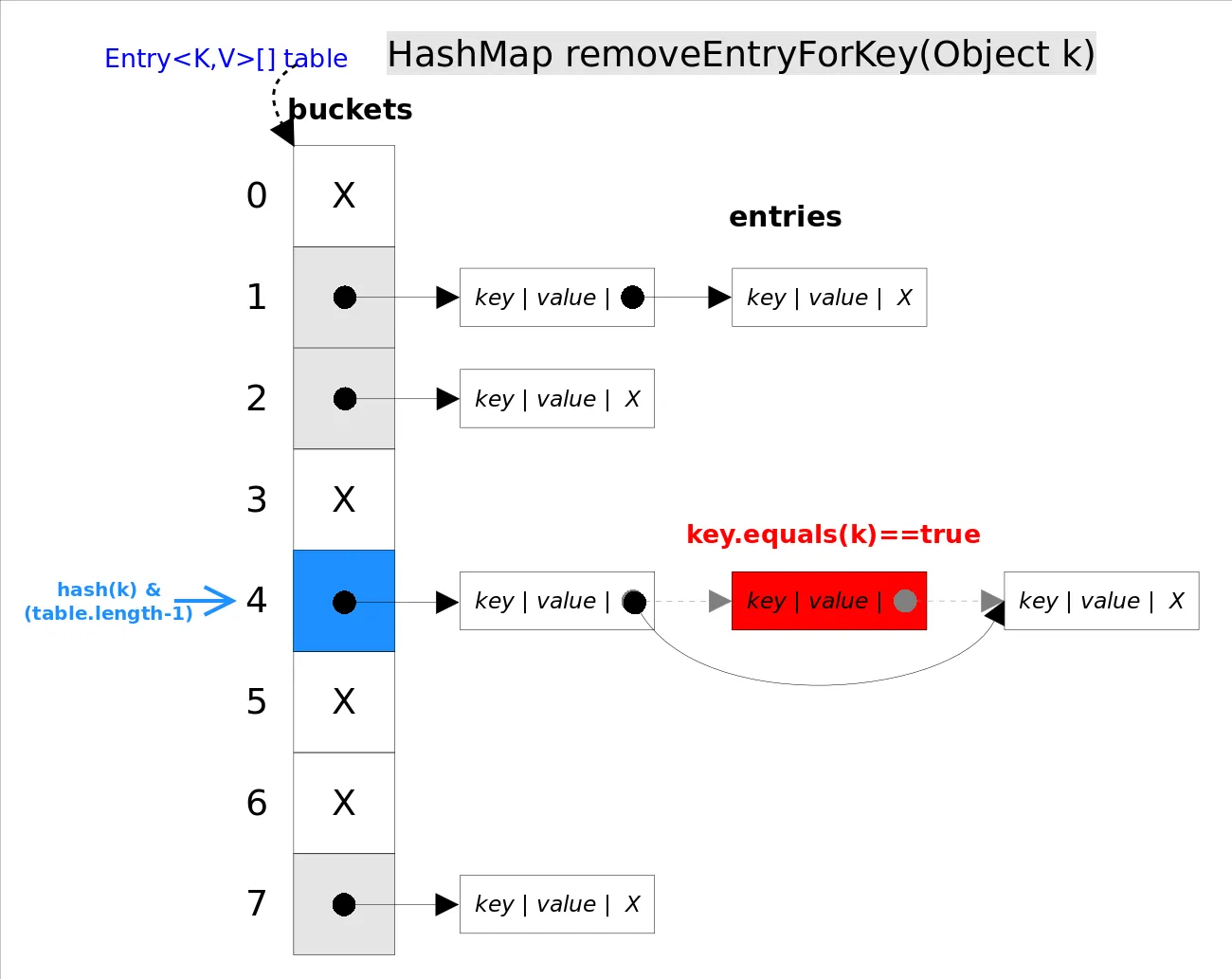

remove()

remove(Object key)的作用是删除 key值对应的 entry,该方法的具体逻辑是在 removeEntryForKey(Object key)里实现的。removeEntryForKey()方法会首先找到 key值对应的 entry,然后删除该 entry(修改链表的相应引用)。查找过程跟 getEntry()过程类似。

//removeEntryForKey()

final Entry<K,V> removeEntryForKey(Object key) {

......

int hash = (key == null) ? 0 : hash(key);

int i = indexFor(hash, table.length);//hash&(table.length-1)

Entry<K,V> prev = table[i];//得到冲突链表

Entry<K,V> e = prev;

while (e != null) {//遍历冲突链表

Entry<K,V> next = e.next;

Object k;

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k)))) {//找到要删除的entry

modCount++; size--;

if (prev == e) table[i] = next;//删除的是冲突链表的第一个entry

else prev.next = next;

return e;

}

prev = e; e = next;

}

return e;

}

Unsafe类在硬件层面的实现?

不妨再看看Unsafe的compareAndSwap*方法来实现CAS操作,它是一个本地方法,实现位于unsafe.cpp中。

UNSAFE_ENTRY(jboolean, Unsafe_CompareAndSwapInt(JNIEnv *env, jobject unsafe, jobject obj, jlong offset, jint e, jint x))

UnsafeWrapper("Unsafe_CompareAndSwapInt");

oop p = JNIHandles::resolve(obj);

jint* addr = (jint *) index_oop_from_field_offset_long(p, offset);

return (jint)(Atomic::cmpxchg(x, addr, e)) == e;

UNSAFE_END

可以看到它通过 Atomic::cmpxchg 来实现比较和替换操作。其中参数x是即将更新的值,参数e是原内存的值。

如果是Linux的x86,Atomic::cmpxchg方法的实现如下:

inline jint Atomic::cmpxchg (jint exchange_value, volatile jint* dest, jint compare_value) {

int mp = os::is_MP();

__asm__ volatile (LOCK_IF_MP(%4) "cmpxchgl %1,(%3)"

: "=a" (exchange_value)

: "r" (exchange_value), "a" (compare_value), "r" (dest), "r" (mp)

: "cc", "memory");

return exchange_value;

}

而windows的x86的实现如下:

inline jint Atomic::cmpxchg (jint exchange_value, volatile jint* dest, jint compare_value) {

int mp = os::isMP(); //判断是否是多处理器

_asm {

mov edx, dest

mov ecx, exchange_value

mov eax, compare_value

LOCK_IF_MP(mp)

cmpxchg dword ptr [edx], ecx

}

}

// Adding a lock prefix to an instruction on MP machine

// VC++ doesn't like the lock prefix to be on a single line

// so we can't insert a label after the lock prefix.

// By emitting a lock prefix, we can define a label after it.

#define LOCK_IF_MP(mp) __asm cmp mp, 0 \

__asm je L0 \

__asm _emit 0xF0 \

__asm L0:

如果是多处理器,为cmpxchg指令添加lock前缀。反之,就省略lock前缀(单处理器会不需要lock前缀提供的内存屏障效果)。这里的lock前缀就是使用了处理器的总线锁(最新的处理器都使用缓存锁代替总线锁来提高性能)。

cmpxchg(void* ptr, int old, int new),如果ptr和old的值一样,则把new写到ptr内存,否则返回ptr的值,整个操作是原子的。在Intel平台下,会用lock cmpxchg来实现,使用lock触发缓存锁,这样另一个线程想访问ptr的内存,就会被block住。

🍃常用框架

Spring

对 spring 和 springboot 的理解

spring

我们一般说 Spring 框架指的都是 Spring Framework,它是很多模块的集合,使用这些模块可以很方便地协助我们进行开发。

比如说 Spring 自带 IoC(Inverse of Control:控制反转) 和 AOP(Aspect-Oriented Programming:面向切面编程)、可以很方便地对数据库进行访问、可以很方便地集成第三方组件(电子邮件,任务,调度,缓存等等)、对单元测试支持比较好、支持 RESTful Java 应用程序的开发。

Spring 最核心的思想就是不重新造轮子,开箱即用!

Spring 提供的核心功能主要是 IoC 和 AOP。学习 Spring ,一定要把 IoC 和 AOP 的核心思想搞懂!

springboot

Spring Boot 只是简化了配置,如果你需要构建 MVC 架构的 Web 程序,你还是需要使用 Spring MVC 作为 MVC 框架,只是说 Spring Boot 帮你简化了 Spring MVC 的很多配置,真正做到开箱即用!

springboot 是怎么加载 redis 的

个人觉得这个问题应该从starter出发 -》 自动装配原理

加载的 redis 或者 bean 是单例还是多例

默认单例

springboot 是怎么实现单例模式的呢?

在我们的系统中,有一些对象其实我们只需要一个,比如说:线程池、缓存、对话框、注册表、日志对象、充当打印机、显卡等设备驱动程序的对象。事实上,这一类对象只能有一个实例,如果制造出多个实例就可能会导致一些问题的产生,比如:程序的行为异常、资源使用过量、或者不一致性的结果。

使用单例模式的好处:

- 对于频繁使用的对象,可以省略创建对象所花费的时间,这对于那些重量级对象而言,是非常可观的一笔系统开销;

- 由于 new 操作的次数减少,因而对系统内存的使用频率也会降低,这将减轻 GC 压力,缩短 GC 停顿时间。

Spring 中 bean 的默认作用域就是 singleton(单例)的。 除了 singleton 作用域,Spring 中 bean 还有下面几种作用域:

- prototype : 每次请求都会创建一个新的 bean 实例。

- request : 每一次HTTP请求都会产生一个新的bean,该bean仅在当前HTTP request内有效。

- session : 每一次HTTP请求都会产生一个新的 bean,该bean仅在当前 HTTP session 内有效。

- global-session: 全局session作用域,仅仅在基于portlet的web应用中才有意义,Spring5已经没有了。Portlet是能够生成语义代码(例如:HTML)片段的小型Java Web插件。它们基于portlet容器,可以像servlet一样处理HTTP请求。但是,与 servlet 不同,每个 portlet 都有不同的会话

Spring 实现单例的方式:

- xml:

<bean id="userService" class="top.snailclimb.UserService" scope="singleton"/> - 注解:

@Scope(value = "singleton")

Spring 通过 ConcurrentHashMap 实现单例注册表的特殊方式实现单例模式。Spring 实现单例的核心代码如下:

// 通过 ConcurrentHashMap(线程安全) 实现单例注册表

private final Map<String, Object> singletonObjects = new ConcurrentHashMap<String, Object>(64);

public Object getSingleton(String beanName, ObjectFactory<?> singletonFactory) {

Assert.notNull(beanName, "'beanName' must not be null");

synchronized (this.singletonObjects) {

// 检查缓存中是否存在实例

Object singletonObject = this.singletonObjects.get(beanName);

if (singletonObject == null) {

//...省略了很多代码

try {

singletonObject = singletonFactory.getObject();

}

//...省略了很多代码

// 如果实例对象在不存在,我们注册到单例注册表中。

addSingleton(beanName, singletonObject);

}

return (singletonObject != NULL_OBJECT ? singletonObject : null);

}

}

//将对象添加到单例注册表

protected void addSingleton(String beanName, Object singletonObject) {

synchronized (this.singletonObjects) {

this.singletonObjects.put(beanName, (singletonObject != null ? singletonObject : NULL_OBJECT));

}

}

}

Spring bean 启动流程和生命周期

长字版本启动流程:https://mp.weixin.qq.com/s/ut3mRwhfqXNjrBtTmI0oWg

1、实例化一个Bean--也就是我们常说的new;

2、按照Spring上下文对实例化的Bean进行配置--也就是IOC注入;

3、如果这个Bean已经实现了BeanNameAware接口,会调用它实现的setBeanName(String)方法,此处传递的就是Spring配置文件中Bean的id值

4、如果这个Bean已经实现了BeanFactoryAware接口,会调用它实现的setBeanFactory(setBeanFactory(BeanFactory)传递的是Spring工厂自身(可以用这个方式来获取其它Bean,只需在Spring配置文件中配置一个普通的Bean就可以);

5、如果这个Bean已经实现了ApplicationContextAware接口,会调用setApplicationContext(ApplicationContext)方法,传入Spring上下文(同样这个方式也可以实现步骤4的内容,但比4更好,因为ApplicationContext是BeanFactory的子接口,有更多的实现方法);

6、如果这个Bean关联了BeanPostProcessor接口,将会调用postProcessBeforeInitialization(Object obj, String s)方法,BeanPostProcessor经常被用作是Bean内容的更改,并且由于这个是在Bean初始化结束时调用那个的方法,也可以被应用于内存或缓存技术;

7、如果Bean在Spring配置文件中配置了init-method属性会自动调用其配置的初始化方法。

8、如果这个Bean关联了BeanPostProcessor接口,将会调用postProcessAfterInitialization(Object obj, String s)方法、;

注:以上工作完成以后就可以应用这个Bean了,那这个Bean是一个Singleton的,所以一般情况下我们调用同一个id的Bean会是在内容地址相同的实例,当然在Spring配置文件中也可以配置非Singleton,这里我们不做赘述。

9、当Bean不再需要时,会经过清理阶段,如果Bean实现了DisposableBean这个接口,会调用那个其实现的destroy()方法;

10、最后,如果这个Bean的Spring配置中配置了destroy-method属性,会自动调用其配置的销毁方法。

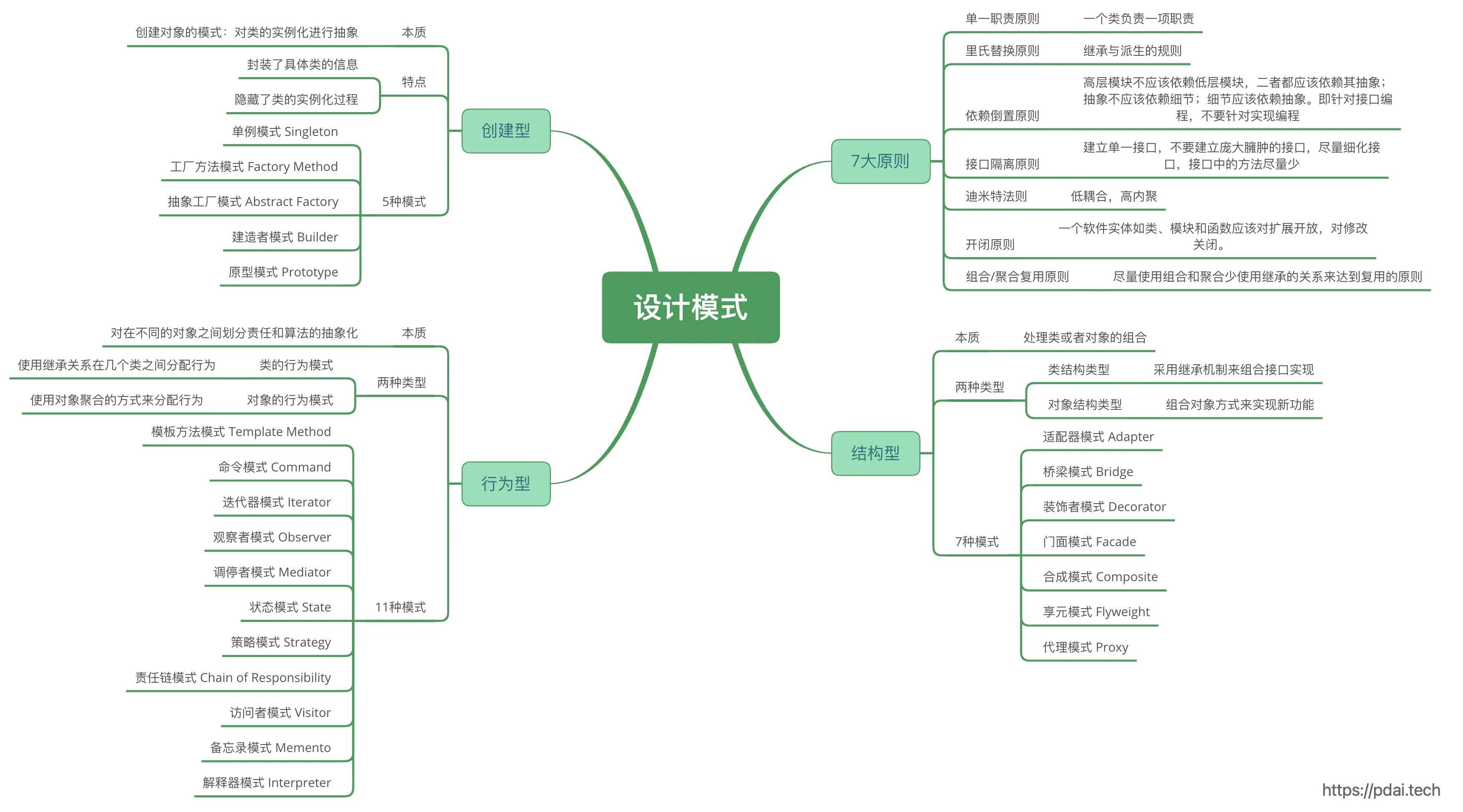

Spring设计模式(美团)

具体可以参考:面试官:“谈谈Spring中都用到了那些设计模式?”

工厂设计模式 : Spring 使用工厂模式通过 BeanFactory、ApplicationContext 创建 bean 对象。

代理设计模式 : Spring AOP 功能的实现。

单例设计模式 : Spring 中的 Bean 默认都是单例的。

模板方法模式 : Spring 中 jdbcTemplate、hibernateTemplate 等以 Template 结尾的对数据库操作的类,它们就使用到了模板模式。

包装器设计模式 : 我们的项目需要连接多个数据库,而且不同的客户在每次访问中根据需要会去访问不同的数据库。这种模式让我们可以根据客户的需求能够动态切换不同的数据源。

观察者模式: Spring 事件驱动模型就是观察者模式很经典的一个应用。

适配器模式 : Spring AOP 的增强或通知(Advice)使用到了适配器模式、spring MVC 中也是用到了适配器模式适配 Controller。****

Spring常用注解

@Value:属性赋值

@Component:与业务层、dao层、控制层不相关的类需要在spring容器中创建使用

@Repository:dao层对象的创建

@Service:业务层层对象的创建

@Controller:控制层对象的创建

@Autowired:引用类型赋值,支持byName。默认是byType

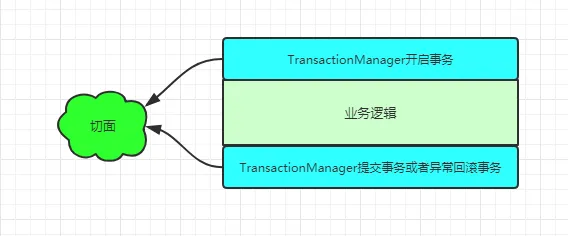

Spring声明式事务原理?哪些场景事务会失效?(OPPO)

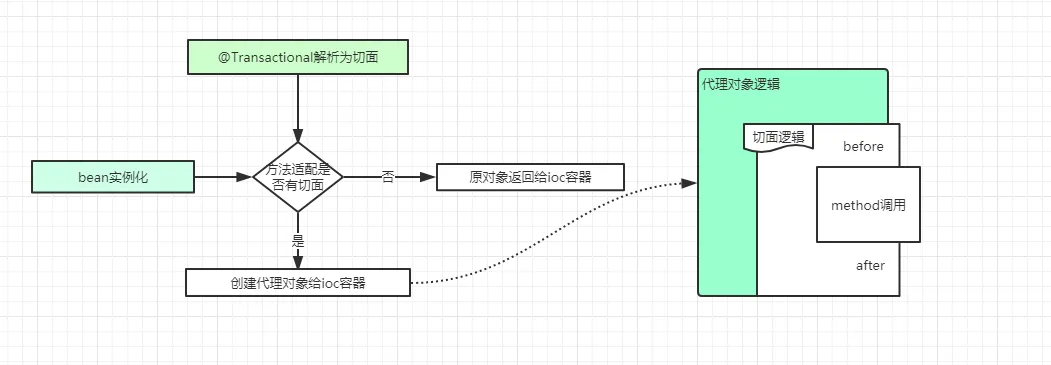

声明式事务原理

spring声明式事务,即 @Transactional,它可以帮助我们把事务开启、提交或者回滚的操作,通过Aop的方式进行管理。

在spring的bean的初始化过程中,就需要对实例化的bean进行代理,并且生成代理对象。生成代理对象的代理逻辑中,进行方法调用时,需要先获取切面逻辑,@Transactional注解的切面逻辑类似于@Around,在spring中是实现一种类似代理逻辑。

spring声明式事务哪些场景会失效

- 方法的访问权限必须是public,其他private等权限,事务失效

- 方法被定义成了final的,这样会导致事务失效。

- 在同一个类中的方法直接内部调用,会导致事务失效。

- 一个方法如果没交给spring管理,就不会生成spring事务。

- 多线程调用,两个方法不在同一个线程中,获取到的数据库连接不一样的。

- 表的存储引擎不支持事务

- 如果自己try...catch误吞了异常,事务失效。

- 错误的传播

Spring Boot

接口幂等是如何保证的

什么是幂等?

幂等原先是数学中的一个概念,表示进行1次变换和进行N次变换产生的效果相同。

当我们讨论接口的幂等性时一般是在说:以相同的请求调用这个接口一次和调用这个接口多次,对系统产生的影响是相同的。如果一个接口满足这个特性,那么我们就说这个 接口是一个幂等接口。

- 接口幂等和防止重复提交是一回事吗?

严格来说,并不是。

- 幂等: 更多的是在重复请求已经发生,或是无法避免的情况下,采取一定的技术手段让这些重复请求不给系统带来副作用。

- 防止重复: 提交更多的是不让用户发起多次一样的请求。比如说用户在线购物下单时点了提交订单按钮,但是由于网络原因响应很慢,此时用户比较心急多次点击了订单提交按钮。 这种情况下就可能会造成多次下单。一般防止重复提交的方案有:将订单按钮置灰,跳转到结果页等。主要还是从客户端的角度来解决这个问题。

- 哪些情况下客户端是防止不了重复提交的?

虽然我们可在客户端做一些防止接口重复提交的事(比如将订单按钮置灰,跳转到结果页等), 但是如下情况依然客户端是很难控制接口重复提交到后台的,这也进一步表明了接口幂等和防止重复提交不是一回事以及后端接口保证接口幂等的必要性所在。

- 接口超时重试:接口可能会因为某些原因而调用失败,出于容错性考虑会加上失败重试的机制。如果接口调用一半,再次调用就会因为脏数据的存在而出现异常。

- 消息重复消费:在使用消息中间件来处理消息队列,且手动ack确认消息被正常消费时。如果消费者突然断开连接,那么已经执行了一半的消息会重新放回队列。被其他消费者重新消费时就会导致结果异常,如数据库重复数据,数据库数据冲突,资源重复等。

- 请求重发:网络抖动引发的nginx重发请求,造成重复调用;

什么是幂等接口?

在HTTP/1.1中,对幂等性进行了定义。它描述了一次和多次请求某一个资源对于资源本身应该具有同样的结果(网络超时等问题除外),即第一次请求的时候对资源产生了副作用,但是以后的多次请求都不会再对资源产生副作用。

这里的副作用是不会对结果产生破坏或者产生不可预料的结果。也就是说,其任意多次执行对资源本身所产生的影响均与一次执行的影响相同。

- 对哪些类型的接口需要保证接口幂等?

我们看下标准的restful请求,幂等情况是怎么样的:

- SELECT查询操作

- GET:只是获取资源,对资源本身没有任何副作用,天然的幂等性。

- HEAD:本质上和GET一样,获取头信息,主要是探活的作用,具有幂等性。

- OPTIONS:获取当前URL所支持的方法,因此也是具有幂等性的。

- DELETE删除操作

- 删除的操作,如果从删除的一次和删除多次的角度看,数据并不会变化,这个角度看它是幂等的

- 但是如果,从另外一个角度,删除数据一般是返回受影响的行数,删除一次和多次删除返回的受影响行数是不一样的,所以从这个角度它需要保证幂等。(折中而言DELETE操作通常也会被纳入保证接口幂等的要求)

- ADD/EDIT操作

- PUT:用于更新资源,有副作用,但是它应该满足幂等性,比如根据id更新数据,调用多次和N次的作用是相同的(根据业务需求而变)。

- POST:用于添加资源,多次提交很可能产生副作用,比如订单提交,多次提交很可能产生多笔订单。

常见的保证幂等的方式

如果你调用下游接口超时了,是不是考虑重试?如果重试,下游接口就需要支持幂等啦。

实现幂等一般有这8种方案:

- select+insert+主键/唯一索引冲突

- 直接insert + 主键/唯一索引冲突

- 状态机幂等

- 抽取防重表

- token令牌

- 悲观锁(如select for update,很少用)

- 典型的数据库悲观锁:for update

- 乐观锁

- 针对更新操作。

- 分布式锁

- 分布式锁实现幂等性的逻辑是,在每次执行方法之前判断,是否可以获取到分布式锁,如果可以,则表示为第一次执行方法,否则直接舍弃请求即可

Netty

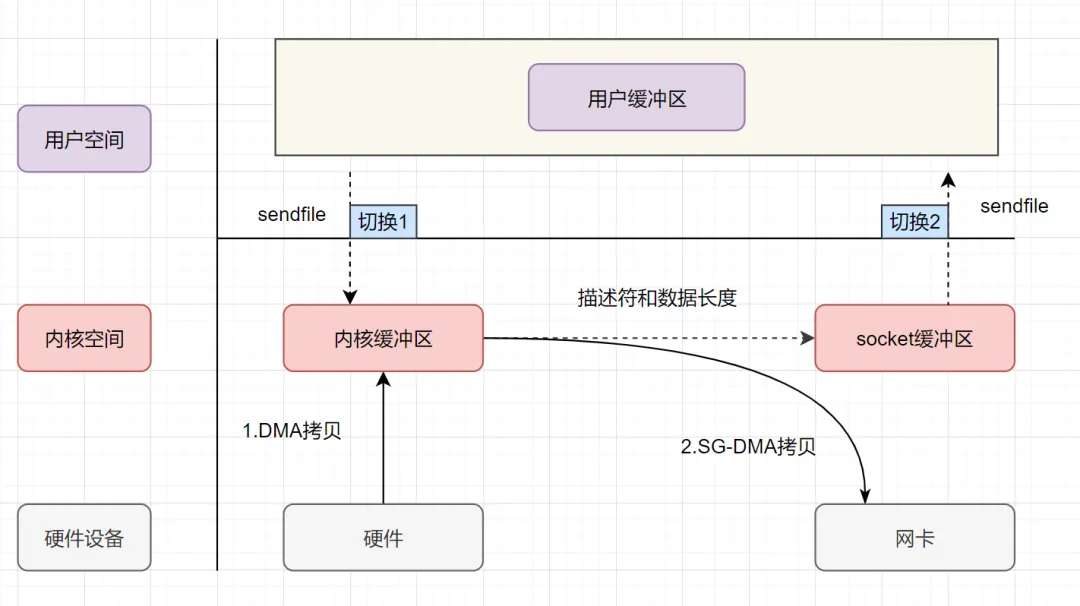

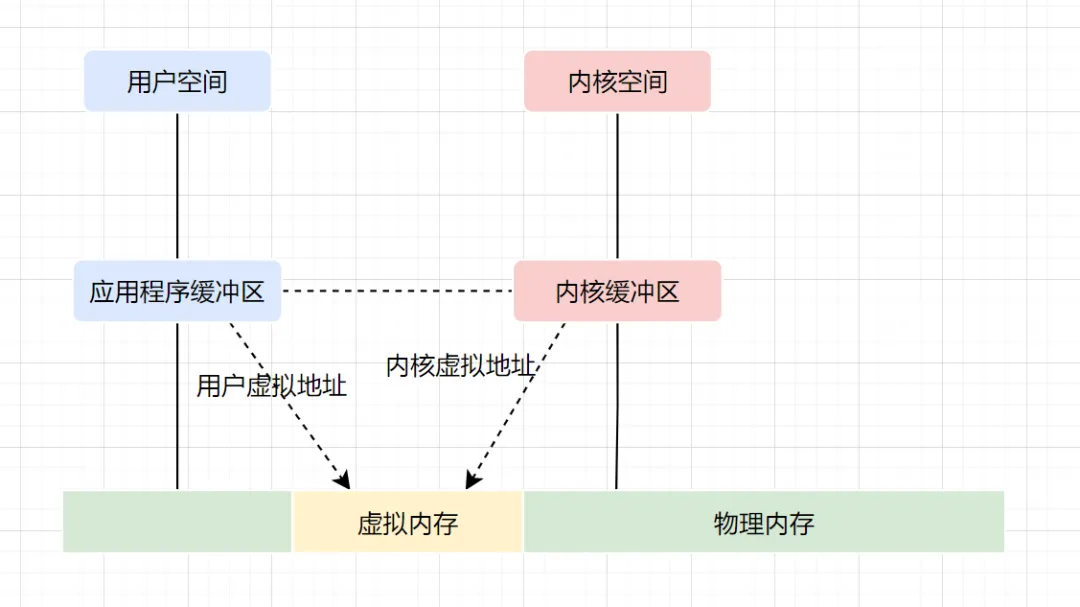

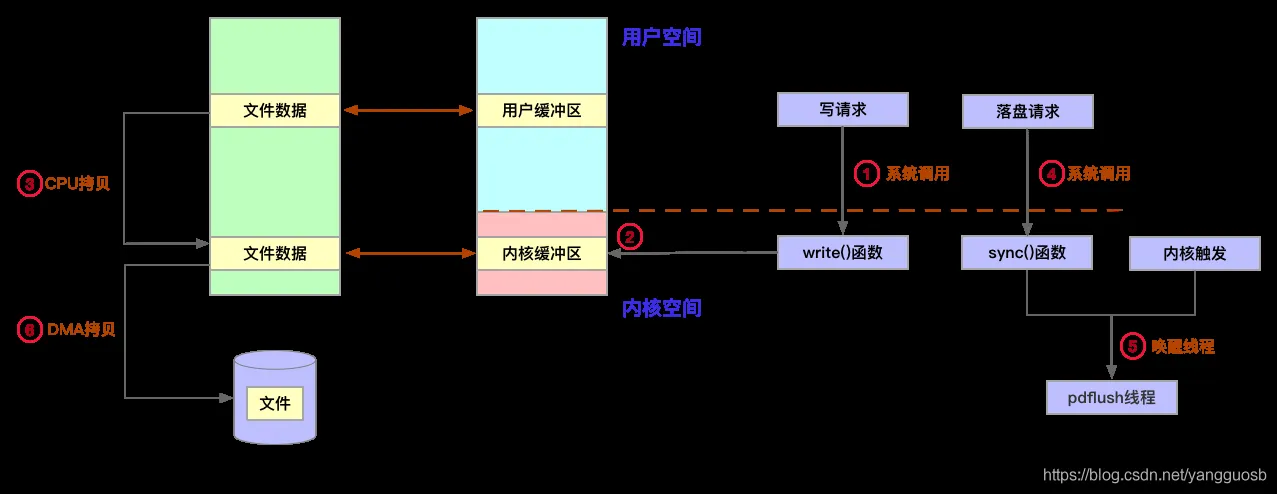

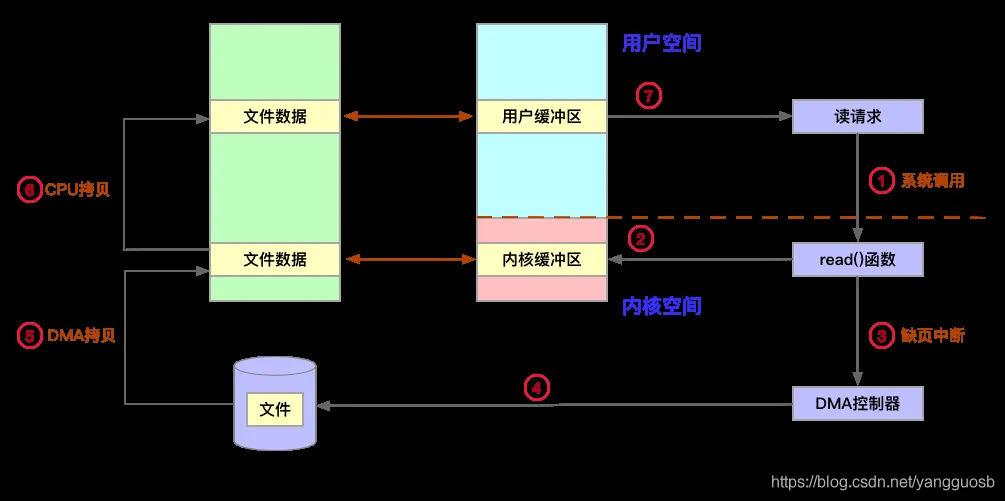

讲讲你理解的Netty 的零拷贝,有什么优点?

零复制(英语:Zero-copy;也译零拷贝)技术是指计算机执行操作时,CPU 不需要先将数据从某处内存复制到另一个特定区域。这种技术通常用于通过网络传输文件时节省 CPU 周期和内存带宽。

在 OS 层面上的 Zero-copy 通常指避免在 用户态(User-space) 与 内核态(Kernel-space) 之间来回拷贝数据。而在 Netty 层面 ,零拷贝主要体现在对于数据操作的优化。

Netty 中的零拷贝体现在以下几个方面:

- 使用 Netty 提供的

CompositeByteBuf类, 可以将多个ByteBuf合并为一个逻辑上的ByteBuf, 避免了各个ByteBuf之间的拷贝。 ByteBuf支持 slice 操作, 因此可以将 ByteBuf 分解为多个共享同一个存储区域的ByteBuf, 避免了内存的拷贝。- 通过

FileRegion包装的FileChannel.tranferTo实现文件传输, 可以直接将文件缓冲区的数据发送到目标Channel, 避免了传统通过循环 write 方式导致的内存拷贝问题。 - 在将一个byte数组转换为一个ByteBuf对象的场景下,Netty提供了一系列的包装类,避免了转换过程中的内存拷贝。

- 如果通道接收和发送ByteBuf都使用直接内存进行Socket读写,就不需要进行缓冲区的二次拷贝。如果使用JVM的堆内存进行Socket读写,那么JVM会先将堆内存Buffer拷贝一份到直接内存再写入Socket中,相比于使用直接内存,这种情况在发送过程中会多出一次缓冲区的内存拷贝。所以,在发送ByteBuffer到Socket时,尽量使用直接内存而不是JVM堆内存

讲讲Reactor线程模型,netty是基于Reactor的哪种模式?

Reactor是一种并发处理客户端请求响应的事件驱动模型。服务端在接收到客户端请求后采用多路复用策略,通过一个非阻塞的线程来异步接收所有的客户端请求,并将这些请求转发到相关的工作线程组上进行处理。Reactor模型常常基于异步线程的方式实现,常用的Reactor线程模型有3种:Reactor单线程模型、Reactor多线程模型和Reactor主从多线程模型

Reactor模式由Reactor线程、Handlers处理器两大角色组成,两大角色的职责分别如下:

(1)Reactor线程的职责:负责响应IO事件,并且分发到Handlers处理器。

(2)Handlers处理器的职责:非阻塞的执行业务处理逻辑。

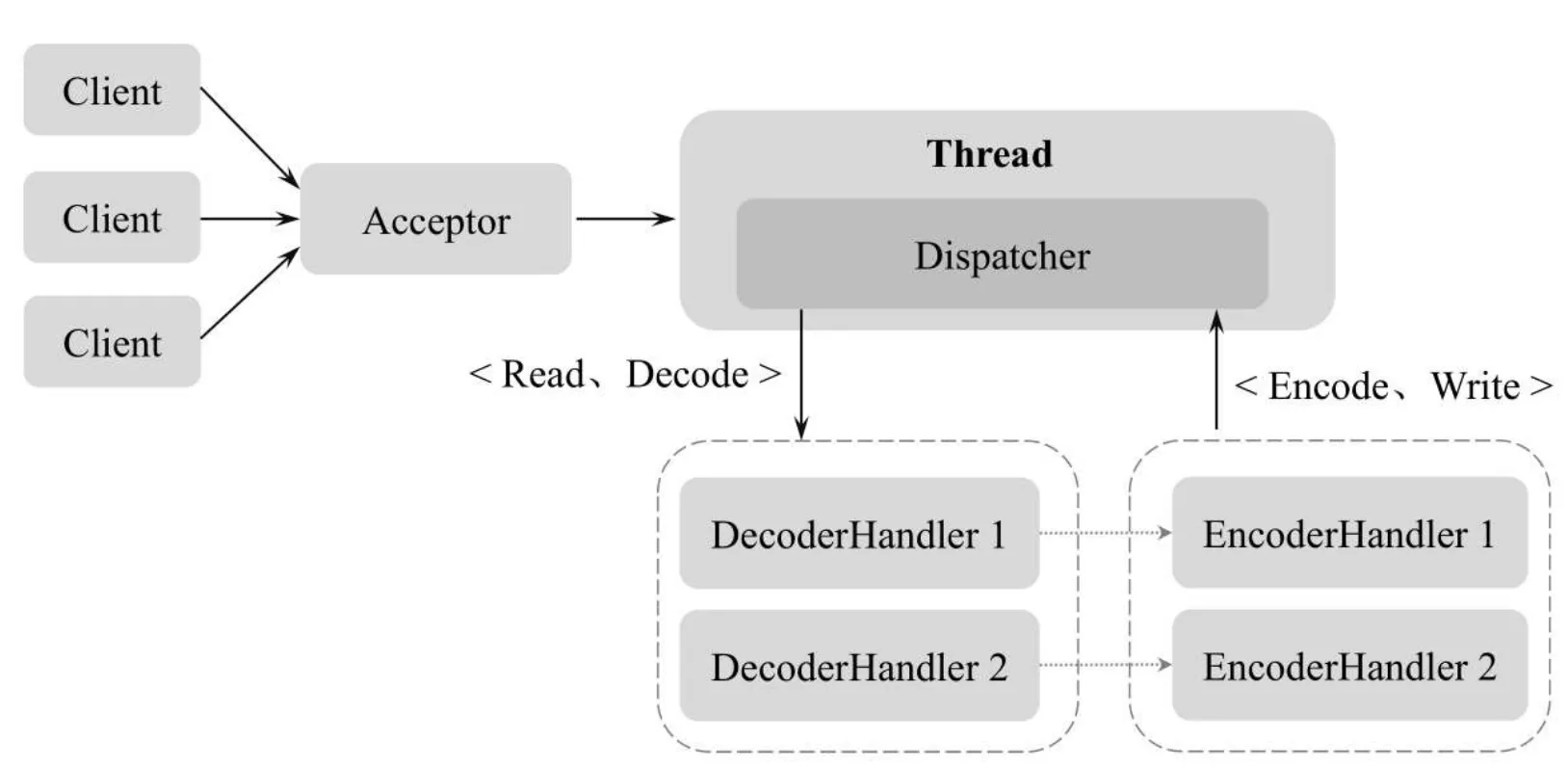

1.单线程模型 :

总体来说,Reactor模式有点类似事件驱动模式。在事件驱动模式中,当有事件触发时,事件源会将事件分发到Handler(处理器),由Handler负责事件处理。Reactor模式中的反应器角色类似于事件驱动模式中的事件分发器(Dispatcher)角色。

具体来说,在Reactor模式中有Reactor和Handler两个重要的组件:

(1)Reactor:负责查询IO事件,当检测到一个IO事件时将其发送给相应的Handler处理器去处理。这里的IO事件就是NIO中选择器查询出来的通道IO事件。

(2)Handler:与IO事件(或者选择键)绑定,负责IO事件的处理,完成真正的连接建立、通道的读取、处理业务逻辑、负责将结果写到通道等。

什么是单线程版本的Reactor模式呢?简单地说,Reactor和Handlers处于一个线程中执行。这是最简单的Reactor模型(图片来自《offer来了》)

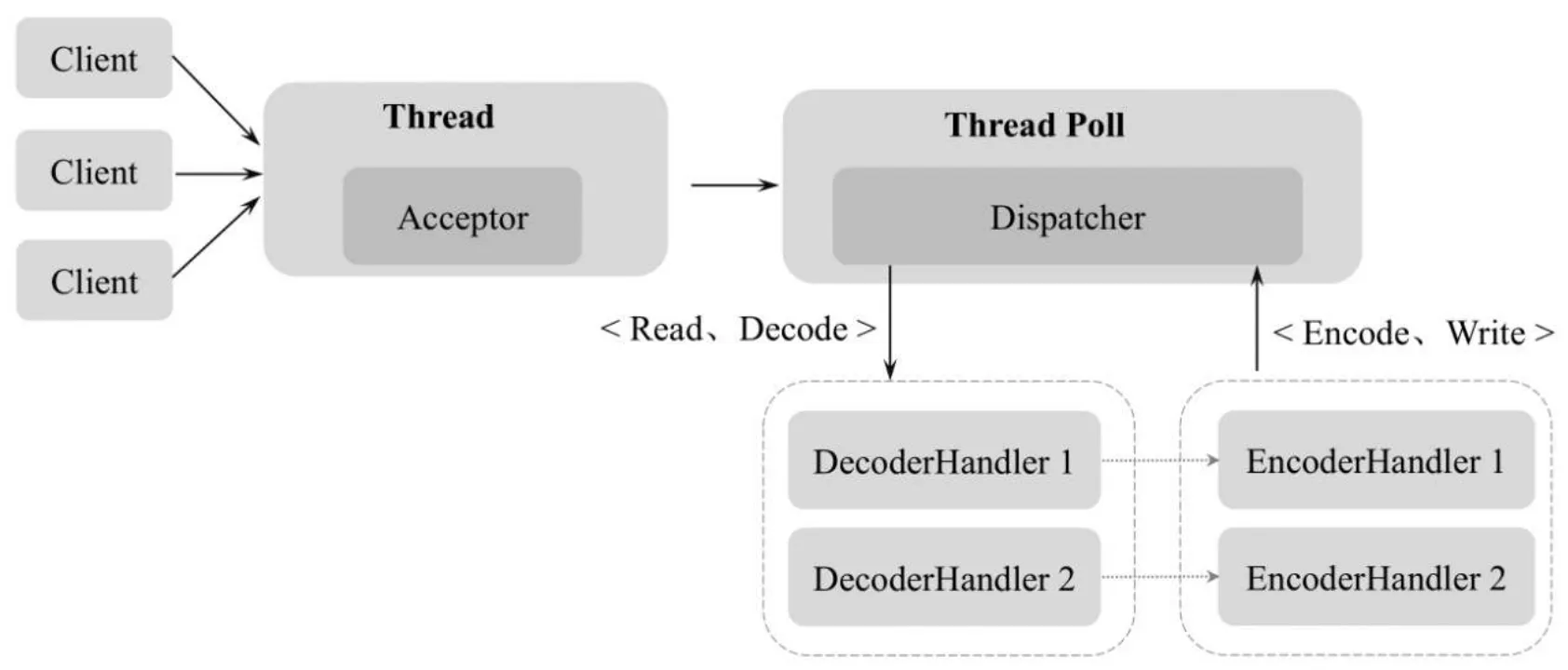

2.多线程模型

Reactor和Handler挤在单个线程中会造成非常严重的性能缺陷,可以使用多线程来对基础的Reactor模式进行改造和演进

多线程Reactor的演进分为两个方面:

(1)升级Handler。既要使用多线程,又要尽可能高效率,则可以考虑使用线程池。

(2)升级Reactor。可以考虑引入多个Selector(选择器),提升选择大量通道的能力。

总体来说,多线程版本的Reactor模式大致如下:

(1)将负责数据传输处理的IOHandler处理器的执行放入独立的线程池中。这样,业务处理线程与负责新连接监听的反应器线程就能相互隔离,避免服务器的连接监听受到阻塞。

(2)如果服务器为多核的CPU,可以将反应器线程拆分为多个子反应器(SubReactor)线程;同时,引入多个选择器,并且为每一个SubReactor引入一个线程,一个线程负责一个选择器的事件轮询。这样充分释放了系统资源的能力,也大大提升了反应器管理大量连接或者监听大量传输通道的能力

Reactor多线程模型与单线程模型最大的区别就是由一组线程(Thread Poll)处理客户端的I/O请求操作。Reactor多线程模型将Acceptor的操作封装在一组线程池中,采用线程池的方式监听服务端端口、接收客户端的TCP连接请求、处理网络I/O读写等操作。线程池一般使用标准的JDK线程池,在该线程池中包含一个任务队列和一系列NIO线程,这些NIO线程负责具体的消息读取、解码、编码和发送。Reactor多线程模型如图(图片来自《offer来了》)

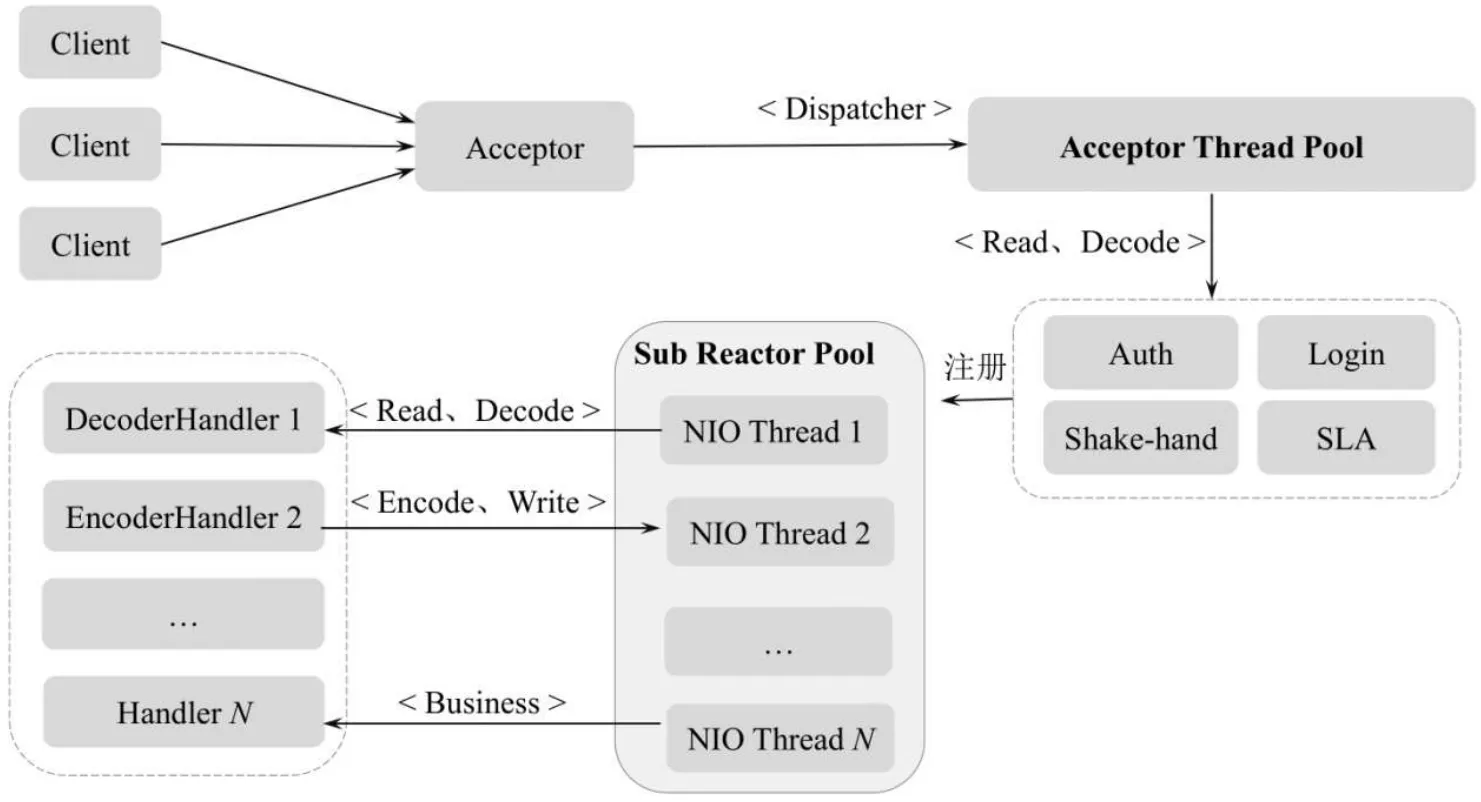

3.主从多线程模型 [netty使用的方式]

在Reactor主从多线程模型中,服务端用于接收客户端连接的不再是一个NIO线程,而是一个独立的NIO线程池。主线程Acceptor在接收到客户端的TCP连接请求并建立完成连接后(可能要经过鉴权、登录等过程),将新创建的SocketChannel注册到子I/O线程池(Sub Reactor Pool)的某个I/O线程上,由它负责具体的SocketChannel的读写和编解码工作。Reactor主从多线程模型中的Acceptor线程池(Acceptor Thread Pool)只用于客户端的鉴权、登录、握手和安全认证,一旦链路建立成功,就将链路注册到后端Sub Reactor线程池的I/O线程上,由I/O线程负责后续的I/O操作。这样就将客户端连接的建立和消息的响应都以异步线程的方式来实现,大大提高了系统的吞吐量。Reactor主从多线程模型如图(图片来自《offer来了》)

了解NIO 的epoll bug吗?谈谈epoll bug的危害 (滴滴)

epoll是Linux下一种高效的IO复用方式,相较于select和poll机制来说。其高效的原因是将基于事件的fd放到内核中来完成,在内核中基于红黑树+链表数据结构来实现,链表存放有事件发生的fd集合,然后在调用epoll_wait时返回给应用程序,由应用程序来处理这些fd事件。

使用IO多路复用,Linux下一般默认就是epoll,Java NIO在Linux下默认也是epoll机制,但是JDK中epoll的实现却是有漏洞的。其中一个就是Epoll的空轮询Bug, 就是即使是关注的select轮询事件返回数量为0,NIO照样不断的从select本应该阻塞的Selector.select()/Selector.select(timeout)中wake up出来,导致CPU飙到100%问题。

官方给的Bug复现方法:

A DESCRIPTION OF THE PROBLEM : The NIO selector wakes up infinitely in this situation.. 0. server waits for connection、

- client connects and write message

- server accepts and register OP_READ

- server reads message and remove OP_READ from interest op set

- client close the connection

- server write message (without any reading.. surely OP_READ is not set)

- server’s select wakes up infinitely with return value 0

产生这一Bug的原因:

因为poll和epoll对于突然中断的连接socket会对返回的eventSet事件集合置为EPOLLHUP或者EPOLLERR,eventSet事件集合发生了变化,这就导致Selector会被唤醒,如果仅仅是因为这个原因唤醒且没有感兴趣的时间发生的话,就会变成空轮询。

简而言之:若Selector的轮询结果为空,也没有wakeup或新消息处理,则发生空轮询,CPU使用率100%

Netty的解决办法

- 对Selector的select操作周期进行统计,每完成一次空的select操作进行一次计数,

- 若在某个周期内连续发生N次空轮询,则触发了epoll死循环bug。

- 重建Selector,判断是否是其他线程发起的重建请求,若不是则将原SocketChannel从旧的Selector上去除注册,重新注册到新的Selector上,并将原来的Selector关闭。

🤹♂️微服务、分布式

分布式事务了解吗?

事务是一个程序执行单元,里面的所有操作要么全部执行成功,要么全部执行失败。在分布式系统中,这些操作可能是位于不同的服务中,那么如果也能保证这些操作要么全部执行成功要么全部执行失败呢?这便是分布式事务要解决的问题。

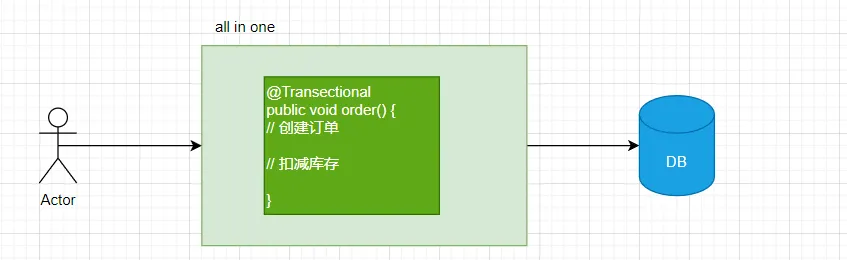

以一个网上的经典下单减库存例子为例:

单体应用所有的业务都使用一个数据库,整个下单流程或许只用在一个方法里同一个事务下操作数据库即可。此时所有操作都在一个事务里,要么全部提交,要么全部回滚。

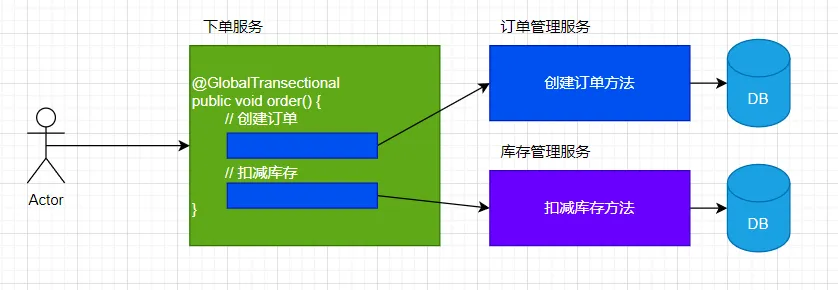

但随着业务量不断增长,业务服务化拆分,就会分离出订单中心、库存中心等。而这样就造成业务间相互隔离,每个业务都维护着自己的数据库,数据的交换只能进行服务调用。

用户再下单时,创建订单和扣减库存,需要同时对订单DB和库存DB进行操作。两步操作必须同时成功,否则就会造成业务混乱,可此时我们只能保证自己服务的数据一致性,无法保证调用其他服务的操作是否成功,所以为了保证整个下单流程的数据一致性,就需要分布式事务介入。

具体理解可以看:https://www.pdai.tech/md/arch/arch-z-transection.html#什么是分布式事务

以及后续可能会问到:说一下怎么实现的分布式事务?还有没有其他的解决方案?RocketMQ 能做分布式事务吗?

rpc了解吗

何为 RPC?

RPC(Remote Procedure Call) 即远程过程调用,通过名字我们就能看出 RPC 关注的是远程调用而非本地调用。

为什么要 RPC ? 因为,两个不同的服务器上的服务提供的方法不在一个内存空间,所以,需要通过网络编程才能传递方法调用所需要的参数。并且,方法调用的结果也需要通过网络编程来接收。但是,如果我们自己手动网络编程来实现这个调用过程的话工作量是非常大的,因为,我们需要考虑底层传输方式(TCP还是UDP)、序列化方式等等方面。

RPC 能帮助我们做什么呢? 简单来说,通过 RPC 可以帮助我们调用远程计算机上某个服务的方法,这个过程就像调用本地方法一样简单。并且!我们不需要了解底层网络编程的具体细节。

举个例子:两个不同的服务 A、B 部署在两台不同的机器上,服务 A 如果想要调用服务 B 中的某个方法的话就可以通过 RPC 来做。

一言蔽之:RPC 的出现就是为了让你调用远程方法像调用本地方法一样简单。

RPC 的原理是什么?

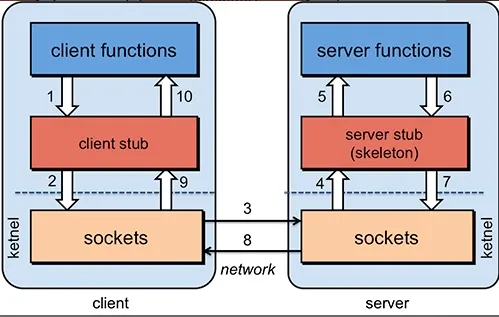

为了能够帮助小伙伴们理解 RPC 原理,我们可以将整个 RPC的 核心功能看作是下面👇 6 个部分实现的:

- 客户端(服务消费端) :调用远程方法的一端。

- 客户端 Stub(桩) : 这其实就是一代理类。代理类主要做的事情很简单,就是把你调用方法、类、方法参数等信息传递到服务端。

- 网络传输 : 网络传输就是你要把你调用的方法的信息比如说参数啊这些东西传输到服务端,然后服务端执行完之后再把返回结果通过网络传输给你传输回来。网络传输的实现方式有很多种比如最近基本的 Socket或者性能以及封装更加优秀的 Netty(推荐)。

- 服务端 Stub(桩) :这个桩就不是代理类了。我觉得理解为桩实际不太好,大家注意一下就好。这里的服务端 Stub 实际指的就是接收到客户端执行方法的请求后,去指定对应的方法然后返回结果给客户端的类。

- 服务端(服务提供端) :提供远程方法的一端。

具体原理图如下,后面我会串起来将整个RPC的过程给大家说一下。

- 服务消费端(client)以本地调用的方式调用远程服务;

- 客户端 Stub(client stub) 接收到调用后负责将方法、参数等组装成能够进行网络传输的消息体(序列化):

RpcRequest; - 客户端 Stub(client stub) 找到远程服务的地址,并将消息发送到服务提供端;

- 服务端 Stub(桩)收到消息将消息反序列化为Java对象:

RpcRequest; - 服务端 Stub(桩)根据

RpcRequest中的类、方法、方法参数等信息调用本地的方法; - 服务端 Stub(桩)得到方法执行结果并将组装成能够进行网络传输的消息体:

RpcResponse(序列化)发送至消费方; - 客户端 Stub(client stub)接收到消息并将消息反序列化为Java对象:

RpcResponse,这样也就得到了最终结果。over!

相信小伙伴们看完上面的讲解之后,已经了解了 RPC 的原理。

虽然篇幅不多,但是基本把 RPC 框架的核心原理讲清楚了!另外,对于上面的技术细节,我会在后面的章节介绍到。

最后,对于 RPC 的原理,希望小伙伴不单单要理解,还要能够自己画出来并且能够给别人讲出来。因为,在面试中这个问题在面试官问到 RPC 相关内容的时候基本都会碰到。

RPC如何实现的?如何实现调度的?(2022虾皮)

讲讲微服务

什么是微服务?

- 微服务架构是一个分布式系统,按照业务进行划分成为不同的服务单元,解决单体系统性能等不足。

- 微服务是一种架构风格,一个大型软件应用由多个服务单元组成。系统中的服务单元可以单独部署,各个服务单元之间是松耦合的。

微服务两台机器怎么通信呢? | 微服务之间是怎么联系?

同步通信:dobbo通过 RPC 远程过程调用、springcloud通过 REST 接口json调用 等。

异步:消息队列,如:RabbitMq、ActiveM、Kafka 等。

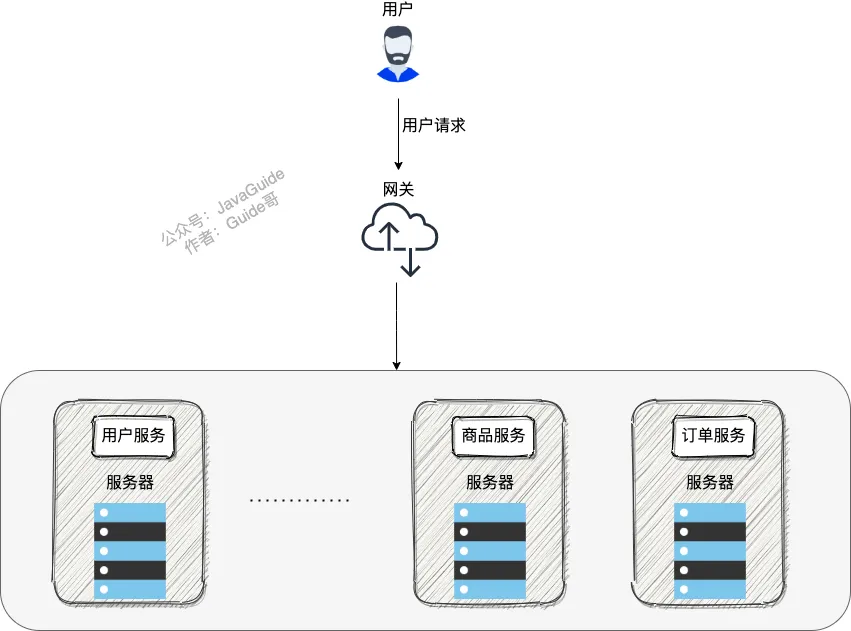

微服务都有什么部分呢

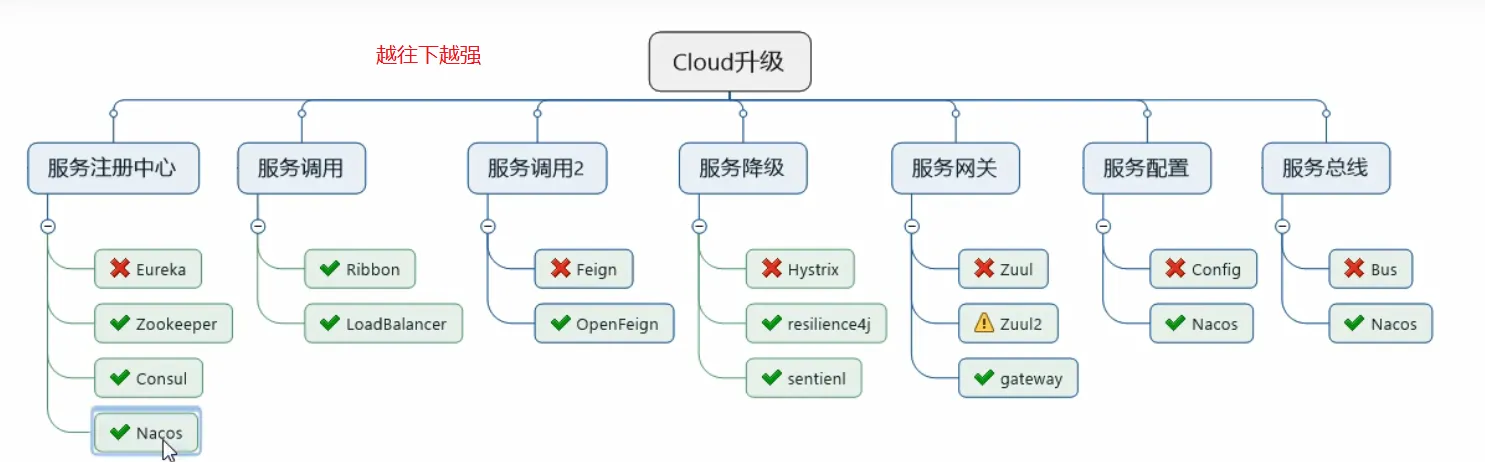

这里调用阳哥PPT的神图

注册中心是什么讲讲

参考:

服务发现:

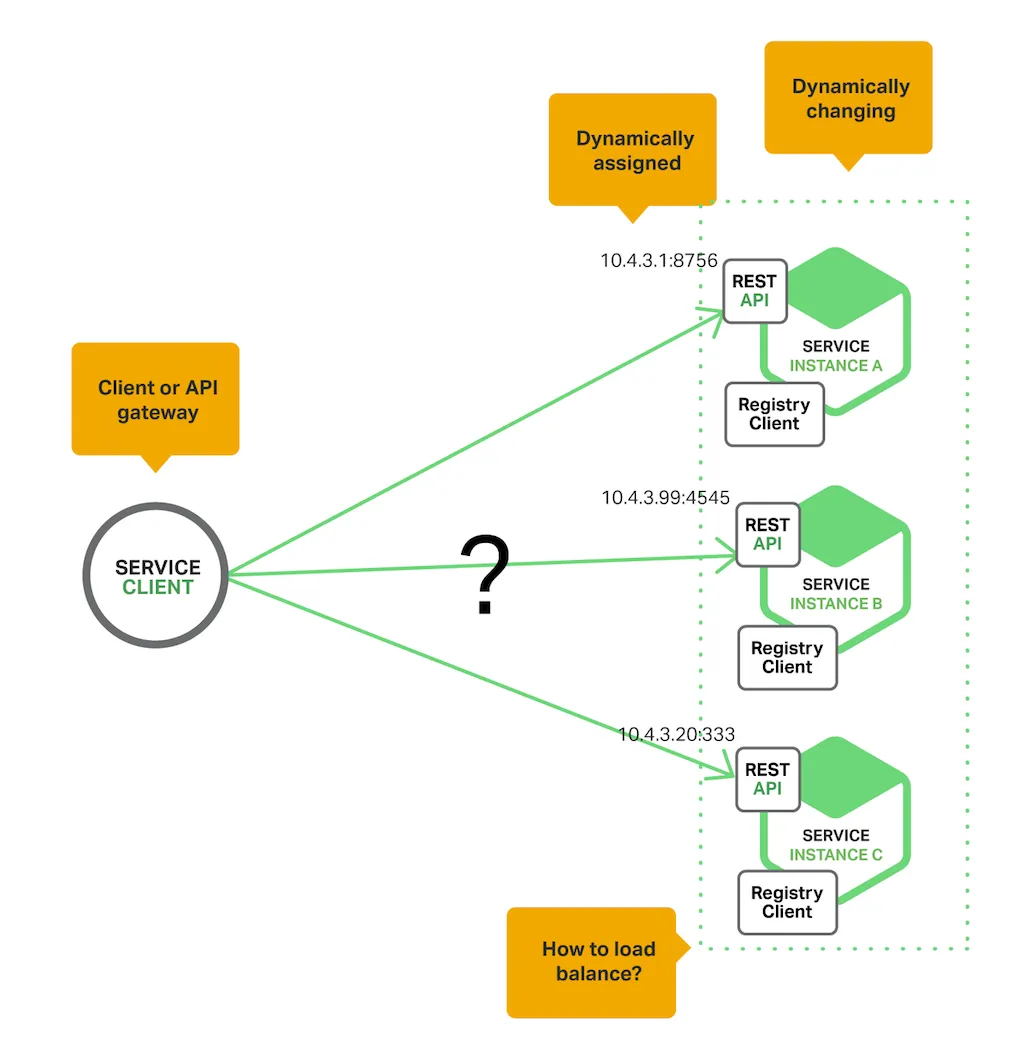

为了发出请求,您的代码需要知道服务实例的网络位置(IP 地址和端口),传统应用程序中,服务实例的网络位置是相对静态的。 例如,您的代码可以从偶尔更新的配置文件中读取网络位置。 然而,在现代的、基于云的微服务应用程序中,这是一个更难解决的问题,如下图所示:

使用注册中心服务实例具有动态分配的网络位置。 此外,服务实例集会因自动缩放、故障和升级而动态变化。

两种主要的服务发现模式:客户端发现和服务器端发现

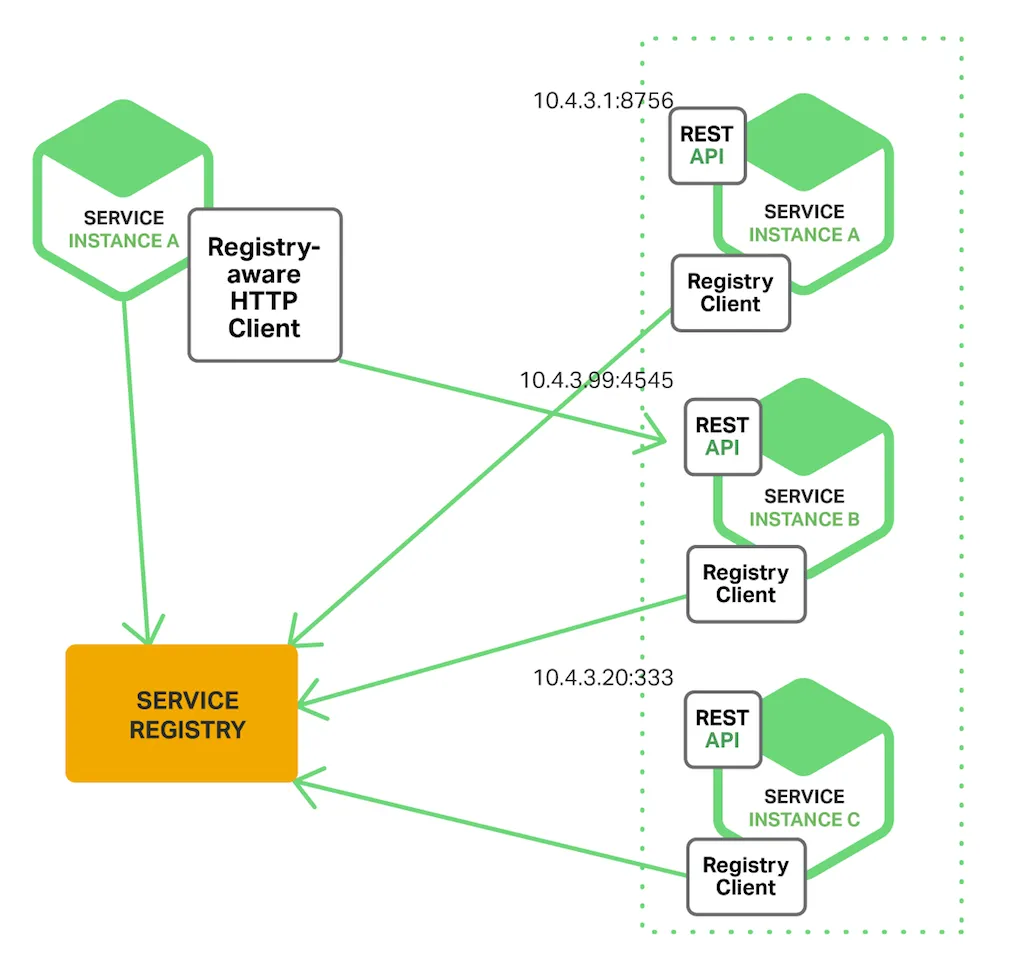

客户端发现

客户端负责确定可用服务实例的网络位置(例如10.4.3.20:333)并在它们之间实现请求的负载平衡。 客户端查询服务注册表,注册表是可用服务实例的数据库。 然后客户端使用负载平衡算法来选择一个可用的服务实例并发出请求。

服务实例的网络位置在启动时向服务注册表注册;当实例终止时,它会从服务注册表中删除。 服务实例的注册通常使用心跳机制定期刷新。

Netflix OSS 提供了一个很好的客户端发现模式示例。 Netflix Eureka 是一个服务注册中心。 它提供了一个 REST API 来管理服务实例注册和查询可用实例。 Netflix Ribbon 是一个 IPC 客户端,它与 Eureka 一起在可用服务实例之间负载平衡请求。

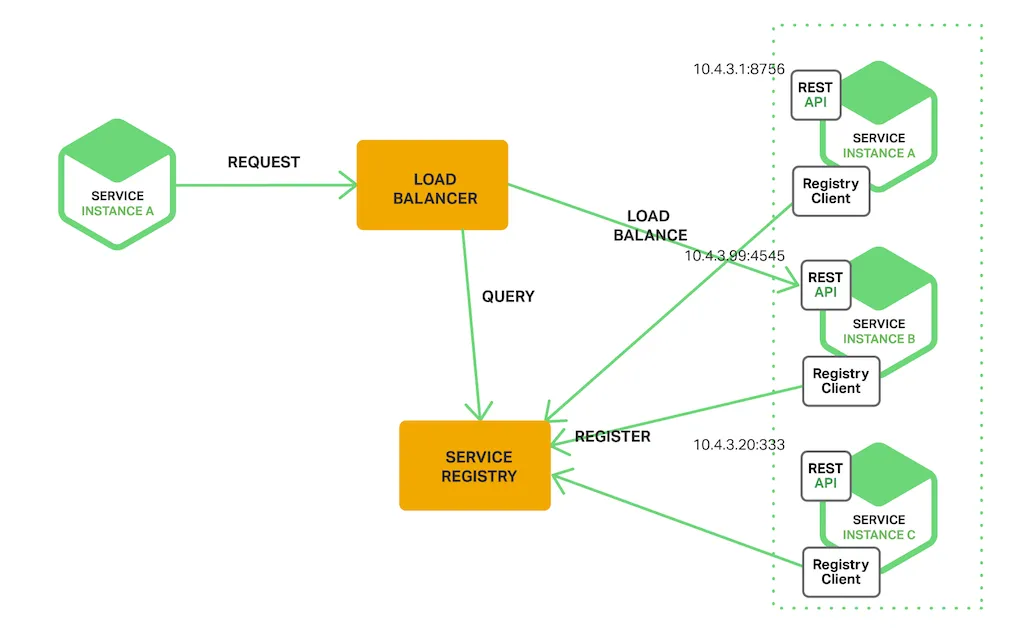

服务端发现

客户端通过负载均衡器向服务发出请求。 负载均衡器查询服务注册表并将每个请求路由到可用的服务实例。 与客户端发现一样,服务实例在服务注册表中注册和注销。

注册中心:

服务注册中心是服务发现的关键部分。 它是一个包含服务实例的网络位置的数据库。 服务注册中心需要高度可用并且是最新的。 客户端可以缓存从服务注册表获得的网络位置。 但是,该信息最终会过时,客户端将无法发现服务实例。 因此,服务注册中心由一组服务器组成,这些服务器使用复制协议来保持一致性。

Netflix Eureka 是服务注册中心的一个很好的例子。 它提供了一个用于注册和查询服务实例的 REST API。 服务实例使用 POST 请求注册其网络位置。 每 30 秒,它必须使用 PUT 请求刷新其注册。 通过使用 HTTP DELETE 请求或实例注册超时来删除注册。 客户端可以使用 HTTP GET 请求检索注册的服务实例。

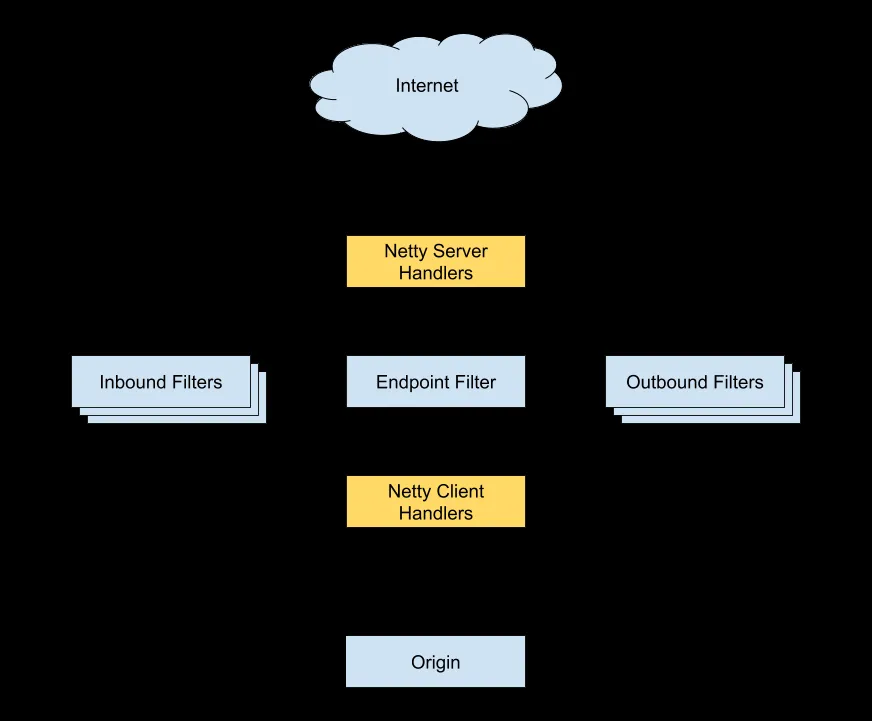

网关是什么呢

何为网关?为什么要网关?

微服务背景下,一个系统被拆分为多个服务,但是像安全认证,流量控制,日志,监控等功能是每个服务都需要的,没有网关的话,我们就需要在每个服务中单独实现,这使得我们做了很多重复的事情并且没有一个全局的视图来统一管理这些功能。

综上:一般情况下,网关都会提供请求转发、安全认证(身份/权限认证)、流量控制、负载均衡、容灾、日志、监控这些功能。

上面介绍了这么多功能,实际上,网关主要做了一件事情:请求过滤

拓展:有哪些常见的网关系统?

Netflix Zuul

Zuul 是 Netflix 开发的一款提供动态路由、监控、弹性、安全的网关服务。

Zuul 主要通过过滤器(类似于 AOP)来过滤请求,从而实现网关必备的各种功能

我们可以自定义过滤器来处理请求,并且,Zuul 生态本身就有很多现成的过滤器供我们使用。就比如限流可以直接用国外朋友写的 spring-cloud-zuul-ratelimit

(这里只是举例说明,一般是配合 hystrix 来做限流):

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-netflix-zuul</artifactId>

</dependency>

<dependency>

<groupId>com.marcosbarbero.cloud</groupId>

<artifactId>spring-cloud-zuul-ratelimit</artifactId>

<version>2.2.0.RELEASE</version>

</dependency>

Zuul 1.x 基于同步 IO,性能较差。Zuul 2.x 基于 Netty 实现了异步 IO,性能得到了大幅改进。

- Github 地址 : https://github.com/Netflix/zuul

- 官方 Wiki : https://github.com/Netflix/zuul/wiki

Spring Cloud Gateway

SpringCloud Gateway 属于 Spring Cloud 生态系统中的网关,其诞生的目标是为了替代老牌网关 **Zuul **。准确点来说,应该是 Zuul 1.x。SpringCloud Gateway 起步要比 Zuul 2.x 更早。

为了提升网关的性能,SpringCloud Gateway 基于 Spring WebFlux 。Spring WebFlux 使用 Reactor 库来实现响应式编程模型,底层基于 Netty 实现异步 IO。

Spring Cloud Gateway 的目标,不仅提供统一的路由方式,并且基于 Filter 链的方式提供了网关基本的功能,例如:安全,监控/指标,和限流。

Spring Cloud Gateway 和 Zuul 2.x 的差别不大,也是通过过滤器来处理请求。不过,目前更加推荐使用 Spring Cloud Gateway 而非 Zuul,Spring Cloud 生态对其支持更加友好。

- Github 地址 : https://github.com/spring-cloud/spring-cloud-gateway

- 官网 : https://spring.io/projects/spring-cloud-gateway

Kong

Kong 是一款基于 OpenResty

的高性能、云原生、可扩展的网关系统。

OpenResty 是一个基于 Nginx 与 Lua 的高性能 Web 平台,其内部集成了大量精良的 Lua 库、第三方模块以及大多数的依赖项。用于方便地搭建能够处理超高并发、扩展性极高的动态 Web 应用、Web 服务和动态网关。

Kong 提供了插件机制来扩展其功能。比如、在服务上启用 Zipkin 插件

$ curl -X POST http://kong:8001/services/{service}/plugins \

--data "name=zipkin" \

--data "config.http_endpoint=http://your.zipkin.collector:9411/api/v2/spans" \

--data "config.sample_ratio=0.001"

- Github 地址: https://github.com/Kong/kong

- 官网地址 : https://konghq.com/kong

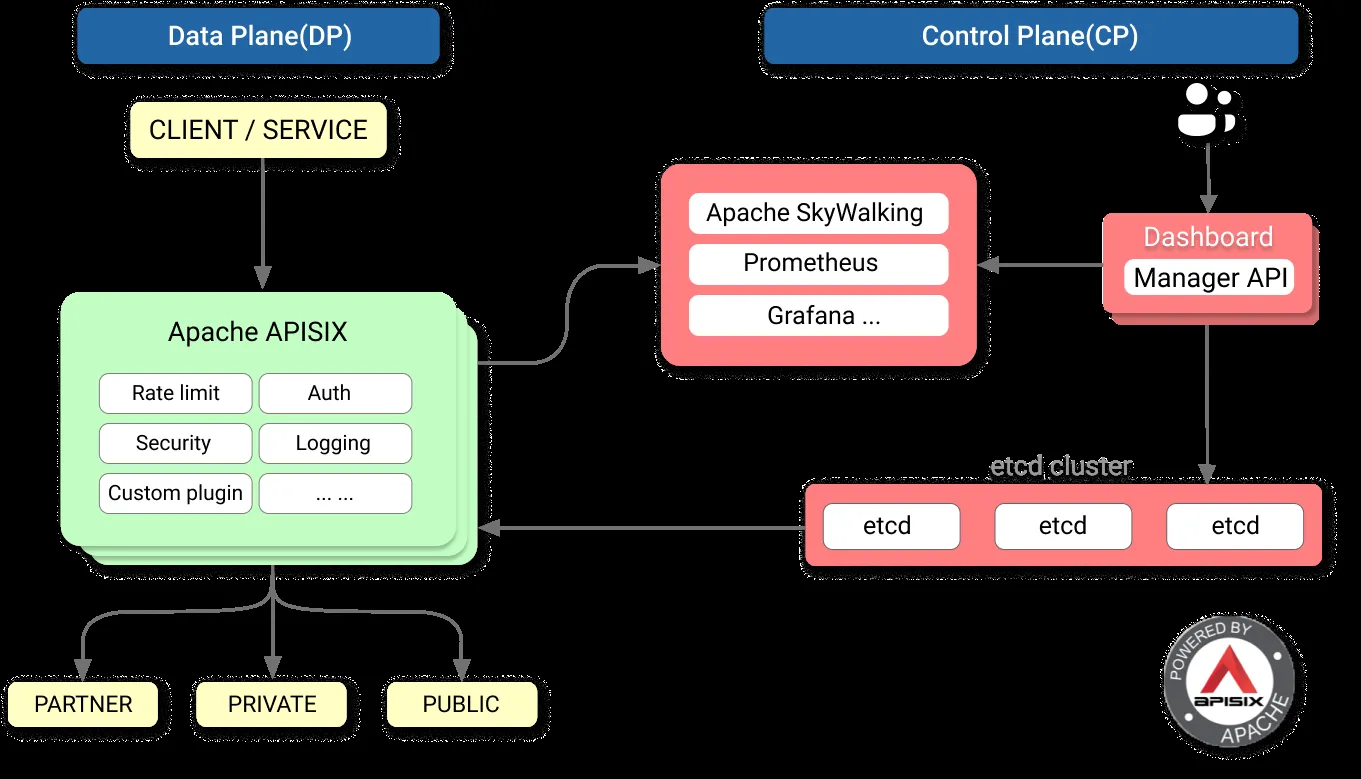

APISIX

APISIX 是一款基于 Nginx 和 etcd 的高性能、云原生、可扩展的网关系统。

etcd是使用 Go 语言开发的一个开源的、高可用的分布式 key-value 存储系统,使用 Raft 协议做分布式共识。

与传统 API 网关相比,APISIX 具有动态路由和插件热加载,特别适合微服务系统下的 API 管理。并且,APISIX 与 SkyWalking(分布式链路追踪系统)、Zipkin(分布式链路追踪系统)、Prometheus(监控系统) 等 DevOps 生态工具对接都十分方便。

作为 NGINX 和 Kong 的替代项目,APISIX 目前已经是 Apache 顶级开源项目,并且是最快毕业的国产开源项目。国内目前已经有很多知名企业(比如金山、有赞、爱奇艺、腾讯、贝壳)使用 APISIX 处理核心的业务流量。

根据官网介绍:“APISIX 已经生产可用,功能、性能、架构全面优于 Kong”。

- Github 地址 :https://github.com/apache/apisix

- 官网地址: https://apisix.apache.org/zh/

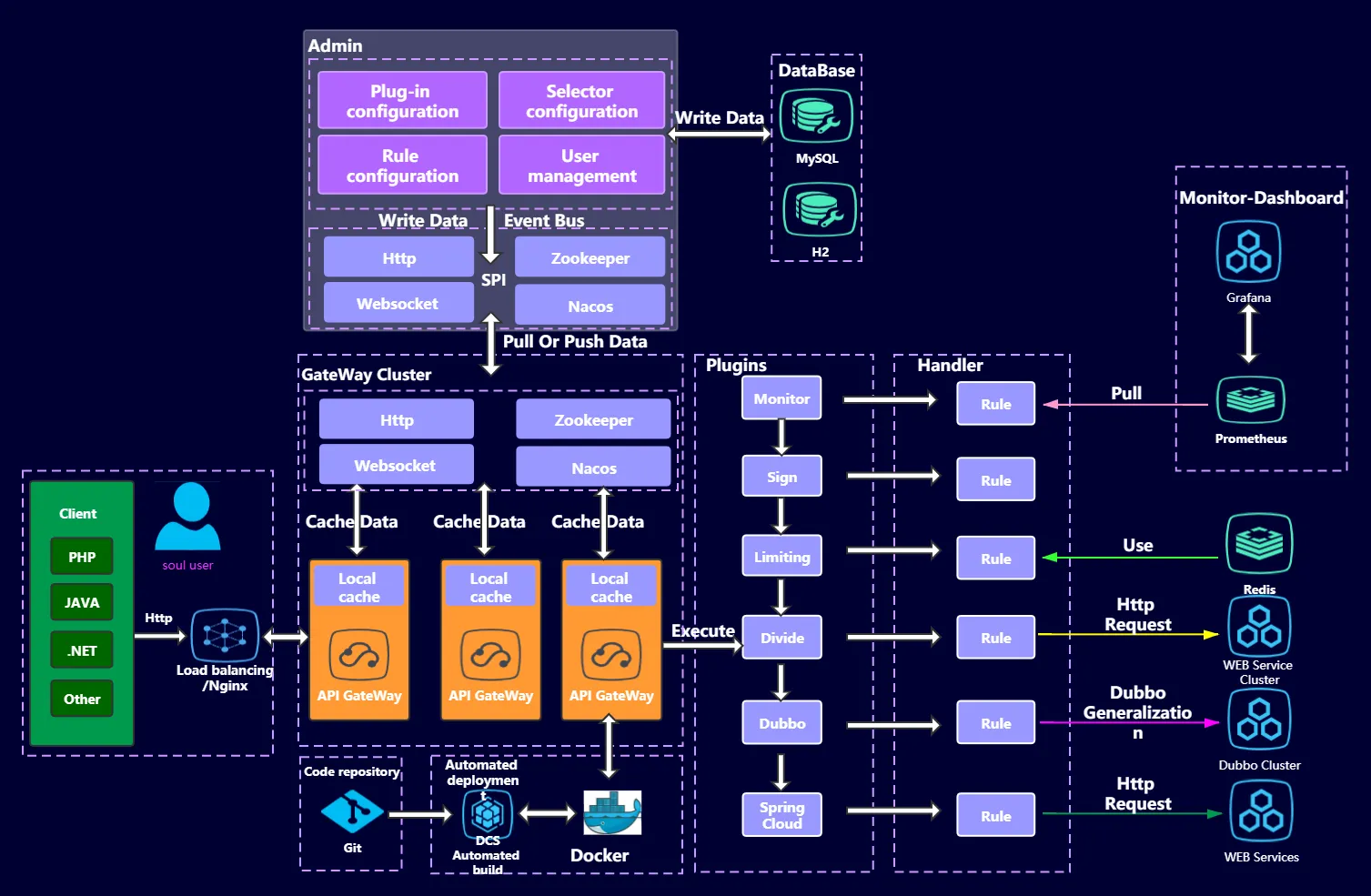

Shenyu

Shenyu 是一款基于 WebFlux 的可扩展、高性能、响应式网关,Apache 顶级开源项目。

Shenyu 通过插件扩展功能,插件是 ShenYu 的灵魂,并且插件也是可扩展和热插拔的。不同的插件实现不同的功能。Shenyu 自带了诸如限流、熔断、转发 、重写、重定向、和路由监控等插件。

- Github 地址: https://github.com/apache/incubator-shenyu

- 官网地址 : https://shenyu.apache.org/

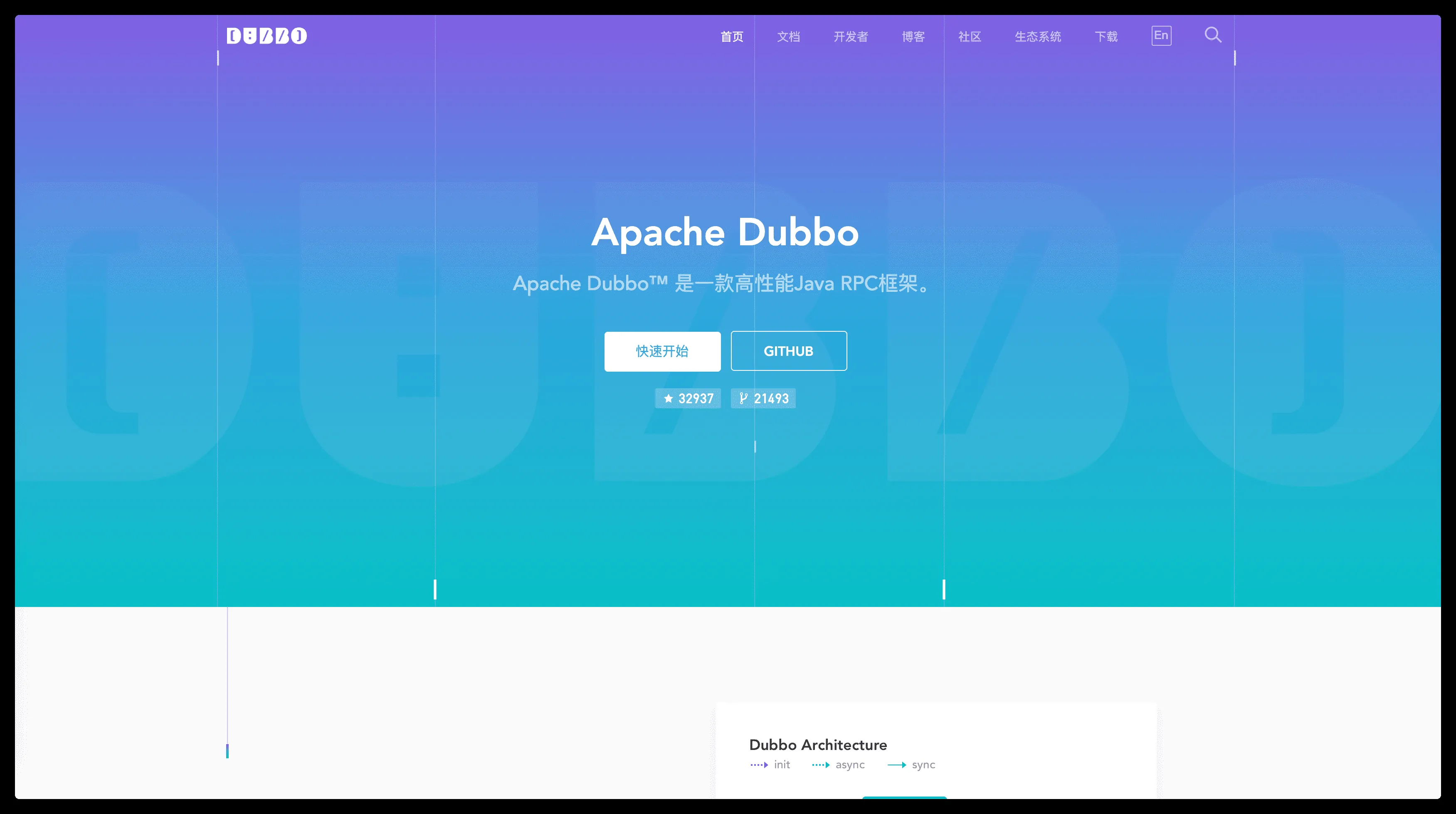

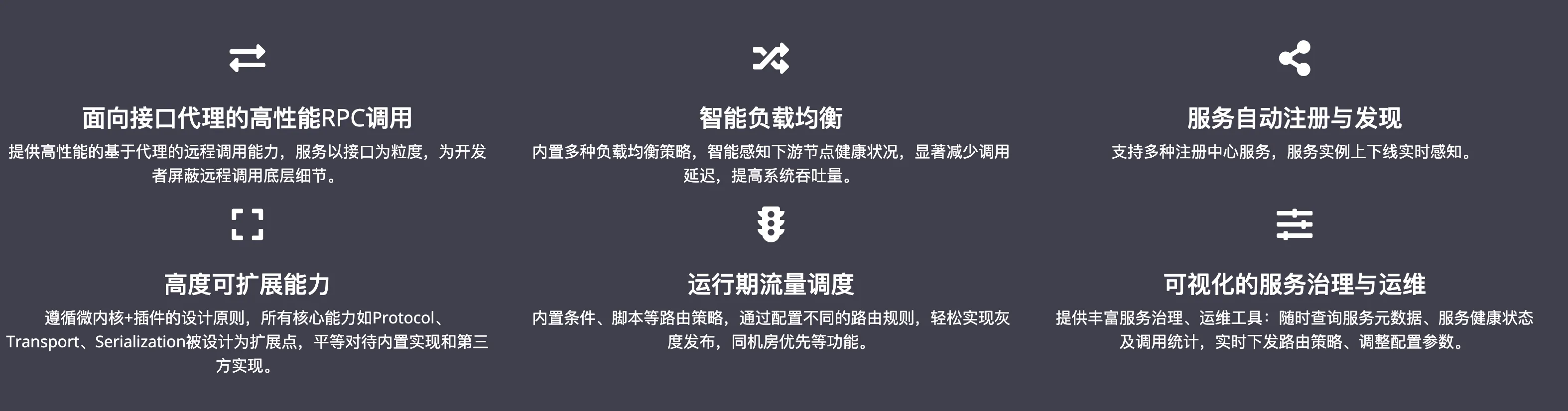

dubbo了解吗?

什么是 Dubbo?

Apache Dubbo 是一款高性能、轻量级的开源 Java RPC 框架。

根据 Dubbo 官方文档

的介绍,Dubbo 提供了六大核心能力

- 面向接口代理的高性能RPC调用。

- 智能容错和负载均衡。

- 服务自动注册和发现。

- 高度可扩展能力。

- 运行期流量调度。

- 可视化的服务治理与运维。

简单来说就是: Dubbo 不光可以帮助我们调用远程服务,还提供了一些其他开箱即用的功能比如智能负载均衡。

为什么要用 Dubbo?

随着互联网的发展,网站的规模越来越大,用户数量越来越多。单一应用架构 、垂直应用架构无法满足我们的需求,这个时候分布式服务架构就诞生了。

分布式服务架构下,系统被拆分成不同的服务比如短信服务、安全服务,每个服务独立提供系统的某个核心服务。

我们可以使用 Java RMI(Java Remote Method Invocation)、Hessian这种支持远程调用的框架来简单地暴露和引用远程服务。但是!当服务越来越多之后,服务调用关系越来越复杂。当应用访问压力越来越大后,负载均衡以及服务监控的需求也迫在眉睫。我们可以用 F5 这类硬件来做负载均衡,但这样增加了成本,并且存在单点故障的风险。

不过,Dubbo 的出现让上述问题得到了解决。Dubbo 帮助我们解决了什么问题呢?

- 负载均衡 : 同一个服务部署在不同的机器时该调用哪一台机器上的服务。

- 服务调用链路生成 : 随着系统的发展,服务越来越多,服务间依赖关系变得错踪复杂,甚至分不清哪个应用要在哪个应用之前启动,架构师都不能完整的描述应用的架构关系。Dubbo 可以为我们解决服务之间互相是如何调用的。

- 服务访问压力以及时长统计、资源调度和治理 :基于访问压力实时管理集群容量,提高集群利用率。

- ......

另外,Dubbo 除了能够应用在分布式系统中,也可以应用在现在比较火的微服务系统中。不过,由于 Spring Cloud 在微服务中应用更加广泛,所以,我觉得一般我们提 Dubbo 的话,大部分是分布式系统的情况。

是怎么使用分布式锁的?

分布式锁,是控制分布式系统不同进程共同访问共享资源的一种锁的实现。秒杀下单、抢红包等等业务场景,都需要用到分布式锁,我们项目中经常使用Redis作为分布式锁。

选了Redis分布式锁的几种实现方法,大家来讨论下,看有没有啥问题哈。

- 命令setnx + expire分开写

- setnx + value值是过期时间

- set的扩展命令(set ex px nx)

- set ex px nx + 校验唯一随机值,再删除

- Redisson

命令setnx + expire分开写

if(jedis.setnx(key,lock_value) == 1){ //加锁

expire(key,100); //设置过期时间

try {

do something //业务请求

}catch(){

}

finally {

jedis.del(key); //释放锁

}

}

如果执行完 setnx加锁,正要执行 expire设置过期时间时,进程crash掉或者要重启维护了,那这个锁就“长生不老”了,别的线程永远获取不到锁啦,所以分布式锁不能这么实现。

setnx + value值是过期时间

long expires = System.currentTimeMillis() + expireTime; //系统时间+设置的过期时间

String expiresStr = String.valueOf(expires);

// 如果当前锁不存在,返回加锁成功

if (jedis.setnx(key, expiresStr) == 1) {

return true;

}

// 如果锁已经存在,获取锁的过期时间

String currentValueStr = jedis.get(key);

// 如果获取到的过期时间,小于系统当前时间,表示已经过期

if (currentValueStr != null && Long.parseLong(currentValueStr) < System.currentTimeMillis()) {

// 锁已过期,获取上一个锁的过期时间,并设置现在锁的过期时间(不了解redis的getSet命令的小伙伴,可以去官网看下哈)

String oldValueStr = jedis.getSet(key_resource_id, expiresStr);

if (oldValueStr != null && oldValueStr.equals(currentValueStr)) {

// 考虑多线程并发的情况,只有一个线程的设置值和当前值相同,它才可以加锁

return true;

}

}

//其他情况,均返回加锁失败

return false;

}

笔者看过有开发小伙伴就是这么实现分布式锁的,但是这种方案也有这些缺点:

- 过期时间是客户端自己生成的,分布式环境下,每个客户端的时间必须同步。

- 没有保存持有者的唯一标识,可能被别的客户端释放/解锁。

- 锁过期的时候,并发多个客户端同时请求过来,都执行了

jedis.getSet(),最终只能有一个客户端加锁成功,但是该客户端锁的过期时间,可能被别的客户端覆盖。

set的扩展命令(set ex px nx)(注意可能存在的问题)

if(jedis.set(key, lock_value, "NX", "EX", 100s) == 1){ //加锁

try {

do something //业务处理

}catch(){

}

finally {

jedis.del(key); //释放锁

}

}

这个方案可能存在这样的问题:

- 锁过期释放了,业务还没执行完。

- 锁被别的线程误删。

set ex px nx + 校验唯一随机值,再删除

if(jedis.set(key, uni_request_id, "NX", "EX", 100s) == 1){ //加锁

try {

do something //业务处理

}catch(){

}

finally {

//判断是不是当前线程加的锁,是才释放

if (uni_request_id.equals(jedis.get(key))) {

jedis.del(key); //释放锁

}

}

}

在这里,判断当前线程加的锁和释放锁是不是一个原子操作。如果调用jedis.del()释放锁的时候,可能这把锁已经不属于当前客户端,会解除他人加的锁。

一般也是用lua脚本代替。lua脚本如下:

if redis.call('get',KEYS[1]) == ARGV[1] then

return redis.call('del',KEYS[1])

else

return 0

end;

这种方式比较不错了,一般情况下,已经可以使用这种实现方式。但是存在锁过期释放了,业务还没执行完的问题(实际上,估算个业务处理的时间,一般没啥问题了)。

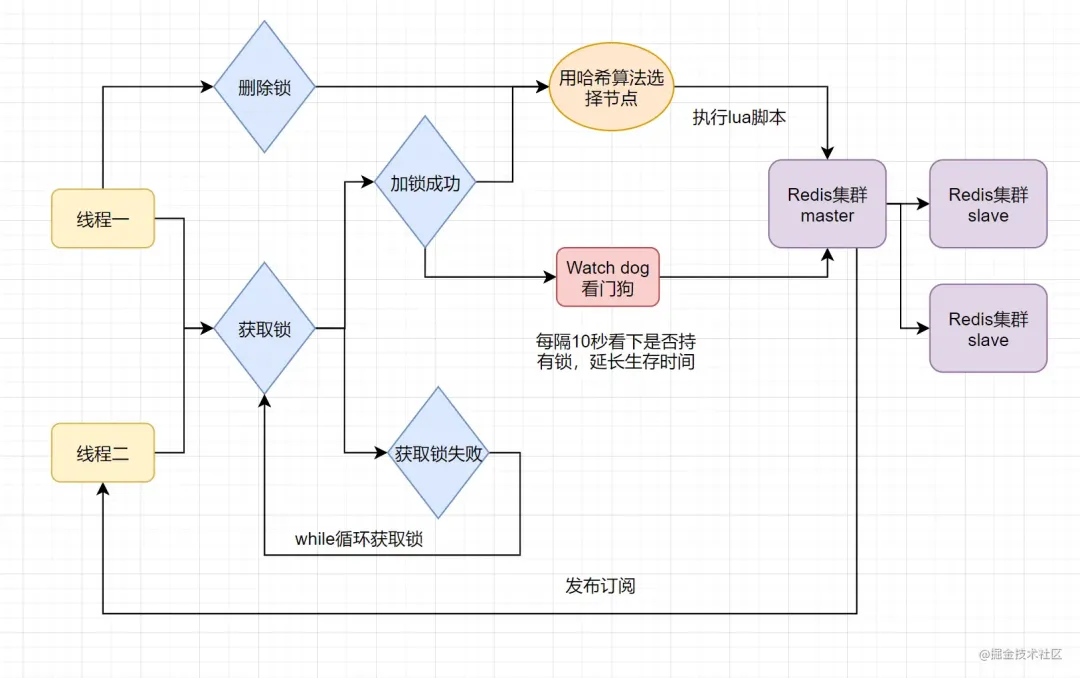

Redisson

分布式锁可能存在锁过期释放,业务没执行完的问题。有些小伙伴认为,稍微把锁过期时间设置长一些就可以啦。其实我们设想一下,是否可以给获得锁的线程,开启一个定时守护线程,每隔一段时间检查锁是否还存在,存在则对锁的过期时间延长,防止锁过期提前释放。

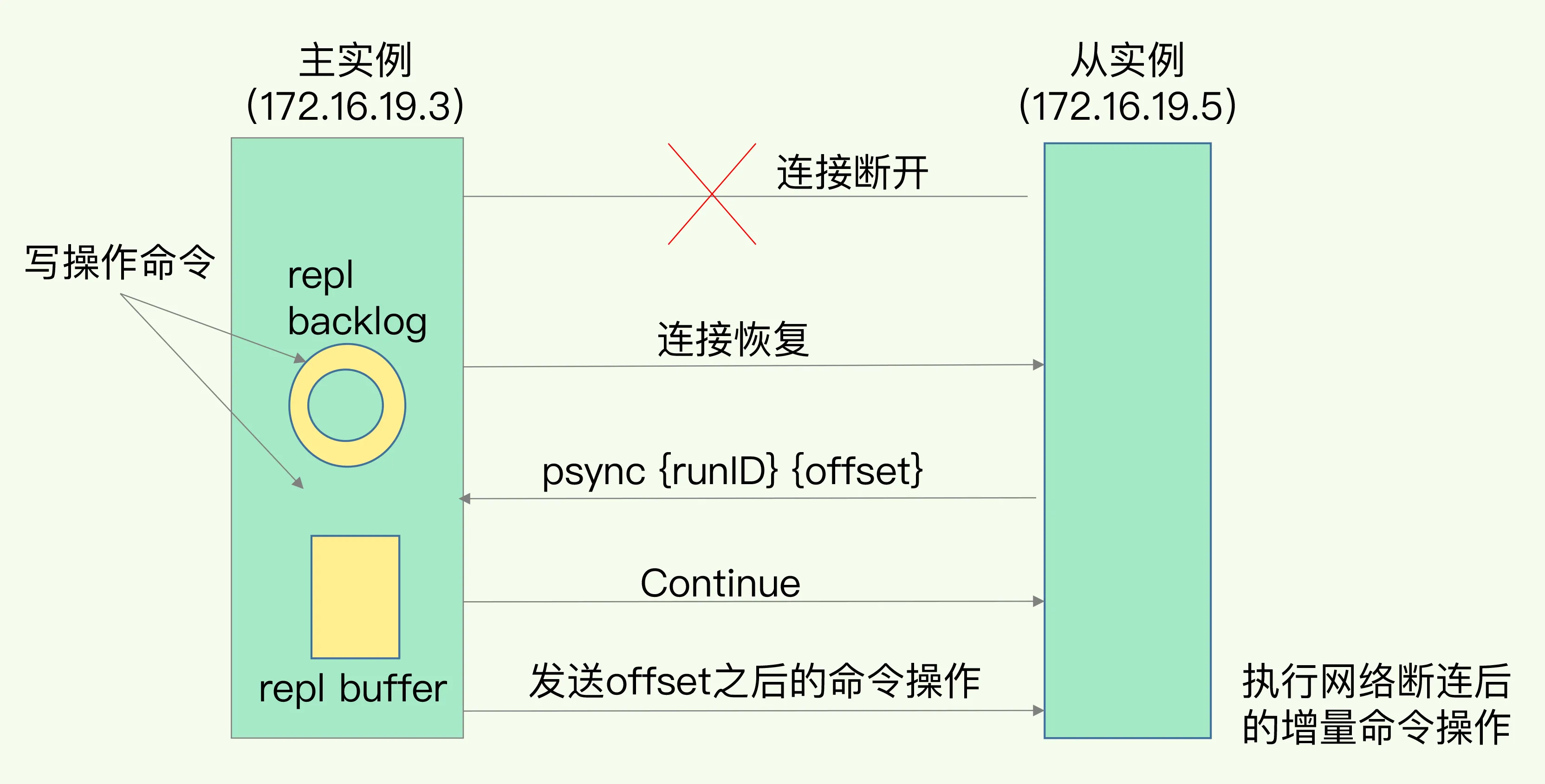

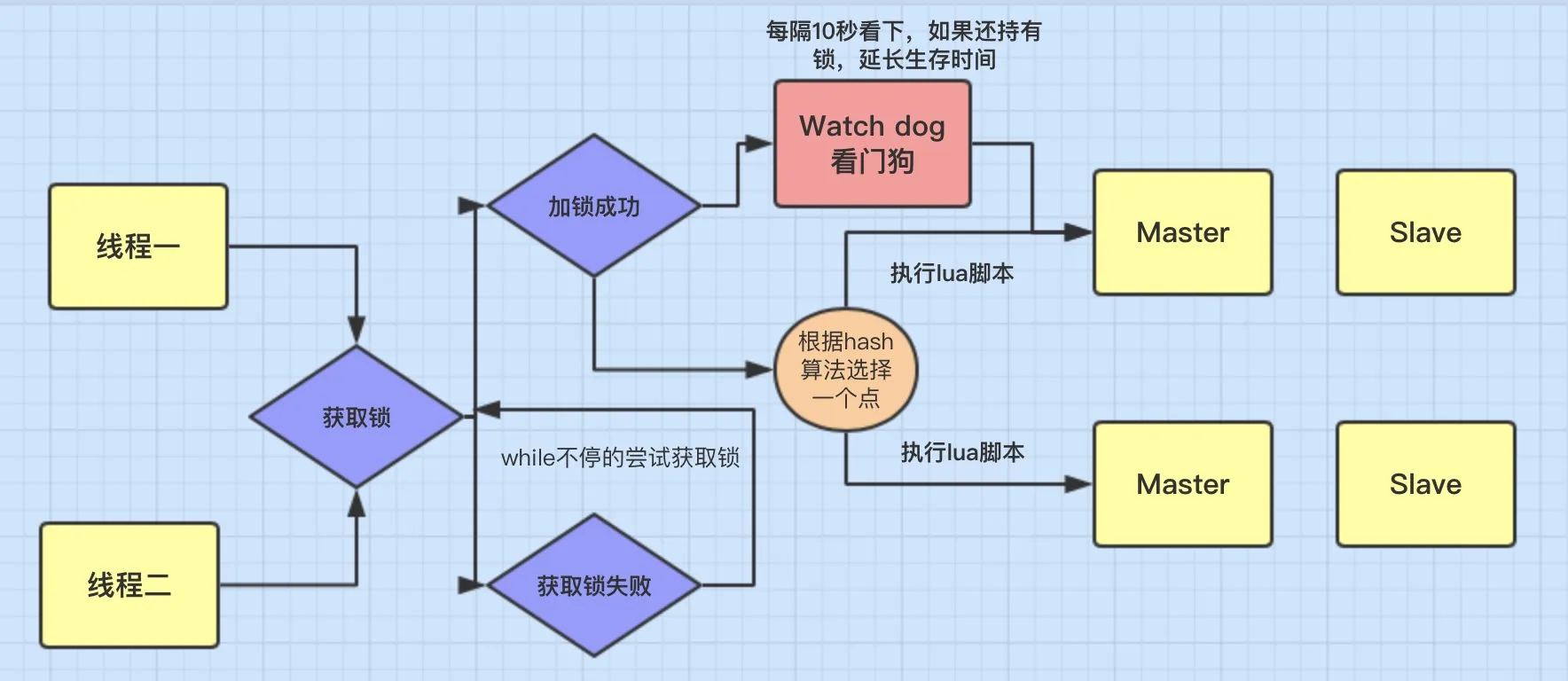

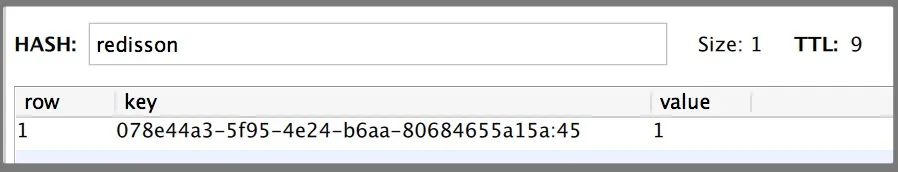

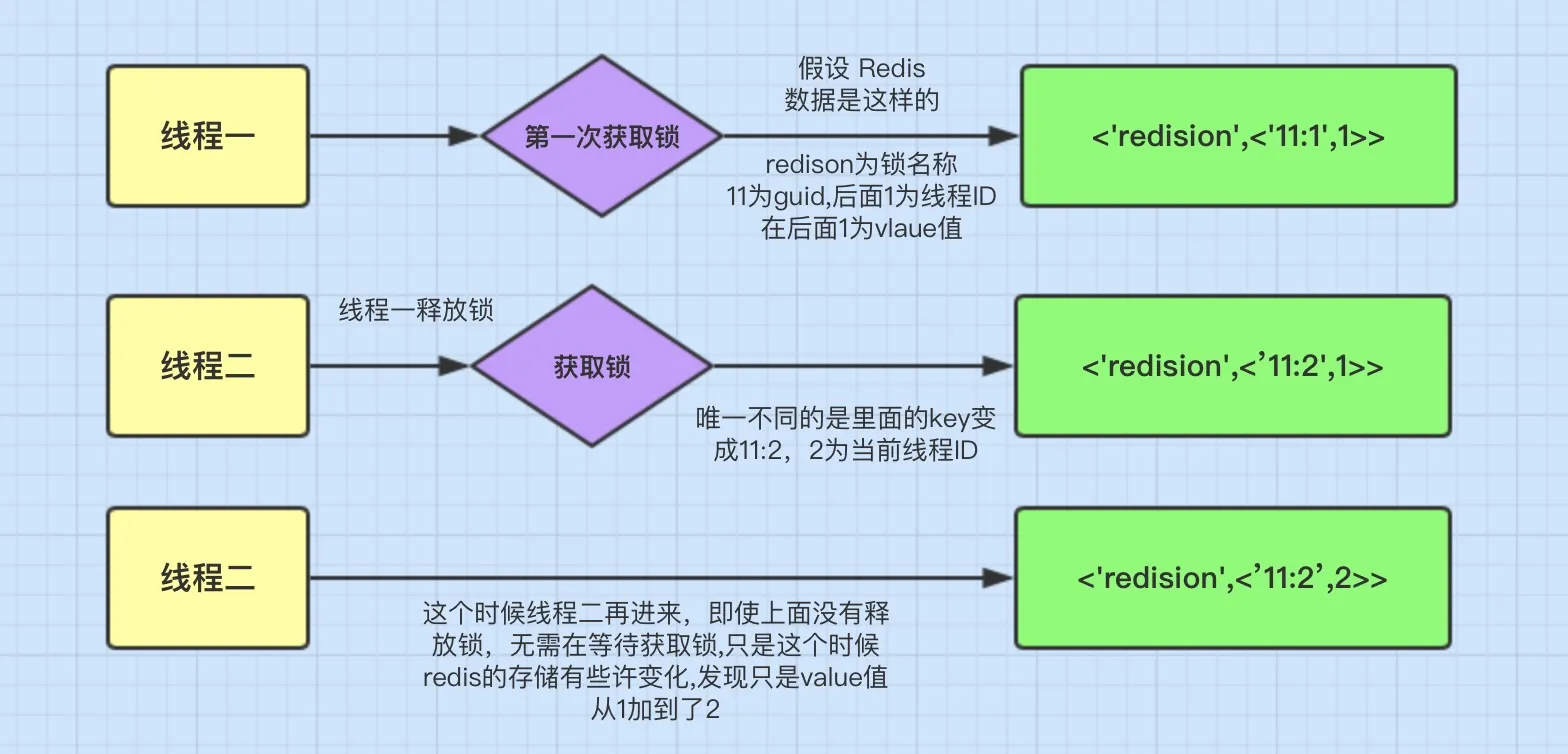

当前开源框架Redisson就解决了这个分布式锁问题。我们一起来看下Redisson底层原理是怎样的吧:

只要线程一加锁成功,就会启动一个 watch dog看门狗,它是一个后台线程,会每隔10秒检查一下,如果线程1还持有锁,那么就会不断的延长锁key的生存时间。因此,Redisson就是使用Redisson解决了锁过期释放,业务没执行完问题

redisson分布式锁,watch机制?

这里Redis的客户端(Jedis, Redisson, Lettuce等)都是基于上述两类形式来实现分布式锁的,只是两类形式的封装以及一些优化(比如Redisson的watch dog)。

以基于Redisson实现分布式锁为例(支持了 单实例、Redis哨兵、redis cluster、redis master-slave等各种部署架构):

特色?

- redisson所有指令都通过lua脚本执行,保证了操作的原子性

- redisson设置了watchdog看门狗,“看门狗”的逻辑保证了没有死锁发生

- redisson支持Redlock的实现方式。

过程?

- 线程去获取锁,获取成功: 执行lua脚本,保存数据到redis数据库。

- 线程去获取锁,获取失败: 订阅了解锁消息,然后再尝试获取锁,获取成功后,执行lua脚本,保存数据到redis数据库。

互斥?

如果这个时候客户端B来尝试加锁,执行了同样的一段lua脚本。第一个if判断会执行“exists myLock”,发现myLock这个锁key已经存在。接着第二个if判断,判断myLock锁key的hash数据结构中,是否包含客户端B的ID,但明显没有,那么客户端B会获取到pttl myLock返回的一个数字,代表myLock这个锁key的剩余生存时间。此时客户端B会进入一个while循环,不听的尝试加锁。

watch dog自动延时机制?

客户端A加锁的锁key默认生存时间只有30秒,如果超过了30秒,客户端A还想一直持有这把锁,怎么办?其实只要客户端A一旦加锁成功,就会启动一个watch dog看门狗,它是一个后台线程,会每隔10秒检查一下,如果客户端A还持有锁key,那么就会不断的延长锁key的生存时间。

可重入?

每次lock会调用incrby,每次unlock会减一。

常见分布式事务解决方案

**分布式事务**:就是指事务的参与者、支持事务的服务器、资源服务器以及事务管理器分别位于不同的分布式系统的不同节点之上。简单来说,分布式事务指的就是分布式系统中的事务,它的存在就是为了保证不同数据库节点的数据一致性。

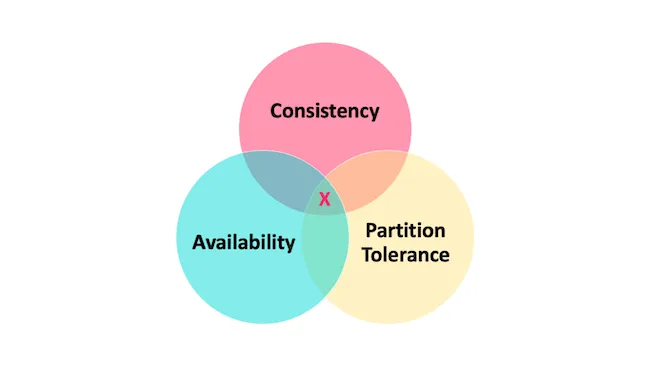

聊到分布式事务,大家记得这两个理论哈:CAP理论 和 BASE 理论

分布式事务的几种解决方案:

- 2PC(二阶段提交)方案、3PC

- TCC(Try、Confirm、Cancel)

- 本地消息表

- 最大努力通知

- seata

2PC(二阶段提交)方案

2PC,即两阶段提交,它将分布式事务的提交拆分为2个阶段:prepare和commit/rollback,即准备阶段和提交执行阶段。在prepare准备阶段需要等待所有参与子事务的反馈,因此可能造成数据库资源锁定时间过长,不适合并发高以及子事务生命周长较长的业务场景。并且协调者宕机的话,所有的参与者都收不到提交或回滚指令。

3PC

两阶段提交分别是:CanCommit,PreCommit 和 doCommit,这里不再详述。3PC 利用超时机制解决了 2PC 的同步阻塞问题,避免资源被永久锁定,进一步加强了整个事务过程的可靠性。但是 3PC 同样无法应对类似的宕机问题,只不过出现多数据源中数据不一致问题的概率更小。

TCC

TCC 采用了补偿机制,其核心思想是:针对每个操作,都要注册一个与其对应的确认和补偿(撤销)操作。它分为三个阶段:Try-Confirm-Cancel

- try阶段:尝试去执行,完成所有业务的一致性检查,预留必须的业务资源。

- Confirm阶段:该阶段对业务进行确认提交,不做任何检查,因为try阶段已经检查过了,默认Confirm阶段是不会出错的。

- Cancel 阶段:若业务执行失败,则进入该阶段,它会释放try阶段占用的所有业务资源,并回滚Confirm阶段执行的所有操作。

TCC方案让应用可以自定义数据库操作的粒度,降低了锁冲突,可以提升性能。但是应用侵入性强,try、confirm、cancel三个阶段都需要业务逻辑实现。

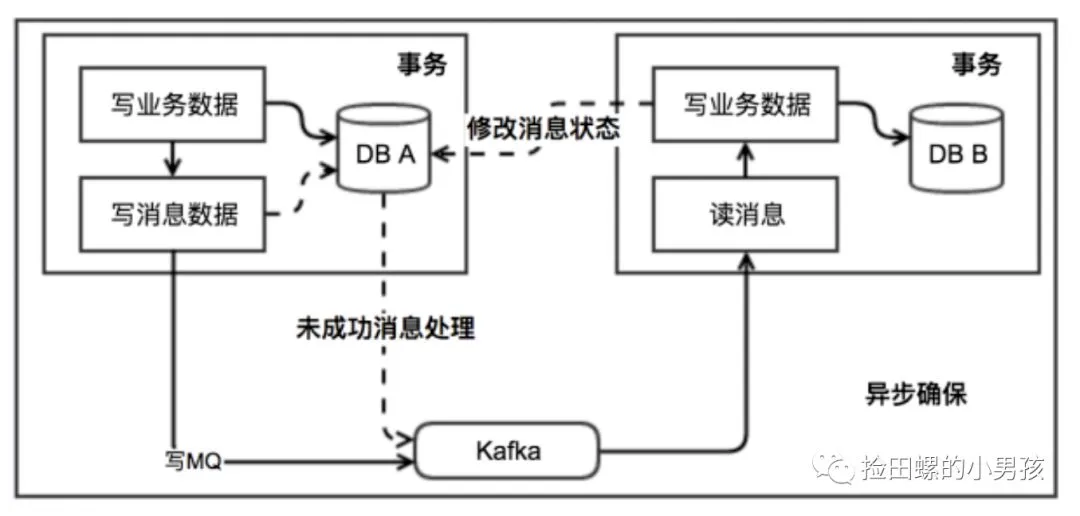

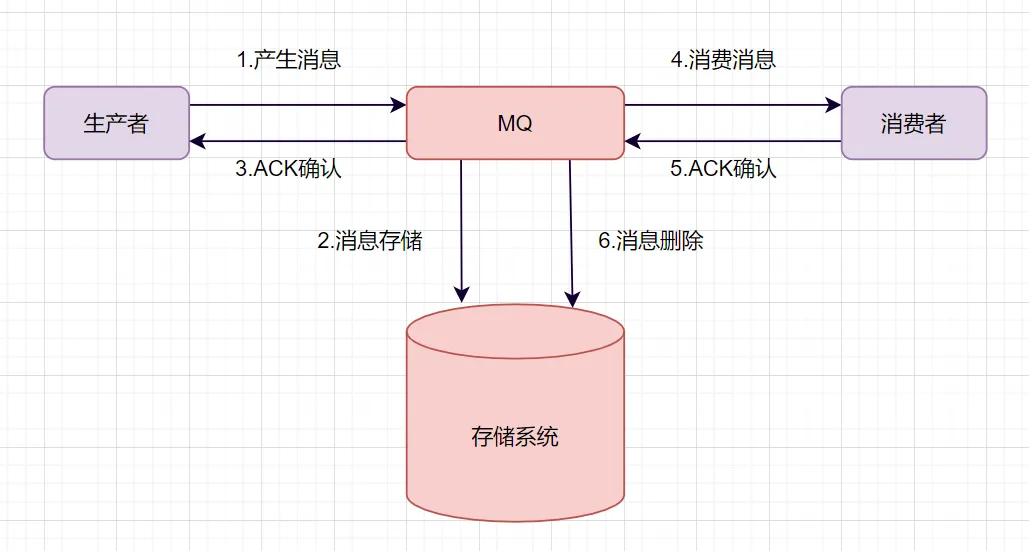

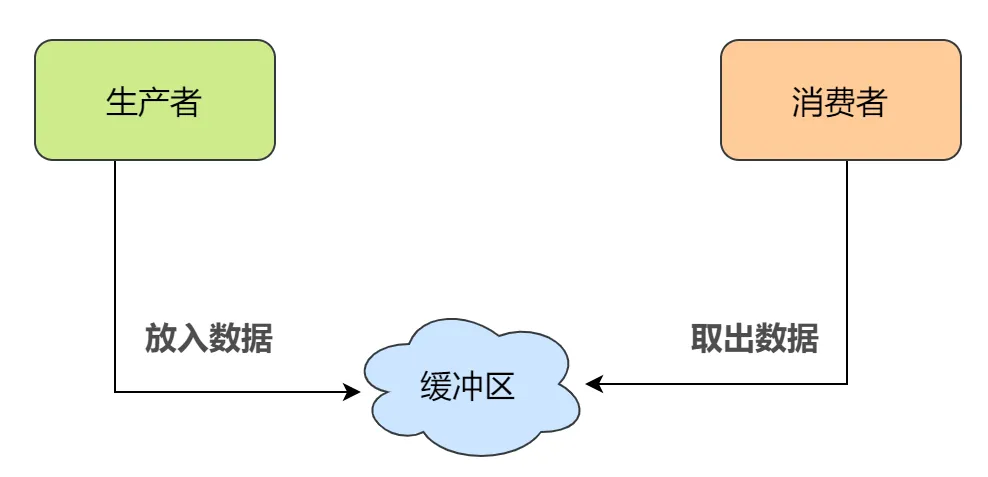

本地消息表

ebay最初提出本地消息表这个方案,来解决分布式事务问题。业界目前使用这种方案是比较多的,它的核心思想就是将分布式事务拆分成本地事务进行处理。可以看一下基本的实现流程图:

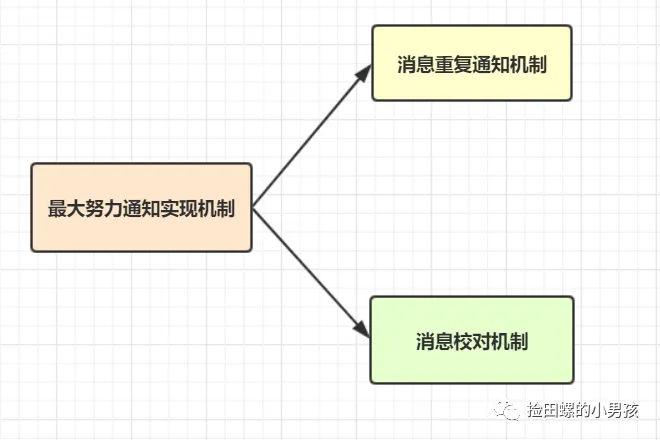

最大努力通知

最大努力通知方案的目标,就是发起通知方通过一定的机制,最大努力将业务处理结果通知到接收方。

seata

Saga 模式是 Seata 提供的长事务解决方案。核心思想是将长事务拆分为多个本地短事务,由Saga事务协调器协调,如果正常结束那就正常完成,如果某个步骤失败,则根据相反顺序一次调用补偿操作。

Saga的并发度高,但是一致性弱,对于转账,可能发生用户已扣款,最后转账又失败的情况。

讲讲CAP理论?怎么理解分区容错性?

起源于 2000年,由加州大学伯克利分校的Eric Brewer教授在分布式计算原理研讨会(PODC)上提出,因此 CAP定理又被称作 布鲁尔定理(Brewer’s theorem)

2年后,麻省理工学院的Seth Gilbert和Nancy Lynch 发表了布鲁尔猜想的证明,CAP理论正式成为分布式领域的定理。

简介

CAP 也就是 Consistency(一致性)、Availability(可用性)、Partition Tolerance(分区容错性) 这三个单词首字母组合。

CAP 理论的提出者布鲁尔在提出 CAP 猜想的时候,并没有详细定义 Consistency、Availability、Partition Tolerance 三个单词的明确定义。

因此,对于 CAP 的民间解读有很多,一般比较被大家推荐的是下面 👇 这种版本的解读。

在理论计算机科学中,CAP 定理(CAP theorem)指出对于一个分布式系统来说,当设计读写操作时,只能同时满足以下三点中的两个:

- 一致性(Consistency) : 所有节点访问同一份最新的数据副本

- 可用性(Availability): 非故障的节点在合理的时间内返回合理的响应(不是错误或者超时的响应)。

- 分区容错性(Partition tolerance) : 分布式系统出现网络分区的时候,仍然能够对外提供服务。

总的来说就是,数据存在的节点越多,分区容忍性越高,但要复制更新的数据就越多,一致性就越难保证。为了保证一致性,更新所有节点数据所需要的时间就越长,可用性就会降低。

springcloud和dubbo区别在哪?各有什么优缺点?

服务调用方式:dubbo是RPC springcloud Rest Api

注册中心:dubbo 是zookeeper springcloud是eureka,也可以是zookeeper

服务网关,dubbo本身没有实现,只能通过其他第三方技术整合,springcloud有Zuul路由网关,作为路由服务器,进行消费者的请求分发,springcloud支持断路器,与git完美集成配置文件支持版本控制,事物总线实现配置文件的更新与服务自动装配等等一系列的微服务架构要素。

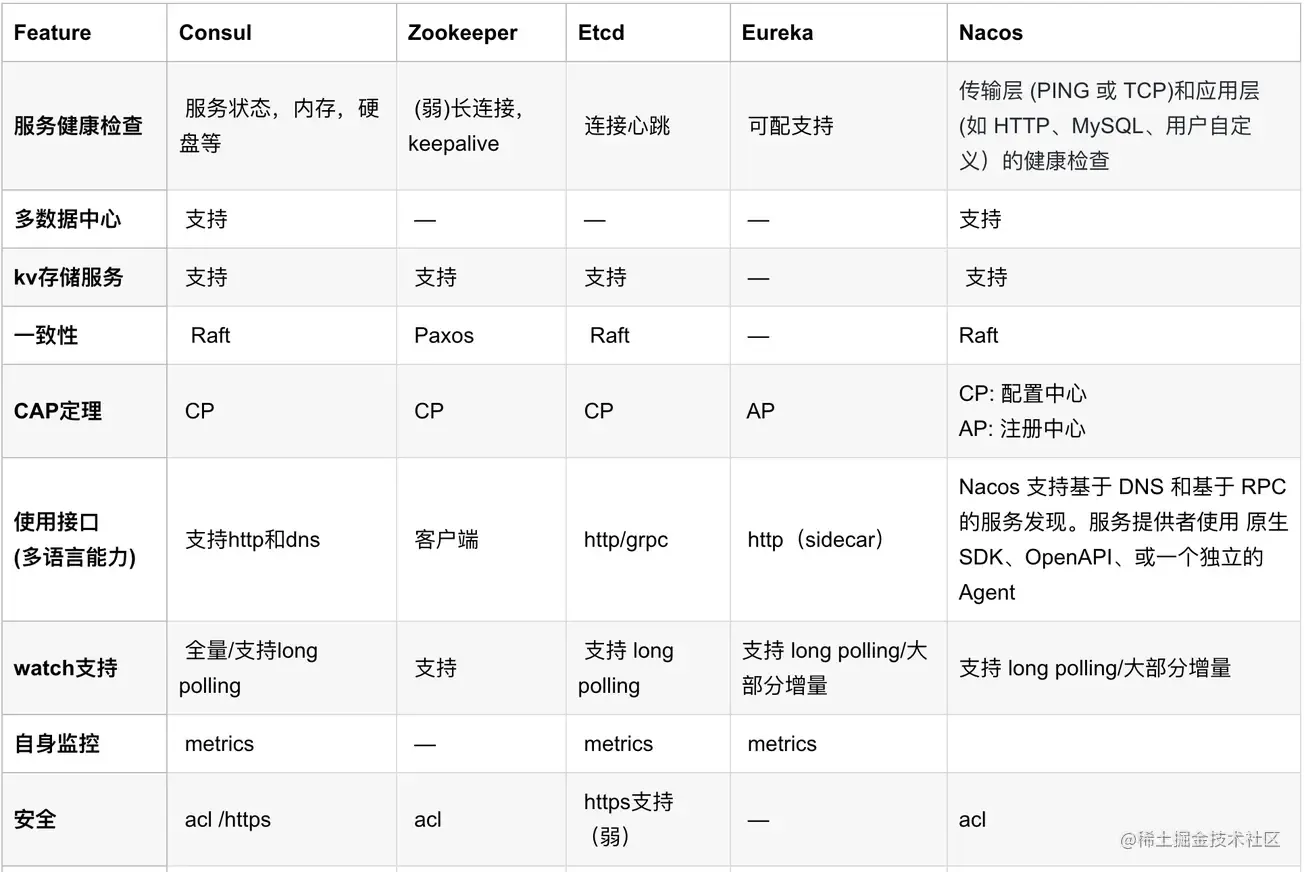

nacos注册中心和zk有啥区别?

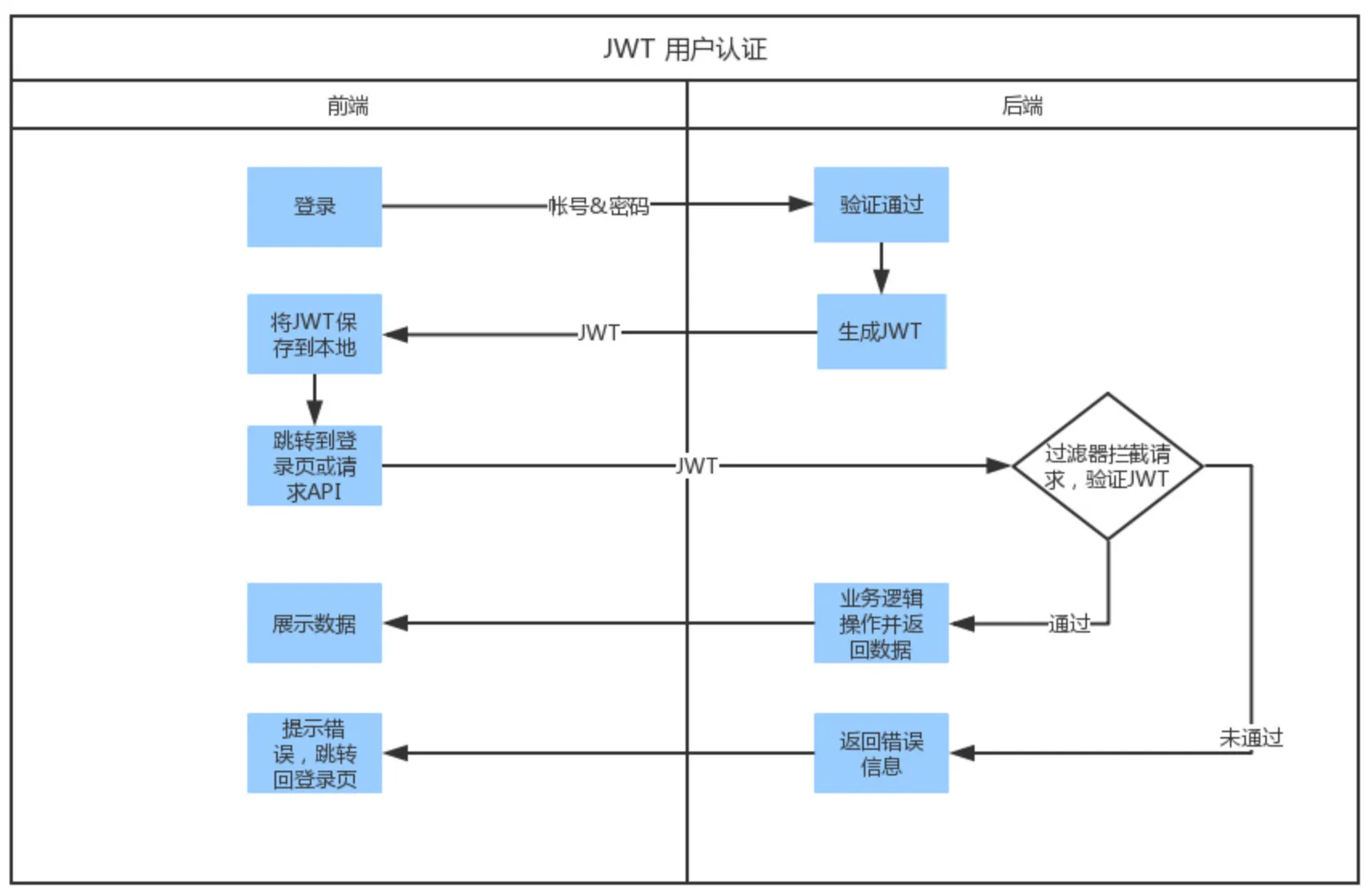

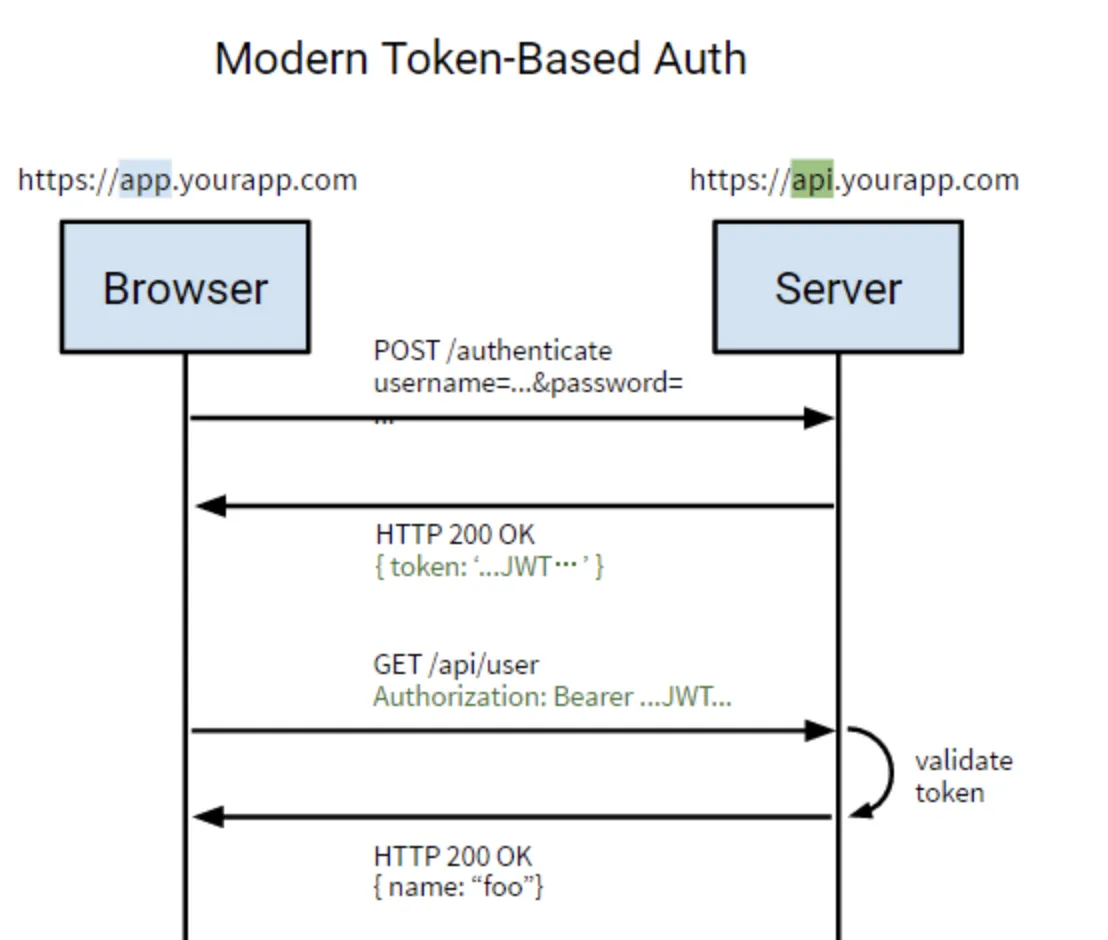

分布式登录怎么保持状态 (简而言之:单点登录怎么实现?)

什么是单点登录:https://zhuanlan.zhihu.com/p/66037342

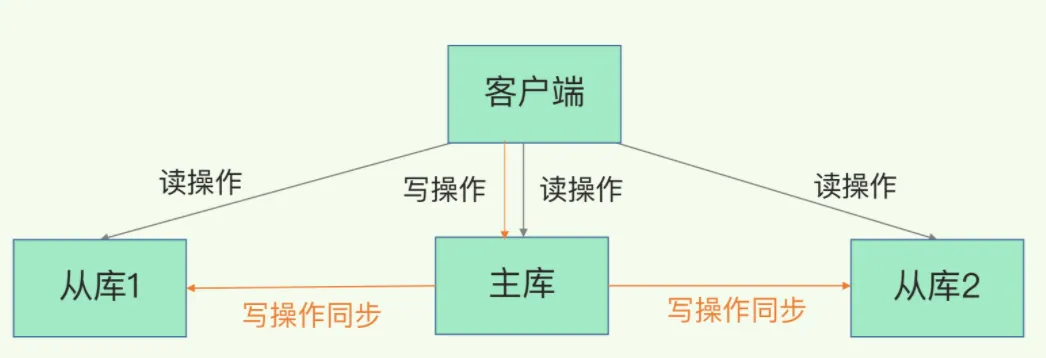

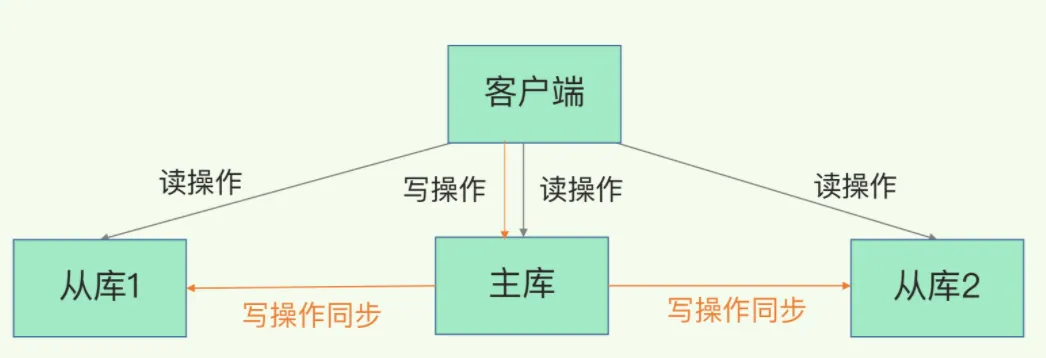

分布式系统中,本地缓存和 Redis 中的数据是否是每台服务器上都备份同样的数据(暂时理解为分布式缓存一致性)

分布式缓存的话,使用的比较多的主要是 Memcached 和 Redis。不过,现在基本没有看过还有项目使用 Memcached 来做缓存,都是直接用 Redis。

Memcached 是分布式缓存最开始兴起的那会,比较常用的。后来,随着 Redis 的发展,大家慢慢都转而使用更加强大的 Redis 了。

分布式缓存主要解决的是单机缓存的容量受服务器限制并且无法保存通用信息的问题。因为,本地缓存只在当前服务里有效,比如如果你部署了两个相同的服务,他们两者之间的缓存数据是无法共同的。

具体方案:

https://blog.csdn.net/alionsss/article/details/107451485

分布式系统相关概念,序列化在分布式系统中的应用,讲一下 thrift

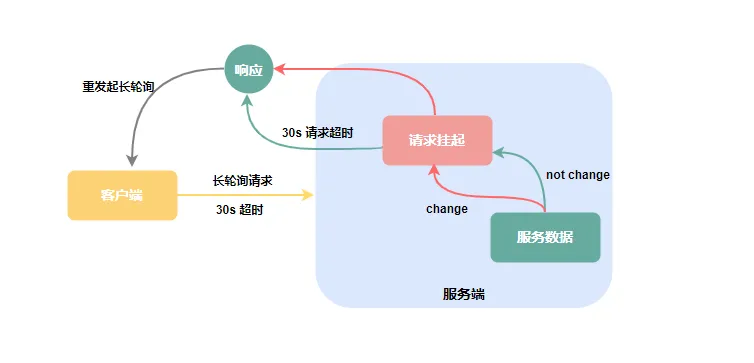

nacos作为配置中心是基于推还是拉取更新配置?这个过程用长轮询会有什么问题?

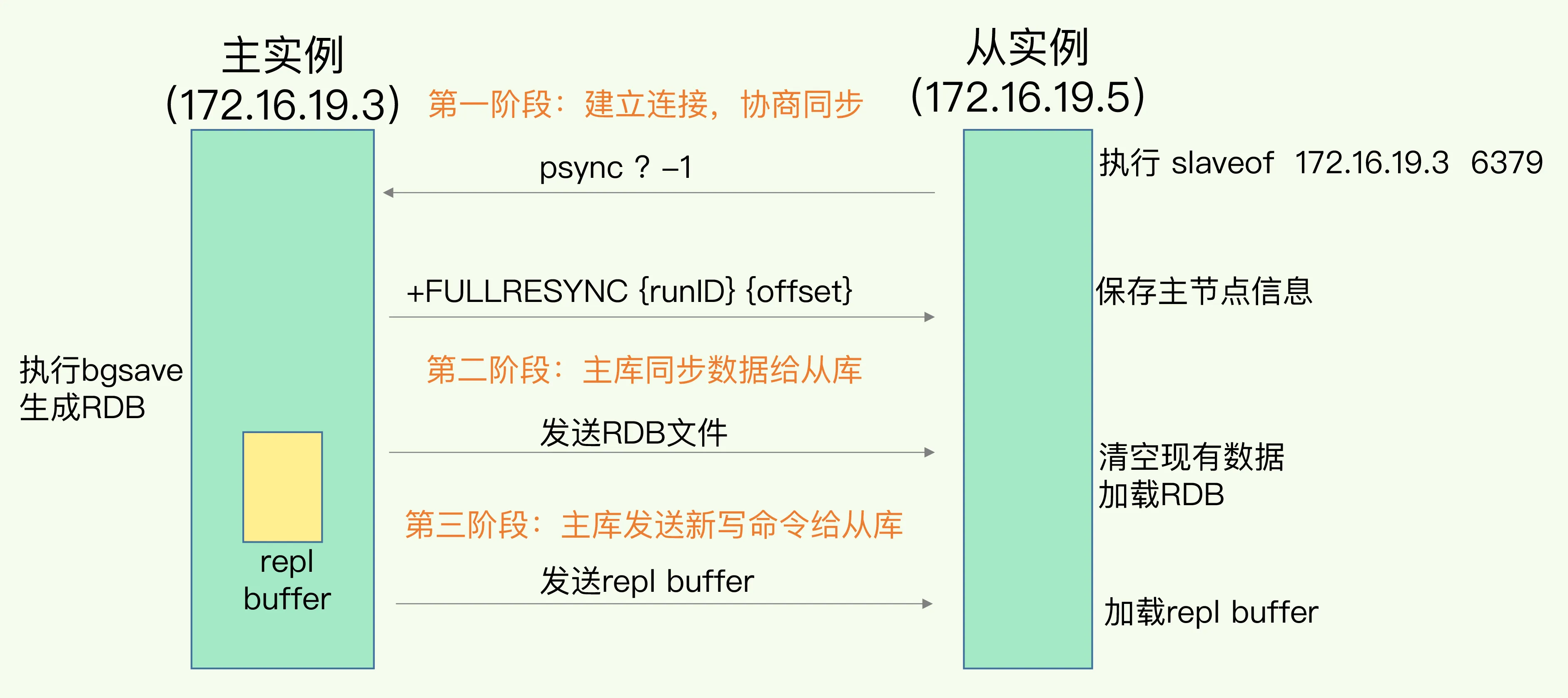

答案选自:https://developer.aliyun.com/article/785050

客户端主动拉的:客户端与服务端建立 TCP长连接,当服务端配置数据有变动,立刻通过建立的长连接将数据推送给客户端

长轮询可不是什么新技术,它不过是由服务端控制响应客户端请求的返回时间,来减少客户端无效请求的一种优化手段,其实对于客户端来说与短轮询的使用并没有本质上的区别。

客户端发起请求后,服务端不会立即返回请求结果,而是将请求挂起等待一段时间,如果此段时间内服务端数据变更,立即响应客户端请求,若是一直无变化则等到指定的超时时间后响应请求,客户端重新发起长链接。

通过@Reference注解,dubbo是怎么得到服务提供者的实例化对象?中间的过程能否简单讲一下

hystrix 工作原理

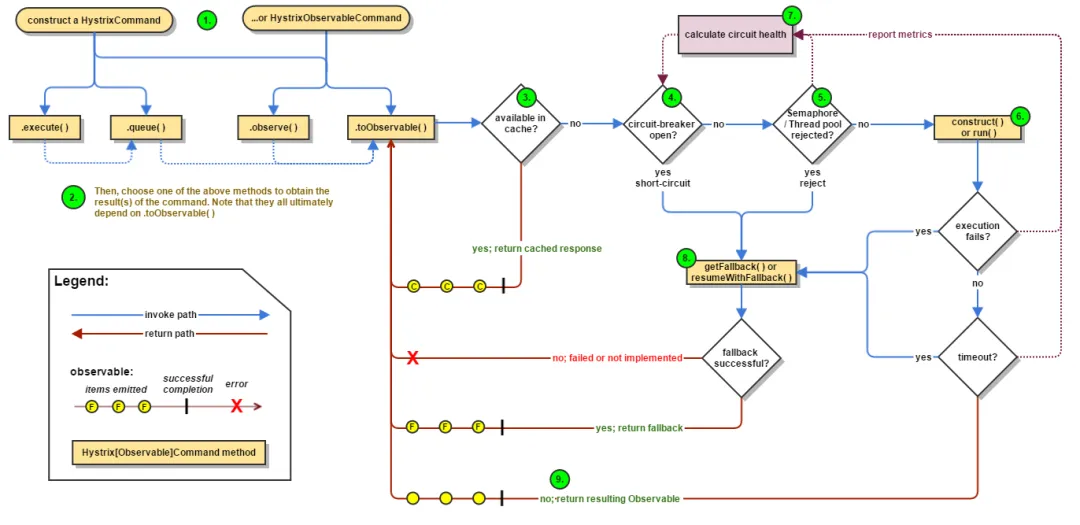

Hystrix 工作流程图如下:

构建命令

Hystrix 提供了两个命令对象:HystrixCommand和HystrixObservableCommand,它将代表你的一个依赖请求任务,向构造函数中传入请求依赖所需要的参数。

执行命令

有四种方式执行Hystrix命令。分别是:

- R execute():同步阻塞执行的,从依赖请求中接收到单个响应。

- Future queue():异步执行,返回一个包含单个响应的Future对象。

- Observable observe():创建Observable后会订阅Observable,从依赖请求中返回代表响应的Observable对象

- Observable toObservable():cold observable,返回一个Observable,只有订阅时才会执行Hystrix命令,可以返回多个结果

检查响应是否被缓存

如果启用了 Hystrix缓存,任务执行前将先判断是否有相同命令执行的缓存。如果有则直接返回包含缓存响应的Observable;如果没有缓存的结果,但启动了缓存,将缓存本次执行结果以供后续使用。

- 检查回路器是否打开 回路器(circuit-breaker)和保险丝类似,保险丝在发生危险时将会烧断以保护电路,而回路器可以在达到我们设定的阀值时触发短路(比如请求失败率达到50%),拒绝执行任何请求。

如果回路器被打开,Hystrix将不会执行命令,直接进入Fallback处理逻辑。

- 检查线程池/信号量/队列情况 Hystrix 隔离方式有线程池隔离和信号量隔离。当使用Hystrix线程池时,Hystrix 默认为每个依赖服务分配10个线程,当10个线程都繁忙时,将拒绝执行命令,,而是立即跳到执行fallback逻辑。

- 执行具体的任务 通过HystrixObservableCommand.construct() 或者 HystrixCommand.run() 来运行用户真正的任务。

- 计算回路健康情况 每次开始执行command、结束执行command以及发生异常等情况时,都会记录执行情况,例如:成功、失败、拒绝和超时等指标情况,会定期处理这些数据,再根据设定的条件来判断是否开启回路器。

- 命令失败时执行Fallback逻辑 在命令失败时执行用户指定的 Fallback 逻辑。上图中的断路、线程池拒绝、信号量拒绝、执行执行、执行超时都会进入Fallback处理。

- 返回执行结果 原始对象结果将以Observable形式返回,在返回给用户之前,会根据调用方式的不同做一些处理。

分布式id生成方案有哪些?什么是雪花算法?

分布式id生成方案主要有:

- UUID

- 数据库自增ID

- 基于雪花算法(Snowflake)实现

- 百度 (Uidgenerator)

- 美团(Leaf)

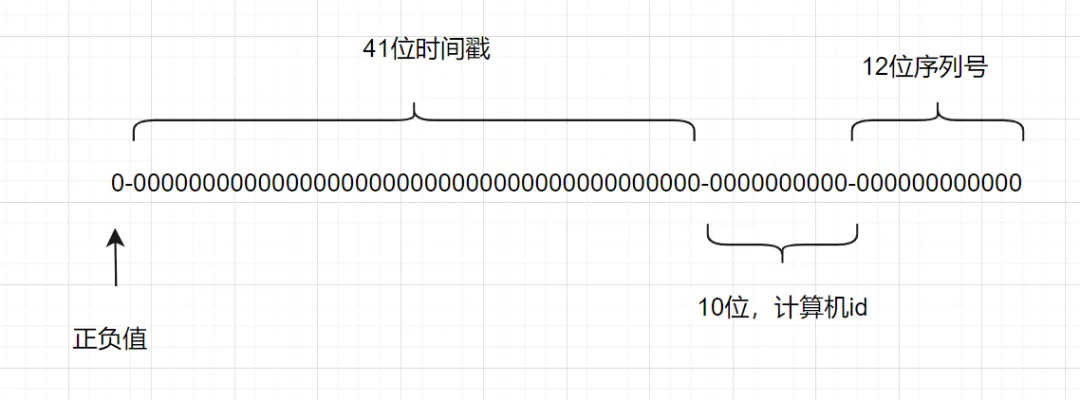

什么是雪花算法?

雪花算法是一种生成分布式全局唯一ID的算法,生成的ID称为Snowflake IDs。这种算法由Twitter创建,并用于推文的ID。

一个Snowflake ID有64位。

- 第1位:Java中long的最高位是符号位代表正负,正数是0,负数是1,一般生成ID都为正数,所以默认为0。

- 接下来前41位是时间戳,表示了自选定的时期以来的毫秒数。

- 接下来的10位代表计算机ID,防止冲突。

- 其余12位代表每台机器上生成ID的序列号,这允许在同一毫秒内创建多个Snowflake ID。

分布式锁方案(MySQL到redlock),讨论锁续期,GC影响 (2022字节番茄)

数据库

基于数据库表(锁表,很少使用)

最简单的方式可能就是直接创建一张锁表,然后通过操作该表中的数据来实现了。当我们想要获得锁的时候,就可以在该表中增加一条记录,想要释放锁的时候就删除这条记录。

为了更好的演示,我们先创建一张数据库表,参考如下:

CREATE TABLE database_lock (

`id` BIGINT NOT NULL AUTO_INCREMENT,

`resource` int NOT NULL COMMENT '锁定的资源',

`description` varchar(1024) NOT NULL DEFAULT "" COMMENT '描述',

PRIMARY KEY (id),

UNIQUE KEY uiq_idx_resource (resource)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COMMENT='数据库分布式锁表';

当我们想要获得锁时,可以插入一条数据:

INSERT INTO database_lock(resource, description) VALUES (1, 'lock');

当需要释放锁的时,可以删除这条数据:

DELETE FROM database_lock WHERE resource=1;

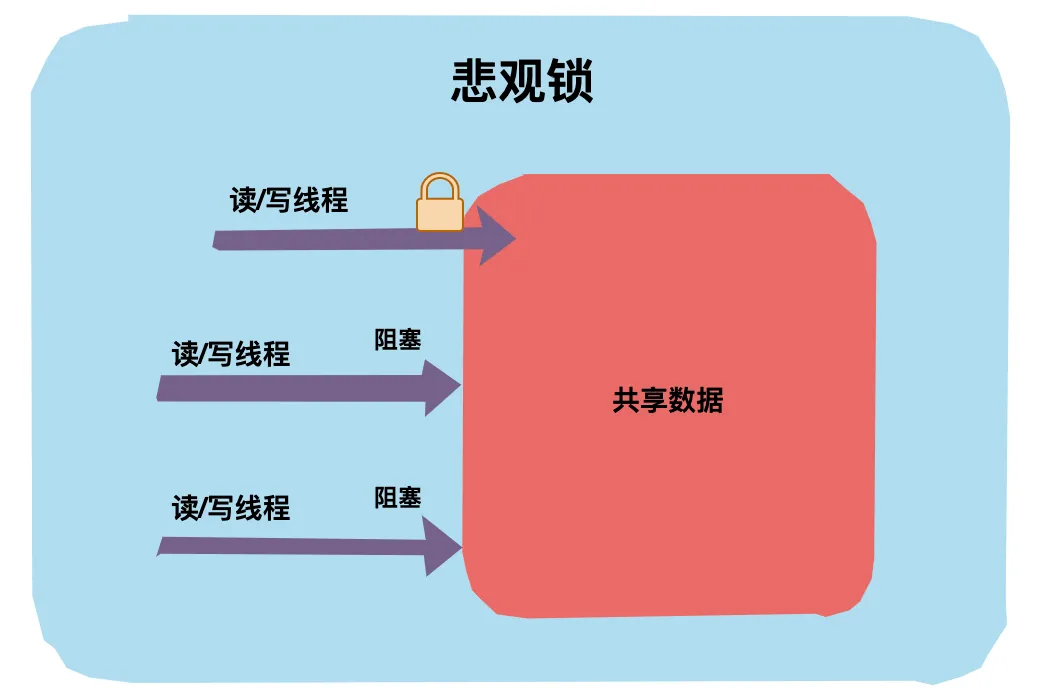

基于悲观锁

在对任意记录进行修改前,先尝试为该记录加上排他锁(exclusive locking)。

如果加锁失败,说明该记录正在被修改,那么当前查询可能要等待或者抛出异常。 具体响应方式由开发者根据实际需要决定。

如果成功加锁,那么就可以对记录做修改,事务完成后就会解锁了。

其间如果有其他对该记录做修改或加排他锁的操作,都会等待我们解锁或直接抛出异常。

要使用悲观锁,我们必须关闭mysql数据库的自动提交属性,因为MySQL默认使用autocommit模式,也就是说,当你执行一个更新操作后,MySQL会立刻将结果进行提交。set autocommit=0;

//0.开始事务

begin;/begin work;/start transaction; (三者选一就可以)

//1.查询出商品信息

select status from t_goods where id=1 for update;

//2.根据商品信息生成订单

insert into t_orders (id,goods_id) values (null,1);

//3.修改商品status为2

update t_goods set status=2;

//4.提交事务

commit;/commit work;

上面的查询语句中,我们使用了select…for update的方式,这样就通过开启排他锁的方式实现了悲观锁。此时在t_goods表中,id为1的 那条数据就被我们锁定了,其它的事务必须等本次事务提交之后才能执行。这样我们可以保证当前的数据不会被其它事务修改。

上面我们提到,使用select…for update会把数据给锁住,不过我们需要注意一些锁的级别,MySQL InnoDB默认行级锁。行级锁都是基于索引的,如果一条SQL语句用不到索引是不会使用行级锁的,会使用表级锁把整张表锁住,这点需要注意。

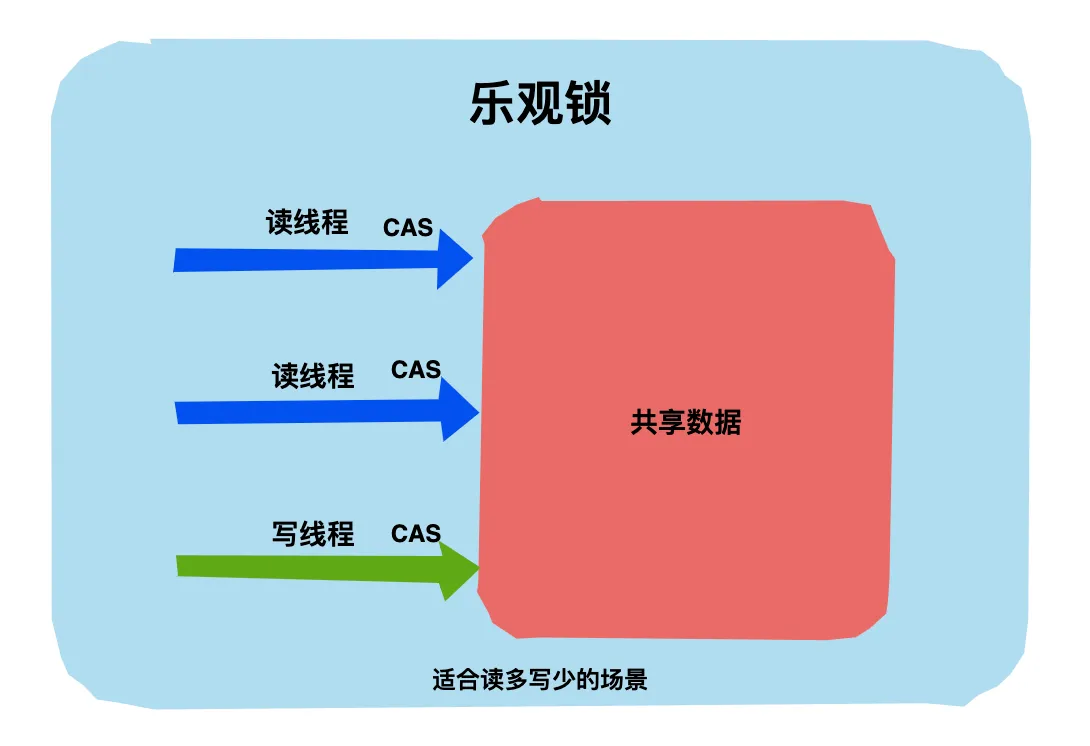

基于乐观锁

乐观并发控制(又名“乐观锁”,Optimistic Concurrency Control,缩写“OCC”)是一种并发控制的方法。它假设多用户并发的事务在处理时不会彼此互相影响,各事务能够在不产生锁的情况下处理各自影响的那部分数据。在提交数据更新之前,每个事务会先检查在该事务读取数据后,有没有其他事务又修改了该数据。如果其他事务有更新的话,正在提交的事务会进行回滚。

使用版本号时,可以在数据初始化时指定一个版本号,每次对数据的更新操作都对版本号执行+1操作。并判断当前版本号是不是该数据的最新的版本号。

1.查询出商品信息

select (status,status,version) from t_goods where id=#{id}

2.根据商品信息生成订单

3.修改商品status为2

update t_goods

set status=2,version=version+1

where id=#{id} and version=#{version};

需要注意的是,乐观锁机制往往基于系统中数据存储逻辑,因此也具备一定的局限性。由于乐观锁机制是在我们的系统中实现的,对于来自外部系统的用户数据更新操作不受我们系统的控制,因此可能会造成脏数据被更新到数据库中。在系统设计阶段,我们应该充分考虑到这些情况,并进行相应的调整(如将乐观锁策略在数据库存储过程中实现,对外只开放基于此存储过程的数据更新途径,而不是将数据库表直接对外公开)

redis

set NX PX + Lua

加锁: set NX PX + 重试 + 重试间隔

向Redis发起如下命令: SET productId:lock 0xx9p03001 NX PX 30000 其中,"productId"由自己定义,可以是与本次业务有关的id,"0xx9p03001"是一串随机值,必须保证全局唯一(原因在后文中会提到),“NX"指的是当且仅当key(也就是案例中的"productId:lock”)在Redis中不存在时,返回执行成功,否则执行失败。"PX 30000"指的是在30秒后,key将被自动删除。执行命令后返回成功,表明服务成功的获得了锁。

@Override

public boolean lock(String key, long expire, int retryTimes, long retryDuration) {

// use JedisCommands instead of setIfAbsense

boolean result = setRedis(key, expire);

// retry if needed

while ((!result) && retryTimes-- > 0) {

try {

log.debug("lock failed, retrying..." + retryTimes);

Thread.sleep(retryDuration);

} catch (Exception e) {

return false;

}

// use JedisCommands instead of setIfAbsense

result = setRedis(key, expire);

}

return result;

}

private boolean setRedis(String key, long expire) {

try {

RedisCallback<String> redisCallback = connection -> {

JedisCommands commands = (JedisCommands) connection.getNativeConnection();

String uuid = SnowIDUtil.uniqueStr();

lockFlag.set(uuid);

return commands.set(key, uuid, NX, PX, expire); // 看这里

};

String result = redisTemplate.execute(redisCallback);

return !StringUtil.isEmpty(result);

} catch (Exception e) {

log.error("set redis occurred an exception", e);

}

return false;

}

解锁:采用lua脚本

在删除key之前,一定要判断服务A持有的value与Redis内存储的value是否一致。如果贸然使用服务A持有的key来删除锁,则会误将服务B的锁释放掉。

if redis.call("get", KEYS[1])==ARGV[1] then

return redis.call("del", KEYS[1])

else

return 0

end

基于RedLock实现分布式锁

这是Redis作者推荐的分布式集群情况下的方式,请看这篇文章Is Redlock safe? (opens new window)

假设有两个服务A、B都希望获得锁,有一个包含了5个redis master的Redis Cluster,执行过程大致如下:

- 客户端获取当前时间戳,单位: 毫秒

- 服务A轮寻每个master节点,尝试创建锁。(这里锁的过期时间比较短,一般就几十毫秒) RedLock算法会尝试在大多数节点上分别创建锁,假如节点总数为n,那么大多数节点指的是n/2+1。

- 客户端计算成功建立完锁的时间,如果建锁时间小于超时时间,就可以判定锁创建成功。如果锁创建失败,则依次(遍历master节点)删除锁。

- 只要有其它服务创建过分布式锁,那么当前服务就必须轮寻尝试获取锁。

基于Redis的客户端

这里Redis的客户端(Jedis, Redisson, Lettuce等)都是基于上述两类形式来实现分布式锁的,只是两类形式的封装以及一些优化(比如Redisson的watch dog)。

以基于Redisson实现分布式锁为例(支持了 单实例、Redis哨兵、redis cluster、redis master-slave等各种部署架构):

特色?

- redisson所有指令都通过lua脚本执行,保证了操作的原子性

- redisson设置了watchdog看门狗,“看门狗”的逻辑保证了没有死锁发生

- redisson支持Redlock的实现方式。

过程?

- 线程去获取锁,获取成功: 执行lua脚本,保存数据到redis数据库。

- 线程去获取锁,获取失败: 订阅了解锁消息,然后再尝试获取锁,获取成功后,执行lua脚本,保存数据到redis数据库。

互斥?

如果这个时候客户端B来尝试加锁,执行了同样的一段lua脚本。第一个if判断会执行“exists myLock”,发现myLock这个锁key已经存在。接着第二个if判断,判断myLock锁key的hash数据结构中,是否包含客户端B的ID,但明显没有,那么客户端B会获取到pttl myLock返回的一个数字,代表myLock这个锁key的剩余生存时间。此时客户端B会进入一个while循环,不听的尝试加锁。

watch dog自动延时机制?

客户端A加锁的锁key默认生存时间只有30秒,如果超过了30秒,客户端A还想一直持有这把锁,怎么办?其实只要客户端A一旦加锁成功,就会启动一个watch dog看门狗,它是一个后台线程,会每隔10秒检查一下,如果客户端A还持有锁key,那么就会不断的延长锁key的生存时间。

可重入?

每次lock会调用incrby,每次unlock会减一。

进一步理解

- 借助Redis实现分布式锁时,有一个共同的缺陷: 当获取锁被拒绝后,需要不断的循环,重新发送获取锁(创建key)的请求,直到请求成功。这就造成空转,浪费宝贵的CPU资源。

- RedLock算法本身有争议,具体看这篇文章How to do distributed locking (opens new window) 以及作者的回复Is Redlock safe?

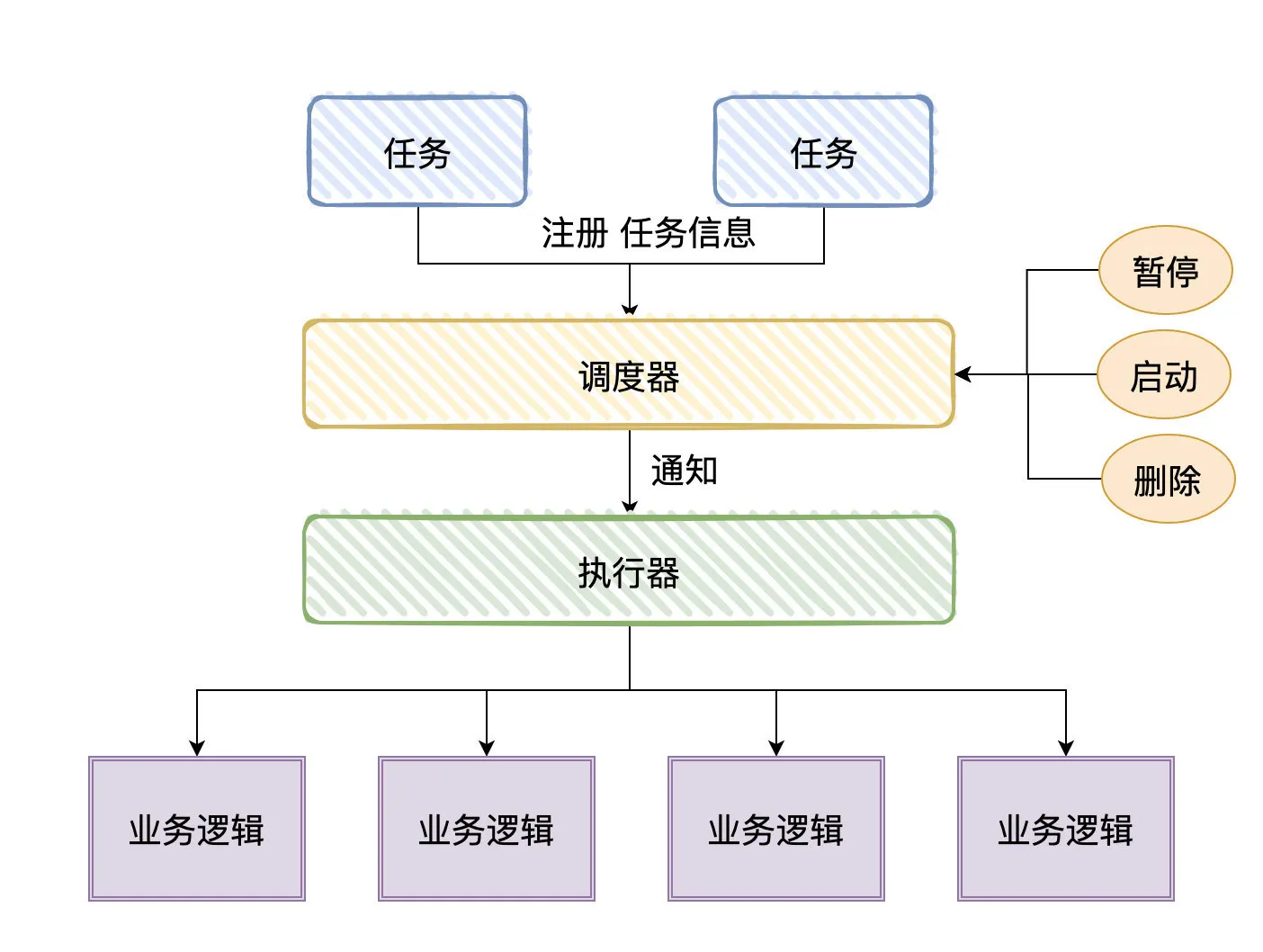

怎么用的分布式定时任务,为什么用

Timer/ScheduledExecutorService/SpringTask(@Schedule)都是单机的,但我们一旦上了生产环境,应用部署往往都是集群模式的。

在集群下,我们一般是希望某个定时任务只在某台机器上执行,那这时候,单机实现的定时任务就不太好处理了。

Quartz是有集群部署方案的,所以有的人会利用数据库行锁或者使用Redis分布式锁来自己实现定时任务跑在某一台应用机器上;做肯定是能做的,包括有些挺出名的分布式定时任务框架也是这样做的,能解决问题。

但我们遇到的问题不单单只有这些,比如我想要支持容错功能(失败重试)、分片功能、手动触发一次任务、有一个比较好的管理定时任务的后台界面、路由负载均衡等等。这些功能,就是作为「分布式定时任务框架」所具备的。

既然现在已经有这么多的轮子了,那我们作为使用方/需求方就没必要自己重新实现一套了,用现有的就好了,我们可以学习现有轮子的实现设计思想。

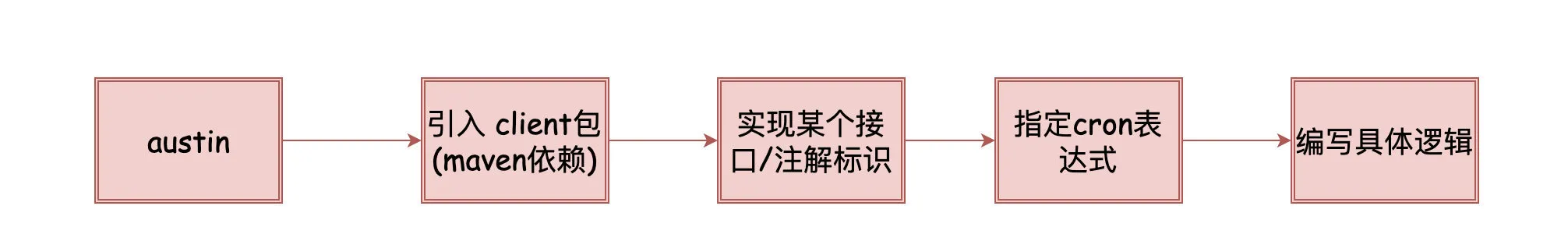

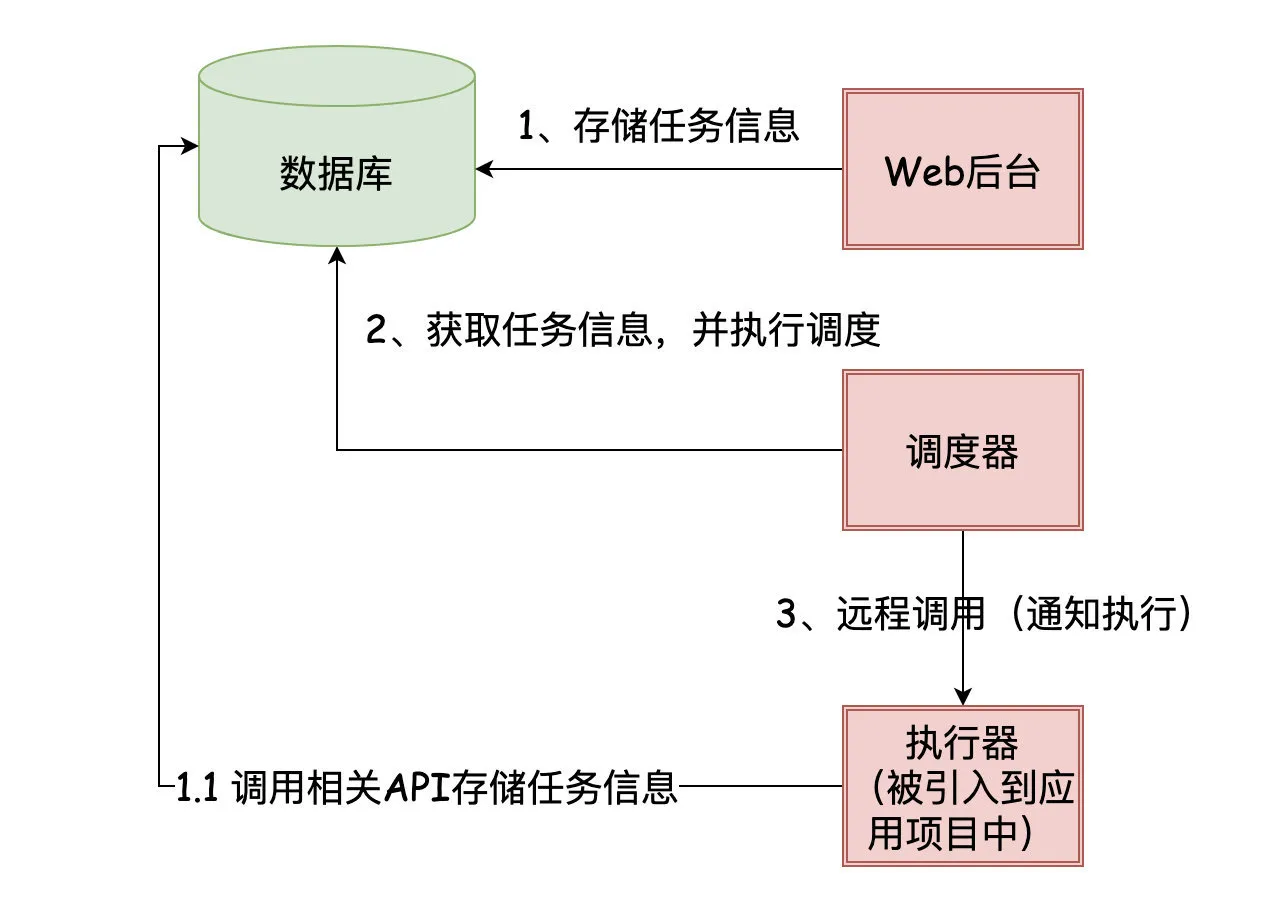

分布式定时任务基础

Quartz是优秀的开源组件,它将定时任务抽象了三个角色:调度器、执行器和任务,以至于市面上的分布式定时任务框架都有类似角色划分。

对于我们使用方而言,一般是引入一个client包,然后根据它的规则(可能是使用注解标识,又或是实现某个接口),随后自定义我们自己的定时任务逻辑。

看着上面的执行图对应的角色抽象以及一般使用姿势,应该还是比较容易理解这个过程的。我们又可以再稍微思考两个问题:

1、 任务信息以及调度的信息是需要存储的,存储在哪?调度器是需要「通知」执行器去执行的,那「通知」是以什么方式去做?

2、调度器是怎么找到即将需要执行的任务的呢?

针对第一个问题,分布式定时任务框架又可以分成了两个流派:中心化和去中心化

- 所谓的「中心化」指的是:调度器和执行器分离,调度器统一进行调度,通知执行器去执行定时任务

- 所谓的「去中心化」指的是:调度器和执行器耦合,自己调度自己执行

对于「中心化」流派来说,存储相关的信息很可能是在数据库(DataBase),而我们引入的client包实际上就是执行器相关的代码。调度器实现了任务调度的逻辑,远程调用执行器触发对应的逻辑。

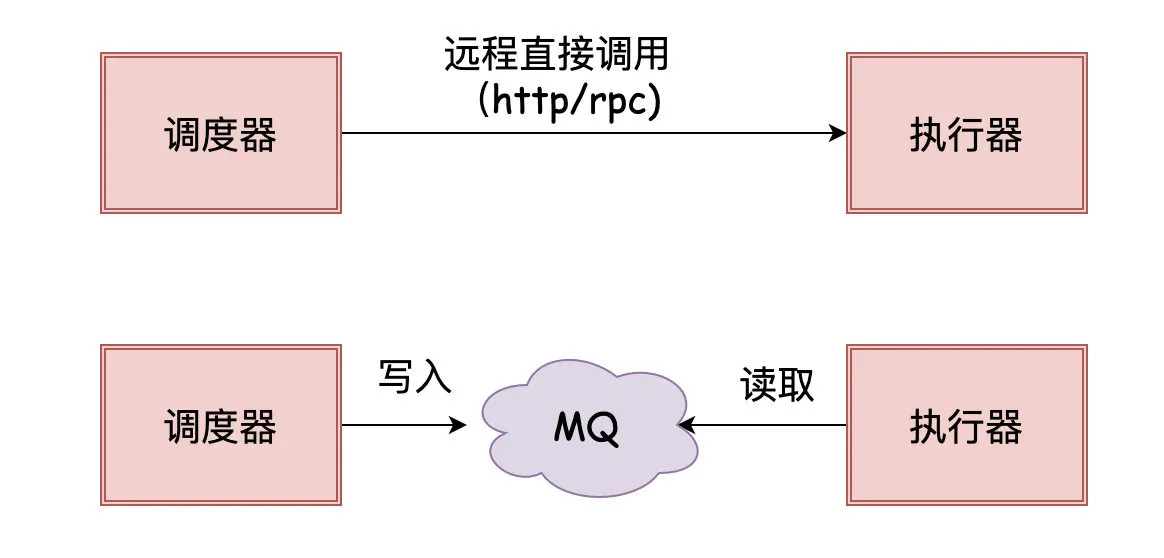

调度器「通知」执行器去执行任务时,可以是通过「RPC」调用,也可以是把任务信息写入消息队列给执行器消费来达到目的。

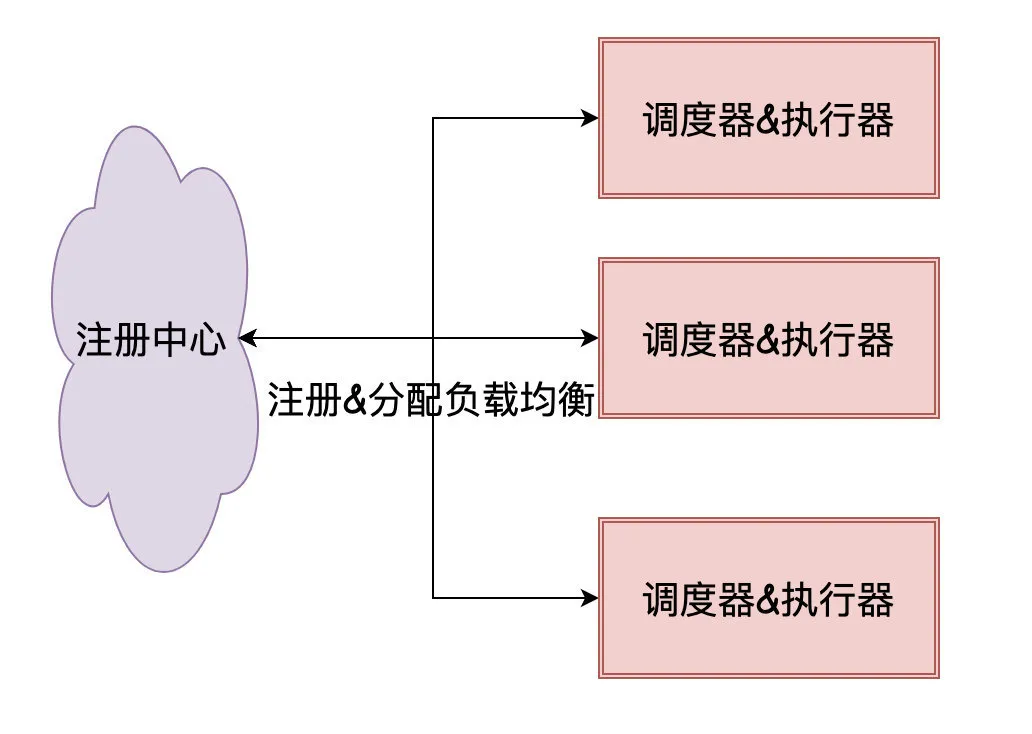

对于「去中心化」流派来说存储相关的信息很可能是在注册中心(Zookeeper),而我们引入的client包实际上就是执行器+调度器相关的代码。

依赖注册中心来完成任务的分配,「中心化」流派在调度的时候是需要保证一个任务只被一台机器消费,这就需要在代码里写分布式锁相关逻辑进行保证,而「去中心化」依赖注册中心就免去了这个环节。

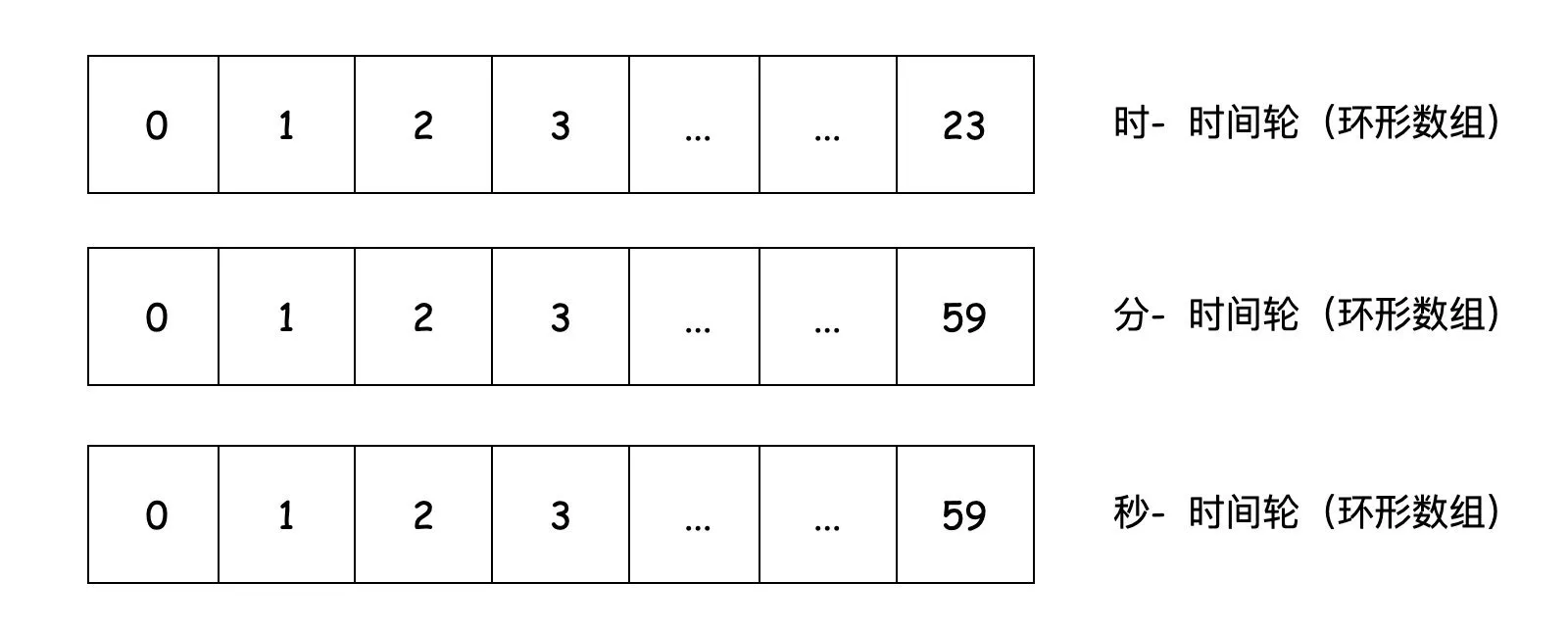

针对第二个问题,调度器是怎么找到即将需要执行的任务的呢?现在一般较新的分布式定时任务框架都用了「时间轮」。

1、如果我们日常要找到准备要执行的任务,可能会把这些任务放在一个List里然后进行判断,那此时查询的时间复杂度为O(n)

2、稍微改进下,我们可能把这些任务放在一个最小堆里(对时间进行排序),那此时的增删改时间复杂度为O(logn),而查询是O(1)

3、再改进下,我们把这些任务放在一个环形数组里,那这时候的增删改查时间复杂度都是O(1)。但此时的环形数组大小决定着我们能存放任务的大小,超出环形数组的任务就需要用另外的数组结构存放。

4、最后再改进下,我们可以有多层环形数组,不同层次的环形数组的精度是不一样的,使用多层环形数组能大大提高我们的精度。

分布式定时任务框架选型

分布式定时任务框架现在可选择的还是挺多的,比较出名的有:XXL-JOB/Elastic-Job/LTS/SchedulerX/Saturn/PowerJob等等等。有条件的公司可能会基于Quartz进行拓展,自研一套符合自己的公司内的分布式定时任务框架。

我并不是做这块出身的,对于我而言,我的austin项目技术选型主要会关注两块(其实跟选择apollo作为分布式配置中心的理由是一样的):成熟、稳定、社区是否活跃。

这一次我选择了xxl-job作为austin的分布式任务调度框架。xxl-job已经有很多公司都已经接入了(说明他的开箱即用还是很到位的)。不过最新的一个版本在2021-02,近一年没有比较大的更新了。

分布式任务调度平台XXL-JOB (xuxueli.com)

♻️虚拟机

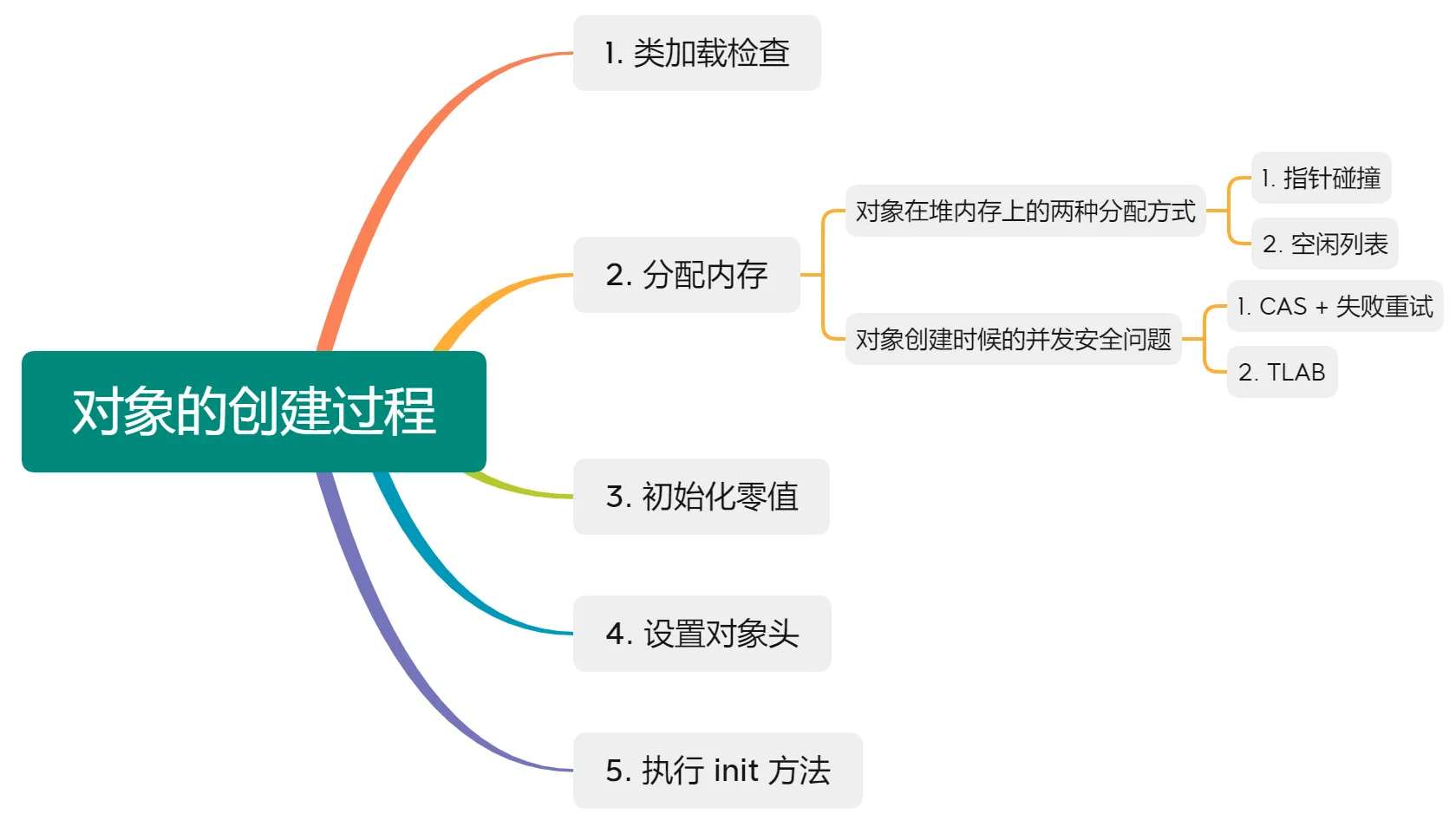

对象创建过程(2022蔚来提前批)

类加载检查

对象创建过程的第一步,所谓类加载检查,就是检测我们接下来要 new 出来的这个对象所属的类是否已经被 JVM 成功加载、解析和初始化过了(具体的类加载过程会在后续文章详细解释~)

具体来说,当 Java 虚拟机遇到一条字节码 new 指令时:

1)首先检查根据 class 文件中的常量池表(Constant Pool Table)能否找到这个类对应的符号引用

此处可以回顾一波常量池表 (Constant Pool Table) 的概念:

用于存放编译期生成的各种字面量(字面量相当于 Java 语言层面常量的概念,如文本字符串,声明为 final 的常量值等)与符号引用。有一些文章会把 class 常量池表称为静态常量池。

都是常量池,常量池表和方法区中的运行时常量池有啥关系吗?运行时常量池是干嘛的呢?

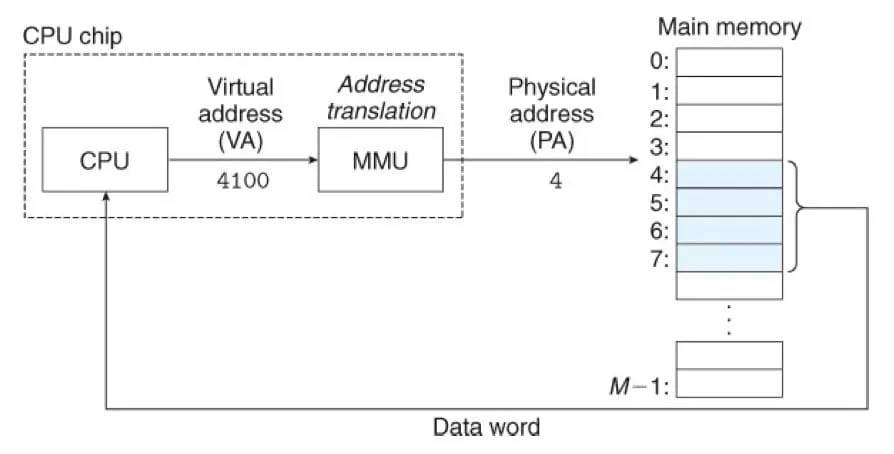

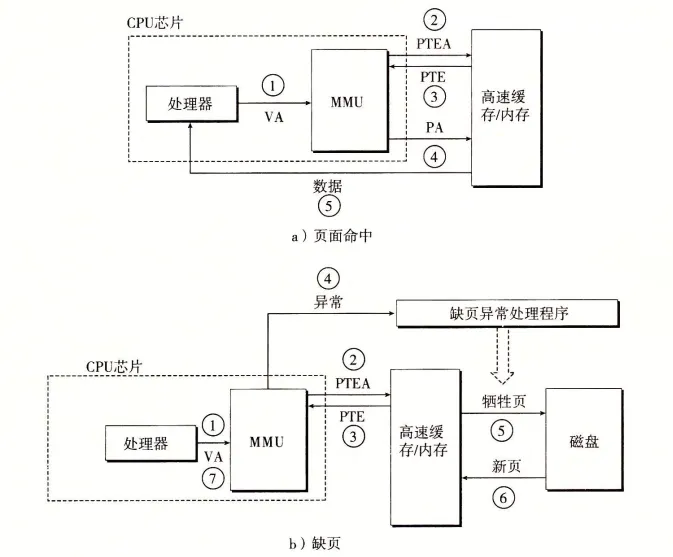

运行时常量池可以在运行期间将 class 常量池表中的符号引用解析为直接引用。简单来说,class 常量池表就相当于一堆索引,运行时常量池根据这些索引来查找对应方法或字段所属的类型信息和名称及描述符信息

2)然后去方法区中的运行时常量池中查找该符号引用所指向的类是否已被 JVM 加载、解析和初始化过

- 如果没有,那就先执行相应的类加载过程

- 如果有,那么进入下一步,为新生对象分配内存

分配内存

类加载检查通过后,这个对象待会儿要是被创建出来得有地方放他对吧?

所以接下来 JVM 会为新生对象分配内存空间。

至于 JVM 怎么知道这个空间得分配多大呢?事实上,对象所需内存的大小在类加载完成后就已经可以完全确定了。

HotSpot虚拟机是一种Java虚拟机(JVM),它是Oracle JDK中默认的JVM。 在 Hotspot 虚拟机中,对象在内存中的布局可以分为 3 块区域:对象头、实例数据和对齐填充。

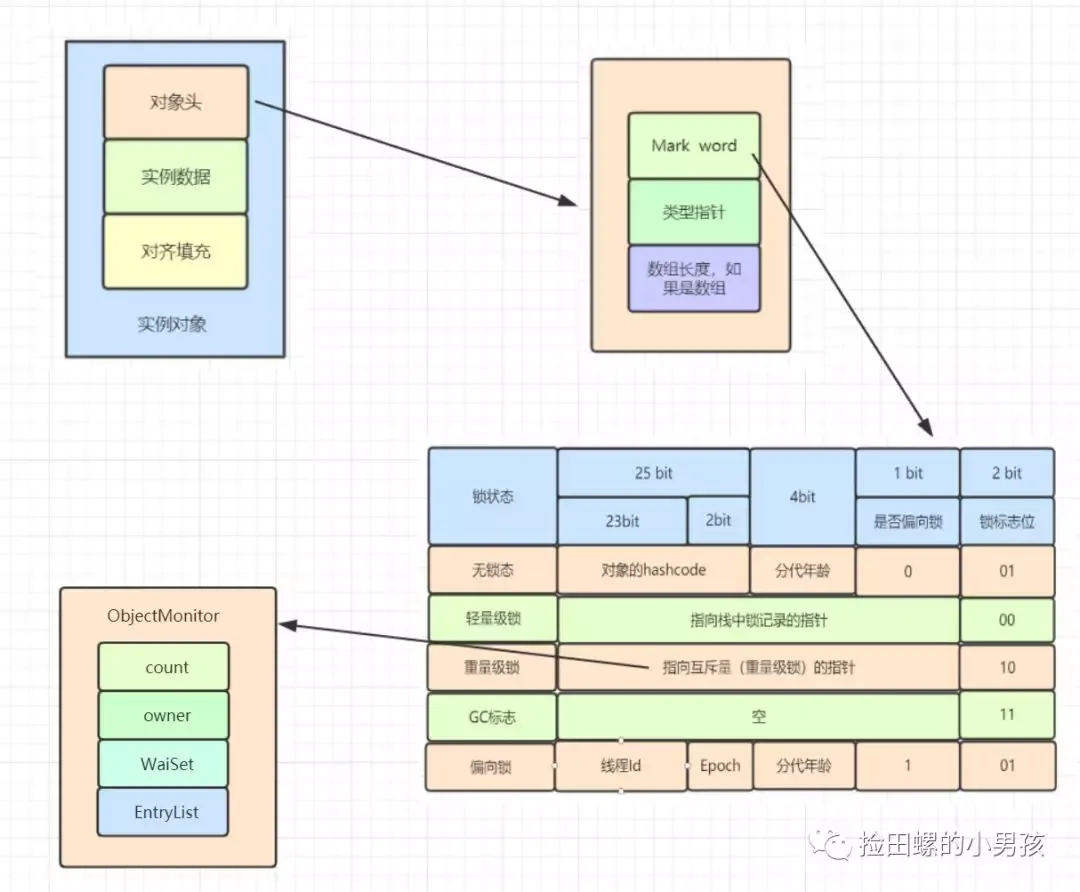

1)Hotspot 虚拟机的对象头包括两部分信息:

- 第一部分用于存储对象自身的运行时数据(如哈希码(HashCode)、GC 分代年龄、锁状态标志、线程持有的锁、偏向线程 ID、偏向时间戳等,这部分数据的长度在 32 位和 64 位的虚拟机(未开启压缩指针)中分别为 32 个比特和 64 个比特,官方称它为 “Mark Word”。学过 synchronized 的小伙伴对这个一定不陌生~)

- 另一部分是类型指针,即对象指向它的类型元数据的指针,虚拟机通过这个指针来确定这个对象是哪个类的实例

2)实例数据部分存储的是这个对象真正的有效信息,即我们在程序代码里面所定义的各种类型的字段内容,无论是从父类继承下来的,还是在子类中定义的字段都必须记录起来。

3)对齐填充部分不是必须的,也没有什么特别的含义,仅仅起占位作用。 因为 Hotspot 虚拟机的自动内存管理系统要求对象起始地址必须是 8 字节的整数倍,换句话说就是对象的大小必须是 8 字节的整数倍。而对象头部分正好是 8 字节的倍数(1 倍或 2 倍),因此,当对象实例数据部分没有对齐时,就需要通过对齐填充来补全。

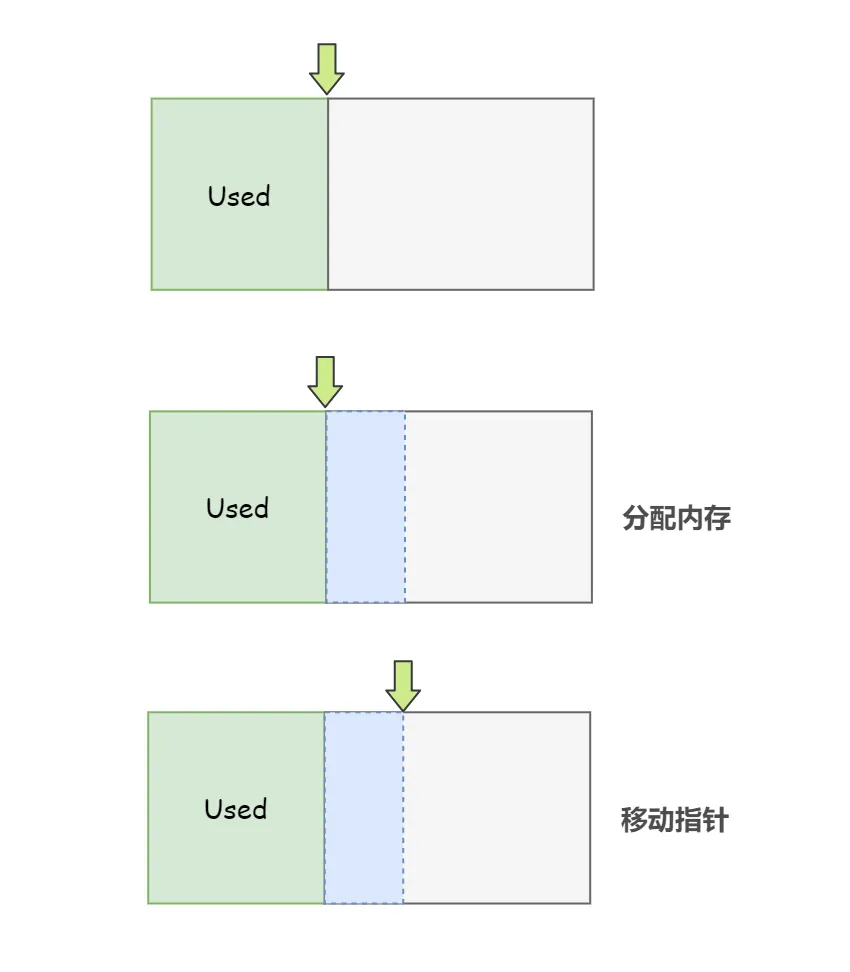

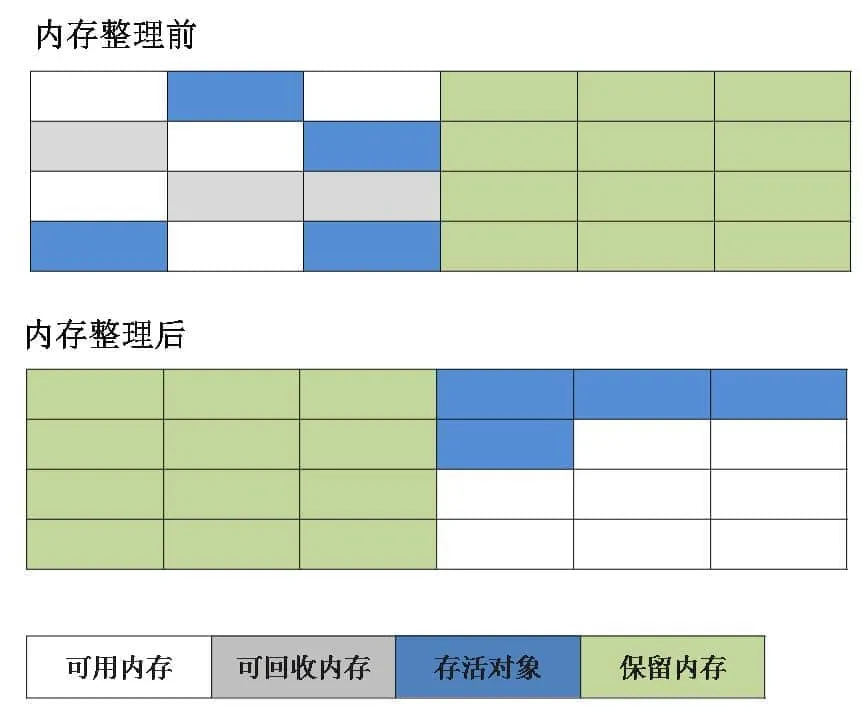

对象在堆上的两种分配方式

为对象分配内存空间的任务通俗来说把一块确定大小的内存块从 Java 堆中划分出来给这个对象用。

根据堆中的内存是否规整,有两种划分方式,或者说对象在堆上的分配有两种方式:

1)假设 Java 堆中内存是绝对规整的,所有被使用过的内存都被放在一边,空闲的内存被放在另一边,中间放着一个指针作为分界点的指示器,那所分配内存就仅仅是把这个指针 向 空闲空间方向 挪动一段与对象大小相等的距离,这种分配方式称为 指针碰撞(Bump The Pointer)

2)如果 Java 堆中的内存并不是规整的,已被使用的内存和空闲的内存相互交错在一起,那就没有办法简单地进行指针碰撞了,虚拟机就必须维护一个列表,记录哪些内存块是可用的,在分配的时候从列表中找到一块足够大的连续空间划分给这个对象,并更新列表上的记录,这种分配方式称为 空闲列表(Free List)。

选择哪种分配方式由 Java 堆是否规整决定,那又有同学会问了,堆是否规整又由谁来决定呢?

Java 堆是否规整由所采用的垃圾收集器是否带有空间压缩整理(Compact)的能力决定的(或者说由垃圾收集器采用的垃圾收集算法来决定的,具体垃圾收集算法见后续文章):

- 因此,当使用 Serial、ParNew 等带压缩整理过程的收集器时,系统采用的分配算法是指针碰撞,既简单又高效

- 而当使用 CMS 这种基于清除(Sweep)算法的收集器时,理论上就只能采用较为复杂的空闲列表来分配内存

对象创建时候的并发安全问题

另外,在为对象创建内存的时候,还需要考虑一个问题:并发安全问题。

对象创建在虚拟机中是非常频繁的行为,以上面介绍的指针碰撞法为例,即使只修改一个指针所指向的位置,在并发情况下也并不是线程安全的,可能出现某个线程正在给对象 A 分配内存,指针还没来得及修改,另一个线程创建了对象 B 又同时使用了原来的指针来分配内存的情况。

解决这个问题有两种可选方案:

- 方案 1:CAS + 失败重试:CAS 大伙应该都熟悉,比较并交换,乐观锁方案,如果失败就重试,直到成功为止

- 方案 2:本地线程分配缓冲(Thread Local Allocation Buffer,

TLAB):每个线程在堆中预先分配一小块内存,每个线程拥有的这一小块内存就称为 TLAB。哪个线程要分配内存了,就在哪个线程的 TLAB 中进行分配,这样各个线程之间互不干扰。如果某个线程的 TLAB 用完了,那么虚拟机就需要为它分配新的 TLAB,这时才需要进行同步锁定。可以通过-XX:+/-UseTLAB参数来设定是否使用 TLAB。

初始化零值

内存分配完成之后,JVM 会将分配到的内存空间都初始化为零值,比如 boolean 字段都初始化为 false 啊,int 字段都初始化为 0 啊之类的

这步操作保证了对象的实例字段在 Java 代码中可以不赋初始值就直接使用,使程序能访问到这些字段的数据类型所对应的零值。

如果使用了 TLAB 的话,初始化零值这项工作可以提前至 TLAB 分配时就顺便进行了

设置对象头

上面我们说过,对象在内存中的布局可以分为 3 块区域:对象头(Object Header)、实例数据和对齐填充

对齐填充并不是什么有意义的数据,实例数据我们在上一步操作中进行了初始化零值,那么对于剩下的对象头中的信息来说,自然不必多说,也是要进行一些赋值操作的:例如这个对象是哪个类的实例、如何才能找到类的元数据信息、对象的哈希码、对象的 GC 分代年龄等信息。根据虚拟机当前运行状态的不同,如是否启用偏向锁等,对象头会有不同的设置方式。

执行 init 方法

上面四个步骤都走完之后,从 JVM 的视角来看,其实一个新的对象已经成功诞生了。

但是从我们程序员的视角来看,这个对象确实是创建出来了,但是还没按照我们定义的构造函数来进行赋值呢,所有的字段都还是默认的零值啊。

构造函数即 Class 文件中的 <init>() 方法,一般来说,new 指令之后会接着执行 <init>() 方法,按照构造函数的意图对这个对象进行初始化,这样一个真正可用的对象才算完全地被构造出来了,皆大欢喜。

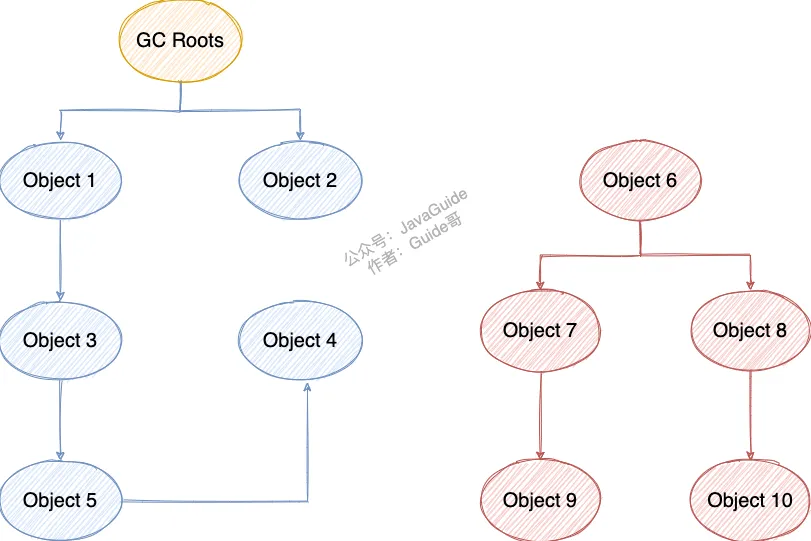

垃圾的判断方法,引用计数法为什么用的没有GCRoot的多,缺点是什么,为什么(2022番茄小说)

引用计数法

给对象中添加一个引用计数器:

- 每当有一个地方引用它,计数器就加 1;

- 当引用失效,计数器就减 1;

- 任何时候计数器为 0 的对象就是不可能再被使用的。

这个方法实现简单,效率高,但是目前主流的虚拟机中并没有选择这个算法来管理内存,其最主要的原因是它很难解决对象之间相互循环引用的问题。

所谓对象之间的相互引用问题,如下面代码所示:除了对象 objA 和 objB 相互引用着对方之外,这两个对象之间再无任何引用。但是他们因为互相引用对方,导致它们的引用计数器都不为 0,于是引用计数算法无法通知 GC 回收器回收他们。

public class ReferenceCountingGc {

Object instance = null;

public static void main(String[] args) {

ReferenceCountingGc objA = new ReferenceCountingGc();

ReferenceCountingGc objB = new ReferenceCountingGc();

objA.instance = objB;

objB.instance = objA;

objA = null;

objB = null;

}

}

可达性分析算法

这个算法的基本思想就是通过一系列的称为 “GC Roots” 的对象作为起点,从这些节点开始向下搜索,节点所走过的路径称为引用链,当一个对象到 GC Roots 没有任何引用链相连的话,则证明此对象是不可用的,需要被回收。

下图中的 Object 6 ~ Object 10 之间虽有引用关系,但它们到 GC Roots 不可达,因此为需要被回收的对象。

哪些对象可以作为 GC Roots 呢?

- 虚拟机栈(栈帧中的本地变量表)中引用的对象

- 本地方法栈(Native 方法)中引用的对象

- 方法区中类静态属性引用的对象

- 方法区中常量引用的对象

- 所有被同步锁持有的对象

对象可以被回收,就代表一定会被回收吗?

即使在可达性分析法中不可达的对象,也并非是“非死不可”的,这时候它们暂时处于“缓刑阶段”,要真正宣告一个对象死亡,至少要经历两次标记过程;可达性分析法中不可达的对象被第一次标记并且进行一次筛选,筛选的条件是此对象是否有必要执行 finalize 方法。当对象没有覆盖 finalize 方法,或 finalize 方法已经被虚拟机调用过时,虚拟机将这两种情况视为没有必要执行。

被判定为需要执行的对象将会被放在一个队列中进行第二次标记,除非这个对象与引用链上的任何一个对象建立关联,否则就会被真的回收。

Object类中的finalize方法一直被认为是一个糟糕的设计,成为了 Java 语言的负担,影响了 Java 语言的安全和 GC 的性能。JDK9 版本及后续版本中各个类中的finalize方法会被逐渐弃用移除。忘掉它的存在吧!

什么时候会OOM,服务OOM怎么办,如何排查(2022 美团)

系统稳定性——OutOfMemoryError 常见原因及解决方法

Java static 变量存在 JVM 哪个区域和生命周期

Static:

- 加载:java虚拟机在加载类的过程中为静态变量分配内存。

- 类变量:static变量在内存中只有一个,存放在方法区,属于类变量,被所有实例所共享

- 销毁:类被卸载时,静态变量被销毁,并释放内存空间。static变量的生命周期取决于类的生命周期

类初始化顺序:

- 静态变量、静态代码块初始化

- 构造函数

- 自定义构造函数

结论:想要用static存一个变量,使得下次程序运行时还能使用上次的值是不可行的。因为静态变量生命周期虽然长(就是类的生命周期),但是当程序执行完,也就是该类的所有对象都已经被回收,或者加载类的ClassLoader已经被回收,那么该类就会从jvm的方法区卸载,即生命期终止。

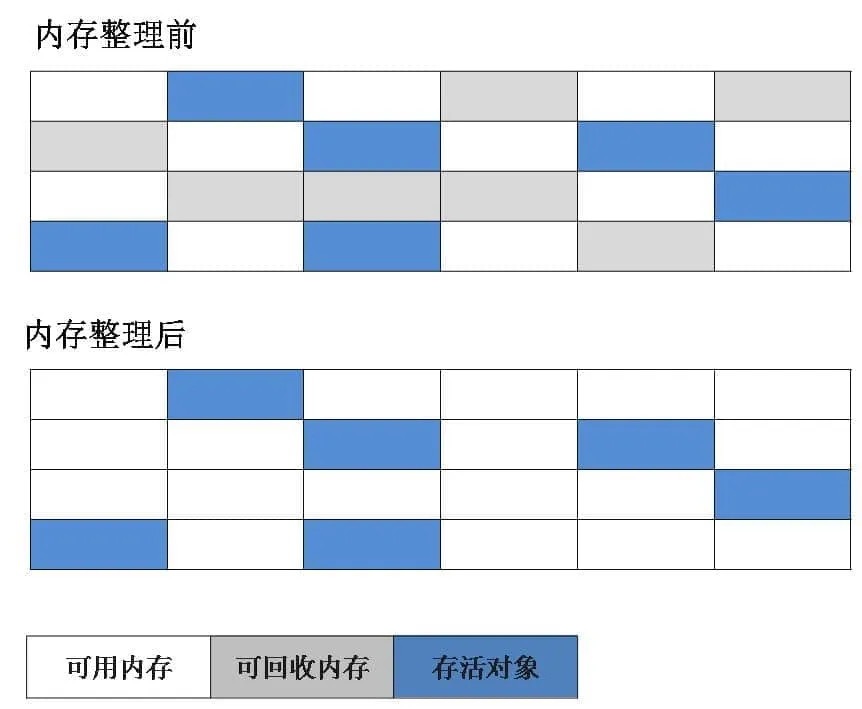

GC 的几种算法(2022携程,2022番茄小说)

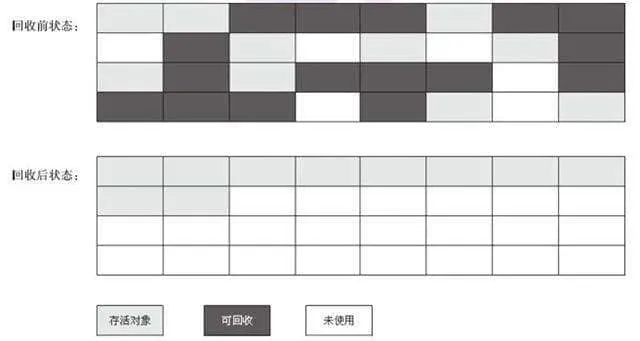

标记-清除算法

该算法分为“标记”和“清除”阶段:首先标记出所有不需要回收的对象,在标记完成后统一回收掉所有没有被标记的对象。它是最基础的收集算法,后续的算法都是对其不足进行改进得到。这种垃圾收集算法会带来两个明显的问题:

- 效率问题

- 空间问题(标记清除后会产生大量不连续的碎片)

标记-复制算法

为了解决效率问题,“标记-复制”收集算法出现了。它可以将内存分为大小相同的两块,每次使用其中的一块。当这一块的内存使用完后,就将还存活的对象复制到另一块去,然后再把使用的空间一次清理掉。这样就使每次的内存回收都是对内存区间的一半进行回收。

标记-整理算法

根据老年代的特点提出的一种标记算法,标记过程仍然与“标记-清除”算法一样,但后续步骤不是直接对可回收对象回收,而是让所有存活的对象向一端移动,然后直接清理掉端边界以外的内存。

分代收集算法

当前虚拟机的垃圾收集都采用分代收集算法,这种算法没有什么新的思想,只是根据对象存活周期的不同将内存分为几块。一般将 java 堆分为新生代和老年代,这样我们就可以根据各个年代的特点选择合适的垃圾收集算法。

比如在新生代中,每次收集都会有大量对象死去,所以可以选择”标记-复制“算法,只需要付出少量对象的复制成本就可以完成每次垃圾收集。而老年代的对象存活几率是比较高的,而且没有额外的空间对它进行分配担保,所以我们必须选择“标记-清除”或“标记-整理”算法进行垃圾收集。

延伸面试问题: HotSpot 为什么要分为新生代和老年代?

根据上面的对分代收集算法的介绍回答。

谈谈你了解的几种垃圾回收器(2022-04-11 携程)

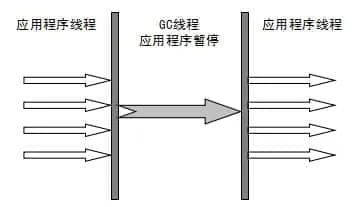

Serial 收集器

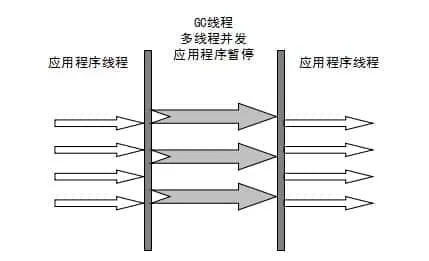

Serial(串行)收集器是最基本、历史最悠久的垃圾收集器了。大家看名字就知道这个收集器是一个单线程收集器了。它的 “单线程” 的意义不仅仅意味着它只会使用一条垃圾收集线程去完成垃圾收集工作,更重要的是它在进行垃圾收集工作的时候必须暂停其他所有的工作线程( "Stop The World" ),直到它收集结束。

新生代采用标记-复制算法,老年代采用标记-整理算法。

虚拟机的设计者们当然知道 Stop The World 带来的不良用户体验,所以在后续的垃圾收集器设计中停顿时间在不断缩短(仍然还有停顿,寻找最优秀的垃圾收集器的过程仍然在继续)。

但是 Serial 收集器有没有优于其他垃圾收集器的地方呢?当然有,它简单而高效(与其他收集器的单线程相比)。Serial 收集器由于没有线程交互的开销,自然可以获得很高的单线程收集效率。Serial 收集器对于运行在 Client 模式下的虚拟机来说是个不错的选择。

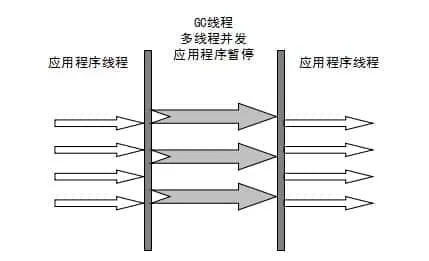

ParNew 收集器

ParNew 收集器其实就是 Serial 收集器的多线程版本,除了使用多线程进行垃圾收集外,其余行为(控制参数、收集算法、回收策略等等)和 Serial 收集器完全一样。

新生代采用标记-复制算法,老年代采用标记-整理算法。

它是许多运行在 Server 模式下的虚拟机的首要选择,除了 Serial 收集器外,只有它能与 CMS 收集器(真正意义上的并发收集器,后面会介绍到)配合工作。

并行和并发概念补充:

- 并行(Parallel) :指多条垃圾收集线程并行工作,但此时用户线程仍然处于等待状态。

- 并发(Concurrent):指用户线程与垃圾收集线程同时执行(但不一定是并行,可能会交替执行),用户程序在继续运行,而垃圾收集器运行在另一个 CPU 上。

Parallel Scavenge 收集器

Parallel Scavenge 收集器也是使用标记-复制算法的多线程收集器,它看上去几乎和 ParNew 都一样。 那么它有什么特别之处呢?

-XX:+UseParallelGC

使用 Parallel 收集器+ 老年代串行

-XX:+UseParallelOldGC

使用 Parallel 收集器+ 老年代并行

Parallel Scavenge 收集器关注点是吞吐量(高效率的利用 CPU)。CMS 等垃圾收集器的关注点更多的是用户线程的停顿时间(提高用户体验)。所谓吞吐量就是 CPU 中用于运行用户代码的时间与 CPU 总消耗时间的比值。 Parallel Scavenge 收集器提供了很多参数供用户找到最合适的停顿时间或最大吞吐量,如果对于收集器运作不太了解,手工优化存在困难的时候,使用 Parallel Scavenge 收集器配合自适应调节策略,把内存管理优化交给虚拟机去完成也是一个不错的选择。

新生代采用标记-复制算法,老年代采用标记-整理算法。

这是 JDK1.8 默认收集器

使用 java -XX:+PrintCommandLineFlags -version 命令查看

-XX:InitialHeapSize=262921408 -XX:MaxHeapSize=4206742528 -XX:+PrintCommandLineFlags -XX:+UseCompressedClassPointers -XX:+UseCompressedOops -XX:+UseParallelGC

java version "1.8.0_211"

Java(TM) SE Runtime Environment (build 1.8.0_211-b12)

Java HotSpot(TM) 64-Bit Server VM (build 25.211-b12, mixed mode)

JDK1.8 默认使用的是 Parallel Scavenge + Parallel Old,如果指定了-XX:+UseParallelGC 参数,则默认指定了-XX:+UseParallelOldGC,可以使用-XX:-UseParallelOldGC 来禁用该功能

Serial Old 收集器

Serial 收集器的老年代版本,它同样是一个单线程收集器。它主要有两大用途:一种用途是在 JDK1.5 以及以前的版本中与 Parallel Scavenge 收集器搭配使用,另一种用途是作为 CMS 收集器的后备方案。

Parallel Old 收集器

Parallel Scavenge 收集器的老年代版本。使用多线程和“标记-整理”算法。在注重吞吐量以及 CPU 资源的场合,都可以优先考虑 Parallel Scavenge 收集器和 Parallel Old 收集器。

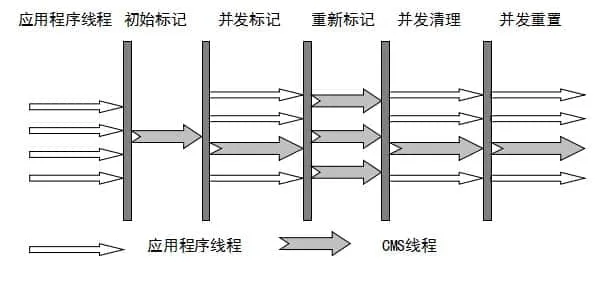

CMS 收集器

CMS(Concurrent Mark Sweep)收集器是一种以获取最短回收停顿时间为目标的收集器。它非常符合在注重用户体验的应用上使用。

CMS(Concurrent Mark Sweep)收集器是 HotSpot 虚拟机第一款真正意义上的并发收集器,它第一次实现了让垃圾收集线程与用户线程(基本上)同时工作。

从名字中的Mark Sweep这两个词可以看出,CMS 收集器是一种 “标记-清除”算法实现的,它的运作过程相比于前面几种垃圾收集器来说更加复杂一些。整个过程分为四个步骤:

- 初始标记: 暂停所有的其他线程,并记录下直接与 root 相连的对象,速度很快 ;

- 并发标记: 同时开启 GC 和用户线程,用一个闭包结构去记录可达对象。但在这个阶段结束,这个闭包结构并不能保证包含当前所有的可达对象。因为用户线程可能会不断的更新引用域,所以 GC 线程无法保证可达性分析的实时性。所以这个算法里会跟踪记录这些发生引用更新的地方。

- 重新标记: 重新标记阶段就是为了修正并发标记期间因为用户程序继续运行而导致标记产生变动的那一部分对象的标记记录,这个阶段的停顿时间一般会比初始标记阶段的时间稍长,远远比并发标记阶段时间短

- 并发清除: 开启用户线程,同时 GC 线程开始对未标记的区域做清扫。

从它的名字就可以看出它是一款优秀的垃圾收集器,主要优点:并发收集、低停顿。但是它有下面三个明显的缺点:

- 对 CPU 资源敏感;

- 无法处理浮动垃圾;

- 它使用的回收算法-“标记-清除”算法会导致收集结束时会有大量空间碎片产生。

G1 收集器

G1 (Garbage-First) 是一款面向服务器的垃圾收集器,主要针对配备多颗处理器及大容量内存的机器. 以极高概率满足 GC 停顿时间要求的同时,还具备高吞吐量性能特征.

被视为 JDK1.7 中 HotSpot 虚拟机的一个重要进化特征。它具备以下特点:

- 并行与并发:G1 能充分利用 CPU、多核环境下的硬件优势,使用多个 CPU(CPU 或者 CPU 核心)来缩短 Stop-The-World 停顿时间。部分其他收集器原本需要停顿 Java 线程执行的 GC 动作,G1 收集器仍然可以通过并发的方式让 java 程序继续执行。

- 分代收集:虽然 G1 可以不需要其他收集器配合就能独立管理整个 GC 堆,但是还是保留了分代的概念。

- 空间整合:与 CMS 的“标记-清理”算法不同,G1 从整体来看是基于“标记-整理”算法实现的收集器;从局部上来看是基于“标记-复制”算法实现的。

- 可预测的停顿:这是 G1 相对于 CMS 的另一个大优势,降低停顿时间是 G1 和 CMS 共同的关注点,但 G1 除了追求低停顿外,还能建立可预测的停顿时间模型,能让使用者明确指定在一个长度为 M 毫秒的时间片段内。

G1 收集器的运作大致分为以下几个步骤:

- 初始标记

- 并发标记

- 最终标记

- 筛选回收

G1 收集器在后台维护了一个优先列表,每次根据允许的收集时间,优先选择回收价值最大的 Region(这也就是它的名字 Garbage-First 的由来) 。这种使用 Region 划分内存空间以及有优先级的区域回收方式,保证了 G1 收集器在有限时间内可以尽可能高的收集效率(把内存化整为零)

ZGC 收集器

与 CMS 中的 ParNew 和 G1 类似,ZGC 也采用标记-复制算法,不过 ZGC 对该算法做了重大改进。

在 ZGC 中出现 Stop The World 的情况会更少!

详情可以看 : 《新一代垃圾回收器 ZGC 的探索与实践》

想要在指定时间结束垃圾回收,选用哪种垃圾回收器(2022-04-11 携程)

G1

什么是GCROOT?

在 Java 语言中,GC Roots 包括以下几类元素:

虚拟机栈中引用的对象

- 比如:各个线程被调用的方法中使用到的参数、局部变量等。

本地方法栈内 JNI(通常说的本地方法)引用的对象

方法区中类静态属性引用的对象

- 比如:Java 类的引用类型静态变量

方法区中常量引用的对象

- 比如:字符串常量池(String Table)里的引用

所有被同步锁 synchronized 持有的对象

Java 虚拟机内部的引用。

基本数据类型对应的 Class 对象,一些常驻的异常对象(如:

NullPointerException、OutOfMemoryError),系统类加载器。反映 java 虚拟机内部情况的 JMXBean、JVMTI 中注册的回调、本地代码缓存等。

除了这些固定的 GC Roots 集合以外,根据用户所选用的垃圾收集器以及当前回收的内存区域不同,

还可以有其他对象 “临时性” 地加入,共同构成完整 GC Roots 集合。比如:分代收集和局部回收

(PartialGC)。

- 如果只针对 Java 堆中的某一块区域进行垃圾回收(比如:典型的只针对新生代),必须考虑到内存区域是虚拟机自己的实现细节,更不是孤立封闭的,这个区域的对象完全有可能被其他区域的对象所引用,这时候就需要一并将关联的区域对象也加入 GCRoots 集合中去考虑,才能保证可达性分析的准确性。

- 典型的只针对新生代:因为新生代除外,还有关联的老年代,所以需要将老年代也一并加入 GC Roots 集合中

小技巧

- 由于 Root 采用栈方式存放变量和指针,所以如果一个指针,它保存了堆内存里面的对象,但是自己又不存放在堆内存里面,那它就是一个 Root。

一系列的称为 “GC Roots” 的对象作为起点,从这些节点开始向下搜索,节点所走过的路径称为引用链,当一个对象到 GC Roots 没有任何引用链相连的话,则证明此对象是不可用的,需要被回收。

注意

- 如果要使用可达性分析算法来判断内存是否可回收,那么分析工作必须在一个能保障一致性 (某一刻的静止状态) 的快照中进行。这点不满足的话分析结果的准确性就无法保证。

- 这点也是导致 GC 进行时必须 “stop The World” 的一个重要原因。

- 即使是号称(几乎)不会发生停顿的 CMS 收集器中,枚举根节点时也是必须要停顿的。

如何破坏双亲委派? (字节实习)

在Java中,双亲委派是一种类加载机制,它的工作方式是当一个类加载器需要加载一个类时,它首先将这个请求委派给它的父类加载器去完成,如果父类加载器还有父类加载器,则继续向上委派,直到委派到Bootstrap ClassLoader为止。如果所有的父类加载器都无法加载这个类,那么再由当前类加载器自己去加载。

这个机制的目的是保证Java中的类的唯一性和安全性。由于类的唯一性是由类加载器和类名一起决定的,如果多个类加载器都可以加载同一个类,就可能导致类的唯一性被破坏,从而导致类的功能异常或安全问题。通过双亲委派机制,所有的类都会被先由最顶层的Bootstrap ClassLoader加载,保证了类的唯一性。

例如,当需要加载一个名为"java.lang.Object"的类时,首先由系统自带的Bootstrap ClassLoader加载,如果没有找到,则由Extension ClassLoader加载,如果还是没有找到,则由App ClassLoader加载。如果还是没有找到,则由当前线程的ClassLoader去加载。

这种机制也有利于避免类库的重复加载,因为父类加载器已经加载过类库,子类加载器就不会再次加载,这有助于减少Java虚拟机内存的使用,提高应用程序的性能。

如果不想打破双亲委派模型,就重写ClassLoader类中的findClass()方法即可,无法被父类加载器加载的类最终会通过这个方法被加载。而如果想打破双亲委派模型则需要重写loadClass()方法

典型的打破双亲委派模型的框架和中间件有tomcat与osgi

//破坏双亲委派模型

@Override

public Class<?> loadClass(String name)

throws ClassNotFoundException {

String myPath = "D:/" + name.replace(".","/") + ".class";

System.out.println(myPath);

byte[] classBytes = null;

FileInputStream in = null;

try {

File file = new File(myPath);

in = new FileInputStream(file);

classBytes = new byte[(int) file.length()];

in.read(classBytes);

} catch (FileNotFoundException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

}finally{

try {

in.close();

} catch (IOException e) {

e.printStackTrace();

}

}

System.out.println();

Class<?> clazz = defineClass(name, classBytes, 0, classBytes.length);

return clazz;

}

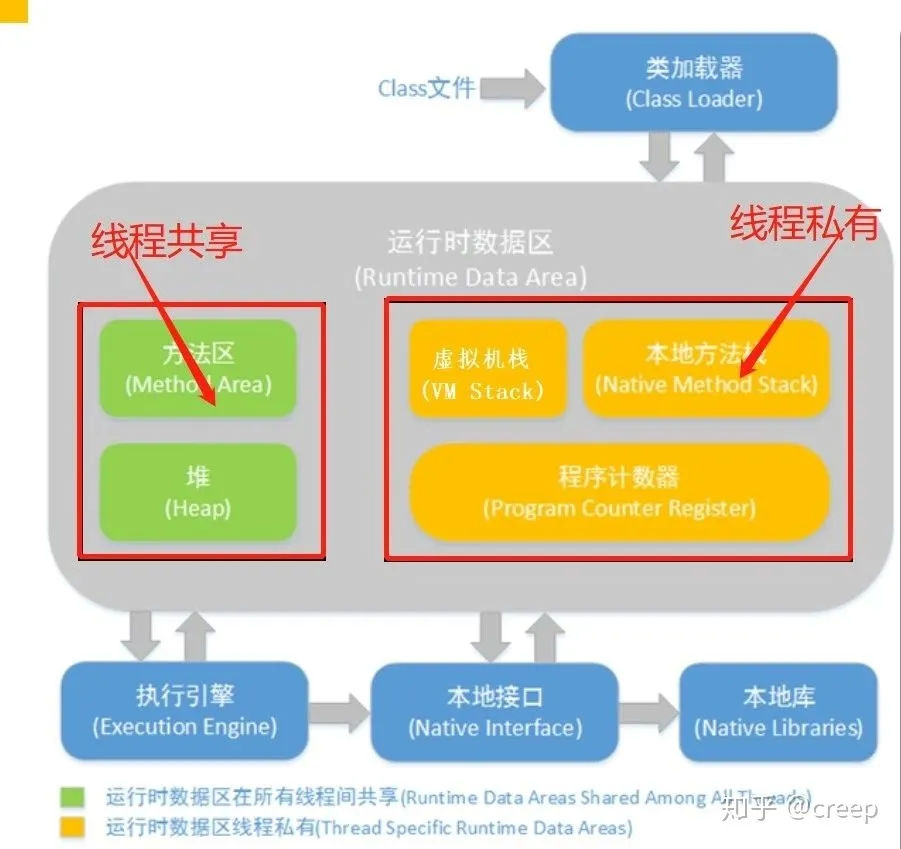

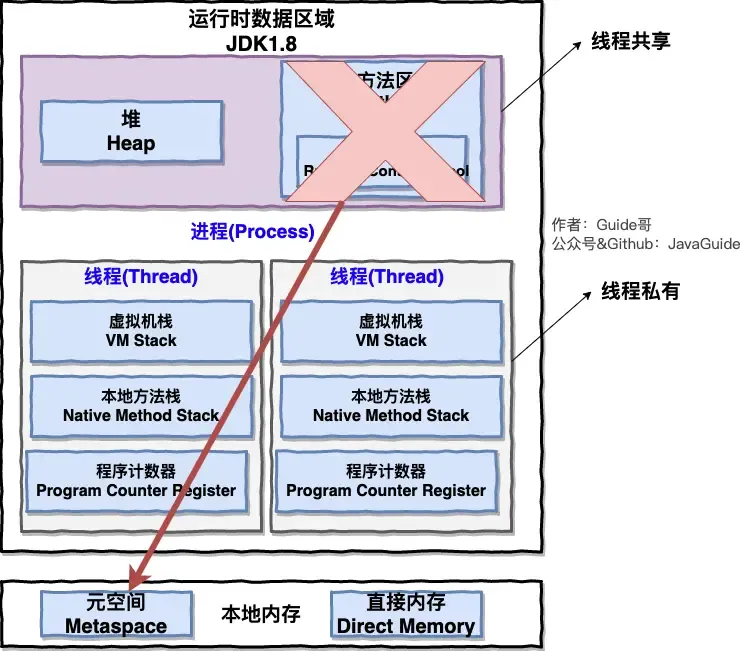

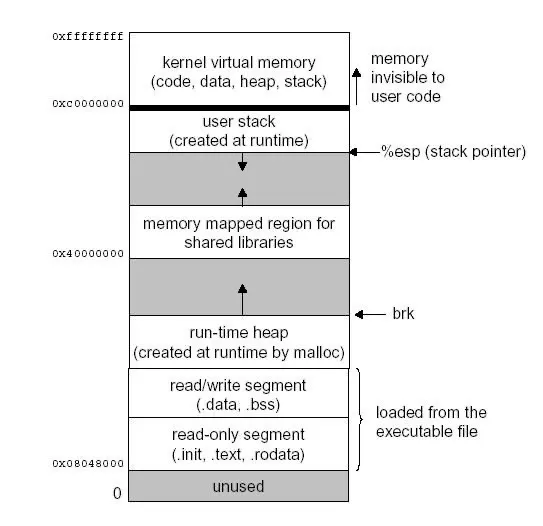

JVM内存模型?JNI在哪个区域? (百度)

JVM内存模型是Java虚拟机规范中定义的一种内存管理机制,它将Java虚拟机的内存划分为以下几个区域:

- 程序计数器(Program Counter Register):是一个指针,指向当前线程正在执行的字节码的地址。

- Java虚拟机栈(Java Virtual Machine Stacks):每个Java线程都有一个自己的Java虚拟机栈,用于存储方法调用的栈帧。每个方法的调用都会在栈上创建一个栈帧,并在方法执行完毕后将其弹出。

- 本地方法栈(Native Method Stacks):用于存储本地方法(Native Method)的栈帧。

- Java堆(Java Heap):是Java虚拟机管理的内存区域中最大的一块。所有的Java对象都在堆中分配内存。Java堆是垃圾收集器管理的主要区域。

- 方法区(Method Area):用于存储已加载的类信息、常量、静态变量、即时编译器编译后的代码等数据。

- 运行时常量池(Runtime Constant Pool):是方法区的一部分,用于存储编译期间生成的字面量和符号引用。每个类的运行时常量池都是独立的,包括该类所引用的其他类和接口的运行时常量池。

- 直接内存(Direct Memory):不是JVM管理的区域,而是由操作系统管理的一块内存区域,用于实现NIO(New Input/Output)功能。

这些内存区域都具有各自的特点和用途,JVM内存模型的合理使用和优化可以有效地提高Java应用程序的性能和稳定性。

JNI在本地方法栈

JNI(Java Native Interface)是Java语言与本地代码交互的一种技术,它允许Java程序调用本地(C、C++等)代码,也可以使本地代码调用Java代码。

在Java中,通过JNI可以访问操作系统的本地API,以实现一些Java无法完成的任务,例如访问硬件、执行底层系统操作等。同时,通过JNI也可以利用本地代码的性能优势,加速Java应用程序的执行速度。

JNI的工作原理是通过Java Native Method Interface(JNMI)提供了一些Java本地方法,用于与本地代码进行交互。在Java代码中声明本地方法时,需要使用native关键字标记,这表明该方法是一个本地方法,它的具体实现由本地代码提供。在Java程序运行时,JVM会在本地代码库中查找对应的本地方法,并将Java程序传递给它进行处理。

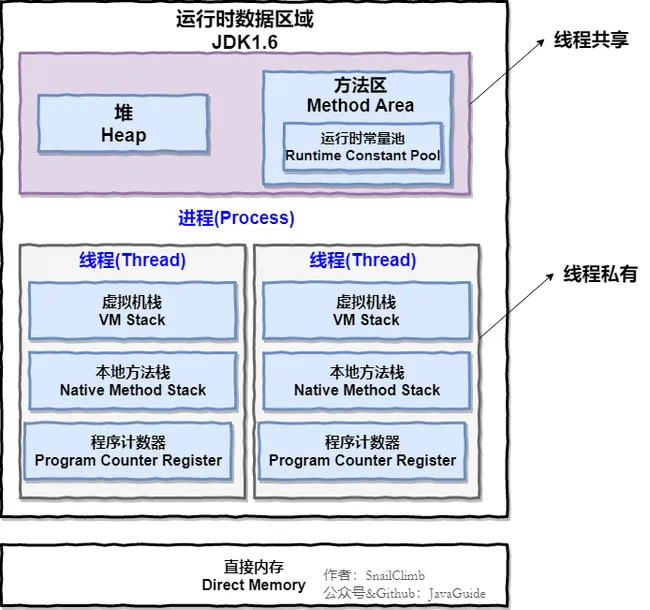

JVM的运行时数据区有什么?堆栈各放什么,说一下栈帧 (百度)

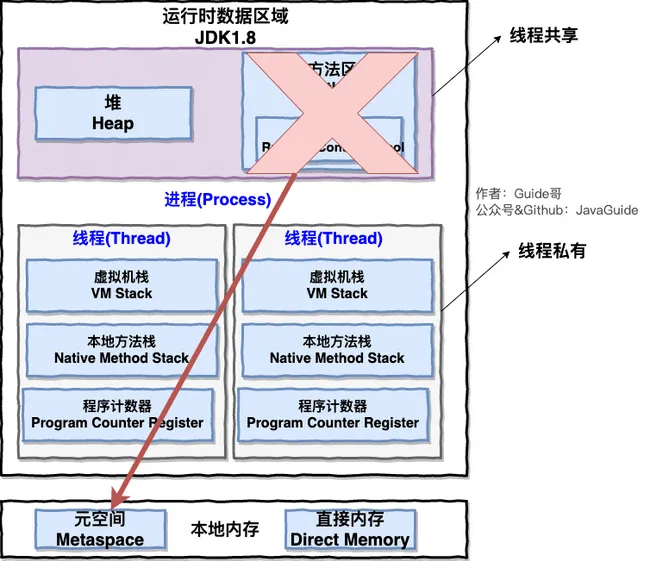

Java 虚拟机在执行 Java 程序的过程中会把它管理的内存划分成若干个不同的数据区域。JDK 1.8 和之前的版本略有不同,下面会介绍到。

JDK 1.8 之前 :

JDK 1.8 :

线程私有的:

- 程序计数器

- 虚拟机栈

- 本地方法栈

线程共享的:

- 堆

- 方法区

- 直接内存 (非运行时数据区的一部分)

Java 虚拟机规范对于运行时数据区域的规定是相当宽松的。以堆为例:堆可以是连续空间,也可以不连续。堆的大小可以固定,也可以在运行时按需扩展 。虚拟机实现者可以使用任何垃圾回收算法管理堆,甚至完全不进行垃圾收集也是可以的。

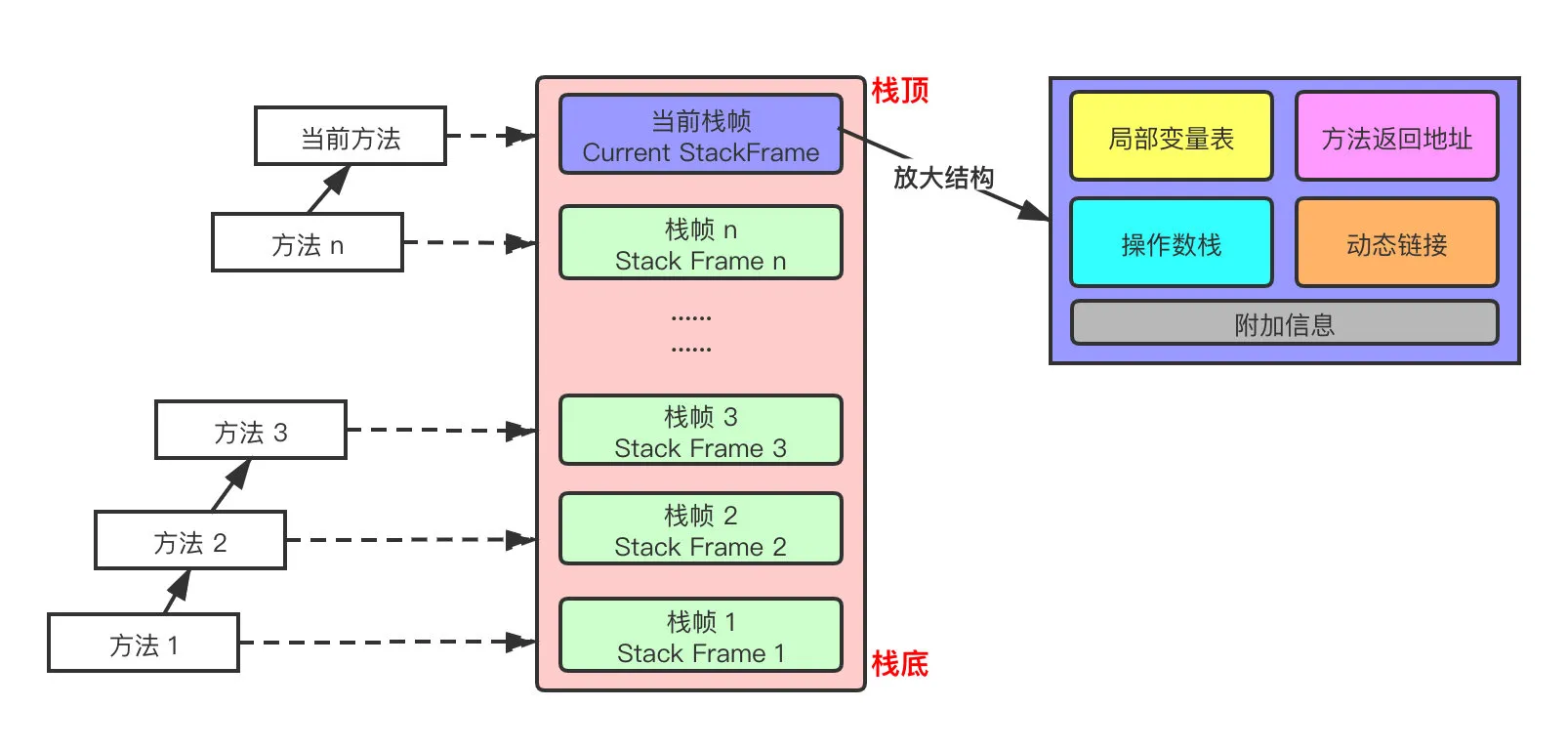

栈:

和虚拟机栈所发挥的作用非常相似,区别是: 虚拟机栈为虚拟机执行 Java 方法 (也就是字节码)服务,而本地方法栈则为虚拟机使用到的 Native 方法服务。 在 HotSpot 虚拟机中和 Java 虚拟机栈合二为一。

本地方法被执行的时候,在本地方法栈也会创建一个栈帧,用于存放该本地方法的局部变量表、操作数栈、动态链接、出口信息。

方法执行完毕后相应的栈帧也会出栈并释放内存空间,也会出现 StackOverFlowError 和 OutOfMemoryError 两种错误。

Java 虚拟机所管理的内存中最大的一块,Java 堆是所有线程共享的一块内存区域,在虚拟机启动时创建。此内存区域的唯一目的就是存放对象实例,几乎所有的对象实例以及数组都在这里分配内存。

Java 世界中“几乎”所有的对象都在堆中分配,但是,随着 JIT 编译器的发展与逃逸分析技术逐渐成熟,栈上分配、标量替换优化技术将会导致一些微妙的变化,所有的对象都分配到堆上也渐渐变得不那么“绝对”了。从 JDK 1.7 开始已经默认开启逃逸分析,如果某些方法中的对象引用没有被返回或者未被外面使用(也就是未逃逸出去),那么对象可以直接在栈上分配内存。

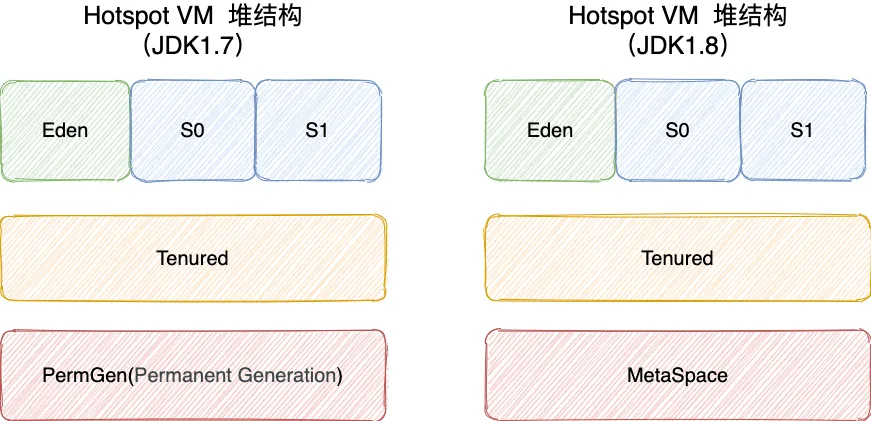

Java 堆是垃圾收集器管理的主要区域,因此也被称作 GC 堆(Garbage Collected Heap)。从垃圾回收的角度,由于现在收集器基本都采用分代垃圾收集算法,所以 Java 堆还可以细分为:新生代和老年代;再细致一点有:Eden、Survivor、Old 等空间。进一步划分的目的是更好地回收内存,或者更快地分配内存。

在 JDK 7 版本及 JDK 7 版本之前,堆内存被通常分为下面三部分:

- 新生代内存(Young Generation)

- 老生代(Old Generation)

- 永久代(Permanent Generation)

下图所示的 Eden 区、两个 Survivor 区 S0 和 S1 都属于新生代,中间一层属于老年代,最下面一层属于永久代。

JDK 8 版本之后 PermGen(永久) 已被 Metaspace(元空间) 取代,元空间使用的是直接内存 (我会在方法区这部分内容详细介绍到)。

大部分情况,对象都会首先在 Eden 区域分配,在一次新生代垃圾回收后,如果对象还存活,则会进入 S0 或者 S1,并且对象的年龄还会加 1(Eden 区->Survivor 区后对象的初始年龄变为 1),当它的年龄增加到一定程度(默认为 15 岁),就会被晋升到老年代中。对象晋升到老年代的年龄阈值,可以通过参数 -XX:MaxTenuringThreshold 来设置。

🐛 修正“Hotspot 遍历所有对象时,按照年龄从小到大对其所占用的大小进行累积,当累积的某个年龄大小超过了 survivor 区的一半时,取这个年龄和 MaxTenuringThreshold 中更小的一个值,作为新的晋升年龄阈值”。

每个栈帧(Stack Frame)中存储着:

- 局部变量表(Local Variables)

- 操作数栈(Operand Stack)(或称为表达式栈)

- 动态链接(Dynamic Linking):指向运行时常量池的方法引用

- 方法返回地址(Return Address):方法正常退出或异常退出的地址

- 一些附加信息

🕝并发编程

Java创建线程的几种方式?

- 继承Thead类创建线程

- 实现Runnable接口创建线程

- 使用Callable和Future创建线程

线程能不能 start 两次,线程池中的线程为什么能循环利用

首先 demo 眼见为实:

/**

* 描述: 对比start和run两种启动线程的方式

*/

public class StartAndRunMethod {

public static void main(String[] args) {

Runnable runnable = () -> {

System.out.println(Thread.currentThread().getName());

};

runnable.run();

new Thread(runnable).start();

}

}

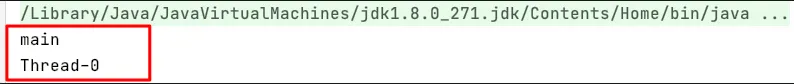

运行结果:

通过运行结果,我们可以总结出,run()方法只是一个普通的方法,start()是一个真正的启动线程的方法 一个线程调用两次 start()会发生什么?

我们还是先 demo:

/**

* 描述: 演示不能两次调用start方法,否则会报错

*/

public class CantStartTwice {

public static void main(String[] args) {

Thread thread = new Thread();

thread.start();

thread.start();

}

}

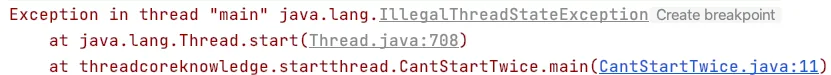

运行结果:报非法的线程状态

原因分析:

问题 2:线程池将线程和任务进行解耦,线程是线程,任务是任务,摆脱了之前通过 Thread 创建线程时的一个线程必须对应一个任务的限制。

在线程池中,同一个线程可以从阻塞队列中不断获取新任务来执行,其核心原理在于线程池对 Thread 进行了封装,并不是每次执行任务都会调用 Thread.start() 来创建新线程,而是让每个线程去执行一个“循环任务”,在这个“循环任务”中不停的检查是否有任务需要被执行,如果有则直接执行,也就是调用任务中的 run 方法,将 run 方法当成一个普通的方法执行,通过这种方式将只使用固定的线程就将所有任务的 run 方法串联起来

当任务提交之后,线程池首先会检查当前线程数,如果当前的线程数小于核心线程数(corePoolSize),比如最开始创建的时候线程数为 0,则新建线程并执行任务。 当提交的任务不断增加,创建的线程数等于核心线程数(corePoolSize),新增的任务会被添加到 workQueue 任务队列中,等待核心线程执行完当前任务后,重新从 workQueue 中获取任务执行。 假设任务非常多,达到了 workQueue 的最大容量,但是当前线程数小于最大线程数(maximumPoolSize),线程池会在核心线程数(corePoolSize)的基础上继续创建线程来执行任务。 假设任务继续增加,线程池的线程数达到最大线程数(maximumPoolSize),如果任务继续增加,这个时候线程池就会采用拒绝策略来拒绝这些任务。 在任务不断增加的过程中,线程池会逐一进行以下 4 个方面的判断

核心线程数(corePoolSize) 任务队列(workQueue) 最大线程数(maximumPoolSize) 拒绝策略

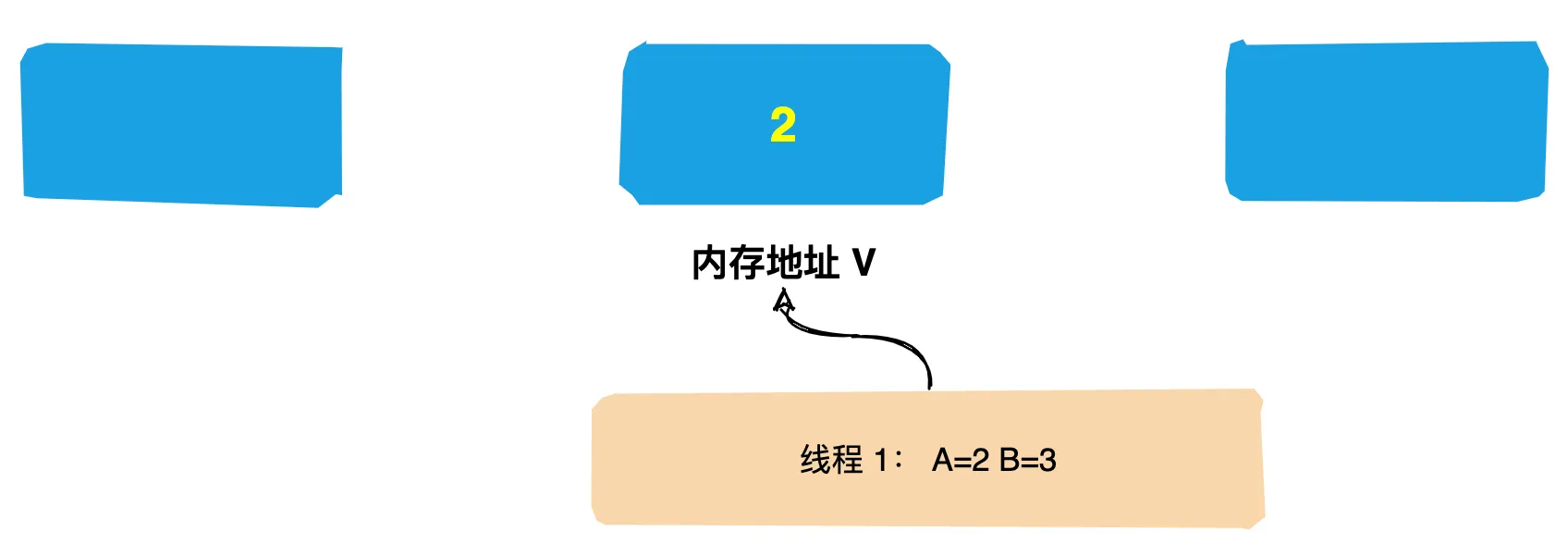

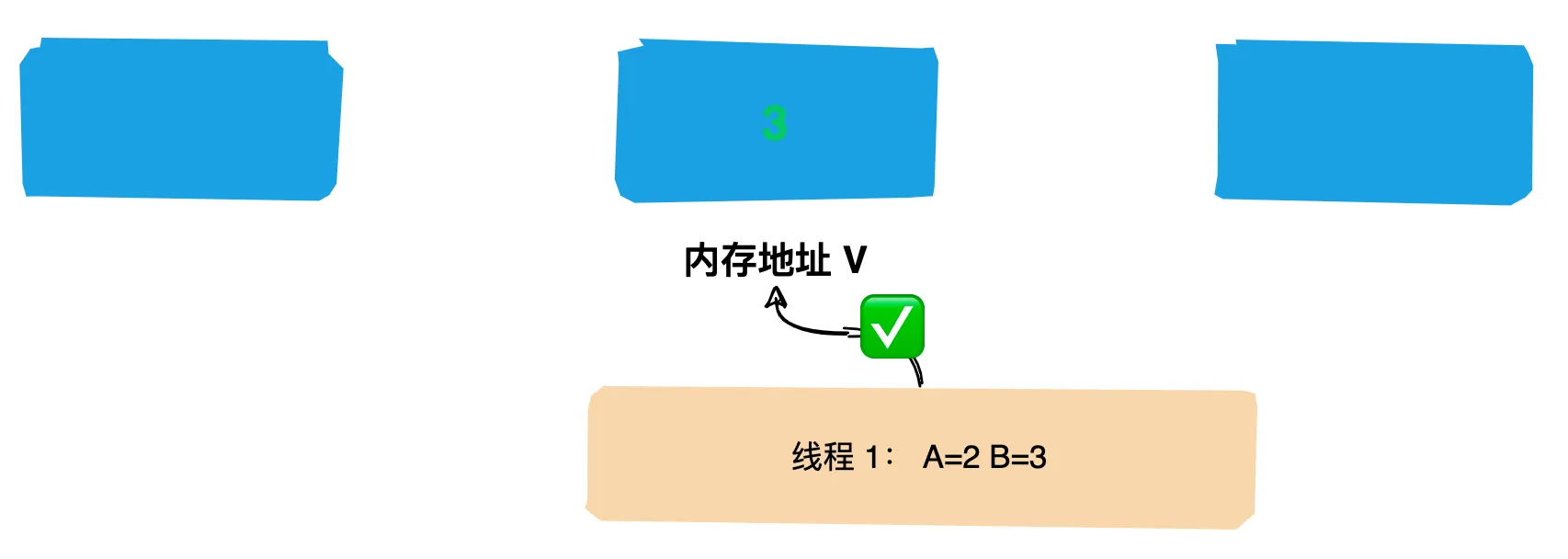

利用多线程时最大的难点是什么,怎么解决多线程安全问题

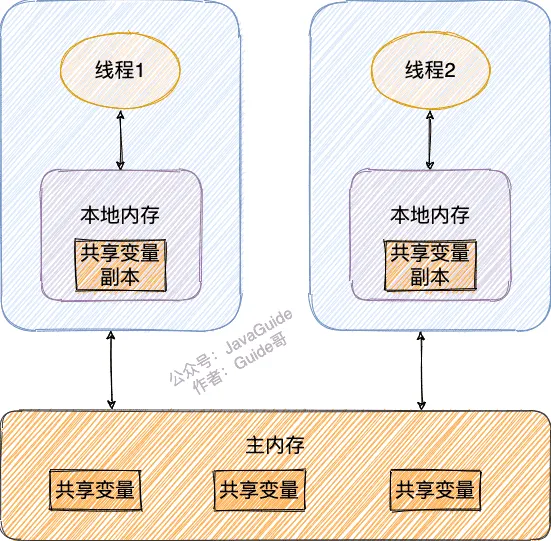

多线程的难点是在多个线程同时访问共享的数据或资源时,可能会发生数据冲突或不一致的问题。这就是多线程安全问题。解决多线程安全问题的方法有很多,比如使用原子类、同步锁、可重入锁、线程本地变量

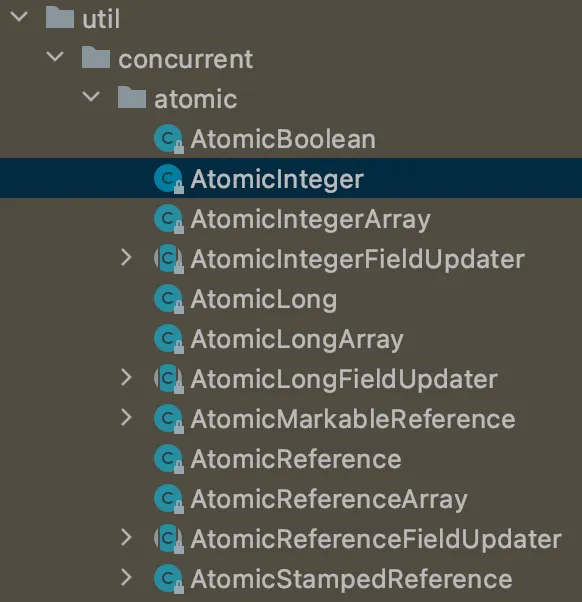

- 原子类是一种使用了原子操作的类,原子操作是指不可被中断的一个或一系列操作。原子类可以保证多线程对共享变量的操作是原子性的,不会出现数据不一致的问题。Java提供了很多原子类,比如AtomicInteger、AtomicLong、AtomicBoolean等。

- 同步锁是一种使用synchronized关键字或者Lock接口实现的锁机制,它可以让多个线程对共享资源进行排他性访问,只有获得锁的线程才能执行临界区代码,其他线程则要等待锁释放后才能竞争锁。

- 可重入锁是一种支持重入功能的锁,重入指的是同一个线程可以多次获取同一个锁。可重入锁可以避免死锁和递归调用导致的栈溢出问题。ReentrantLock就是一种可重入锁,它实现了Lock接口,并提供了公平和非公平两种模式。

- 线程本地变量是一种为每个线程创建一个单独副本的变量,每个线程只能访问自己的副本,而不能访问其他线程的副本。这样就避免了多个线程对同一个变量进行修改而导致数据不一致的问题。ThreadLocal就是一种线程本地变量,它提供了get()和set()方法来获取和设置当前线程的副本¹³。

怎么保证多线程下面单例模式安全

在多线程环境下,单例模式需要特别小心以避免多个线程同时创建多个实例,从而违反了单例模式的设计原则。以下是一些保证多线程下单例模式安全的方法:

- 懒汉式双重校验锁(Double-Checked Locking) 这种方式可以避免多个线程同时创建实例的问题,并且在实例已经存在时可以避免使用锁,从而提高性能。它的核心思想是,首先检查实例是否已经创建,如果没有,才进行同步,只有获取到锁的线程才能创建实例。当其他线程再次尝试创建实例时,因为已经存在实例,所以不会再进入同步块中。

- 饿汉式单例模式(Eager Initialization) 这种方式在类加载时就创建了实例,因此可以保证线程安全,但是可能会浪费一些系统资源。它的缺点是,如果实例在程序运行期间从未使用过,那么它就浪费了系统资源。

- 静态内部类方式 这种方式利用了 Java 类加载器的机制来保证多线程下只有一个实例被创建。当静态内部类被加载时,实例就会被创建,而且因为类加载是线程安全的,所以不会有多个线程创建多个实例的情况发生。

- 使用volatile关键字 在多线程中,volatile关键字可以保证变量的可见性和禁止指令重排,从而可以保证单例模式的正确性。在变量声明时使用volatile关键字可以确保变量的可见性,从而避免多线程下创建多个实例的问题。

需要注意的是,以上方法虽然可以保证单例模式的正确性,但是也会对程序的性能产生一定的影响。因此,在选择实现单例模式时需要根据实际情况进行权衡。

concurrentMap 和 hashmap 有什么区别

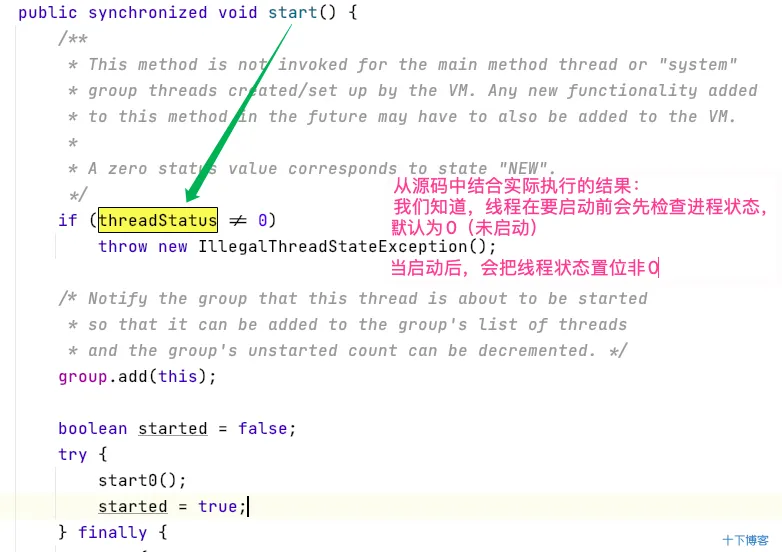

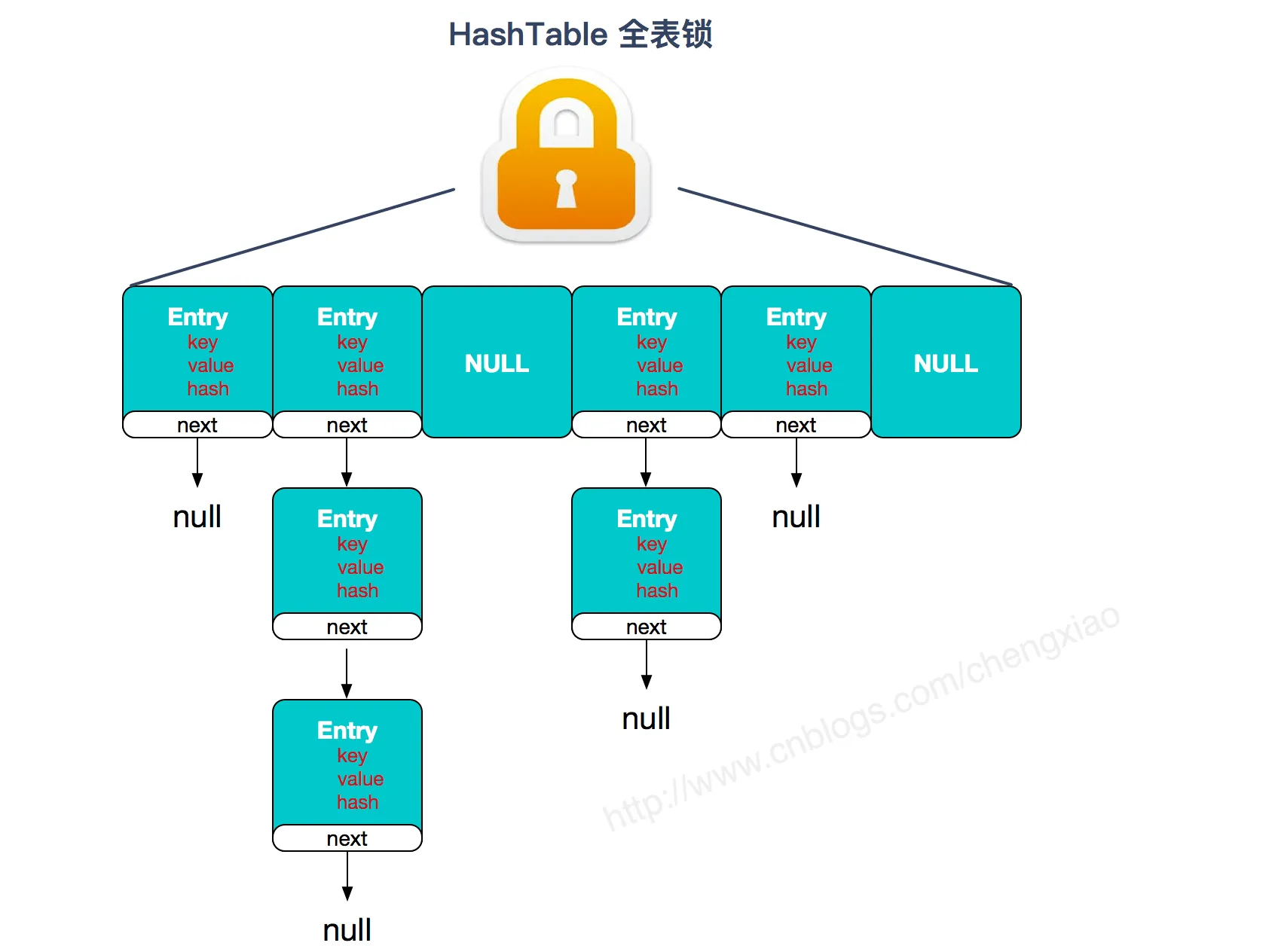

ConcurrentHashMap 和 Hashtable 的区别主要体现在实现线程安全的方式上不同。

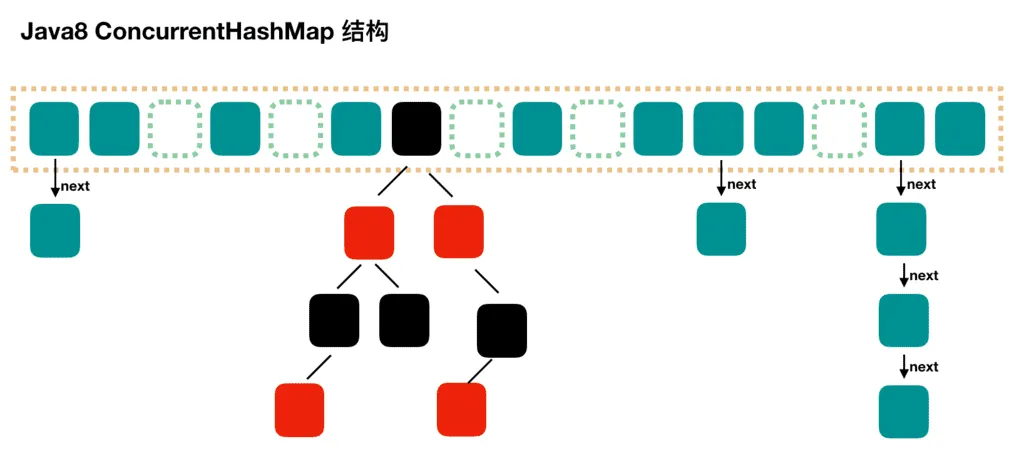

- 底层数据结构: JDK1.7 的

ConcurrentHashMap底层采用 分段的数组+链表 实现,JDK1.8 采用的数据结构跟HashMap1.8的结构一样,数组+链表/红黑二叉树。Hashtable和 JDK1.8 之前的HashMap的底层数据结构类似都是采用 数组+链表 的形式,数组是 HashMap 的主体,链表则是主要为了解决哈希冲突而存在的; - 实现线程安全的方式(重要): ① 在 JDK1.7 的时候,