2023大厂八股文

前言

2022有的大厂面试题不会在2023再次出现(也有可能会因为粗心加上,欢迎issue或者PR指正和修改),如果想要了解可以先看2022大厂面试版本。

🐦Java 基础

ArrayList线程安全吗?把ArrayList变成线程安全有哪些方法?(2023 美团)

将ArrayList变成线程安全有几种方法:

- 使用Collections.synchronizedList() 方法将ArrayList转换为线程安全的List。该方法会返回一个线程安全的List,使用该List时需要在访问它的方法上添加synchronized关键字,以保证多线程访问的安全性。

import java.util.ArrayList;

import java.util.Collections;

import java.util.List;

public class Main {

public static void main(String[] args) {

List<String> list = new ArrayList<>();

List<String> synchronizedList = Collections.synchronizedList(list);

}

}

- 使用CopyOnWriteArrayList类来代替ArrayList。CopyOnWriteArrayList是一种线程安全的List实现,它通过在写操作时复制整个数组来保证线程安全性,在读操作时不需要加锁,因此可以提高读取效率。

import java.util.concurrent.CopyOnWriteArrayList;

public class Main {

public static void main(String[] args) {

CopyOnWriteArrayList<String> list = new CopyOnWriteArrayList<>();

}

}

- 使用Lock接口来实现同步。可以使用ReentrantLock类来实现对ArrayList的同步操作,该类提供了与synchronized类似的功能,但是具有更高的灵活性。比如可以使用tryLock()方法来尝试获取锁,避免了线程的长时间等待。

Lock lock = new ReentrantLock();

...

lock.lock();

try {

// 对 ArrayList 的操作

} finally {

lock.unlock();

}

- 使用读写锁来实现同步。可以使用ReentrantReadWriteLock类来实现对ArrayList的读写操作的同步。该类提供了读锁和写锁两种锁,多个线程可以同时获取读锁,但是只有一个线程可以获取写锁,在写操作时需要先获取写锁,以保证线程安全。

ReadWriteLock rwLock = new ReentrantReadWriteLock();

...

rwLock.readLock().lock();

try {

// 对 ArrayList 的读操作

} finally {

rwLock.readLock().unlock();

}

...

rwLock.writeLock().lock();

try {

// 对 ArrayList 的写操作

} finally {

rwLock.writeLock().unlock();

}

- 使用 Vector: Vector 是一个线程安全的类,与 ArrayList 非常相似,可以作为替代品。但是,由于 Vector 的所有方法都是同步的,这可能会导致性能问题。

参考文献:

- https://stackoverflow.com/questions/2444005/how-do-i-make-my-arraylist-thread-safe-another-approach-to-problem-in-java 如何使我的ArrayList线程安全?Java问题的另一种方法?

- https://stackoverflow.com/questions/18983362/how-to-prove-arraylist-is-not-thread-safe-with-a-test 如何用测试证明数组列表不是线程安全的?

- https://stackoverflow.com/questions/300519/arraylist-vs-vectors-in-java-if-thread-safety-isnt-a-concern ArrayList与vector,Java如果线程安全不是一个问题

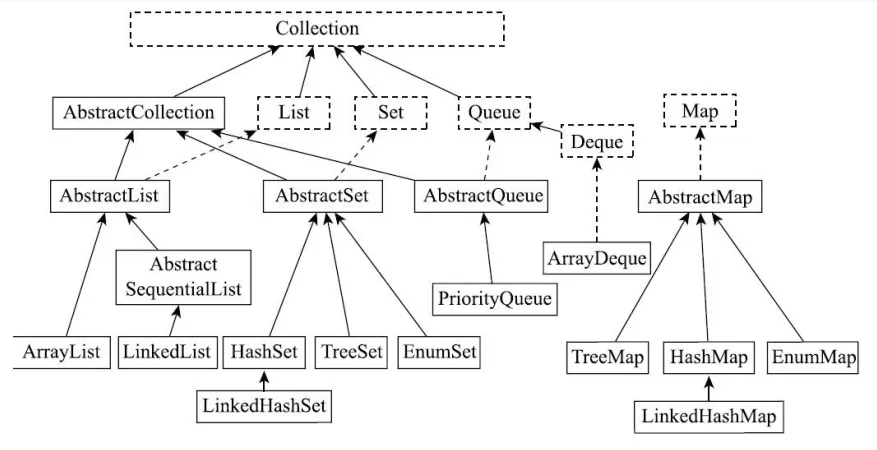

Java中有哪些常用的容器呢?(2023 阿里)

List是有序的Collection,使用此接口能够精确的控制每个元素的插入位置,用户能根据索引访问List中元素。常用的实现List的类有LinkedList,ArrayList,Vector,Stack。

- ArrayList是容量可变的非线程安全列表,其底层使用数组实现。当几何扩容时,会创建更大的数组,并把原数组复制到新数组。ArrayList支持对元素的快速随机访问,但插入与删除速度很慢。

- LinkedList本质是一个双向链表,与ArrayList相比,,其插入和删除速度更快,但随机访问速度更慢。

Set不允许存在重复的元素,与List不同,set中的元素是无序的。常用的实现有HashSet,LinkedHashSet和TreeSet。

- HashSet通过HashMap实现,HashMap的Key即HashSet存储的元素,所有Key都是用相同的Value,一个名为PRESENT的Object类型常量。使用Key保证元素唯一性,但不保证有序性。由于HashSet是HashMap实现的,因此线程不安全。

- LinkedHashSet继承自HashSet,通过LinkedHashMap实现,使用双向链表维护元素插入顺序。

- TreeSet通过TreeMap实现的,添加元素到集合时按照比较规则将其插入合适的位置,保证插入后的集合仍然有序。

Map 是一个键值对集合,存储键、值和之间的映射。Key 无序,唯一;value 不要求有序,允许重复。Map 没有继承于 Collection 接口,从 Map 集合中检索元素时,只要给出键对象,就会返回对应的值对象。主要实现有TreeMap、HashMap、HashTable、LinkedHashMap、ConcurrentHashMap

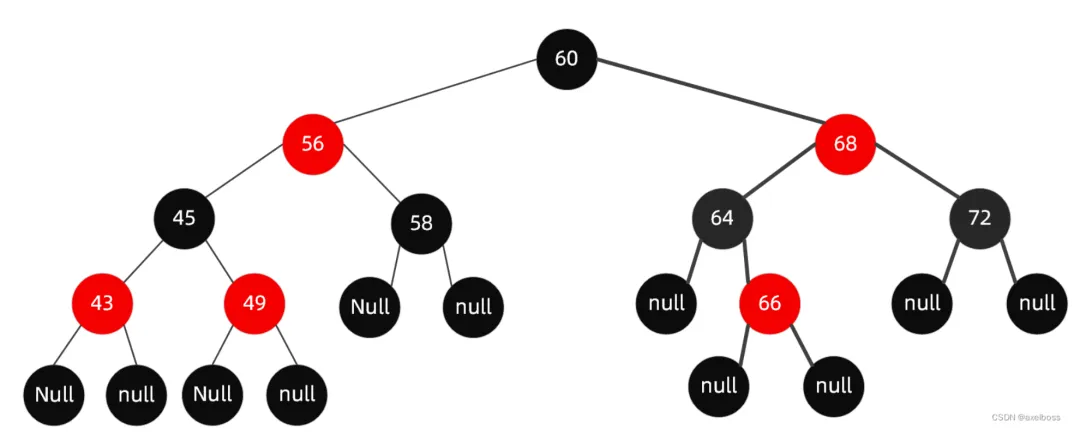

- HashMap:JDK1.8 之前 HashMap 由数组+链表组成的,数组是 HashMap 的主体,链表则是主要为了解决哈希冲突而存在的(“拉链法”解决冲突),JDK1.8 以后在解决哈希冲突时有了较大的变化,当链表长度大于阈值(默认为 8)时,将链表转化为红黑树,以减少搜索时间

- LinkedHashMap:LinkedHashMap 继承自 HashMap,所以它的底层仍然是基于拉链式散列结构即由数组和链表或红黑树组成。另外,LinkedHashMap 在上面结构的基础上,增加了一条双向链表,使得上面的结构可以保持键值对的插入顺序。同时通过对链表进行相应的操作,实现了访问顺序相关逻辑。

- HashTable:数组+链表组成的,数组是 HashMap 的主体,链表则是主要为了解决哈希冲突而存在的

- TreeMap:红黑树(自平衡的排序二叉树)

- ConcurrentHashMap:Node数组+链表+红黑树实现,线程安全的(jdk1.8以前Segment锁,1.8以后CAS锁)

HashMap是线程不安全的,那有什么线程安全的办法吗?(2023 阿里)

HashMap不是线程安全的,Hashtable和ConcurrentHashMap 都是线程安全的。

Hashtable和Collections.synchronizedMap返回的装饰器类SynchronizedMap都是通过synchronized关键字来保证多线程操作的线程安全,但使用synchronized会有一个问题,就是锁的粒度太大,同时只能有一个线程进行操作,导致并发度低下,影响了操作的性能。

比如:Hashtable的get和put方法,都使用了关键字synchronized修饰,这就意味着当一个线程调用put方法添加元素时,其它线程不能再同时执行put添加元素,也不能调用get方法获取数据。

为了解决synchronized并发度低的问题,ConcurrentHashMap使用了cas+synchronized解决共享遍历操作原子性问题,使用volatile保障共享变量的内存可见性问题。

ArrayList的并发修改异常了解吗?单线程情况下会发生吗?(2023 小红书)

这种异常通常发生在对ArrayList进行遍历时,同时尝试修改它的结构(例如添加或删除元素)。这种异常被称为ConcurrentModificationException。

在单线程情况下,这种异常也可能发生。当你在使用迭代器遍历ArrayList集合时,如果使用ArrayList的方法(如add()或remove())修改了集合的结构,就可能触发这个异常。这是因为ArrayList的内部实现使用了一个modCount变量来跟踪结构修改的次数。当迭代器检测到modCount发生变化时,它会抛出ConcurrentModificationException异常。

为了避免这种异常,你可以在遍历ArrayList时采用以下方法:

- 使用Iterator的remove()方法来删除元素,而不是直接使用ArrayList的remove()方法。这样可以确保modCount的值在迭代过程中保持一致。

- 如果需要遍历过程中添加元素,可以考虑使用ListIterator,它提供了add()方法,允许在遍历过程中修改列表结构。

- 另一种方法是使用Java 8的Stream API,它提供了一种更安全的方式来处理集合的并发修改问题。

- 如果你确实需要在遍历过程中修改ArrayList,可以考虑先复制一个新的ArrayList,然后在新的ArrayList上进行修改。遍历完成后,再将新的ArrayList赋值给原来的引用。这样可以避免在遍历过程中修改原始ArrayList的结构。

参考:

- https://stackoverflow.com/questions/602636/why-is-a-concurrentmodificationexception-thrown-and-how-to-debug-it 为什么会抛出它会抛出ConcurrentModificationException异常以及如何调试它

- https://www.javatpoint.com/concurrentmodificationexception-in-java

什么情况下会导致并发修改异常?(2023 快手)

在Java集合(如List、Set、Map)被一个线程进行迭代操作时,如果另一个线程同时修改了该集合的结构(如添加或删除元素),就有可能导致ConcurrentModificationException的发生

面向过程的方法存在哪些问题?(2023 美团)

- 可维护性较差:面向过程编程主要依赖于函数和过程,随着代码规模的增大,可能会导致代码结构复杂,不易维护。

- 可复用性较低:面向过程编程难以实现模块化,导致代码难以复用,进一步增加开发时间和成本。

- 扩展性不足:面向过程编程在代码逻辑发生变化时,往往需要对程序进行大量的修改,这样的代码扩展性不足。

- 抽象能力有限:面向过程编程主要关注过程和算法,而不是数据结构和对象,这使得它在表达现实世界的复杂问题时抽象能力有限。

- 封装性差:面向过程编程没有提供良好的封装机制,程序中的数据和处理过程容易暴露,可能导致数据安全性和程序稳定性问题。

- 强耦合:面向过程编程的方法往往导致程序组件之间存在强耦合,当一个组件发生变化时,可能会影响其他组件的正常工作。

面向过程好处是什么?(2023 美团)

- 面向过程编程采用自顶向下的编程方式,将问题分解为一个个小的模块,便于理解和编写。

- 每个模块相对独立,出现问题时可以单独调试,降低了调试难度。

- 面向过程编程适合解决简单、逻辑性强的问题,对于初学者来说,学习成本较低。

object 有哪些方法(2023百度)

当面试官问到 Java 中 Object 类的方法时,如果你无法记住所有的方法,可以采用以下回答策略:

- 强调基本方法:首先提及最常用和最基本的几个方法,如 equals()、hashCode()、toString(),这些方法几乎在每个对象中都会用到。

- equals(Object obj): 检查当前对象是否与另一个对象相等。

- hashCode(): 返回对象的哈希码值。

- toString(): 返回对象的字符串表示。

- 提及重要的方法:接下来可以提及一些较为重要的方法,如 getClass() 用于获取对象的运行时类,clone() 用于创建对象的副本等。

- clone(): 创建并返回当前对象的副本。

- getClass(): 返回对象的运行时类。

- 谈论对象间的通信:强调 wait()、notify()、notifyAll() 这些用于线程间通信的方法,说明其在多线程编程中的作用。

- notify(): 唤醒在该对象上等待的单个线程。

- notifyAll(): 唤醒在该对象上等待的所有线程。

- wait(): 导致当前线程等待,直到另一个线程调用该对象的 notify() 或 notifyAll() 方法。

- 谈论垃圾回收:提及 finalize() 方法,它在对象被垃圾回收之前调用,可以用于执行一些清理操作。

- finalize(): 在对象被垃圾回收器回收之前调用。

如果让你自己实现一个 map 你会怎么做(2023百度)

- 定义Map接口,包括get,put,remove,size,isEmpty等方法

public interface MyMap {

public Object get(Object key);

public void put(Object key, Object value);

public Object remove(Object key);

public int size();

public boolean isEmpty();

}

- 实现HashMap,使用哈希表和链表解决hash冲突

public class MyHashMap implements MyMap {

private int size;

private LinkedList[] buckets;

public MyHashMap() {

buckets = new LinkedList[16];

}

public Object get(Object key) {

int hash = key.hashCode();

int index = hash % buckets.length;

LinkedList list = buckets[index];

if (list != null) {

for (Node node : list) {

if (node.key.equals(key)) {

return node.value;

}

}

}

return null;

}

public void put(Object key, Object value) {

// 省略实现...

}

// 其他方法省略...

}

- 实现TreeMap,使用红黑树排序并存储key-value

public class MyTreeMap implements MyMap {

private Node root;

private class Node {

Object key;

Object value;

Node left;

Node right;

// 省略构造方法...

}

public Object get(Object key) {

Node node = root;

while (node != null) {

if (key.compareTo(node.key) < 0) {

node = node.left;

} else if (key.compareTo(node.key) > 0) {

node = node.right;

} else {

return node.value;

}

}

return null;

}

public void put(Object key, Object value) {

// 省略实现...

}

}

作为 map 的 key 需要重写哪些方法?(2023 完美世界)

首先,先理解面试题的意思,可以理解为:如果你要用自己的类的对象作为Map的键,你需要重写这个类的哪些方法?

- 在Java中,Map接口是基于键值对的,每个键都必须是唯一的。Java使用键对象的hashCode()方法来计算哈希值,这个哈希值用于确定在Map内部存储结构中的位置。同时,Java也使用键对象的equals()方法来检查两个键是否相等。

- 所以,如果你的类的对象要作为Map的键使用,那么通常需要你重写这个类的hashCode()和equals()方法,以确保它们的行为符合预期。

- 如果不重写这两个方法,那么默认的hashCode()方法将返回每个对象的内存地址,equals()方法将仅比较两个对象的内存地址。这可能会导致不符合预期的行为,比如两个内容完全相同但内存地址不同的对象被视为不同的键。

在Java中,作为Map的键(key),你通常需要重写以下两个方法:

- hashCode():这个方法返回对象的哈希码,用于确定在哈希表中的存储位置。如果两个对象被认为相等(根据equals()方法),那么它们的hashCode()方法必须返回相同的值。

- equals():这个方法用来判断两个对象是否相等。在Java的Map中,当我们调用get(key)或containsKey(key)方法时,Map实现会用这个方法来查找与给定键匹配的键。

当你创建自定义的类并打算将其实例用作Map的键时,通常需要覆盖这两个方法以确保它们的行为符合预期。如果不这样做,Map可能无法正确地查找、添加或删除键值对。

List的实现类(2023 阿里)

Java中的List接口有多个实现类,常用的包括:

- ArrayList:基于动态数组实现,优势在于支持随机访问和快速插入/删除元素,适用于频繁读取和遍历的场景。

- LinkedList:基于双向链表实现,优势在于支持快速插入/删除元素,适用于频繁插入/删除元素的场景。

- Vector:和ArrayList类似,但由于其线程安全性,适用于多线程环境。

- Stack:基于Vector实现,是一个后进先出(LIFO)的数据结构,适用于需要按照后进先出顺序处理元素的场景。

List和Set的区别(2023 阿里)

- 顺序:List是有序的集合,它可以按照元素插入的顺序进行存储和访问。而Set是无序的集合,元素在集合中的位置是不固定的。

- 重复元素:List允许存储重复的元素,即可以有多个相同的对象。Set不允许存储重复的元素,即每个对象在集合中只能出现一次。

- 实现类:List的常用实现类有ArrayList和LinkedList,分别使用数组和链表作为底层数据结构。Set的常用实现类有HashSet、LinkedHashSet和TreeSet,分别基于哈希表、链表+哈希表和红黑树实现。

- 性能:由于底层数据结构的差异,List和Set在增加、删除、查找等操作上的性能表现有所不同。例如,ArrayList在随机访问元素时性能较好,而LinkedList在插入和删除元素时性能较好。HashSet在查找、添加和删除元素时性能较好,但不保证元素顺序。TreeSet在保持元素排序的同时,也能提供较好的查找性能。

补充: Queue(实现排队功能的叫号机): 按特定的排队规则来确定先后顺序,存储的元素是有序的、可重复的。 Map(用 key 来搜索的专家): 使用键值对(key-value)存储,类似于数学上的函数 y=f(x),"x" 代表 key,"y" 代表 value,key 是无序的、不可重复的,value 是无序的、可重复的,每个键最多映射到一个值。

针对你说的List和Set的性质,那你会用这两种结构解决哪些问题(2023 阿里)

List(列表)适用于以下场景:

- 有序数据:列表中的元素按照插入顺序存储,因此适用于需要保持元素顺序的场景。

- 允许重复元素:列表允许存储重复的元素,因此适用于需要统计元素出现次数的场景。

- 需要根据索引进行查找、插入和删除操作:列表允许通过索引值直接访问、插入或删除元素,适用于需要频繁进行这些操作的场景。

Set(集合)适用于以下场景:

- 去重:集合中的元素不能重复,因此适用于去除数据中重复元素的场景。

- 无需关心元素顺序:集合中的元素没有固定顺序,适用于元素顺序无关紧要的场景。

- 快速判断元素是否存在:集合提供了高效率的查找算法,适用于需要快速判断某个元素是否存在于数据集中的场景。

- 集合运算:集合支持交集、并集、差集等运算,适用于需要进行这些运算的场景。

Java创建对象的几种方式,除了new和反射还有其他吗?(2023 阿里实习)

- 使用 new 关键字: 这是创建对象最常见的方式。例如:

MyClass obj = new MyClass();

- 使用 Java 反射 (Reflection) API,主要是 java.lang.Class 类中的 newInstance() 方法或者 java.lang.reflect.Constructor 类中的 newInstance() 方法。例如:

Class<?> clazz = Class.forName("com.example.MyClass");

MyClass obj = (MyClass) clazz.newInstance();

- 使用 java.lang.Cloneable 接口和 clone() 方法:这种方法用于创建现有对象的复制品。对象需要实现 Cloneable 接口,并重写 clone() 方法。

MyClass obj1 = new MyClass();

MyClass obj2 = (MyClass) obj1.clone();

- 使用 Java 序列化 (java.io.Serializable 接口) 和反序列化:这种方法通常用于创建现有对象的复制品,但它不调用构造器。对象需要实现 Serializable 接口。

ObjectOutputStream out = new ObjectOutputStream(new FileOutputStream("data.obj"));

out.writeObject(obj1);

out.close();

ObjectInputStream in = new ObjectInputStream(new FileInputStream("data.obj"));

MyClass obj2 = (MyClass) in.readObject();

in.close();

- 使用 java.lang.ClassLoader 或者 java.lang.Class 的 defineClass() 方法:这种方法用于从一个类的二进制名称或者字节码创建一个新的类和对象。

ClassLoader classLoader = MyClass.class.getClassLoader();

Class<?> clazz = classLoader.loadClass("com.example.MyClass");

MyClass obj = (MyClass) clazz.newInstance();

Java9以后推荐的写法是:

ClassLoader classLoader = MyClass.class.getClassLoader();

Class<?> clazz = classLoader.getClass();

MyClass obj = (MyClass)clazz.getDeclaredConstructor().newInstance();

hashmap,为什么要转成红黑树,不是一开始就用?(2023 阿里实习)

在Java中,HashMap使用了链表和红黑树两种数据结构来存储数据。原因是,这两种数据结构在不同的情况下各有优缺点。让我们了解一下HashMap在何时以及为什么会将链表转换为红黑树。

链表

- 优点:相比于红黑树,链表结构更简单,占用空间较少,且在哈希冲突较少的情况下具有良好的性能。

- 缺点:链表在哈希冲突较多的情况下(即链表长度较长时),查找性能会明显下降,因为需要遍历链表。

红黑树

- 优点:红黑树是一种自平衡的二叉查找树,它能保证查找、插入和删除的时间复杂度为O(log n),在哈希冲突较多的情况下性能更优。

- 缺点:相比于链表,红黑树结构更复杂,占用空间较多,且在哈希冲突较少的情况下性能优势不明显。

为了在空间和时间上达到一个平衡,Java的HashMap采用了一种折中的策略。它在初始化时使用链表结构来存储数据,但当链表长度达到一定阈值时(默认为8),会将链表转换为红黑树结构。这样,当哈希冲突较少时,HashMap可以利用链表的空间优势;而在哈希冲突较多时,HashMap则能从红黑树的时间性能上受益。

因此,在Java中,HashMap不是一开始就使用红黑树,而是根据实际情况动态地选择并转换数据结构,以达到最佳性能。

Long 的长度和范围,为什么要减 1 ?(2023 快手)

先来复习一下 Java 中的 8 种基本数据类型:

6 种数字类型:

- 4 种整数型:

byte、short、int、long - 2 种浮点型:

float、double

- 4 种整数型:

1 种字符类型:

char1 种布尔型:

boolean。

这 8 种基本数据类型的默认值以及所占空间的大小如下:

| 基本类型 | 位数 | 字节 | 默认值 | 取值范围 |

|---|---|---|---|---|

byte | 8 | 1 | 0 | -128 ~ 127 |

short | 16 | 2 | 0 | -32768(-2^15) ~ 32767(2^15 - 1) |

int | 32 | 4 | 0 | -2147483648 ~ 2147483647 |

long | 64 | 8 | 0L | -9223372036854775808(-2^63) ~ 9223372036854775807(2^63 -1) |

char | 16 | 2 | 'u0000' | 0 ~ 65535(2^16 - 1) |

float | 32 | 4 | 0f | 1.4E-45 ~ 3.4028235E38 |

double | 64 | 8 | 0d | 4.9E-324 ~ 1.7976931348623157E308 |

boolean | 1 | false | true、false |

可以看到,像 byte、short、int、long能表示的最大正数都减 1 了。这是为什么呢?这是因为在二进制补码表示法中,最高位是用来表示符号的(0 表示正数,1 表示负数),其余位表示数值部分。所以,如果我们要表示最大的正数,我们需要把除了最高位之外的所有位都设为 1。如果我们再加 1,就会导致溢出,变成一个负数。

对于 boolean,官方文档未明确定义,它依赖于 JVM 厂商的具体实现。逻辑上理解是占用 1 位,但是实际中会考虑计算机高效存储因素。

另外,Java 的每种基本类型所占存储空间的大小不会像其他大多数语言那样随机器硬件架构的变化而变化。这种所占存储空间大小的不变性是 Java 程序比用其他大多数语言编写的程序更具可移植性的原因之一(《Java 编程思想》2.2 节有提到)。

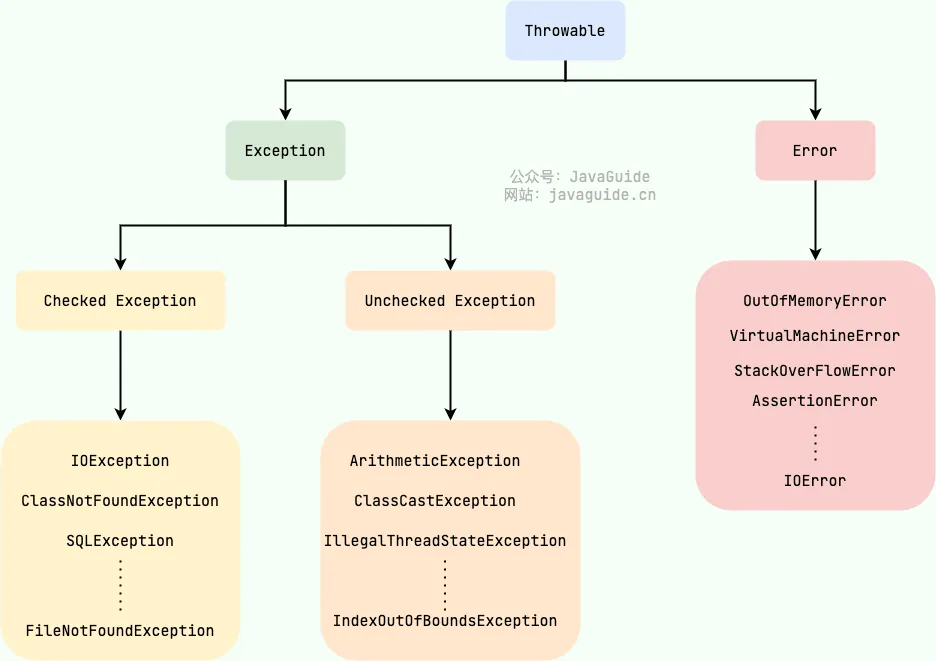

JAVA 异常的层次结构(2023 快手)

Java 异常类层次结构图概览:

在 Java 中,所有的异常都有一个共同的祖先 java.lang 包中的 Throwable类。Throwable 类有两个重要的子类:

Exception:程序本身可以处理的异常,可以通过catch来进行捕获。Exception又可以分为 Checked Exception (受检查异常,必须处理) 和 Unchecked Exception (不受检查异常,可以不处理)。Error:Error属于程序无法处理的错误 ,我们没办法通过catch来进行捕获不建议通过catch捕获 。例如 Java 虚拟机运行错误(Virtual MachineError)、虚拟机内存不够错误(OutOfMemoryError)、类定义错误(NoClassDefFoundError)等 。这些异常发生时,Java 虚拟机(JVM)一般会选择线程终止。

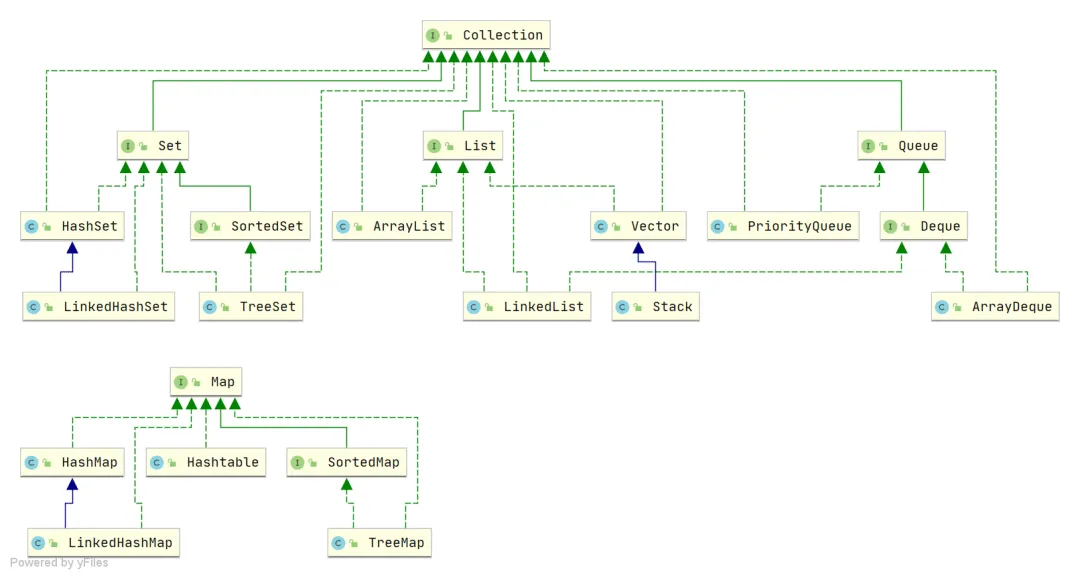

JAVA 的集合类有了解么?(2023 快手)

Java 集合, 也叫作容器,主要是由两大接口派生而来:一个是 Collection接口,主要用于存放单一元素;另一个是 Map 接口,主要用于存放键值对。对于Collection 接口,下面又有三个主要的子接口:List、Set 和 Queue。

Java 集合框架如下图所示:

注:图中只列举了主要的继承派生关系,并没有列举所有关系。比方省略了AbstractList, NavigableSet等抽象类以及其他的一些辅助类,如想深入了解,可自行查看源码。

List(对付顺序的好帮手): 存储的元素是有序的、可重复的。Set(注重独一无二的性质): 存储的元素不可重复的。Queue(实现排队功能的叫号机): 按特定的排队规则来确定先后顺序,存储的元素是有序的、可重复的。Map(用 key 来搜索的专家): 使用键值对(key-value)存储,类似于数学上的函数 y=f(x),"x" 代表 key,"y" 代表 value,key 是无序的、不可重复的,value 是无序的、可重复的,每个键最多映射到一个值。

try{return “a”} fianlly{return “b”}这条语句返回啥(2023 快手)

finally块中的return语句会覆盖try块中的return返回,因此,该语句将返回"b"。

String s = new String(“abc”)执行过程中分别对应哪些内存区域?(2023 快手)

首先,我们看到这个代码中有一个new关键字,我们知道new指令是创建一个类的实例对象并完成加载初始化的,因此这个字符串对象是在运行期才能确定的,创建的字符串对象是在堆内存上。

其次,在String的构造方法中传递了一个字符串abc,由于这里的abc是被final修饰的属性,所以它是一个字符串常量。在首次构建这个对象时,JVM拿字面量"abc"去字符串常量池试图获取其对应String对象的引用。于是在堆中创建了一个"abc"的String对象,并将其引用保存到字符串常量池中,然后返回;

所以,如果abc这个字符串常量不存在,则创建两个对象,分别是abc这个字符串常量,以及new String这个实例对象。如果abc这字符串常量存在,则只会创建一个对象。

Default修饰符和Proteted修饰符区别(2023 用友)

在Java中,访问修饰符决定了类及其成员的可见性。Java提供了四种访问级别,但在此我们将专注于“默认”(无修饰符)和“protected”修饰符。

默认访问修饰符(没有修饰符):

- 当一个类或其成员没有使用任何访问修饰符,它使用默认访问级别。

- 这被称为“包私有”或“包默认”。

- 在这种情况下,类或成员只能被其所在包内的其他类访问。

- 它们不能被包外的任何类访问。

// 在somepackage包中 class DefaultModifierClass { void defaultMethod() { System.out.println("This is a default method"); } }上述类

DefaultModifierClass及其方法defaultMethod只能在somepackage包中被访问。protected 访问修饰符:

- 当类或其成员使用protected修饰符时,它可以被其所在包中的所有类访问。

- 更重要的是,它还可以被外部包中的子类访问,但只能通过子类对象来访问。

- 不能直接被外部包中的其他类访问。

// 在somepackage包中 public class ProtectedModifierClass { protected void protectedMethod() { System.out.println("This is a protected method"); } }ProtectedModifierClass中的protectedMethod方法可以在somepackage中的任何地方被访问,并且还可以在其他包中的ProtectedModifierClass的子类中被访问。

自定义排序怎么实现?(2023 用友)

在Java中,实现自定义排序可以通过以下几种方法:

- 实现Comparable接口:该接口定义了一个compareTo方法,用于定义对象之间的比较规则。自定义的类需要实现Comparable接口,并在compareTo方法中实现比较逻辑。然后可以使用Arrays.sort()或Collections.sort()进行排序。

- 实现Comparator接口:Comparator接口定义了一个compare方法,用于定义对象之间的比较规则。自定义的类可以创建一个实现Comparator接口的比较器类,在比较器类中实现compare方法。然后可以使用Arrays.sort()或Collections.sort()并传入比较器对象进行排序。

下面是使用实现Comparable接口和Comparator接口的示例代码:

使用实现Comparable接口的方法:

public class Person implements Comparable<Person> {

private String name;

private int age;

// 构造函数和getter/setter方法省略

@Override

public int compareTo(Person other) {

if (this.age == other.age) {

return this.name.compareTo(other.name);

} else {

return Integer.compare(this.age, other.age);

}

}

}

// 使用Arrays.sort()进行排序

Person[] people = new Person[3];

people[0] = new Person("Alice", 23);

people[1] = new Person("Bob", 25);

people[2] = new Person("Charlie", 20);

Arrays.sort(people);

使用实现Comparator接口的方法:

public class PersonAgeComparator implements Comparator<Person> {

@Override

public int compare(Person p1, Person p2) {

return Integer.compare(p1.getAge(), p2.getAge());

}

}

// 使用Collections.sort()进行排序

List<Person> people = new ArrayList<>();

people.add(new Person("Alice", 23));

people.add(new Person("Bob", 25));

people.add(new Person("Charlie", 20));

Collections.sort(people, new PersonAgeComparator());

以上是两种常用的实现自定义排序的方法。通过实现Comparable接口或实现Comparator接口,可以根据自定义的比较规则对对象进行排序。

arraylist的addAll方法,如果容量为1,addAll一个容量为100000的数组,怎么扩容?(2023 用友)

在 Java 的 ArrayList 类中,当你使用 addAll 方法添加一个大量元素的集合时,内部会进行动态数组扩容。这个过程大致可以分为以下几步:

- 检查是否需要扩容:首先,会检查当前的

ArrayList是否有足够的空间来容纳新增的元素。如果没有,就需要进行扩容。 - 计算新的容量:

ArrayList的扩容机制通常是:新的容量 =(旧容量 * 3)/2 + 1。然而,在调用addAll的情况下,如果需要添加的元素数量比这个扩容后的新容量还要大,那么新容量将会设为需要添加的元素数量。 - 分配新数组并复制元素:根据计算出的新容量,会创建一个新的内部数组。然后,旧数组的元素会被复制到这个新数组中。

- 添加新元素:新的元素会被添加到新数组中的适当位置。

假设初始容量为1,然后你使用 addAll 添加一个容量为 100,000 的数组。在这种情况下,ArrayList 会首先计算需要多大的新容量才能存储所有新添加的元素,即最小需要 100,001 的容量。然后,它会创建一个这么大的新数组,并把旧数组和新添加的数组中的元素都复制到这个新数组中。

这样的扩容机制通常是为了优化性能。通过一次性分配一个足够大的数组,ArrayList 减少了多次扩容和数组复制的需要,从而提高了效率。

请注意,扩容操作是有代价的,因为它涉及到数组的复制。因此,在初始化 ArrayList 时,如果你已经知道会存储大量的元素,最好通过构造函数指定一个足够大的初始容量,以减少后续的扩容操作。

枚举类,可以new出来么(2023 用友)

Java枚举类是一种特殊的类,用于定义一组固定的常量。枚举类的实例在定义时就已经固定,无需使用new操作符进行实例化。

枚举类的实例必须放在第一行显示,每个实例都是public static final修饰的,最终以分号结束。在Java中,枚举类的定义方式如下:

public enum DayOfWeek {

SUNDAY, MONDAY, TUESDAY, WEDNESDAY, THURSDAY, FRIDAY, SATURDAY

}

在上述代码中,DayOfWeek是一个枚举类,它包含了一周的所有天数。这些枚举实例SUNDAY, MONDAY, TUESDAY, WEDNESDAY, THURSDAY, FRIDAY, SATURDAY都是DayOfWeek类的实例,可以通过DayOfWeek.SUNDAY等方式进行访问。

枚举类的实例在编译时即已确定,无法通过new操作符再次实例化。枚举类中的构造函数默认为私有化,不允许被外部调用。

Java抽象类和抽象方法抽象字段之间的因果关系?(2023 用友)

在Java中,抽象类、抽象方法和“抽象字段”之间的关系并不是真正的因果关系,但它们是紧密相关的。首先,我们来澄清各自的定义和概念:

抽象类 (Abstract Class):不能被实例化的类。它可能包含抽象方法和具体方法。它通常作为其他类的基类,并由子类提供实现。创建抽象类的目的是为了提供一个通用的、不能被实例化的基础框架。

public abstract class Animal { // ... 其他代码 }抽象方法 (Abstract Method):在抽象类中声明但没有实现的方法。子类继承抽象类时,必须实现这些抽象方法,除非子类也是抽象类。

public abstract class Animal { public abstract void makeSound(); }Java实际上并没有“抽象字段”的概念。当我们在抽象类中声明字段时,这些字段都是具有实际存储值的字段,即使它们在抽象类中。但是,你可以在抽象类中定义字段并期望子类提供具体的值或使用。

关系总结:

- 一个类如果有一个或多个抽象方法,那么这个类必须被声明为抽象类。

- 抽象类可以没有抽象方法。

- 抽象类不能被实例化,但它可以有构造方法,这通常用于子类调用。

- 抽象方法必须在子类中被实现,除非子类也是一个抽象类。

- 抽象类可以有字段(成员变量),这些字段不是抽象的,并且可以被子类使用或重写。

这种设计使得Java能够强制实现某些方法,而不仅仅是提供一个接口的框架,这为面向对象设计提供了很大的灵活性。

多线程下如何保证HashSet的安全性?(2023 用友)

在Java中,HashSet 是非线程安全的,这意味着如果多个线程同时修改一个HashSet,而没有适当的同步,那么它的行为是不确定的。要在多线程环境中保证 HashSet 的安全性,您可以考虑以下方法:

使用

Collections.synchronizedSet(): Java 的Collections类提供了一个synchronizedSet()方法,可以将给定的集合包装成线程安全的集合。Set<Object> set = Collections.synchronizedSet(new HashSet<>());使用这种方式时,需要注意的是,迭代这个集合仍然需要外部同步,因为可能在迭代期间其他线程进行了修改。例如:

synchronized(set) { for(Object item : set) { // do something } }使用

ConcurrentHashMap为基础的Set:ConcurrentHashMap是一个线程安全的Map实现。虽然它是一个Map,但我们可以使用它来创建一个线程安全的Set:Set<Object> set = Collections.newSetFromMap(new ConcurrentHashMap<>());这样得到的

Set是线程安全的,并且它的并发性能通常比synchronizedSet更好。使用

CopyOnWriteArraySet: 如果你预计集合的写操作相对较少,而读操作非常频繁,那么CopyOnWriteArraySet可能是一个很好的选择。这个集合在每次写操作时都会复制一份数据,从而确保读操作永远不会受到并发修改的干扰。但是,如果写操作非常频繁,性能可能会受到很大的影响。Set<Object> set = new CopyOnWriteArraySet<>();手动同步: 你可以选择为

HashSet操作添加自己的同步机制。但这通常是不推荐的,因为容易出错。

线程池的 BlockingQueue 有什么需要特别注意的(长度溢出相关)?(2023 得物)

Java线程池中的BlockingQueue是一种特殊的队列,它在多线程环境下实现了线程安全和阻塞的功能。在使用Java线程池中的BlockingQueue时,有几点需要特别注意:

- 类型选择:Java线程池提供了不同类型的BlockingQueue,例如ArrayBlockingQueue、LinkedBlockingQueue等,不同的类型适用于不同的场景。需要根据具体需求选择合适的BlockingQueue类型。

- 🌟 容量限制:线程池的BlockingQueue可以设置容量上限,这是为了控制任务的排队和执行。需要根据实际情况合理设置队列的容量,避免任务积压过多或者队列溢出。(高负载情况下,如果队列过长,可能会积累大量的任务,这样会占用大量的内存。设置过大的队列可能会导致内存溢出或者资源过度占用。)

- 阻塞机制:当BlockingQueue已满时,新的任务将被阻塞,直到队列中有空余位置。同样,当BlockingQueue为空时,获取任务的操作也会被阻塞,直到有新任务加入队列。需要注意处理好阻塞机制,避免出现死锁或线程饥饿等问题。

- 内存使用: 高负载情况下,如果队列过长,可能会积累大量的任务,这样会占用大量的内存。

引入专门的监控体系可以帮助你了解队列的使用状态,例如队列长度、处理速度等,这样可以及时进行调整。

ConcurrentHashMap 为什么 key 和 value 不能为 null?(2023 美团)

设计ConcurrentHashMap的作者是这样回答的:The main reason that nulls aren't allowed in ConcurrentMaps (ConcurrentHashMaps, ConcurrentSkipListMaps) is that ambiguities that may be just barely tolerable in non-concurrent maps can't be accommodated. The main one is that if map.get(key) returns null, you can't detect whether the key explicitly maps to null vs the key isn't mapped. In a non-concurrent map, you can check this via map.contains(key), but in a concurrent one, the map might have changed between calls.

主要原因是并发映射(ConcurrentMaps,ConcurrentHashMaps,ConcurrentSkipListMaps)不允许使用null的原因是,在非并发映射中可能勉强可以容忍的歧义无法适应。主要的一个问题是,如果map.get(key)返回null,你无法检测到该键是显式映射到null还是该键未映射(意思是:如果map可以保存null,则无法判断get返回null,是因为该值没有键,还是因为该值为null)。在非并发映射中,您可以通过map.contains(key)来检查此问题,但在并发映射中,调用之间可能会更改映射。

参考:

https://stackoverflow.com/questions/698638/why-does-concurrenthashmap-prevent-null-keys-and-values

如果不理解则进一步解释:当 map.get(key) 返回 null 时,我们不能确定这个 null 是因为键值实际上被映射为 null,还是因为这个键在映射中不存在。在一个非并发的 HashMap 中,你可以通过额外调用 map.contains(key) 来解决这个问题,从而确认这个键是否真的存在于映射中。然而,在并发环境下,这种额外的检查并不可靠,因为映射可能在 get 和 contains 调用之间被其他线程修改。也就是说,即使 contains 返回 true,也没有办法保证键仍然存在于映射中,或者其值没有被改变。这样的不确定性在并发环境中可能导致严重的问题或bug。为了解决这个问题,ConcurrentHashMap 简单地禁止了 null 值,这样 get 方法返回 null 就唯一地表示该键在映射中不存在。这消除了潜在的歧义,并使得代码更容易理解和维护。

HashMap在多线程情况下会产生哪些问题?会产生死锁吗?(2023 得物)

在多线程环境下,HashMap可能会遇到以下几个问题:

- 数据不一致:多个线程同时修改HashMap,可能导致数据状态不一致。

- 死循环:在扩容(rehashing)的过程中,如果两个线程同时尝试对同一个键进行插入,可能会造成链表转为环形,从而导致死循环。

- 结构不一致:一个线程在遍历HashMap的元素时,另一个线程修改了HashMap的结构(比如添加或删除元素),可能会抛出

ConcurrentModificationException。

至于死锁,HashMap本身的操作通常不会导致死锁,因为它不涉及多个资源的锁定。然而,在特定的使用场景或复杂的操作序列中,还是有可能产生死锁,但这通常是由于应用逻辑,而非HashMap本身造成的。如果需要在多线程环境下使用,建议使用线程安全的版本,如ConcurrentHashMap。

对于会变成环状的情况,在Java的HashMap实现中,有一个转移(transfer)的操作,该操作在HashMap扩容时进行。在这个过程中,如果两个线程同时尝试进行这个操作并且没有合适的同步机制,可能会导致链表形成一个环,从而使得HashMap进入一个无限循环状态。

这个问题在JDK 1.7中尤为明显,因为在这个版本中,链表没有优化为红黑树(JDK 1.8之后对这点进行了优化)。

下面的代码段是一个简化示例,并不是实际HashMap源码。但它可以用来说明在不同步的环境下如何可能导致一个循环链表。

class Node {

int key;

int value;

Node next;

Node(int key, int value) {

this.key = key;

this.value = value;

}

}

public class SimpleHashMap {

private Node[] table;

private int size;

public SimpleHashMap(int initialCapacity) {

table = new Node[initialCapacity];

size = 0;

}

public void put(int key, int value) {

if (size >= table.length * 0.75) { // 假设负载因子为0.75

resize();

}

int index = indexFor(key, table.length);

Node newNode = new Node(key, value);

newNode.next = table[index];

table[index] = newNode;

size++;

}

private void resize() {

Node[] newTable = new Node[table.length * 2];

transfer(newTable);

table = newTable;

}

private void transfer(Node[] newTable) {

for (Node node : table) {

if (node != null) {

// 下面的代码只是一个示例,没有考虑所有的细节。

// 如果两个线程同时执行这一段代码,可能会导致链表的环形结构。

int newIndex = indexFor(node.key, newTable.length);

Node newNode = new Node(node.key, node.value);

newNode.next = newTable[newIndex];

newTable[newIndex] = newNode;

}

}

}

private int indexFor(int key, int length) {

return key % length;

}

}

这个简化的HashMap实现在put方法中包含一个resize操作,该操作会在HashMap达到某个负载因子时被触发。

如果两个线程同时执行transfer方法,并且尝试修改相同的链表,由于没有适当的同步,可能会导致这些链表项互相引用,形成一个环。

要注意,这个例子只是为了演示可能的问题,并不是实际的HashMap实现。在实际的JDK实现中,这种问题可能更难以复现,但理论上是可能的。

假设有个hashmap上锁put,get不上锁会有线程安全问题吗?为什么?(2023 快手)

这样的做法会有线程安全问题。当你对HashMap进行put操作上锁,但get操作不上锁时,以下几种情况可能发生:

- 数据不一致:一个线程正在进行put操作,而另一个线程在进行get操作,这可能导致get操作返回一个不一致或者错误的数据。

- 内部结构问题:HashMap在扩容或者重新哈希时,其内部数据结构会发生变化。如果在这一过程中进行get操作,可能会导致不可预料的行为或错误。

- 可见性:如果一个线程修改了一个元素,但这个修改没有被其他线程看到(因为没有适当的内存屏障),那么其他线程获取到的将是一个过期或不正确的值。

🕝 并发编程

Java的线程池有哪些?(2023 阿里)

- ScheduledThreadPool:可以设置定期的执行任务,它支持定时或周期性执行任务,比如每隔 10 秒钟执行一次任务,我通过这个实现类设置定期执行任务的策略。

- FixedThreadPool:它的核心线程数和最大线程数是一样的,所以可以把它看作是固定线程数的线程池,它的特点是线程池中的线程数除了初始阶段需要从 0 开始增加外,之后的线程数量就是固定的,就算任务数超过线程数,线程池也不会再创建更多的线程来处理任务,而是会把超出线程处理能力的任务放到任务队列中进行等待。而且就算任务队列满了,到了本该继续增加线程数的时候,由于它的最大线程数和核心线程数是一样的,所以也无法再增加新的线程了。

- CachedThreadPool:可以称作可缓存线程池,它的特点在于线程数是几乎可以无限增加的(实际最大可以达到 Integer.MAX_VALUE,为 2^31-1,这个数非常大,所以基本不可能达到),而当线程闲置时还可以对线程进行回收。也就是说该线程池的线程数量不是固定不变的,当然它也有一个用于存储提交任务的队列,但这个队列是 SynchronousQueue,队列的容量为0,实际不存储任何任务,它只负责对任务进行中转和传递,所以效率比较高。

- SingleThreadExecutor:它会使用唯一的线程去执行任务,原理和 FixedThreadPool 是一样的,只不过这里线程只有一个,如果线程在执行任务的过程中发生异常,线程池也会重新创建一个线程来执行后续的任务。这种线程池由于只有一个线程,所以非常适合用于所有任务都需要按被提交的顺序依次执行的场景,而前几种线程池不一定能够保障任务的执行顺序等于被提交的顺序,因为它们是多线程并行执行的。

- SingleThreadScheduledExecutor:它实际和 ScheduledThreadPool 线程池非常相似,它只是 ScheduledThreadPool 的一个特例,内部只有一个线程。

线程池队列的底层?(2023 美团)

Java线程池的底层原理主要基于两个核心概念:线程复用和任务队列。

- 线程复用: 创建线程是一个昂贵的操作,线程池通过复用已创建的线程来降低资源消耗。这样,多个任务可以在预先创建的线程上执行,而不需要为每个任务都创建一个新线程。

- 任务队列: 当所有线程都在忙碌状态时,新来的任务会被放入一个队列中,等待线程空闲后再执行。

具体操作流程如下:

- 当一个新任务提交给线程池时,线程池首先会判断是否有空闲线程可用。如果有,直接在空闲线程上执行该任务。

- 如果没有空闲线程,但是线程池的线程数还未达到最大值,那么线程池会创建一个新线程来执行该任务。

- 如果所有线程都在忙碌状态,并且线程数已达最大值,该任务就会被放入任务队列。

- 线程池里的线程完成任务后会检查任务队列,看是否有等待的任务。如果有,它们会从队列中取出任务并执行。

- 在一些配置下,如果线程长时间处于空闲状态,它可能会被终止,以释放资源。

这样,线程池既可以复用线程,减少创建和销毁线程的开销,也能有效地管理和调度任务。常用的Java线程池实现有ExecutorService接口和其实现类,如ThreadPoolExecutor和ScheduledThreadPoolExecutor。

线程池的队列又分哪几种呢?(2023 美团)

首先看一下线程池参数:

public ThreadPoolExecutor(int corePoolSize, //线程池的核心线程数量

int maximumPoolSize, //线程池的最大线程数

long keepAliveTime, //当线程数大于核心线程数时,多余的空闲线程存活的最长时间

TimeUnit unit, //时间单位

BlockingQueue<Runnable> workQueue, //任务队列,用来储存等待执行任务的队列

ThreadFactory threadFactory, //线程工厂,用来创建线程,一般默认即可

RejectedExecutionHandler handler //拒绝策略,当提交的任务过多而不能及时处理时,我们可以定制策略来处理任务

)

探究的就是BlockingQueue<Runnable> workQueue类型:

- ArrayBlockingQueue: 基于数组结构的有界阻塞队列,需要预先设定其容量。

- LinkedBlockingQueue: 基于链表结构的阻塞队列,可以是有界的,也可以是无界的(理论上,直到内存耗尽)。

- PriorityBlockingQueue: 一个具有优先级的无界阻塞队列。

- SynchronousQueue: 一个没有存储空间的阻塞队列,每个插入操作必须等待一个相应的删除操作。

- DelayedQueue: 一个阻塞队列,只有当任务到达指定的延迟时间时才能从队列中提取。

不同类型的队列有各自的适用场景和优缺点。例如,ArrayBlockingQueue和LinkedBlockingQueue通常用于存储大量的任务,而SynchronousQueue通常用于直接将任务传递给工作线程。

线程池的拒绝策略能自定义拒绝策略吗?(2023 阿里)

Java线程池拒绝策略是可以自定义的。你可以使用RejecttedExecutionHandler接口来定义你自己的拒绝策略。该接口只有一个方法拒绝执行(Runnable r,ThreadPoolExecator执行器),当执行器无法执行任务时调用。你可以实现这个方法来定义你自己的拒绝策略。

示例:

public class CustomRejectedExecutionHandler implements RejectedExecutionHandler {

@Override

public void rejectedExecution(Runnable r, ThreadPoolExecutor executor) {

// Your custom rejection policy here

}

}

ThreadPoolExecutor executor = new ThreadPoolExecutor(

corePoolSize,

maxPoolSize,

keepAliveTime,

TimeUnit.SECONDS,

new LinkedBlockingQueue<>(),

new CustomRejectedExecutionHandler()

);

线程池配置无界队列了之后,拒绝策略怎么搞,什么时候用到无界对列?(2023 快手)

线程池配置无界队列了之后,拒绝策略其实就失去了意义,因为无论有多少任务提交到线程池,都会被放入队列中等待执行,不会触发拒绝策略。不过,这样可能堆积大量的请求,从而导致 OOM。因此,一般不推荐使用误解队列。

假设不是无界队列的话,如果当前同时运行的线程数量达到最大线程数量并且队列也已经被放满了任务时,ThreadPoolTaskExecutor 定义一些拒绝策略:

ThreadPoolExecutor.AbortPolicy:抛出RejectedExecutionException来拒绝新任务的处理。ThreadPoolExecutor.CallerRunsPolicy:调用执行自己的线程运行任务,也就是直接在调用execute方法的线程中运行(run)被拒绝的任务,如果执行程序已关闭,则会丢弃该任务。因此这种策略会降低对于新任务提交速度,影响程序的整体性能。如果您的应用程序可以承受此延迟并且你要求任何一个任务请求都要被执行的话,你可以选择这个策略。ThreadPoolExecutor.DiscardPolicy:不处理新任务,直接丢弃掉。ThreadPoolExecutor.DiscardOldestPolicy:此策略将丢弃最早的未处理的任务请求。

举个例子:

Spring 通过 ThreadPoolTaskExecutor 或者我们直接通过 ThreadPoolExecutor 的构造函数创建线程池的时候,当我们不指定 RejectedExecutionHandler 饱和策略的话来配置线程池的时候默认使用的是 ThreadPoolExecutor.AbortPolicy。在默认情况下,ThreadPoolExecutor 将抛出 RejectedExecutionException 来拒绝新来的任务 ,这代表你将丢失对这个任务的处理。对于可伸缩的应用程序,建议使用 ThreadPoolExecutor.CallerRunsPolicy。当最大池被填满时,此策略为我们提供可伸缩队列(这个直接查看 ThreadPoolExecutor 的构造函数源码就可以看出,比较简单的原因,这里就不贴代码了)。

使用多线程要注意哪些问题?(2023 美团)

使用多线程时需要注意以下问题:

- 线程安全:当多个线程同时访问某一数据时,如果不进行正确的同步控制,可能会导致数据的不一致。需要通过使用synchronized,Lock,volatile等机制来保证线程安全。

- 死锁:死锁是指两个或两个以上的线程在执行过程中,因争夺资源而造成的一种互相等待的现象,若无外力干涉那他们都将无法推进下去。我们应避免在代码中产生死锁。

- 活锁:活锁指的是线程虽然没有被阻塞,但是由于某种条件没有被满足,始终无法向前执行,就像在原地踏步。

- 饥饿:由于线程的优先级设置不合理或者锁机制不公平,导致某些线程始终无法获取到CPU资源或者锁资源,从而无法进行工作。

- 资源消耗:每个线程都会占用一定的内存资源,过多的线程可能会导致系统资源消耗过大。同时,线程上下文切换也会消耗CPU资源,过多的线程也可能会导致CPU负载过大。

- 数据共享和可见性:多线程之间共享数据,需要保证一个线程对数据的修改对其他线程可见,可以使用volatile或者Atomic类来保证。

- 线程的生命周期管理:需要合理的创建、启动、暂停、恢复、终止线程,不合理的管理可能会导致程序错误或者资源泄漏。

- 线程异常处理:线程中的未捕获异常会导致线程终止,而且这个异常不能被外部捕获。需要为线程设置UncaughtExceptionHandler来处理未捕获的异常。

保证数据的一致性有哪些方案呢?(2023 美团)

在Java中,有多种方式可以保证数据的一致性:

- 同步语句块(Synchronized Blocks):在Java中,你可以使用synchronized关键字对一个对象或者方法进行锁定,来保证在一个时刻只有一个线程可以访问该对象或者方法,从而避免数据的不一致。

- Volatile关键字:volatile关键字可以保证变量的可见性。当一个共享变量被volatile修饰时,它会保证修改的值会立即被更新到主存,当有其他线程需要读取时,它会去主存中读取新值。

- 原子类(Atomic Classes):Java提供了一组原子类(如AtomicInteger、AtomicLong等),它们使用了高效的机器级指令来保证原子性操作,从而避免了复杂的同步。

- Lock接口和相关类:Java并发库提供了显式的锁机制,包括ReentrantLock、ReadWriteLock等,可以提供比synchronized更灵活的锁定机制。

- 并发集合(Concurrent Collections):Java提供了一组并发集合类(如ConcurrentHashMap、CopyOnWriteArrayList等),它们内部已经实现了并发控制,可以在并发环境中安全使用。

- 事务(Transactions):在数据库和某些支持事务的系统中,可以通过事务来保证数据的一致性。Java中的JPA和Spring等框架提供了对事务的支持。

以上就是在Java中保证数据一致性的一些常用方案,选择哪种方案取决于具体的应用场景和需求。

怎么获取子线程的返回值?(2023 阿里实习)

在Java中,若要获取子线程的返回值,可以使用Callable接口和Future类。Callable接口允许你定义一个返回值的任务,而Future类则代表这个任务的结果。为了获取子线程的返回值,首先创建一个实现Callable接口的类,并重写call()方法。然后,将这个Callable对象提交给ExecutorService,它会返回一个Future对象。通过调用Future对象的get()方法,主线程可以等待并获取子线程的返回值。

import java.util.concurrent.Callable;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

import java.util.concurrent.Future;

public class Main {

public static void main(String[] args) {

ExecutorService executor = Executors.newSingleThreadExecutor();

Callable<Integer> task = new Callable<Integer>() {

@Override

public Integer call() throws Exception {

// 这里写你的子线程逻辑,并返回结果

int result = 0;

for (int i = 1; i <= 10; i++) {

result += i;

}

return result;

}

};

Future<Integer> future = executor.submit(task);

try {

// 主线程等待并获取子线程的返回值

Integer result = future.get();

System.out.println("子线程的返回值: " + result);

} catch (InterruptedException | ExecutionException e) {

e.printStackTrace();

} finally {

executor.shutdown();

}

}

}

子线程抛异常,主线程 try-catch 是否可以获取到异常?(2023 阿里实习)

答案:可以。

当使用 Callable 和 Future 时,如果子线程在执行过程中抛出异常,主线程可以通过调用 Future.get() 方法时捕获异常来获取它。Future.get() 方法可以抛出一个 ExecutionException,这个异常包装了子线程抛出的真实异常。要获取子线程的异常,你可以在主线程的 try-catch 语句中捕获 ExecutionException,然后调用 getCause() 方法来获取子线程的异常。

import java.util.concurrent.Callable;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

import java.util.concurrent.Future;

public class Main {

public static void main(String[] args) {

ExecutorService executor = Executors.newSingleThreadExecutor();

Callable<Integer> task = new Callable<Integer>() {

@Override

public Integer call() throws Exception {

// 这里故意抛出一个异常

throw new RuntimeException("子线程抛出异常");

}

};

Future<Integer> future = executor.submit(task);

try {

// 主线程等待并获取子线程的返回值

Integer result = future.get();

} catch (InterruptedException e) {

e.printStackTrace();

} catch (ExecutionException e) {

// 获取并处理子线程抛出的异常

Throwable cause = e.getCause();

System.out.println("子线程抛出的异常: " + cause.getMessage());

} finally {

executor.shutdown();

}

}

}

AtomicInteger是怎么更新保证原子性的?(2023 小红书)

AtomicInteger 是 Java 并发包 java.util.concurrent.atomic 中的一个类,它用于执行原子操作。原子操作是一种不可中断的操作,无论在任何情况下,只要这个操作开始,就会运行到结束,不会出现中间态。这是一种避免多线程并发问题的常用手段。

AtomicInteger 在内部通过很低级的原子硬件指令直接支持原子性。主要使用了一种名为“Compare and Swap”(CAS,比较并交换)的算法来实现原子性。这种算法使用三个参数:一个内存位置 V、预期的原始值 A 和新值 B。该算法仅当内存位置 V 的当前值与预期的原始值 A 相匹配时,才会将内存位置 V 的值更新为新值 B。如果内存位置 V 的当前值与预期值 A 不匹配,那么操作会失败,通常这个操作会在一个循环中进行,直到操作成功。

public final boolean compareAndSet(int expect, int update) {

return unsafe.compareAndSwapInt(this, valueOffset, expect, update);

}

AtomicInteger 的源码中,使用 Unsafe 类的 CAS 操作来实现:

private static final Unsafe unsafe = Unsafe.getUnsafe();

private static final long valueOffset;

static {

try {

valueOffset = unsafe.objectFieldOffset

(AtomicInteger.class.getDeclaredField("value"));

} catch (Exception ex) { throw new Error(ex); }

}

public final int getAndIncrement() {

return unsafe.getAndAddInt(this, valueOffset, 1);

}

unsafe.getAndAddInt() 方法实现了 CAS,它会获取当前值,加 1,并比较当前值是否改变,如果没有改变则更新,否则重新获取值。

所以 AtomicInteger 通过 CAS 无锁操作实现了线程安全的递增操作。

Future抛出的两个异常的对比,都有什么用?(2023 百度提前批)

在Java中,Future接口在其方法执行过程中可能会抛出以下异常:

InterruptedException:当线程在等待、睡眠或其他占用时间的操作中被中断时可能会抛出此异常。例如,

Future.get()方法会在等待计算完成时抛出此异常,如果线程在等待过程中被中断。Future<Integer> future = executor.submit(callable); try { Integer result = future.get(); } catch (InterruptedException e) { // handle exception }ExecutionException:如果

Future的计算抛出异常,那么Future.get()方法会抛出这个异常。这个异常的原因可以通过ExecutionException.getCause()获得。Future<Integer> future = executor.submit(callable); try { Integer result = future.get(); } catch (ExecutionException e) { Throwable cause = e.getCause(); // handle exception }TimeoutException:当

Future.get(long timeout, TimeUnit unit)在超时时间内没有得到结果时,会抛出此异常。Future<Integer> future = executor.submit(callable); try { Integer result = future.get(5, TimeUnit.SECONDS); } catch (TimeoutException e) { // handle exception }CancellationException:当尝试取回已经取消的任务的结果时,会抛出此异常。

Future<Integer> future = executor.submit(callable); future.cancel(true); try { Integer result = future.get(); } catch (CancellationException e) { // handle exception }

请注意,这些异常都必须被捕获和处理,因为它们都是java.lang.Exception的子类,是已检查的异常。

参考:

- https://stackoverflow.com/questions/2665569/in-what-cases-does-future-get-throw-executionexception-or-interruptedexception 在什么情况下Future. get()抛出ExecutionException或InterruptedException

- https://stackoverflow.com/questions/2248131/handling-exceptions-from-java-executorservice-tasks 处理ExecutorService任务Java异常

- https://www.baeldung.com/java-future

- https://docs.oracle.com/javase/8/docs/api/java/util/concurrent/Future.html

线程池任务提交,比如调用execute或submit API之后的流程有了解吗?(2023 影石360)

在Java中,线程池是一个在后台运行的线程集合,可以用来执行并发任务。当我们在线程池中调用execute或submit方法时,线程池会处理任务的调度和执行。以下是一个简要的流程描述:

- 任务提交:当一个新任务通过

execute()或submit()方法提交到线程池时,线程池首先会判断当前活跃的线程数量是否小于corePoolSize(核心线程数)。 - 任务分配:

- 如果小于

corePoolSize,线程池会创建一个新的线程来执行这个任务,即使其他线程是空闲的。 - 如果大于或等于

corePoolSize,线程池会尝试将任务添加到工作队列(workQueue)。 - 如果工作队列已满,且活跃线程数量小于

maximumPoolSize(最大线程数),线程池会创建一个新的线程来处理这个任务。 - 如果工作队列已满,且活跃线程数量等于

maximumPoolSize,线程池会根据其饱和策略(RejectedExecutionHandler)来处理这个任务。

- 如果小于

- 任务执行:线程池中的线程从工作队列中取出任务并执行。如果线程在执行任务时发生异常,将会被线程池捕获,并根据具体的情况决定是否需要替换这个线程。

- 任务完成:当一个任务完成时,线程会返回到线程池并保持空闲状态,等待下一个任务的分配。

请注意,execute()方法和submit()方法有一些区别:

execute()方法用于提交没有返回值的任务,所以它不会返回任何东西。submit()方法用于提交需要返回值的任务。它返回一个Future对象,通过这个Future对象可以获取任务的结果。

AQS队列中的任务怎么知道锁被释放了?(2023 美团)

AQS 使用一个 int 成员变量来表示同步状态,并基于一个 FIFO 队列来管理那些尝试获取资源但失败的线程。

当线程尝试获取资源但失败时,它会被包装成一个节点(Node)并加入到 AQS 的等待队列中。每个节点包含一个指向前一个节点的链接(prev)和一个指向后一个节点的链接(next),这形成了一个双向链表。

那么,一个节点(线程)如何知道锁已经被释放了呢?这主要是通过以下方式来实现的:

- 状态变量:AQS 中的状态变量是一个核心组件。当一个线程释放锁时,它会尝试将状态变量设为 0 或相应的值。任何尝试获取锁的线程都会首先检查这个状态变量。

- 前驱节点:当一个线程尝试获取锁并失败时,它会被放到等待队列中,并且通常会进入休眠模式。当它前面的节点(它的前驱)成功获取并随后释放锁时,这个节点的线程会被唤醒。这是通过前驱节点直接唤醒其后继节点的线程来实现的。

- LockSupport:AQS 使用

LockSupport.park()和LockSupport.unpark(thread)方法来挂起和唤醒线程。当一个线程不能获取锁时,它会被挂起(即调用LockSupport.park())。当锁被释放时,相应的线程(通常是等待队列中的头部线程)会被唤醒,即调用LockSupport.unpark(thread)。

综上所述,当锁被释放时,正在等待的线程知晓这个变化是通过检查状态变量、前驱节点的通知,以及 LockSupport 的挂起/唤醒机制来实现的。

🍃 常用框架

MyBatis运用了哪些常见的设计模式?(2023 美团)

- 工厂模式,工厂模式在 MyBatis 中的典型代表是 SqlSessionFactory

- 建造者模式,建造者模式在 MyBatis 中的典型代表是 SqlSessionFactoryBuilder

- 单例模式,单例模式在 MyBatis 中的典型代表是 ErrorContext

- 适配器模式,适配器模式在 MyBatis 中的典型代表是 Log

- 代理模式,代理模式在 MyBatis 中的典型代表是 MapperProxyFactory

- 模板方法模式,模板方法在 MyBatis 中的典型代表是 BaseExecutor

- 装饰器模式,装饰器模式在 MyBatis 中的典型代表是 Cache

- 迭代器模式,如迭代器模式Properties tyTokenizer;

- 组合模式,如SqlNode和每个子类ChooseSqlNode;

参考文献:

- https://programming.vip/docs/6200e8e7b682c.html 【Mybatis源码解析】Mybatis源码涉及的设计模式总结

- https://programming.vip/docs/mybatis-design-pattern.html Mybatis设计模式

MyBatis中创建了一个Mapper接口,在写一个xml文件,java的接口是要实现的,为什么这没有实现呢?(2023 美团)

MyBatis中的Mapper接口并不需要实现,它只是定义了一组方法签名。MyBatis会根据Mapper接口中的方法名、参数类型和返回值类型,自动生成实现方法。因此,Mapper接口中的方法不需要实现,也不需要在该接口中编写任何方法体。

相反,你需要编写一个与Mapper接口同名的XML文件,来实现这些方法的具体SQL操作。这样,当你在Java代码中调用Mapper接口中的方法时,MyBatis会自动将该方法映射到对应的XML文件中的SQL语句,并执行该语句。

与传统的JDBC相比,MyBatis的优点?(2023 美团)

在面试中,可以按照以下的方式来回答:

- 首先,我认为最大的优点是MyBatis提供了更高的灵活性。我们可以直接编写SQL,这样可以充分利用数据库的特性并且更好地控制查询。

- 其次,MyBatis使我们无需手动转换数据,它能自动将结果集映射到Java对象,这大大简化了编程工作。

- 此外,MyBatis支持动态SQL,我们可以在SQL语句中使用动态元素,如if、choose等,从而能够创建更复杂的查询。

- 除此之外,MyBatis将SQL语句放在XML文件或注解中,实现了SQL与Java代码的分离,这使得代码更加易于维护。

- MyBatis也能更好地处理一对多、多对多等复杂关系。

- 最后,MyBatis提供了一些JDBC无法提供的特性,如延迟加载,这对于性能优化是非常有用的。

JDBC连接数据库的步骤(2023 美团)

- 加载数据库驱动程序:首先,我们需要加载数据库驱动。这可以通过 Class.forName() 方法实现,例如 Class.forName("com.mysql.jdbc.Driver")。

- 建立数据库连接:使用DriverManager.getConnection()方法建立与数据库的连接,需要指定数据库的URL、用户名和密码,例如:Connection conn = DriverManager.getConnection("jdbc:mysql://localhost/mydatabase", "username", "password");

- 创建Statement对象:使用Connection对象的createStatement()方法创建一个Statement对象,用于执行SQL语句,例如:Statement stmt = conn.createStatement();

- 执行SQL语句:使用Statement对象的executeQuery()或executeUpdate()方法执行SQL语句,例如:ResultSet rs = stmt.executeQuery("SELECT * FROM mytable");

- 处理查询结果:如果执行的是查询语句,需要使用ResultSet对象来处理查询结果,例如:while (rs.next())

- 关闭数据库连接:在程序结束时,需要使用Connection对象的close()方法关闭数据库连接,例如:conn.close();

怎么理解SpringIoc?(2023 美团)

IoC(Inversion of Control)是“控制反转” 的缩写,是一种设计思想,也是Spring框架的核心。IoC是将你设计好的对象交给容器控制,而不是传统的在你的对象内部直接控制。如何理解好IoC呢?可以从以下几点来看:

- 控制反转:传统的程序是由我们自己在对象内部通过new进行创建对象,是由程序控制对象的创建。在Spring框架中,对象的创建是由Spring容器来进行的,它负责控制对象的生命周期。所谓“控制反转”就是把传统的有我们自己控制的对象创建过程交给Spring框架来做。

- 依赖注入:IoC的一个重要的具体实现方法是DI(Dependency Injection),也叫作依赖注入。在我们设计好的对象中会有一些其他对象的引用(即依赖),如果没有Spring容器,我们需要使用很多复杂的方法来管理这些依赖。而有了Spring容器,我们只需要告诉Spring这些依赖即可,Spring会自动把这些依赖注入到对象中。

- 容器:在Spring的IoC下,Spring容器是一个非常重要的角色,它包含并管理了应用中定义的各种组件,负责实例化、配置、装配对象,管理对象的整个生命周期。

- 减轻耦合:通过IoC,对象间的耦合度可以降低,对象只需要关注自身的业务逻辑,而不需要关心其他对象是如何创建和管理的,大大增强了代码的可维护性和可测试性。

- 提供配置:Spring容器可以使用XML、Java注解、Java代码等多种方式来进行配置,提供了非常大的灵活性。

如果让你设计一个SpringIoc,你觉得会从哪些方面考虑这个设计?(2023 美团)

- Bean的生命周期管理:需要设计Bean的创建、初始化、销毁等生命周期管理机制,可以考虑使用工厂模式和单例模式来实现。

- 依赖注入:需要实现依赖注入的功能,包括属性注入、构造函数注入、方法注入等,可以考虑使用反射机制和XML配置文件来实现。

- Bean的作用域:需要支持多种Bean作用域,比如单例、原型、会话、请求等,可以考虑使用Map来存储不同作用域的Bean实例。

- AOP功能的支持:需要支持AOP功能,可以考虑使用动态代理机制和切面编程来实现。

- 异常处理:需要考虑异常处理机制,包括Bean创建异常、依赖注入异常等,可以考虑使用try-catch机制来处理异常。

- 配置文件加载:需要支持从不同的配置文件中加载Bean的相关信息,可以考虑使用XML、注解或者Java配置类来实现。

Spring给我们提供了很多扩展点,这些有了解吗?(2023 美团)

- BeanFactoryPostProcessor:允许在Spring容器实例化bean之前修改bean的定义。常用于修改bean属性或改变bean的作用域。

- BeanPostProcessor:可以在bean实例化、配置以及初始化之后对其进行额外处理。常用于代理bean、修改bean属性等。

- PropertySource:用于定义不同的属性源,如文件、数据库等,以便在Spring应用中使用。

- ImportSelector和ImportBeanDefinitionRegistrar:用于根据条件动态注册bean定义,实现配置类的模块化。

- Spring MVC中的HandlerInterceptor:用于拦截处理请求,可以在请求处理前、处理中和处理后执行特定逻辑。

- Spring MVC中的ControllerAdvice:用于全局处理控制器的异常、数据绑定和数据校验。

- Spring Boot的自动配置:通过创建自定义的自动配置类,可以实现对框架和第三方库的自动配置。

- 自定义注解:创建自定义注解,用于实现特定功能或约定,如权限控制、日志记录等。

大致了解SpringMVC的处理流程吗?(2023 美团)

- 接收请求:用户发送请求至前端控制器DispatcherServlet。

- 查找处理器映射:DispatcherServlet收到请求后,调用HandlerMapping处理器映射器。

- 处理器映射返回处理器执行链:HandlerMapping根据请求的URL找到对应的Controller并返回一个HandlerExecutionChain对象(包含一个Handler处理器(页面控制器)对象,多个HandlerInterceptor拦截器对象)。

- 调用处理器适配器:DispatcherServlet通过HandlerAdapter进行多类型的页面控制器的适配,调用对应的Controller(处理器)。

- Controller执行业务逻辑:Controller开始执行页面控制器的处理方法,并返回一个ModelAndView对象(模型和视图)。

- 视图解析:DispatcherServlet通过视图解析器进行解析(根据逻辑视图名解析成实际视图/页面),并将ModelAndView对象中的模型数据填充到request域对象中。

- 返回视图:DispatcherServlet把返回的视图对象返回给用户。

SpringAOP主要想解决什么问题(2023 美团)

- 代码分离:在许多应用程序中,你可能会发现你需要在多个方法或对象中重复相同的代码块,比如日志记录、事务管理、权限检查等。这种情况下,代码不是真正的分离,各部分功能模块的职责并不清晰。通过使用AOP,你可以把这些代码集中在一起,然后应用到程序的其他部分,实现"横切关注点"(cross-cutting concerns)的有效管理。

- 维护性:如果你需要修改一些重复的代码(比如更改日志记录的格式),你可能需要在多个位置进行更改。使用AOP,你只需要在一个地方更改,减少了出错的可能性,提高了代码的维护性。

- 可读性:AOP可以使得代码的可读性增强。因为重复的、固定的代码被分离出来,业务代码更加清晰,易于理解。

- 可重用性:由于AOP能将横切关注点抽象成独立的模块,这些模块可以在多个应用中重用。

总的来说,Spring AOP能够让开发者更好地关注业务逻辑的开发,而将诸如日志记录、安全控制、事务处理等公共任务抽象和集中处理,从而提高代码的可维护性、可读性和可重用性。

🔥 SpringAOP的原理了解吗(2023 美团、2023 完美世界、2023 影石360、2023 快手)

序言

面向切面编程(AOP)是一种编程范式,它允许开发人员定义跨多个方法和类的关注点。AOP 的主要目的是将程序中分散的功能(例如日志、安全等)模块化,并能够在不修改核心业务逻辑代码的情况下,将这些功能插入到程序的不同部分。

核心概念和原则

- 切面(Aspect): 切面是一个模块,其中定义了一个或多个“关注点”或“交叉关注点”。简单来说,它是我们想要实现的功能或行为。例如,日志记录、事务管理和安全性都可以是切面。

- 连接点(Join Point): 连接点是程序中的某个特定位置,如方法执行、异常处理等,我们可以在这些位置插入切面的代码。在Spring AOP中,连接点主要是指方法执行。

- 通知(Advice): 通知是切面在特定的连接点执行的代码片段。Spring AOP包括以下五种类型的通知:

- 前置通知(Before advice): 在连接点之前执行。

- 后置通知(After returning advice): 在连接点成功执行后执行。

- 异常通知(After throwing advice): 如果在连接点抛出异常,则执行。

- 最终通知(After (finally) advice): 在连接点执行后,无论成功还是异常都会执行。

- 环绕通知(Around advice): 在连接点前后都可以执行。

- 切点(Pointcut): 切点是一组表达式,用于指定哪些连接点需要被通知。它告诉AOP框架在何处应用通知。

- 目标对象(Target Object): 目标对象是包含连接点的对象。Spring AOP代理的目标对象通常是一个被代理的对象。

- 代理(Proxy): AOP代理是用于实现切面的对象。在Spring中,AOP代理可以是JDK动态代理或CGLIB代理。

- 织入(Weaving): 织入是将切面插入到目标对象中以创建代理对象的过程。这可以在编译时、加载时或运行时完成。

步骤

- 定义切面: 创建一个类,并在该类中定义需要注入的关注点。

- 定义通知: 在切面类中,定义一些方法,并使用Spring AOP的注解来标注这些方法是哪种类型的通知。

- 定义切点: 使用

@Pointcut注解定义表达式,指定在哪些方法上应用通知。 - 应用切面: 使用Spring的配置(XML或Java)来启用AOP并应用切面。

总的来说,Spring AOP提供了一种强大而灵活的方式来增加关注点或行为,而无需修改原始代码。这大大简化了例如日志记录、事务管理和安全性等交叉关注点的实现。希望这个解释有助于您了解Spring AOP的基本原则!如果您有进一步的问题或需要详细的示例,请告诉我!

面试的时候可以这样回答: 🙋♂️ "Spring AOP 是一种面向切面编程的实现,它通过动态代理方式解耦了业务逻辑和系统服务。其主要组成部分包括 JoinPoint(程序执行过程中的某个特定点,如方法调用),PointCut(一组可以通过表达式或规则定义的 JoinPoint),Advice(在特定的 JoinPoint 执行的代码),和 Aspect(包含 Advice 和 PointCut 的模块)。 Spring AOP 根据目标对象是否实现接口来选择使用 JDK 动态代理还是 CGLIB 代理。如果目标对象实现了接口,Spring AOP 就会用 JDK 动态代理,否则会用 CGLIB 代理。这样,在运行时,Spring AOP 可以动态地将 Advice 应用到目标对象,实现系统服务和业务逻辑的解耦。 通过这种方式,我们可以将一些通用的系统服务(比如事务管理、日志、安全等)抽象出来,从而使业务代码更简洁、更易于维护和复用。"

拦截器有几个方法,分别在什么时候执行,对比过滤器(2023 完美世界)

拦截器和过滤器是Web开发中常用的两种处理方法。这里我假设你指的是Spring MVC拦截器和Java Servlet过滤器。 拦截器 (Interceptor) 在Spring MVC中通常有3个方法:

preHandle(HttpServletRequest request, HttpServletResponse response, Object handler): 在请求被处理之前调用。如果返回true,处理流程继续;如果返回false,处理流程结束,不会调用后续的拦截器和处理器。postHandle(HttpServletRequest request, HttpServletResponse response, Object handler, ModelAndView modelAndView): 在请求被处理之后,视图被渲染之前调用。可以通过它来修改数据模型和视图或进行其他处理。afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex): 在请求处理完毕后(视图渲染后)调用,通常用于进行资源清理等工作。

过滤器 (Filter) 在Java Servlet API中通常有三个方法:

- init(FilterConfig filterConfig): 在服务器启动时,创建Filter对象时调用。

- doFilter(ServletRequest request, ServletResponse response, FilterChain chain): 每次在过滤请求时调用。可以进行逻辑处理,然后使用chain.doFilter(request, response);将请求传递到链中的下一个过滤器或资源(servlet或静态内容)。

- destroy(): 在服务器关闭时,销毁Filter对象时调用。

比较:

- 相较于过滤器,拦截器更加灵活和强大。拦截器是基于Java的反射机制的,它在运行时动态地将逻辑插入到方法调用中,而不需要改变源码。此外,拦截器可以获得Spring容器中的各种bean,从而有更多的操作。

- 过滤器则主要用于请求的过滤处理,包括日志记录、请求压缩、安全检查、用户登录校验等。它的运行速度一般比拦截器快,但功能上不如拦截器强大。

导入一个 jar 包怎么让 springboot 知道哪些需要自动配置(2023 完美世界)

Spring Boot自动配置是通过@EnableAutoConfiguration注解实现的。它基本上是通过查找并加载META-INF/spring.factories配置文件来完成的。 如果你想要将你的jar包在Spring Boot项目中进行自动配置,你需要以下步骤:

- 在你的jar包中创建一个spring.factories文件,并将其放入META-INF目录下

- 在spring.factories文件中添加你的自动配置类,格式如下

org.springframework.boot.autoconfigure.EnableAutoConfiguration=\

com.yourpackage.YourAutoConfigurationClass

- 确保你的AutoConfiguration类使用了@Configuration,并在需要的bean上使用了@Bean注解。

这样,当Spring Boot项目启动时,它会读取META-INF/spring.factories文件,并自动配置那些bean。

请注意,你的AutoConfiguration类应该尽可能的"幂等",意味着多次运行结果应该是一致的,并且应该对已有的Bean有所尊重,如果容器中已经存在了你要创建的Bean,你应该避免再次创建。

另外,你可能需要使用@Conditional注解以避免在不需要的情况下创建bean。

Spring IOC 中的 FactoryBean和BeanFactory?(2023 京东)

BeanFactory

- 职责:

BeanFactory是 Spring 的核心接口,负责管理容器中的 Bean。它维护着 Bean 的定义以及依赖关系,还负责创建和装配 Bean。 - 生命周期:

BeanFactory负责整个 Bean 的生命周期,包括 Bean 的创建、初始化、依赖注入、销毁等。 - 配置:通常来说,我们很少直接使用

BeanFactory,更多情况下我们使用的是ApplicationContext,这是一个更高级的容器,也是BeanFactory的一个子接口。 - 使用场景:通常在小型应用或者资源受限的环境下,我们可能会直接使用

BeanFactory。

FactoryBean

- 职责:

FactoryBean是一个特殊的 Bean,用于生成其他 Bean 实例。通常当创建某个 Bean 需要复杂的初始化逻辑时,会使用FactoryBean。 - 生命周期:

FactoryBean自身也是一个 Bean,因此它也是由BeanFactory管理的。当其他 Bean 依赖于由FactoryBean创建的 Bean 时,FactoryBean.getObject()方法会被调用,用于生成那个 Bean。 - 配置:

FactoryBean通常在 Spring 配置文件中定义,就像其他普通的 Bean 一样。 - 使用场景:

FactoryBean在 Spring 框架自身和第三方库中被广泛使用,用于生成如JdbcTemplate、SessionFactory等复杂对象。

我们先看一下FactoryBean的接口:

public interface FactoryBean {

T getObject() throws Exception;

Class<?> getObjectType();

boolean isSingleton();

}

- getObject() – 返回工厂生成的对象,这是 Spring 容器将使用的对象

- getObjectType() – 返回此 FactoryBean 生成的对象的类型

- isSingleton() – 表示此 FactoryBean 生成的对象是否是单例

现在,让我们实现一个示例 FactoryBean。我们将实现一个 ToolFactory 来生成 Tool 类型的对象:

public class Tool {

private int id;

// standard constructors, getters and setters

}

工具工厂本身:

public class ToolFactory implements FactoryBean<Tool> {

private int factoryId;

private int toolId;

@Override

public Tool getObject() throws Exception {

return new Tool(toolId);

}

@Override

public Class<?> getObjectType() {

return Tool.class;

}

@Override

public boolean isSingleton() {

return false;

}

// standard setters and getters

}

我们可以看到,ToolFactory是一个FactoryBean,它可以产生Tool对象。

测试 Tool 对象是否正确注入:

@RunWith(SpringJUnit4ClassRunner.class)

@ContextConfiguration(classes = FactoryBeanAppConfig.class)

public class FactoryBeanJavaConfigTest {

@Autowired

private Tool tool;

@Resource(name = "&tool")

private ToolFactory toolFactory;

@Test

public void testConstructWorkerByJava() {

assertThat(tool.getId(), equalTo(2));

assertThat(toolFactory.getFactoryId(), equalTo(7070));

}

}

Spring 提供 AbstractFactoryBean 作为 FactoryBean 实现的简单模板超类。有了这个基类,我们现在可以更方便地实现创建单例或原型对象的工厂 bean。

让我们实现一个 SingleToolFactory 和 NonSingleToolFactory 来展示如何将 AbstractFactoryBean 用于单例和原型类型:

public class SingleToolFactory extends AbstractFactoryBean<Tool> {

private int factoryId;

private int toolId;

@Override

public Class<?> getObjectType() {

return Tool.class;

}

@Override

protected Tool createInstance() throws Exception {

return new Tool(toolId);

}

// standard setters and getters

}

现在是非单例实现:

public class NonSingleToolFactory extends AbstractFactoryBean<Tool> {

private int factoryId;

private int toolId;

public NonSingleToolFactory() {

setSingleton(false);

}

@Override

public Class<?> getObjectType() {

return Tool.class;

}

@Override

protected Tool createInstance() throws Exception {

return new Tool(toolId);

}

// standard setters and getters

}

可以测试 Worker 对象的属性是否按照我们的预期注入:

@RunWith(SpringJUnit4ClassRunner.class)

@ContextConfiguration(locations = { "classpath:factorybean-abstract-spring-ctx.xml" })

public class AbstractFactoryBeanTest {

@Resource(name = "singleTool")

private Tool tool1;

@Resource(name = "singleTool")

private Tool tool2;

@Resource(name = "nonSingleTool")

private Tool tool3;

@Resource(name = "nonSingleTool")

private Tool tool4;

@Test

public void testSingleToolFactory() {

assertThat(tool1.getId(), equalTo(1));

assertTrue(tool1 == tool2);

}

@Test

public void testNonSingleToolFactory() {

assertThat(tool3.getId(), equalTo(2));

assertThat(tool4.getId(), equalTo(2));

assertTrue(tool3 != tool4);

}

}

使用 FactoryBean 是一种很好的做法,可以封装复杂的构造逻辑或使在 Spring 中配置高度可配置的对象变得更容易。

参考:

Spring Boot启动时进行初始化的操作(2023 得物)

一种常见的方式是通过实现ApplicationRunner接口或CommandLineRunner接口来实现初始化操作。这两个接口在Spring Boot中专门用于在应用程序启动后执行初始化任务。我们可以创建一个类,并实现其中一个接口的run方法,在该方法中编写初始化逻辑。例如,可以在该方法中加载配置文件、初始化数据库连接等。这样,在应用程序启动后,Spring Boot会自动调用这些初始化方法。

ApplicationRunner接口:该接口提供了一个run方法,该方法在Spring Boot应用程序完全启动后执行。您可以创建一个实现ApplicationRunner接口的Bean,并在其中编写初始化逻辑。例如:

import org.springframework.boot.ApplicationArguments;

import org.springframework.boot.ApplicationRunner;

import org.springframework.stereotype.Component;

@Component

public class MyApplicationRunner implements ApplicationRunner {

@Override

public void run(ApplicationArguments args) throws Exception {

// 执行初始化逻辑

System.out.println("应用程序启动完成,进行初始化操作...");

}

}

CommandLineRunner接口:与ApplicationRunner类似,但它接受命令行参数作为方法参数。您可以创建一个实现CommandLineRunner接口的Bean,并在其中编写初始化逻辑。例如:

import org.springframework.boot.CommandLineRunner;

import org.springframework.stereotype.Component;

@Component

public class MyCommandLineRunner implements CommandLineRunner {

@Override

public void run(String... args) throws Exception {

// 执行初始化逻辑

System.out.println("应用程序启动完成,进行初始化操作...");

}

}

另一种方式是使用注解@PostConstruct来标记一个方法,在Spring容器初始化过程中,该方法会在依赖注入完成后自动执行。通过在这个方法中编写初始化逻辑,可以实现在Spring Boot启动时进行初始化操作。

🐬 MySQL

可重复读和已提交读隔离级别表现的现象是什么,区别是什么样的?(2023 美团)

- 读提交,指一个事务提交之后,它做的变更才能被其他事务看到,会有不可重复读、幻读的问题。

- 可重复读,指一个事务执行过程中看到的数据,一直跟这个事务启动时看到的数据是一致的,MySQL InnoDB 引擎的默认隔离级别,解决了不可重复读的问题,并且以很大程度上避免幻读现象的发生。

数据库引擎知道哪些?(2023 美团)

MySQL 常见的存储引擎 InnoDB、MyISAM 和 Memory 分别支持的索引类型。

数据文件大体分成哪几种数据文件?(2023 美团)

我们每创建一个 database(数据库) 都会在 /var/lib/mysql/ 目录里面创建一个以 database 为名的目录,然后保存表结构和表数据的文件都会存放在这个目录里。

比如,我这里有一个名为 my_test 的 database,该 database 里有一张名为 t_order 数据库表。 然后,我们进入 /var/lib/mysql/my_test 目录,看看里面有什么文件?

[root ~]#ls /var/lib/mysql/my_test

db.opt

t_order.frm

t_order.ibd

可以看到,共有三个文件,这三个文件分别代表着:

- db.opt,用来存储当前数据库的默认字符集和字符校验规则。

- t_order.frm ,t_order 的表结构会保存在这个文件。在 MySQL 中建立一张表都会生成一个.frm 文件,该文件是用来保存每个表的元数据信息的,主要包含表结构定义。

- t_order.ibd,t_order 的表数据会保存在这个文件。表数据既可以存在共享表空间文件(文件名:ibdata1)里,也可以存放在独占表空间文件(文件名:表名字.ibd)。这个行为是由参数 innodb_file_per_table 控制的,若设置了参数 innodb_file_per_table 为 1,则会将存储的数据、索引等信息单独存储在一个独占表空间,从 MySQL 5.6.6 版本开始,它的默认值就是 1 了,因此从这个版本之后, MySQL 中每一张表的数据都存放在一个独立的 .ibd 文件。

对一个慢sql怎么去排查?(2023 美团)

可通过开启mysql的慢日志查询,设置好时间阈值,进行捕获

索引字段是不是建的越多越好(2023 美团)

索引越多,在写入频繁的场景下,对于B+树的维护所付出的性能消耗也会越大

什么是覆盖索引?(2023 快手)

这个其实在2022年的大厂面试中出现过,但是是以聚簇索引形式提问出现

覆盖索引是一种数据库查询优化机制。在覆盖索引中,索引本身包含了查询所需要的所有数据,因此在执行查询时,数据库系统可以只访问索引,而不需要再访问数据行。这样可以显著提高查询速度,因为访问索引通常比访问数据行要快。(在索引 B+Tree 的叶子节点上都能找得到的那些索引,从二级索引中查询得到记录,而不需要通过聚簇索引查询获得,可以避免回表的操作)

覆盖索引与聚簇索引和非聚簇索引的主要区别在于数据的存储和访问方式:

- 覆盖索引:它被称为“覆盖”,因为只需使用索引即可满足查询,而无需访问表数据本身。这可以使查询更快,因为它避免了访问表数据的需要,而是使用通常更小、更紧凑的索引数据

- 聚簇索引:在聚簇索引中,数据行实际上被存储在索引中,因此每个表只能有一个聚簇索引。索引的顺序与磁盘上行的物理顺序相同。聚簇索引可以快速查找指定的数据行,但如果你需要在同一表上执行许多不同的查询,那么可能会受到限制,因为每个表只能有一个聚簇索引。

- 非聚簇索引:非聚簇索引是一个单独的结构,与数据行分开存储。非聚簇索引包含索引键值和一个指向每个数据行实际位置的指针。在非聚簇索引中查找数据需要两个步骤:首先在索引中查找,然后使用索引中的指针访问数据行。因此,非聚簇索引的查询通常比聚簇索引要慢一些。

覆盖索引可以看作是非聚簇索引的一个特例,它不仅包含索引键值和数据行的指针,还包含查询所需的其他列的数据。所以,如果查询可以被一个覆盖索引满足,那么查询速度就会比一般的非聚簇索引要快,因为数据库系统不需要再访问数据行,所有需要的数据都在索引中。使用覆盖索引的好处就是,不需要查询出包含整行记录的所有信息,也就减少了大量的 I/O 操作。

使用覆盖索引的例子:

CREATE TABLE `tbl_user` (

`id` int(11) NOT NULL,

`name` varchar(50) NOT NULL,

`age` int(11) NOT NULL,

KEY `idx_name_age` (`name`,`age`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;

SELECT `name`, `age` FROM `tbl_user` WHERE `name` = 'John' AND `age` = 30;

这里 (name, age) 组成了一个复合索引 idx_name_age,查询只需要name和age两列,所以这个查询可以使用覆盖索引,数据库只需要扫描索引,不需要访问表数据,所以查询效率高。

具体查询为:

SELECT `name`, `age` FROM `tbl_user` WHERE `name` = 'John' AND `age` = 30;

这个查询只需要name和age两个字段,而idx_name_age索引中就包含这两个字段,所以这个查询可以使用覆盖索引。 覆盖索引的查询语句应该是:

SELECT

idx_name_age.name,

idx_name_age.age

FROM tbl_user

WHERE idx_name_age.name = 'John' AND idx_name_age.age = 30;

这里我们直接从idx_name_age索引中选取需要的字段,而不再访问表数据,所以这个查询使用了覆盖索引。 所以,一个查询要使用覆盖索引,需要满足两个条件:

- 查询所需要的字段都存在于某个索引中

- 查询语句直接从该索引中选取字段,而不再访问表数据

没使用覆盖索引的例子:

CREATE TABLE `tbl_user` (

`id` int(11) NOT NULL,

`name` varchar(50) NOT NULL,

`age` int(11) NOT NULL,

`address` varchar(100) NOT NULL,

KEY `idx_name_age` (`name`,`age`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;

SELECT `name`, `age`, `address` FROM `tbl_user` WHERE `name` = 'John' AND `age` = 30;

这里虽然有(name, age)的索引,但是由于查询需要的address字段不在该索引中,所以这个查询无法使用覆盖索引,需要访问表数据获取address字段,查询效率较低。

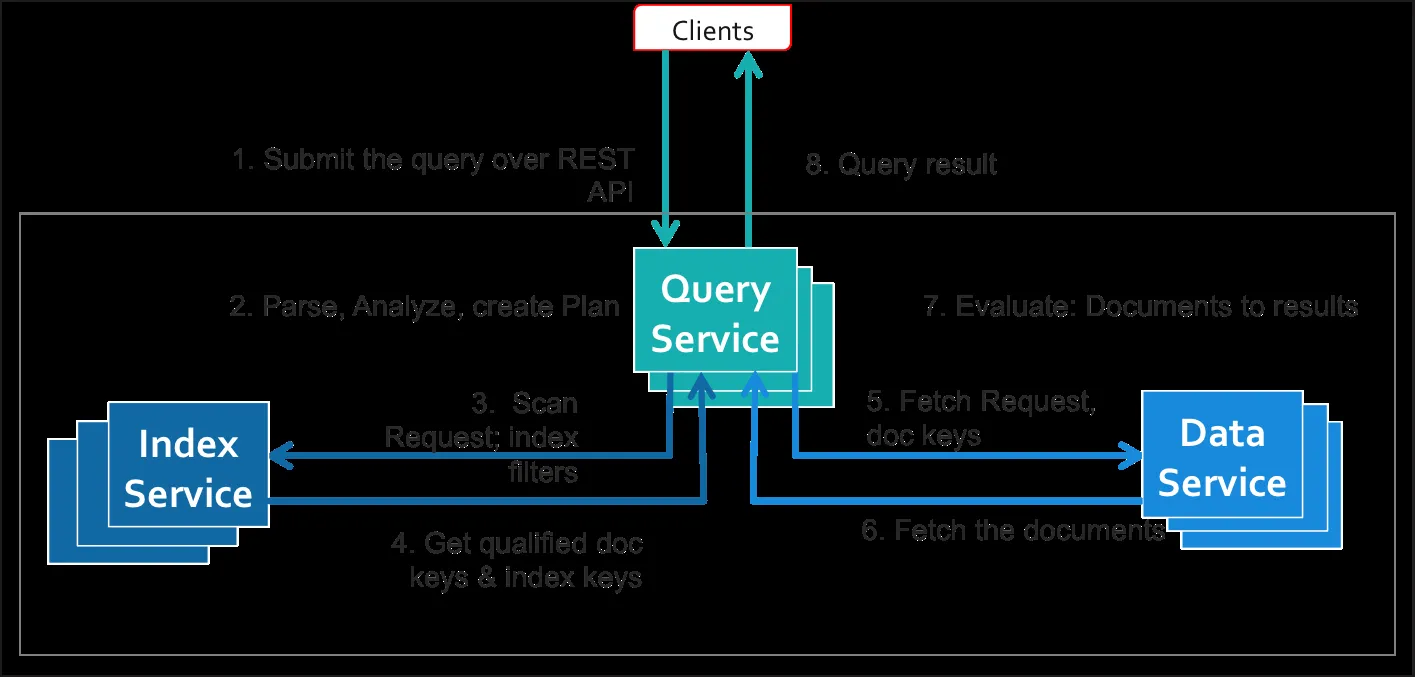

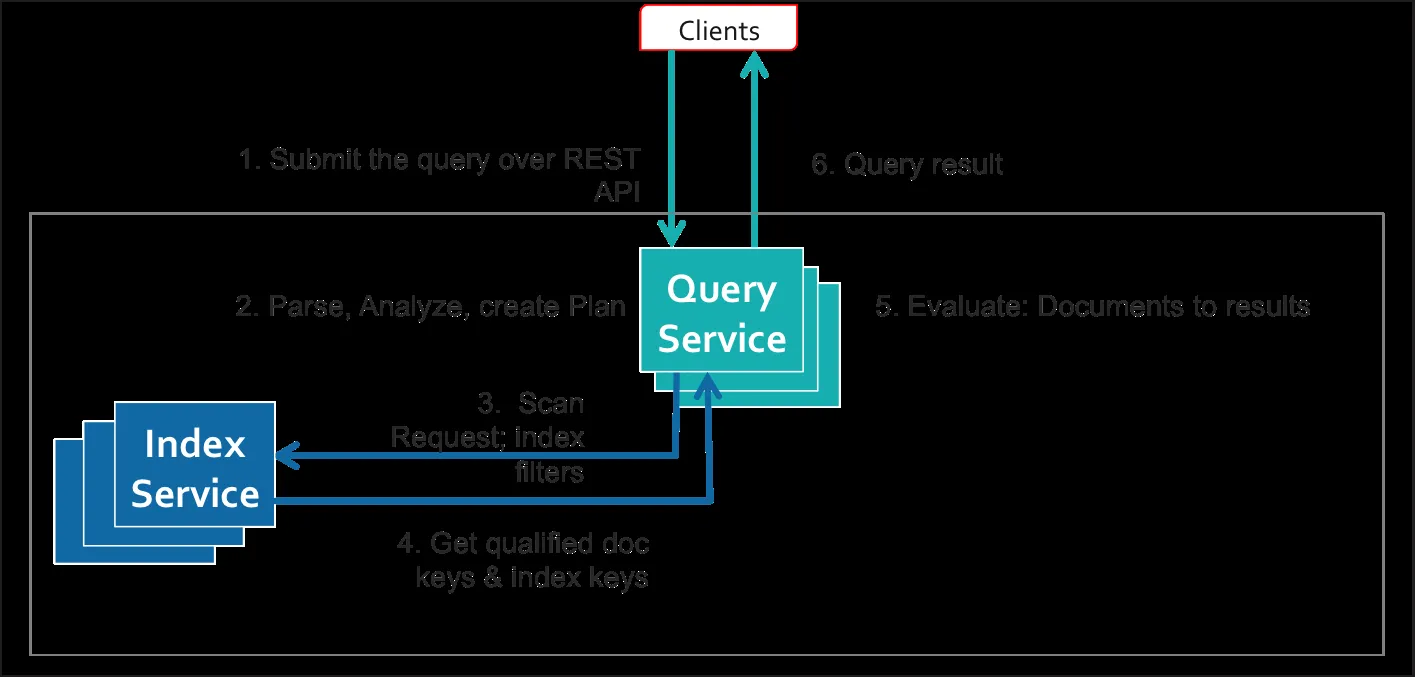

图示: 在没有使用覆盖索引,数据库查询数据是这样:

使用了覆盖索引避免了从数据服务中获取数据的额外步骤。这导致了相当大的性能改进。

参考文献:

- https://stackoverflow.com/questions/62137/what-is-a-covered-index 什么是覆盖索引?

- https://xiaolincoding.com/mysql/index/index_interview.html#按字段个数分类 覆盖索引优化-小林coding

- https://stackoverflow.com/questions/609343/what-are-covering-indexes-and-covered-queries-in-sql-server 在SQL Server中什么是覆盖索引和覆盖查询?

- https://docs.couchbase.com/server/current/n1ql/n1ql-language-reference/covering-indexes.html Covering Indexes

- https://www.red-gate.com/simple-talk/databases/sql-server/learn/using-covering-indexes-to-improve-query-performance/ 使用覆盖索引以提高查询性能

mysql的隔离级别是什么?mysql是如何实现的?(2023 阿里)

MySQL InnoDB 引擎的默认隔离级别虽然是「可重复读」,但是它很大程度上避免幻读现象(并不是完全解决了),解决的方案有两种:

- 针对快照读(普通 select 语句),是通过 MVCC 方式解决了幻读,因为可重复读隔离级别下,事务执行过程中看到的数据,一直跟这个事务启动时看到的数据是一致的,即使中途有其他事务插入了一条数据,是查询不出来这条数据的,所以就很好了避免幻读问题。

- 针对当前读(select ... for update 等语句),是通过 next-key lock(记录锁+间隙锁)方式解决了幻读,因为当执行 select ... for update 语句的时候,会加上 next-key lock,如果有其他事务在 next-key lock 锁范围内插入了一条记录,那么这个插入语句就会被阻塞,无法成功插入,所以就很好了避免幻读问题。

MySQL中delete 和 truncate 的区别?(2023 阿里实习)

- 命令类型:DELETE是一个DML(数据操作语言)命令,而TRUNCATE是一个DDL(数据定义语言)命令。

- 删除的数据范围:DELETE可以删除表中的一行或多行,TRUNCATE则会删除表中的所有行。

- 是否可以撤销:DELETE命令执行后,你可以使用ROLLBACK命令撤销更改,而TRUNCATE执行后无法撤销。

- 日志记录:DELETE命令在删除行时会记录行的日志,而TRUNCATE命令在删除数据时不记录任何日志。

- 性能:TRUNCATE命令比DELETE命令快,因为它不记录任何日志。

- 触发器行为:如果你在表上设置了触发器,那么DELETE命令会触发它,而TRUNCATE命令不会。

- 参照完整性约束:TRUNCATE是不能在参照完整性约束存在的情况下使用的,即,如果存在外键约束,不能使用TRUNCATE。

什么是联合索引,为什么要建联合索引?(2023 阿里实习)

联合索引是数据库中一种特殊类型的索引,它基于两个或多个列的值进行创建。简单来说,如果你经常在WHERE子句中同时使用多个列进行查询,那么可能需要使用联合索引。

联合索引的主要优势在于它可以极大地提高查询速度。如果你的查询通常会涉及到多个列,那么使用联合索引可能会比使用多个单列索引更高效。同时,因为索引本身会占用存储空间,联合索引比多个单列索引需要更少的存储空间。

例如:假设你有一个人员表,它有两个字段:名字(FirstName)和姓氏(LastName)。你经常运行如下查询来查找特定的全名:

SELECT * FROM People WHERE FirstName = 'John' AND LastName = 'Doe';

在这种情况下,如果你分别为 FirstName 和 LastName 创建索引,MySQL 需要首先在 FirstName 索引中找到所有名为 'John' 的人,然后在 LastName 索引中找到所有姓为 'Doe' 的人,最后对这两个结果集进行交集操作。这可能需要大量的时间和计算资源,特别是在表非常大的时候。

但是,如果你为这两列创建一个联合索引,那么 MySQL 可以直接使用这个索引来找到所有名为 'John' 并且姓为 'Doe' 的人,无需额外的交集操作。这样查询的效率就会大大提高。

创建联合索引的SQL命令可能如下:

CREATE INDEX idx_firstname_lastname ON People (FirstName, LastName);

然后,你的查询可以直接利用这个联合索引,大大提高查询效率。

SQL explain 会输出哪些信息?(2023 阿里实习)

- ID:表示查询执行计划中每个操作的唯一标识符。

- Select Type:表示查询中的子查询或者表的类型,如 SIMPLE(无子查询或者 UNION)、PRIMARY(最外层查询)、SUBQUERY、DERIVED 等。

- Table:表示正在访问的表的名称。

- Type:表示连接类型,如 ALL(全表扫描)、index(全索引扫描)、range(范围扫描)、ref(使用非唯一索引键或者唯一索引键的一部分进行查找等)。

- Possible Keys:表示查询可能使用的索引。

- Key:表示实际使用的索引。

- Key Length:表示使用的索引的长度。

- Ref:表示哪些列或者常量被用于查找索引列上的值。

- Rows:估计要检查的行数。

- Filtered:表示返回的行数占扫描行数的百分比(基于条件过滤)。

- Extra:包含有关查询执行计划的其他信息,如 Using filesort、Using temporary、Using index 等。

参考:

sql 怎么手动加锁(2023 阿里实习)

在 SQL 中手动加锁通常是通过使用显式锁定语句来实现的。在 MySQL 中,你可以使用 LOCK TABLES 和 UNLOCK TABLES 语句来手动加锁和解锁。以下是一些示例:

- 读锁(Read Lock):给一个表加读锁,可以防止其他事务对该表进行写操作,但允许其他事务进行读操作。要给一个表加读锁,可以使用以下语句:

LOCK TABLES table_name READ;

其中,table_name 是你要加锁的表的名称。

- 写锁(Write Lock):给一个表加写锁,可以防止其他事务对该表进行读、写操作。要给一个表加写锁,可以使用以下语句:

LOCK TABLES table_name WRITE;

在使用 LOCK TABLES 对表进行显式锁定后,你需要使用 UNLOCK TABLES 语句来释放锁。示例如下:

UNLOCK TABLES;

请注意,这种手动加锁方式主要适用于 MyISAM 存储引擎,因为 MyISAM 不支持事务。对于支持事务的存储引擎(如 InnoDB),你通常应该使用事务来实现并发控制和锁定。

在 InnoDB 存储引擎中,你可以使用 SELECT ... FOR UPDATE 或 SELECT ... LOCK IN SHARE MODE 语句来锁定行。例如:

- 行锁 - FOR UPDATE:给一个或多个行加排他锁,防止其他事务对这些行进行读、写操作。

START TRANSACTION;

SELECT * FROM table_name WHERE condition FOR UPDATE;

-- 进行其他操作

COMMIT;

- 行锁 - LOCK IN SHARE MODE:给一个或多个行加共享锁,允许其他事务对这些行进行读操作,但阻止其他事务进行写操作。

START TRANSACTION;

SELECT * FROM table_name WHERE condition LOCK IN SHARE MODE;

-- 进行其他操作

COMMIT;

在使用行锁时,请确保你的操作在事务中进行,并在完成操作后提交事务。这将释放锁并保持数据一致性。

介绍一些 mysql 底层结构?(2023 蚂蚁金服)

- 存储引擎(Storage Engines):MySQL 支持多种存储引擎,每种引擎都有其特定的特性和用途。例如,InnoDB 是支持事务和行级锁定的存储引擎,而 MyISAM 则是一个简单、高性能的引擎,适用于只读或读写比较低的场景。选择合适的存储引擎对于数据库性能和可靠性至关重要。

- 服务器层(Server Layer):服务器层负责处理客户端连接、查询缓存、查询分析、查询优化和执行等任务。它提供了许多功能,如存储过程、触发器、视图等,以帮助用户更高效地管理和使用数据库。

- 缓冲池(Buffer Pool):缓冲池是 InnoDB 存储引擎用于缓存数据和索引的内存区域。缓冲池的大小和管理对于数据库性能至关重要,因为它可以减少磁盘 I/O,从而提高查询速度。

- 日志(Logs):MySQL 使用多种日志来记录数据库活动和辅助恢复。例如,二进制日志(Binary Log)记录了数据库更改的历史,可以用于数据复制和恢复。而 InnoDB 的重做日志(Redo Log)则记录了对数据的修改操作,用于确保事务的持久性和数据库在崩溃后的恢复。

- 索引(Indexes):索引是数据库中用于加速查询的数据结构。MySQL 支持多种索引类型,如 B-Tree、哈希索引、全文索引等。合理地使用索引可以大幅提高查询性能,但过多的索引可能会导致更新操作变慢。

- 锁定(Locking):为了保证数据一致性和并发控制,MySQL 使用各种锁定机制,如表锁、行锁、元数据锁等。锁定策略的选择和实现对于数据库性能和并发处理能力至关重要。

- 事务(Transactions):事务是一组原子性的数据库操作,它们要么全部成功执行,要么完全不执行。事务可以帮助确保数据一致性和并发控制。InnoDB 存储引擎提供了对事务的支持,包括提交、回滚、隔离级别等功能。

参考:

mysql中,主键索引和唯一索引的区别是什么?(2023 百度提前批)

在MySQL中,**主键索引(Primary Key)和唯一索引(Unique Key)**都是两种非常重要的索引类型,它们之间的主要区别可以从以下几个方面来理解:

- 唯一性:主键索引和唯一索引都保证了索引列的唯一性。换句话说,主键索引和唯一索引都要求索引列的值唯一,不能有重复的值。

- 非空性:主键索引要求索引列的值必须是非空的,而唯一索引则允许索引列的值为NULL。也就是说,如果你在一列上定义了主键索引,那么你不能在这列上插入NULL值;而如果你在一列上定义了唯一索引,那么你可以在这列上插入NULL值。

- 数量:在一个表中,主键索引只能有一个,而唯一索引可以有多个。

- 自动增长:主键可以自动增长,但是唯一索引不能。

- 集群索引:在InnoDB存储引擎中,主键索引是集群索引(Clustered Index),也就是说,数据记录是按照主键的顺序来存储的。如果一个表没有明确定义主键,InnoDB会选择一个唯一索引作为主键,如果没有唯一索引,InnoDB会自动生成一个6字节的ROWID作为主键。

这些区别让主键索引和唯一索引在数据库设计和优化中发挥不同的作用。

一个联合索引(a, b, c),查询(a, c),能用到索引吗?(2023 百度提前批)

在MySQL中,使用联合索引(比如索引(a, b, c))查询时,需要按照索引的顺序使用列。这是由MySQL的索引策略决定的,称为最左前缀原则或最左前缀匹配原则。

对于查询(a, c),只有在查询条件中包含“a”字段,并且"b"字段也在查询条件中时,"c"才能用到索引。这是因为在联合索引(a, b, c)中,“c"是第三个字段,如果查询条件中不包含"b”,那么索引在"b"之后的部分都不能使用。

因此,如果你的查询条件是(a, c),那么MySQL只能使用到"a"的部分索引,不能利用到"c"的部分索引,即便"c"在索引中。

为了使查询更有效地使用索引,你可以考虑调整索引或查询的设计。例如,你可以创建一个新的联合索引(a, c),或者在查询条件中包含"b"字段。

事务原子性是怎么实现的?(2023 美团)

MySQL的事务原子性主要通过Undo Log(撤销日志)来实现的。

当进行一次事务操作时,MySQL会首先在Undo Log中记录下事务操作前的数据状态。如果事务成功执行并提交,Undo Log中的记录就可以被删除。但如果在事务执行过程中出现错误,或者用户执行了ROLLBACK操作,MySQL就会利用Undo Log中的信息将数据恢复到事务开始前的状态,从而实现事务的原子性。

这就意味着,事务要么全部执行成功,要么如果部分执行失败,那么已经执行的部分也会被撤销,保证数据的一致性。

事务的隔离性怎么实现的?(2023 美团)

MySQL的事务隔离性主要通过锁机制和多版本并发控制(MVCC)来实现。

- 锁机制:包括行锁和表锁。行锁可以精确到数据库表中的某一行,而表锁则会锁定整个数据表。当一个事务在操作某个数据项时,会对其加锁,阻止其他事务对同一数据项的并发操作,从而实现隔离性。

- 多版本并发控制(MVCC):这是InnoDB存储引擎特有的一种机制,它可以在不加锁的情况下创建数据在某一时间点的快照。在读取数据时,MVCC会返回该时间点的数据版本,即使该数据后来被其他事务修改。这样,每个事务都有自己的数据视图,彼此之间不会互相影响,实现了隔离性。

此外,MySQL还提供了四种隔离级别(读未提交、读已提交、可重复读、串行化),可以根据需要选择不同的隔离级别,以在并发性和数据一致性之间取得平衡。

事务一致性怎么实现的?(2023 美团)

MySQL实现事务一致性主要依赖于其InnoDB存储引擎的ACID属性,其中C代表一致性(Consistency)。具体来说,以下是MySQL如何实现事务一致性的一些方式:

- 使用锁机制:InnoDB存储引擎支持行级锁和表级锁,通过锁机制来控制并发事务的访问冲突,确保每个事务都在一致性的状态下执行。

- 使用MVCC:InnoDB存储引擎通过MVCC来实现读已提交和可重复读两个隔离级别,保证了事务的一致性视图,即在事务开始时生成一个快照,事务在执行过程中看到的数据都是这个快照中的数据。

- 使用Undo日志:InnoDB存储引擎在修改数据前,会先将原始数据保存在Undo日志中,如果事务失败或者需要回滚,就可以利用Undo日志将数据恢复到原始状态,从而保证了数据的一致性。

- 使用Redo日志:Redo日志用于保证事务的持久性,但也间接保证了一致性。因为在系统崩溃恢复时,可以通过Redo日志来重做已提交的事务,保证这些事务的修改能够持久保存。

事务的持久性怎么实现的?(通过2023 美团面试题思考补充)

MySQL实现事务持久性主要依赖于其使用的存储引擎,比如InnoDB。以下是InnoDB如何实现事务持久性的一些方式:

- 重做日志(Redo Logs):InnoDB引擎有一组重做日志文件,事务提交前,会先将更改写入到重做日志中,并保证这些日志被写入到磁盘。这种机制就是所谓的预写式日志(Write-Ahead Logging,WAL)。每个重做日志都包含了事务的相关信息,以及这个事务所做的修改。

- 刷新缓冲池(Flush Buffer Pool):当事务提交时,InnoDB引擎只是将更改写入了重做日志,并没有立即写入到磁盘的数据文件中。实际的写入过程是在后台以一定的频率进行的,这就是所谓的刷新缓冲池。

- 崩溃恢复(Crash Recovery):如果数据库在事务执行过程中崩溃,InnoDB可以使用重做日志来恢复数据到一个一致的状态。在重启过程中,InnoDB会检查重做日志,并将所有未完成的事务所做的修改应用到数据文件中,同时取消所有未提交的事务。

这些机制共同确保了MySQL事务的持久性,即使在系统崩溃后,已提交的事务所做的修改也能被正确地恢复。

具体如何刷盘可以看:https://javaguide.cn/database/mysql/mysql-logs.html#刷盘时机

事务的这四个特性是怎么实现的?(2023 阿里)

- 持久性是通过 redo log (重做日志)来保证的;

- 原子性是通过 undo log(回滚日志) 来保证的;

- 隔离性是通过 MVCC(多版本并发控制) 或锁机制来保证的;

- 一致性则是通过持久性+原子性+隔离性来保证;

MySQL死锁的案例(2023 阿里)

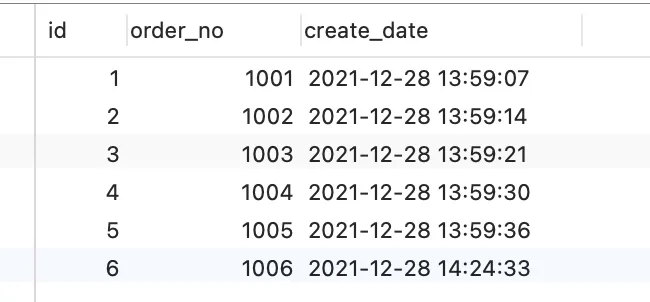

t_order 表里现在已经有了 6 条记录,其中 id 字段为主键索引,order_no 字段普通索引,也就是非唯一索引:

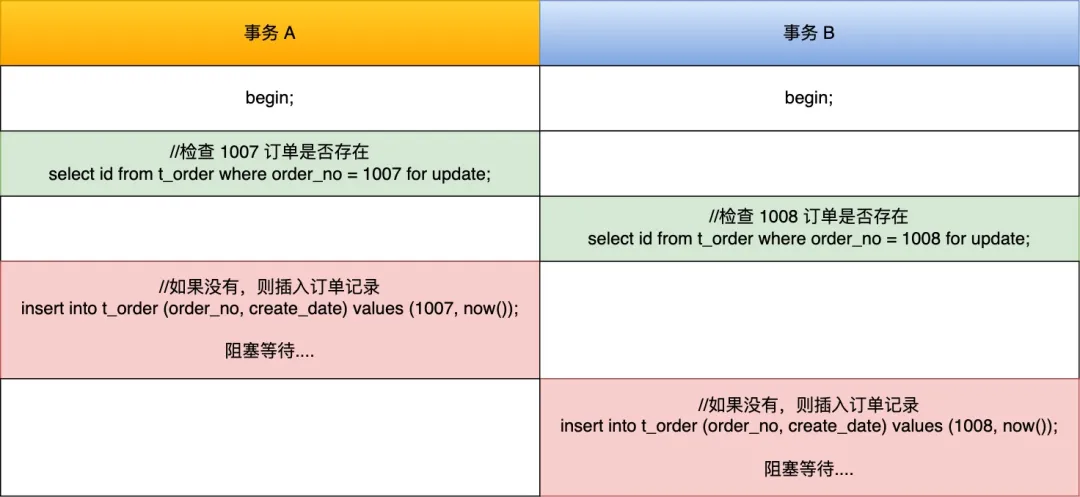

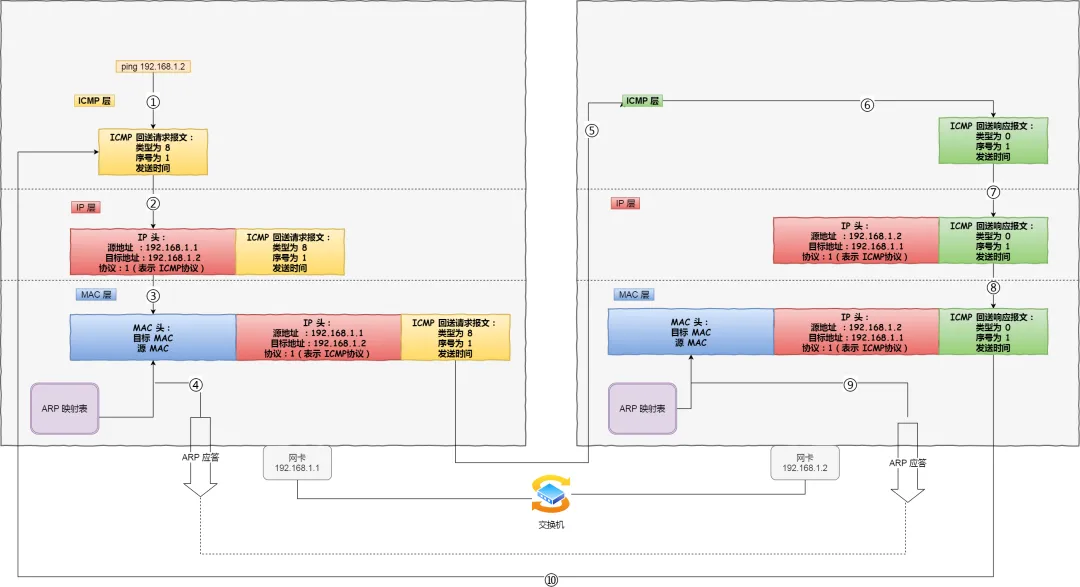

有两事务,一个事务要插入订单 1007 ,另外一个事务要插入订单 1008,因为需要对订单做幂等性校验,所以两个事务先要查询该订单是否存在,不存在才插入记录,过程如下:

可以看到,两个事务都陷入了等待状态,原因:

- T1: 事务 a 在执行 select id from t_order where order_no = 1007 for update,会在二级索引(INDEX_NAME : index_order)上加的是 X 型的 next-key 锁,锁范围是

(1006, +∞]。 - T2: 事务 b 在执行 select id from t_order where order_no = 1008 for update,会在二级索引(INDEX_NAME : index_order)上加的是 X 型的 next-key 锁,锁范围是

(1006, +∞]。 - T3:事务 a 往事务 A next-key 锁的范围 (1006, +∞] 里插入 id = 1007 的记录就会被锁住:因为当我们执行以下插入语句时,会在插入间隙上获取插入意向锁,而插入意向锁与间隙锁是冲突的,所以当其它事务持有该间隙的间隙锁时,需要等待其它事务释放间隙锁之后,才能获取到插入意向锁

- T4:事务 b 往事务 a next-key 锁的范围 (1006, +∞] 里插入 id = 1008 的记录就会被锁住,原因也是一样,申请插入意向锁的时候阻塞了。

案例中的事务 A 和事务 B 在执行完后 select ... for update 语句后,都持有范围为(1006,+∞]的next-key 锁,而接下来的插入操作为了获取到插入意向锁,都在等待对方事务的间隙锁释放,于是就造成了循环等待,导致死锁。

MySQL分库分表之后怎么确保每个表的id都是唯一的?(2023 阿里)

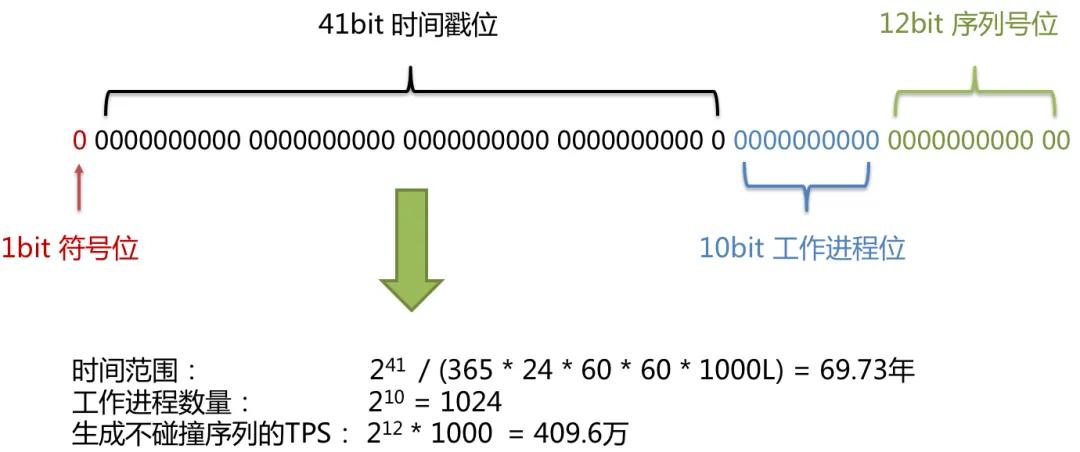

可以使用雪花算法算法来生成分布式 id,它会生成一个 64 bit 的整数,可以保证不同进程主键的不重复性,以及相同进程主键的有序性。

在同一个进程中,它首先是通过时间位保证不重复,如果时间相同则是通过序列位保证。同时由于时间位是单调递增的,且各个服务器如果大体做了时间同步,那么生成的主键在分布式环境可以认为是总体有序的,这就保证了对索引字段的插入的高效性。

但是雪花算法有缺点,雪花算法是强依赖于时间的,而如果机器时间发生回拨,有可能会生成重复的 ID。可以用美团提供的分布式 ID 解决方案 Leaf,他是不依赖时间戳的

MVCC的隔离机制介绍一下?(2023 美团)

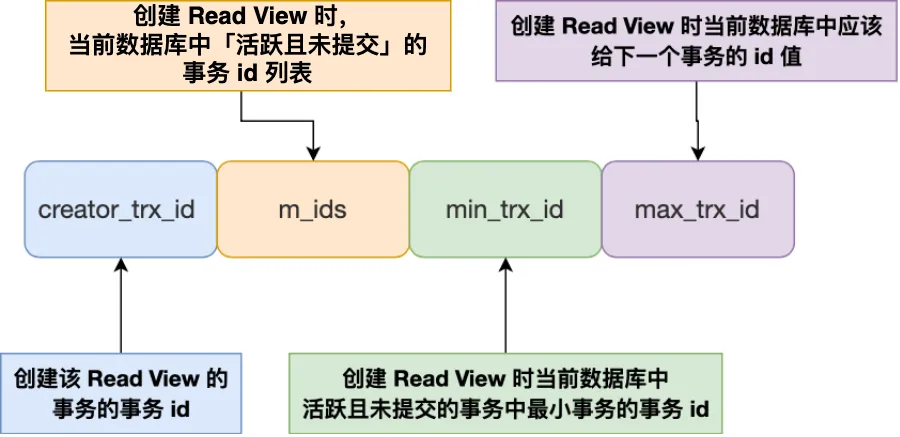

- Read View 中四个字段作用;

- 聚簇索引记录中两个跟事务有关的隐藏列;

那 Read View 到底是个什么东西?

Read View 有四个重要的字段:

- m_ids :指的是在创建 Read View 时,当前数据库中「活跃事务」的事务 id 列表,注意是一个列表,“活跃事务”指的就是,启动了但还没提交的事务。

- min_trx_id :指的是在创建 Read View 时,当前数据库中「活跃事务」中事务 id 最小的事务,也就是 m_ids 的最小值。

- max_trx_id :这个并不是 m_ids 的最大值,而是创建 Read View 时当前数据库中应该给下一个事务的 id 值,也就是全局事务中最大的事务 id 值 + 1;

- creator_trx_id :指的是创建该 Read View 的事务的事务 id。

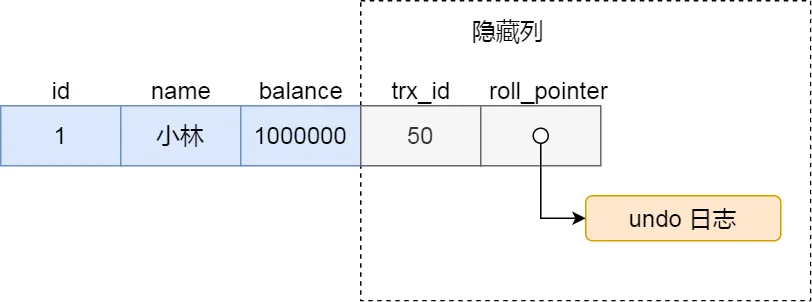

知道了 Read View 的字段,我们还需要了解聚簇索引记录中的两个隐藏列。

假设在账户余额表插入一条小林余额为 100 万的记录,然后我把这两个隐藏列也画出来,该记录的整个示意图如下:

对于使用 InnoDB 存储引擎的数据库表,它的聚簇索引记录中都包含下面两个隐藏列:

- trx_id,当一个事务对某条聚簇索引记录进行改动时,就会把该事务的事务 id 记录在 trx_id 隐藏列里;

- roll_pointer,每次对某条聚簇索引记录进行改动时,都会把旧版本的记录写入到 undo 日志中,然后这个隐藏列是个指针,指向每一个旧版本记录,于是就可以通过它找到修改前的记录。

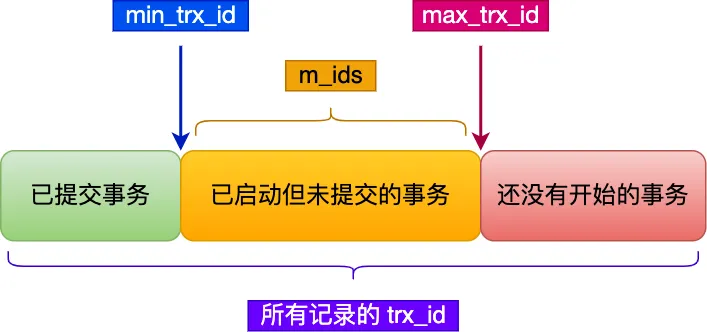

在创建 Read View 后,我们可以将记录中的 trx_id 划分这三种情况:

一个事务去访问记录的时候,除了自己的更新记录总是可见之外,还有这几种情况:

如果记录的 trx_id 值小于 Read View 中的

min_trx_id值,表示这个版本的记录是在创建 Read View 前已经提交的事务生成的,所以该版本的记录对当前事务可见。如果记录的 trx_id 值大于等于 Read View 中的

max_trx_id值,表示这个版本的记录是在创建 Read View 后才启动的事务生成的,所以该版本的记录对当前事务不可见。如果记录的 trx_id 值在 Read View 的 min_trx_id和max_trx_id之间,需要判断 trx_id 是否在 m_ids 列表中:

- 如果记录的 trx_id 在

m_ids列表中,表示生成该版本记录的活跃事务依然活跃着(还没提交事务),所以该版本的记录对当前事务不可见。 - 如果记录的 trx_id 不在

m_ids列表中,表示生成该版本记录的活跃事务已经被提交,所以该版本的记录对当前事务可见。

- 如果记录的 trx_id 在

这种通过「版本链」来控制并发事务访问同一个记录时的行为就叫 MVCC(多版本并发控制)。

数据库的三大范式,可以反范式吗?(2023 美团)

数据库的三大范式是数据库设计的基本原则,主要包括:

- 第一范式(1NF) :数据表中的每一列都是不可分割的最小单元,也就是属性值是原子性的。

- 第二范式(2NF):在第一范式的基础上,要求数据表中的每一列都与主键相关,也就是说非主键列必须完全依赖于主键,不能只依赖主键的一部分(针对联合主键)。

- 第三范式(3NF):在第二范式的基础上,要求一个数据表中不包含已在其他表中已包含的非主键信息,也就是说,非主键列必须直接依赖于主键,不能存在传递依赖。

传递依赖进步一解释:在一个数据库表中,如果存在一个非主键列B,它不直接依赖于该表的主键列A,而是依赖于另一个非主键列C,而这个非主键列C又依赖于主键列A,那么就可以说,非主键列B对主键列A存在传递依赖。

例如,假设我们有一个包含学生ID(主键)、学生姓名、班级名称和班主任姓名的表。在这个表中,学生姓名直接依赖于学生ID,班级名称也直接依赖于学生ID,但是班主任姓名并不直接依赖于学生ID,而是依赖于班级名称(因为一个班级对应一个班主任)。在这种情况下,我们就可以说,班主任姓名对学生ID存在传递依赖。

为了满足第三范式(3NF),我们需要消除这种传递依赖。具体来说,我们可以将原表拆分为两个表,一个表包含学生ID、学生姓名和班级名称,另一个表包含班级名称和班主任姓名。这样,每个表中的非主键列都直接依赖于主键,不存在传递依赖,从而满足第三范式。

关于反范式,是的,数据库设计可以反范式。反范式设计是为了优化数据库性能,通过增加冗余数据或者组合数据,减少复杂的数据查询,提高数据读取性能。

反范式:是数据库设计中的一种策略,通过引入数据冗余或合并表来优化读取性能,但可能会增加数据管理的复杂性和数据一致性的风险。

在理想的范式设计中,为了减少数据冗余和避免数据异常(如插入异常、更新异常和删除异常),一般会将数据分解到多个相关的表中。然而,这种设计可能会导致查询性能降低,因为需要执行多表连接操作以获取所需的数据。

反范式设计通过以下方式优化读取性能:

- 数据冗余:在多个表中存储相同的数据,以减少多表连接操作。这可能会导致数据更新更复杂,因为需要在多个位置更新相同的数据。

- 数据预计算:将经常需要计算的数据预先计算并存储起来,如总数、平均数等。

- 表合并:将多个表合并为一个表,以减少多表连接操作。这可能会导致数据冗余,但可以提高查询性能。

虽然反范式设计可以优化读取性能,但也会带来数据管理的复杂性和数据一致性的风险。因此,是否使用反范式设计需要根据具体的应用场景和性能需求进行权衡。

MySQL中,什么样的数据不推荐加索引?(2023 影石360)

- 低基数列:如果列的值大多数都是相同的,例如性别列(只有男、女两种值),那么对这种列添加索引可能并不高效。

- 频繁变化的列:如果某个列的数据频繁变动,那么每次数据变动时索引都需要重建,这会导致性能下降。

- 大文本列:对于非常长的文本,建立索引可能会非常耗费资源。如果需要,可以考虑使用全文索引或者其他搜索引擎解决方案。

- 冗余索引:如果已经有了一个多列索引,例如

(A, B, C),那么对于A列的单独索引可能就是冗余的,因为(A, B, C)已经包含了A的索引。 - 存储开销:每个索引都需要占用额外的磁盘空间。如果有太多的索引,不仅会浪费存储空间,还可能导致额外的I/O开销。

- 插入、删除、更新操作:索引虽然可以加速查询,但也会减慢插入、删除和更新操作的速度,因为每次这些操作发生时,索引也需要更新。

当然,是否为某列添加索引还需要根据实际的查询需求、数据分布和业务场景来决定。在决定加索引之前,最好进行性能测试和分析,确保索引能带来预期的效果。

数据库自增id,当id值大于MAXINT时,数据库如何做 ?(2023 快手)

- 做分库分表之类的优化了

- 调整数据类型,修改为BIGINT数据类型,但是要注意数据太多,DDL执行时长问题

了解过前缀索引吗?(2023 快手)

使用前缀索引是为了减小索引字段大小,可以增加一个索引页中存储的索引值,有效提高索引的查询速度。在一些大字符串的字段作为索引时,使用前缀索引可以帮助我们减小索引项的大小。

假设有一个包含用户名的MySQL表users,表结构如下:

CREATE TABLE users (

id INT PRIMARY KEY AUTO_INCREMENT,

username VARCHAR(255)

);

对username字段创建完整索引可能会占用较多空间。如果知道大多数查询只会使用用户名的前几个字符,可以创建前缀索引。例如,为username字段的前4个字符创建索引:

ALTER TABLE users ADD INDEX idx_username_prefix(username(4));

之后,以下查询将使用前缀索引,从而更快地返回结果:

SELECT * FROM users WHERE username LIKE 'John%';

但是,像这样的查询将无法使用前缀索引:

SELECT * FROM users WHERE username LIKE '%John';

前缀索引减少了索引的大小,但也有局限性:

- order by 就无法使用前缀索引;

- 无法把前缀索引用作覆盖索引;

介绍一下联合索引?最左匹配原则是什么?(2023 快手)

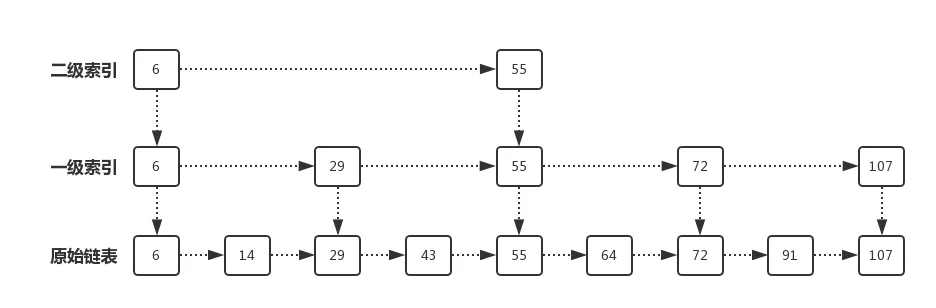

通过将多个字段组合成一个索引,该索引就被称为联合索引。

比如,将商品表中的 product_no 和 name 字段组合成联合索引(product_no, name),创建联合索引的方式如下:

CREATE INDEX index_product_no_name ON product(product_no, name);

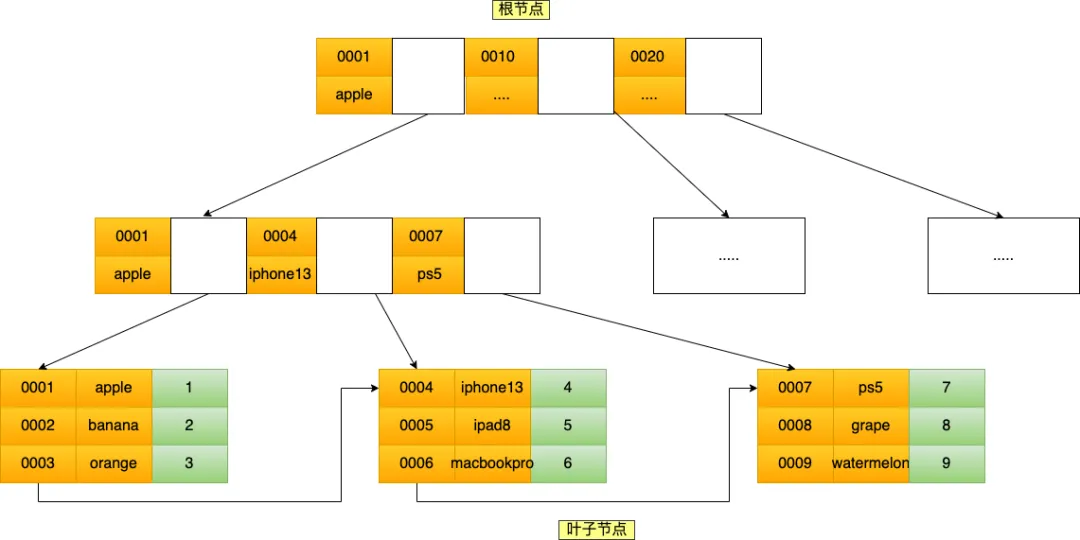

联合索引(product_no, name) 的 B+Tree 示意图如下(图中叶子节点之间我画了单向链表,但是实际上是双向链表,原图我找不到了,修改不了,偷个懒我不重画了,大家脑补成双向链表就行)。

可以看到,联合索引的非叶子节点用两个字段的值作为 B+Tree 的 key 值。当在联合索引查询数据时,先按 product_no 字段比较,在 product_no 相同的情况下再按 name 字段比较。

也就是说,联合索引查询的 B+Tree 是先按 product_no 进行排序,然后再 product_no 相同的情况再按 name 字段排序。

因此,使用联合索引时,存在最左匹配原则,也就是按照最左优先的方式进行索引的匹配。在使用联合索引进行查询的时候,如果不遵循「最左匹配原则」,联合索引会失效,这样就无法利用到索引快速查询的特性了。

比如,如果创建了一个 (a, b, c) 联合索引,如果查询条件是以下这几种,就可以匹配上联合索引:

- where a=1;

- where a=1 and b=2 and c=3;

- where a=1 and b=2;

需要注意的是,因为有查询优化器,所以 a 字段在 where 子句的顺序并不重要。

但是,如果查询条件是以下这几种,因为不符合最左匹配原则,所以就无法匹配上联合索引,联合索引就会失效:

- where b=2;

- where c=3;

- where b=2 and c=3;

上面这些查询条件之所以会失效,是因为(a, b, c) 联合索引,是先按 a 排序,在 a 相同的情况再按 b 排序,在 b 相同的情况再按 c 排序。所以,b 和 c 是全局无序,局部相对有序的,这样在没有遵循最左匹配原则的情况下,是无法利用到索引的。

我这里举联合索引(a,b)的例子,该联合索引的 B+ Tree 如下(图中叶子节点之间我画了单向链表,但是实际上是双向链表,原图我找不到了,修改不了,偷个懒我不重画了,大家脑补成双向链表就行)。

可以看到,a 是全局有序的(1, 2, 2, 3, 4, 5, 6, 7 ,8),而 b 是全局是无序的(12,7,8,2,3,8,10,5,2)。因此,直接执行where b = 2这种查询条件没有办法利用联合索引的,利用索引的前提是索引里的 key 是有序的。

只有在 a 相同的情况才,b 才是有序的,比如 a 等于 2 的时候,b 的值为(7,8),这时就是有序的,这个有序状态是局部的,因此,执行where a = 2 and b = 7是 a 和 b 字段能用到联合索引的,也就是联合索引生效了。

联合索引有一些特殊情况,并不是查询过程使用了联合索引查询,就代表联合索引中的所有字段都用到了联合索引进行索引查询,也就是可能存在部分字段用到联合索引的 B+Tree,部分字段没有用到联合索引的 B+Tree 的情况。

这种特殊情况就发生在范围查询。联合索引的最左匹配原则会一直向右匹配直到遇到「范围查询」就会停止匹配。也就是范围查询的字段可以用到联合索引,但是在范围查询字段的后面的字段无法用到联合索引。

MySQL的索引为什么是b+树(2023 得物)

因为 B+ 树具有以下几个优点:

- 查询效率稳定: B+ 树的高度较矮,因此查询时需要的磁盘 I/O 操作次数较少。这有助于实现更高的查询速度和更稳定的性能。

- 范围查询方便: B+ 树的所有叶子节点都位于同一层,并且通过指针连接,这使得范围查询更加高效。

- 更适合磁盘: 数据库存储通常依赖于磁盘,而磁盘的 I/O 操作通常具有高成本。B+ 树允许更有效地读取数据块,减少了 I/O 操作。

- 高扇出率: 由于 B+ 树节点可以存储大量子节点的引用,树的高度相对较低,这进一步减少了查询需要的磁盘 I/O 操作次数。

- 适应性强: B+ 树可以容易地插入、删除和查找操作,而且能自动平衡,这是数据库系统中非常需要的特性。

- 数据局部性: B+ 树有助于实现数据的局部性原理,即经常一起使用的数据也应该一起存储。这有助于提高缓存和磁盘 I/O 效率。

- 易于维护: B+ 树易于分裂和合并,这样在数据插入和删除时能保持良好的平衡性。

- 多路复用: 在多用户或并发环境下,B+ 树能更好地支持多路复用。

一个sql语句,判断是否用了索引,是否回表(2023 得物)

EXPLAIN

mysql的死锁问题(2023 得物)

MySQL在以下情况下可能会出现死锁问题:

- 并发读写冲突:当多个事务同时读取和写入同一行数据时,可能会导致死锁问题。例如,事务A先获取了锁并读取了某一行数据,同时事务B也需要读取该行数据,但事务A还未释放锁,导致事务B无法继续执行,从而可能导致死锁。

- 加锁顺序不一致:当事务在执行过程中获取锁的顺序不一致时,也可能会导致死锁。例如,事务A先锁住了表A的某一行,然后想要锁住表B的某一行;而事务B先锁住了表B的某一行,然后想要锁住表A的某一行。这种情况下,两个事务可能会因为互相等待对方释放锁而发生死锁。

- 高并发场景:当有大量并发的事务同时请求锁资源时,可能增加了发生死锁的概率。特别是在数据库设计不合理或应用程序并发控制不当的情况下,死锁的发生可能更为频繁。

- 锁超时设置不合理:如果在事务中设置了过长的锁超时时间,那么在并发量较大的情况下,可能会导致事务持有锁的时间过长,从而增加了死锁发生的可能性。

解决MySQL死锁问题的方法有很多,以下是一些常见的方法:

- 死锁检测和处理: MySQL的InnoDB存储引擎可以自动检测死锁,并回滚其中一个事务,释放资源,使其他事务能够继续执行。应用程序可以通过监控错误日志来获取有关死锁的信息,并采取适当的措施来处理。

- 优化事务和锁策略: 在设计数据库架构时,应该合理设置事务的隔离级别、锁的粒度和加锁顺序。例如,尽量使用较低的隔离级别,减少锁的持有时间,以及确保所有事务加锁的顺序一致。

- 提高并发能力: 通过增加硬件资源(例如内存、磁盘)或者优化查询语句的性能,可以提高数据库的并发能力,从而减少发生死锁的可能性。

- 减少事务时间: 尽量在事务内完成尽可能少的工作,减少事务的持有时间,以便其他事务能够更快地获得所需的锁资源。

- 设置超时时间:MySQL的InnoDB存储引擎通过参数innodb_lock_wait_timeout来设置锁等待的时间,超过这个时间后会报错并释放锁资源。默认的超时时间是50秒。通过适当调整这个超时时间,可以在一定程度上减少死锁发生的可能性。

手写个sql死锁,如果字段非索引会发生死锁吗(2023 快手)

SQL死锁通常发生在两个或更多个事务相互等待对方释放锁时。下面是一个简单的MySQL示例,演示了如何产生一个死锁。假设我们有一个名为students的表,该表有id和name两个字段。

CREATE TABLE students (

id INT PRIMARY KEY,

name VARCHAR(50)

);

INSERT INTO students (id, name) VALUES (1, 'Alice');

INSERT INTO students (id, name) VALUES (2, 'Bob');

现在假设我们有两个并发的事务:

事务1:

START TRANSACTION;

UPDATE students SET name='Charlie' WHERE id=1;

-- 事务1在这里暂停,等待事务2

UPDATE students SET name='David' WHERE id=2;

COMMIT;

事务2:

START TRANSACTION;

UPDATE students SET name='Emily' WHERE id=2;

-- 事务2在这里暂停,等待事务1

UPDATE students SET name='Frank' WHERE id=1;

COMMIT;

这两个事务会造成死锁,因为事务1锁定了id=1的记录,而事务2锁定了id=2的记录。然后,它们都等待对方释放锁。

如果字段非索引会发生死锁吗?

实际上非索引字段可能会增加发生死锁的机会。这是因为在非索引字段上执行更新或者锁定操作通常需要全表扫描,这将锁定更多的行。这样,与其他事务的锁竞争可能性就更高了,从而更容易导致死锁。

然而,要注意的是,是否会发生死锁还取决于很多其他因素,包括数据库管理系统的内部机制、事务的隔离级别等等。所以,即使是非索引字段也不一定总是会导致死锁。但是,使用索引通常可以减少全表扫描和锁竞争,从而降低死锁的风险。

♨️ Redis

Redis string底层的结构?(2023 美团)

Redis 的字符串是一个动态字符串实现,它能够容纳任意长度的二进制安全的字符串。这意味着在 Redis 中,你不仅可以保存例如 "Hello, World!" 这样的字符串,还可以保存 JPEG 图像或者任何其他二进制数据。

在底层,Redis 的字符串是由以下结构表示的:

struct sdshdr {

// 保存字符串长度的字节大小

int len;

// 保存未使用的字节大小,这样当字符串需要扩展时可以避免不必要的重新分配

int free;

// 实际的字符串数据,这是一个字符数组

char buf[];

};

这里的 buf 字段是一个柔性数组(flexible array member)。实际的数据长度比 buf 的大小更大,这取决于 len 字段的值。free 字段表示 buf 后面有多少未使用的字节,这使得字符串追加变得更加高效。

这种动态字符串结构意味着:

- 字符串可以在不重新分配内存的情况下增长,只要

free字段所示的未使用空间允许。 - 字符串可以包含二进制数据,因为它们是二进制安全的。

- 字符串可以知道其长度,因为

len字段提供了这一信息,这意味着取长度是 O(1) 操作。

注意:这里给出的 sdshdr 结构是一个简化版本。在不同的 Redis 版本中,为了支持大字符串或优化存储,可能会有不同的实现或细微的差别。

Redis 分布式锁的实现?过期时间怎样设置的?(2023 美团)

Redis 分布式锁通常使用 SETNX(Set if Not eXists)或者 SET 命令配合某些参数来实现。这种锁可以保证在分布式系统中的多个节点之间的互斥性。

以下是使用 Redis 实现分布式锁的基本步骤:

- 加锁:

- 使用

SETNX lock:key value尝试设置一个锁。如果返回1,表示获取锁成功。如果返回0,表示其他客户端已经持有这个锁。 - 为了避免死锁(例如,持有锁的客户端崩溃导致其他客户端永远无法获取锁),你需要给锁设置一个过期时间。这可以通过

EXPIRE命令实现,但更安全的方法是使用SET命令的PX或EX选项。例如:SET lock:key value NX PX 30000会尝试设置一个锁,它在 30 秒后过期。

- 使用

- 执行业务操作:

- 如果成功获得锁,执行需要保护的业务操作。

- 解锁:

- 使用

DEL lock:key来释放锁。 - 为了确保只有锁的持有者可以释放锁(避免误解锁),释放锁的操作应该是原子的。这通常使用 Redis 的 Lua 脚本实现。脚本会检查锁的值是否与期望相匹配,只有在匹配的情况下才删除它。

- 使用

设置锁的过期时间是一个权衡:

- 太短:业务操作可能没有完成就已经过期,这可能会导致其他客户端在当前操作还在进行时获得锁。

- 太长:如果持有锁的客户端崩溃,其他客户端可能需要等待很长时间才能获取锁。

因此,设置的过期时间应该比预期的业务操作时间稍微长一些,但也不宜过长。

注意:Redis 的 Redlock 算法是一个更复杂、更健壮的分布式锁实现。如果需要在多个 Redis 实例或集群之间实现真正的分布式锁,可以考虑使用这个算法。

redis怎么实现分布式锁 set nx命令有什么问题 如何解决?(2023小红书)

Redis实现分布式锁的基本思路是使用SET命令的NX(Not eXists)选项。NX选项表示只有当键不存在时,才会设置键值对。这样可以确保在分布式环境中,只有一个客户端能够成功地获取锁。以下是一个简单的示例:

SET lock_key some_value NX PX 30000

这个命令尝试设置一个名为lock_key的键,值为some_value,并且使用NX选项。PX选项表示设置一个过期时间,单位为毫秒,在这个例子中是30000毫秒(30秒)。 然而,使用SET NX命令实现分布式锁存在一些问题:

- 非原子操作:在某些情况下,客户端可能在设置锁和设置过期时间之间崩溃,导致锁永远不会被释放。这可以通过使用SET命令的PX选项来解决,它可以在设置锁的同时设置过期时间,确保操作是原子的。

- 无法解决锁超时问题:如果持有锁的客户端在锁过期之前没有完成任务,其他客户端可能会获取到锁,导致并发问题。为了解决这个问题,可以在获取锁时设置一个唯一的值(例如UUID),并在释放锁时检查该值。这样可以确保只有锁的持有者才能释放锁。

- 无法解决锁释放问题:如果持有锁的客户端在释放锁之前崩溃,锁可能永远不会被释放。为了解决这个问题,可以使用一个后台线程定期检查并释放过期的锁。

- 无法实现公平锁:SET NX命令无法保证公平性,即等待时间最长的客户端不一定能够优先获取锁。要实现公平锁,可以使用Redis的LIST数据结构,将等待锁的客户端按照先进先出(FIFO)的顺序排队。 综上所述,虽然SET NX命令可以实现基本的分布式锁功能,但在实际应用中可能需要考虑更多的问题。为了解决这些问题,可以使用成熟的Redis分布式锁库,如Redlock。Redlock提供了一个更加健壮和可靠的分布式锁实现,可以解决上述问题

什么情况使用 redis 反而降低性能(2023 完美世界)

- 数据集过大:Redis 将数据存储在内存中,如果数据集过大,超出了服务器可用内存的限制,就会导致 Redis 使用交换空间(swap space)或者频繁地从磁盘加载数据,从而严重影响性能。

- 内存碎片化:当 Redis 频繁地进行写入、更新和删除操作时,可能会导致内存碎片化。这会导致 Redis 需要更多的内存来存储相同的数据,最终导致性能下降。

- 大量的键过期操作:当 Redis 中有大量的键需要过期处理时,Redis 会执行定期清理操作来删除过期的键。如果这个清理操作耗时较长,会导致 Redis 在执行其他操作时的性能下降。

- 高并发写入操作:当有大量的并发写入操作时,Redis 可能会因为竞争条件而降低性能。这种情况下,可以考虑使用 Redis 的事务功能来减少竞争并发。

- 复杂的数据结构操作:Redis 提供了多种复杂的数据结构,如列表、集合和有序集合等。当对这些数据结构进行复杂的操作时,例如对大型列表进行频繁的插入和删除操作,可能会导致性能下降。

需要注意的是,这些情况并不意味着 Redis 总是会降低性能,而是在特定的场景下可能会出现性能下降的情况。为了优化 Redis 的性能,可以根据具体的情况进行调整和优化,例如增加内存、合理设置过期时间、使用合适的数据结构等。

参考资料:

Redis大key如何解决(2023 滴滴)

Redis大key通常指的是存储在Redis中的数据结构(例如字符串、列表、集合、哈希表和有序集合)的数据量特别大的key。例如,一个列表中的元素数量巨大,或者一个哈希表的字段数量很多。这些大key可能会导致在执行某些操作时消耗过多的CPU和内存资源,进而影响Redis的性能。 例如:字符串(String):一个字符串value的长度非常大,例如超过10KB。

SET bigkey "a very large string....." # string长度非常大

列表(List):列表中的元素数量非常多,例如超过10000个。

LPUSH bigkey item1 item2 item3 ... item10001 # 列表元素数量非常多

哈希(Hash):哈希中的字段数量非常多,例如超过10000个。

HMSET bigkey field1 value1 field2 value2 ... field10001 value10001 # 哈希字段数量非常多

以上的数值(例如10KB,10000个等)仅作为参考,具体定义大key的阈值需要根据实际业务和Redis的配置来决定。如果这些key对Redis的性能产生了影响,就应当考虑对其进行优化。

什么是大key总结

- String 类型的值大于 10 KB;

- Hash、List、Set、ZSet 类型的元素的个数超过 5000个;

大 key 会造成什么问题?

大 key 会带来以下四种影响:

- 客户端超时阻塞。由于 Redis 执行命令是单线程处理,然后在操作大 key 时会比较耗时,那么就会阻塞 Redis,从客户端这一视角看,就是很久很久都没有响应。

- 引发网络阻塞。每次获取大 key 产生的网络流量较大,如果一个 key 的大小是 1 MB,每秒访问量为 1000,那么每秒会产生 1000MB 的流量,这对于普通千兆网卡的服务器来说是灾难性的。

- 阻塞工作线程。如果使用 del 删除大 key 时,会阻塞工作线程,这样就没办法处理后续的命令。

- 内存分布不均。集群模型在 slot 分片均匀情况下,会出现数据和查询倾斜情况,部分有大 key 的 Redis 节点占用内存多,QPS 也会比较大。

如何找到大 key ?

- redis-cli --bigkeys 查找大key

可以通过 redis-cli --bigkeys 命令查找大 key:

redis-cli -h 127.0.0.1 -p6379 -a "password" -- bigkeys

使用的时候注意事项:

- 最好选择在从节点上执行该命令。因为主节点上执行时,会阻塞主节点;

- 如果没有从节点,那么可以选择在 Redis 实例业务压力的低峰阶段进行扫描查询,以免影响到实例的正常运行;或者可以使用 -i 参数控制扫描间隔,避免长时间扫描降低 Redis 实例的性能。 该方式的不足之处:

- 这个方法只能返回每种类型中最大的那个 bigkey,无法得到大小排在前 N 位的 bigkey;

- 对于集合类型来说,这个方法只统计集合元素个数的多少,而不是实际占用的内存量。但是,一个集合中的元素个数多,并不一定占用的内存就多。因为,有可能每个元素占用的内存很小,这样的话,即使元素个数有很多,总内存开销也不大;

- 使用 SCAN 命令查找大 key 使用 SCAN 命令对数据库扫描,然后用 TYPE 命令获取返回的每一个 key 的类型。 对于 String 类型,可以直接使用 STRLEN 命令获取字符串的长度,也就是占用的内存空间字节数。 对于集合类型来说,有两种方法可以获得它占用的内存大小:

- 如果能够预先从业务层知道集合元素的平均大小,那么,可以使用下面的命令获取集合元素的个数,然后乘以集合元素的平均大小,这样就能获得集合占用的内存大小了。List 类型:LLEN 命令;Hash 类型:HLEN 命令;Set 类型:SCARD 命令;Sorted Set 类型:ZCARD 命令;

- 如果不能提前知道写入集合的元素大小,可以使用 MEMORY USAGE 命令(需要 Redis 4.0 及以上版本),查询一个键值对占用的内存空间。

- 使用 RdbTools 工具查找大 key 使用 RdbTools 第三方开源工具,可以用来解析 Redis 快照(RDB)文件,找到其中的大 key。 比如,下面这条命令,将大于 10 kb 的 key 输出到一个表格文件。

rdb dump.rdb -c memory --bytes 10240 -f redis.csv

如何删除大 key

删除操作的本质是要释放键值对占用的内存空间,不要小瞧内存的释放过程。

释放内存只是第一步,为了更加高效地管理内存空间,在应用程序释放内存时,操作系统需要把释放掉的内存块插入一个空闲内存块的链表,以便后续进行管理和再分配。这个过程本身需要一定时间,而且会阻塞当前释放内存的应用程序。

所以,如果一下子释放了大量内存,空闲内存块链表操作时间就会增加,相应地就会造成 Redis 主线程的阻塞,如果主线程发生了阻塞,其他所有请求可能都会超时,超时越来越多,会造成 Redis 连接耗尽,产生各种异常。

因此,删除大 key 这一个动作,我们要小心。具体要怎么做呢?这里给出两种方法:

- 分批次删除

- 异步删除(Redis 4.0版本以上)

- 分批次删除

对于删除大 Hash,使用 hscan 命令,每次获取 100 个字段,再用 hdel 命令,每次删除 1 个字段。

Python代码:

def del_large_hash():

r = redis.StrictRedis(host='redis-host1', port=6379)

large_hash_key ="xxx" #要删除的大hash键名

cursor = '0'

while cursor != 0:

# 使用 hscan 命令,每次获取 100 个字段

cursor, data = r.hscan(large_hash_key, cursor=cursor, count=100)

for item in data.items():

# 再用 hdel 命令,每次删除1个字段

r.hdel(large_hash_key, item[0])

对于删除大 List,通过 ltrim 命令,每次删除少量元素。

Python代码:

def del_large_list():

r = redis.StrictRedis(host='redis-host1', port=6379)

large_list_key = 'xxx' #要删除的大list的键名

while r.llen(large_list_key)>0:

#每次只删除最右100个元素

r.ltrim(large_list_key, 0, -101)

对于删除大 Set,使用 sscan 命令,每次扫描集合中 100 个元素,再用 srem 命令每次删除一个键。

Python代码:

def del_large_set():

r = redis.StrictRedis(host='redis-host1', port=6379)

large_set_key = 'xxx' # 要删除的大set的键名

cursor = '0'

while cursor != 0:

# 使用 sscan 命令,每次扫描集合中 100 个元素

cursor, data = r.sscan(large_set_key, cursor=cursor, count=100)

for item in data:

# 再用 srem 命令每次删除一个键

r.srem(large_size_key, item)

对于删除大 ZSet,使用 zremrangebyrank 命令,每次删除 top 100个元素。

Python代码:

def del_large_sortedset():

r = redis.StrictRedis(host='large_sortedset_key', port=6379)

large_sortedset_key='xxx'

while r.zcard(large_sortedset_key)>0:

# 使用 zremrangebyrank 命令,每次删除 top 100个元素

r.zremrangebyrank(large_sortedset_key,0,99)

- 异步删除 从 Redis 4.0 版本开始,可以采用异步删除法,用 unlink 命令代替 del 来删除。 这样 Redis 会将这个 key 放入到一个异步线程中进行删除,这样不会阻塞主线程。 除了主动调用 unlink 命令实现异步删除之外,我们还可以通过配置参数,达到某些条件的时候自动进行异步删除。 主要有 4 种场景,默认都是关闭的:

lazyfree-lazy-eviction no

lazyfree-lazy-expire no

lazyfree-lazy-server-del

noslave-lazy-flush no

它们代表的含义如下:

- lazyfree-lazy-eviction:表示当 Redis 运行内存超过 maxmeory 时,是否开启 lazy free 机制删除;

- lazyfree-lazy-expire:表示设置了过期时间的键值,当过期之后是否开启 lazy free 机制删除;

- lazyfree-lazy-server-del:有些指令在处理已存在的键时,会带有一个隐式的 del 键的操作,比如 rename 命令,当目标键已存在,Redis 会先删除目标键,如果这些目标键是一个 big key,就会造成阻塞删除的问题,此配置表示在这种场景中是否开启 lazy free 机制删除;

- slave-lazy-flush:针对 slave (从节点) 进行全量数据同步,slave 在加载 master 的 RDB 文件前,会运行 flushall 来清理自己的数据,它表示此时是否开启 lazy free 机制删除。

建议开启其中的 lazyfree-lazy-eviction、lazyfree-lazy-expire、lazyfree-lazy-server-del 等配置,这样就可以有效的提高主线程的执行效率。

解决